韩松、朱俊彦等人提出GAN压缩法:算力消耗不到1/9,现已开源

作者:Muyang Li等

机器之心编译

机器之心编辑部

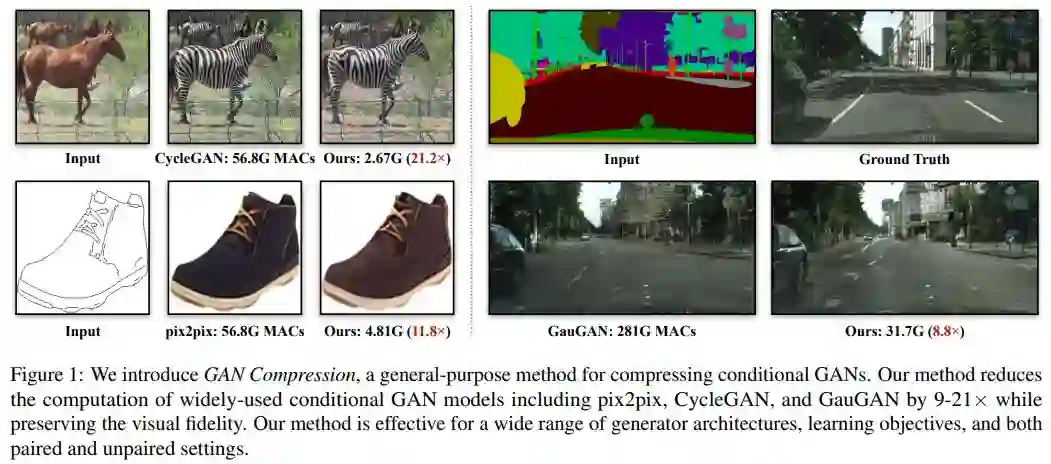

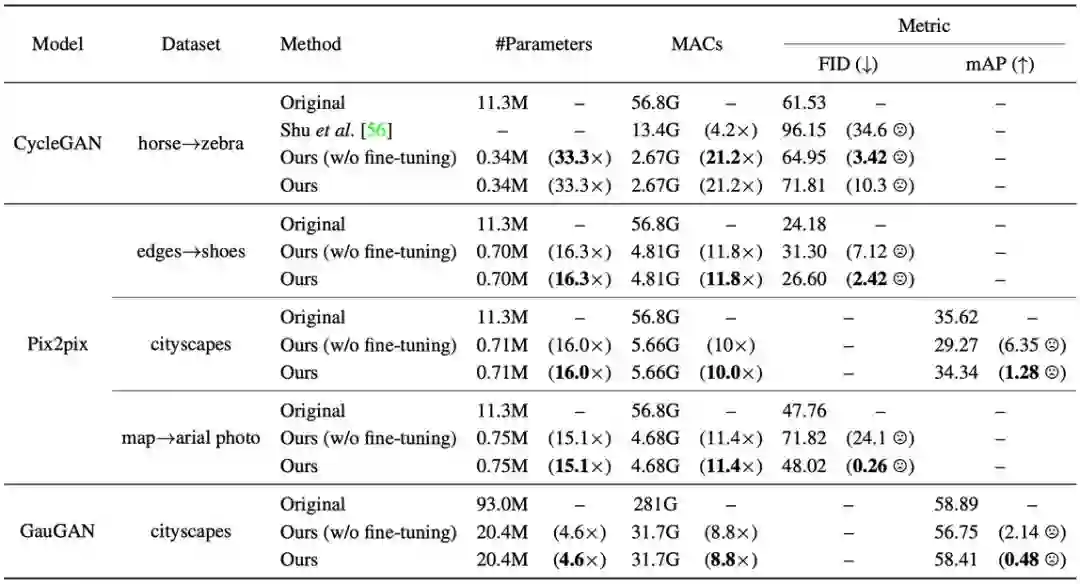

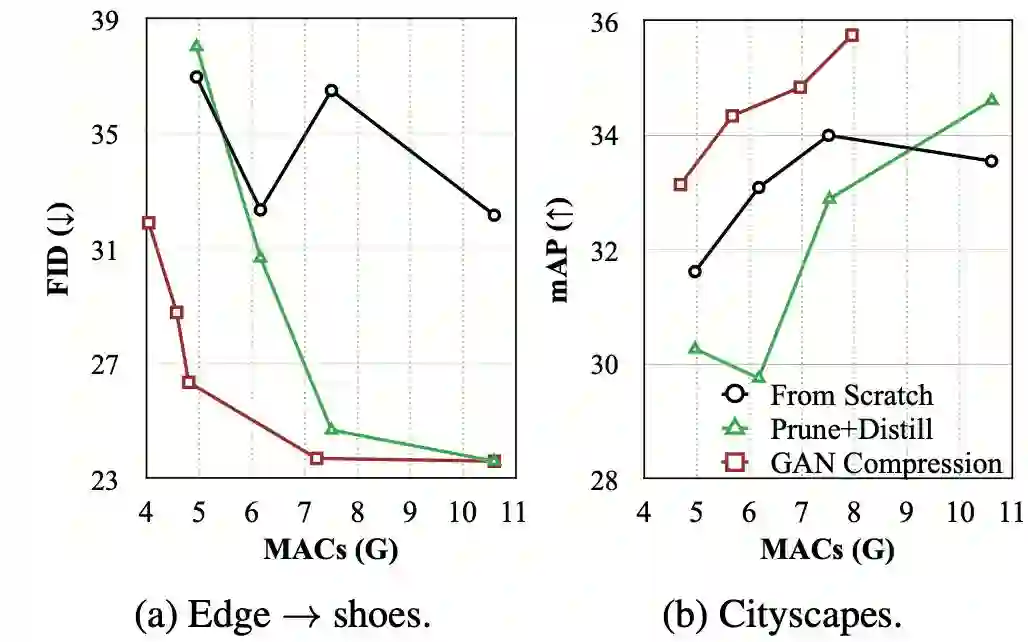

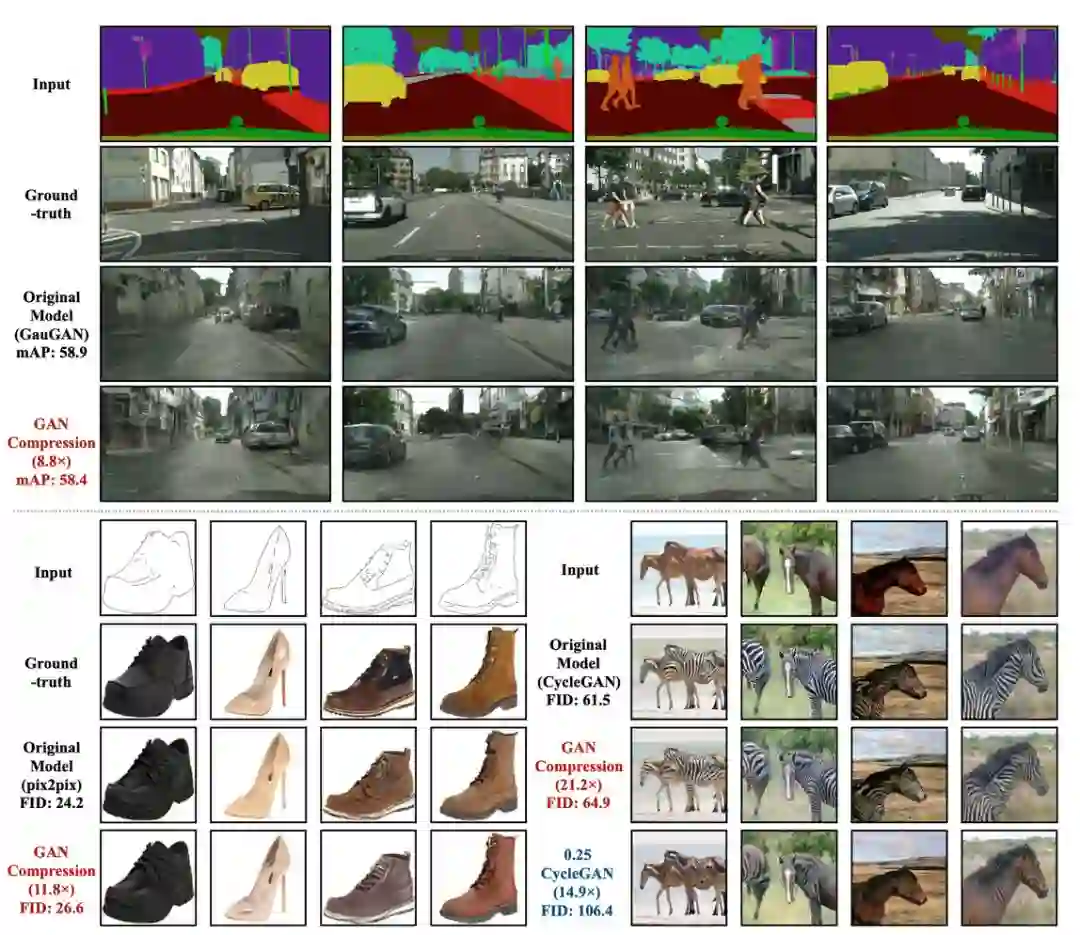

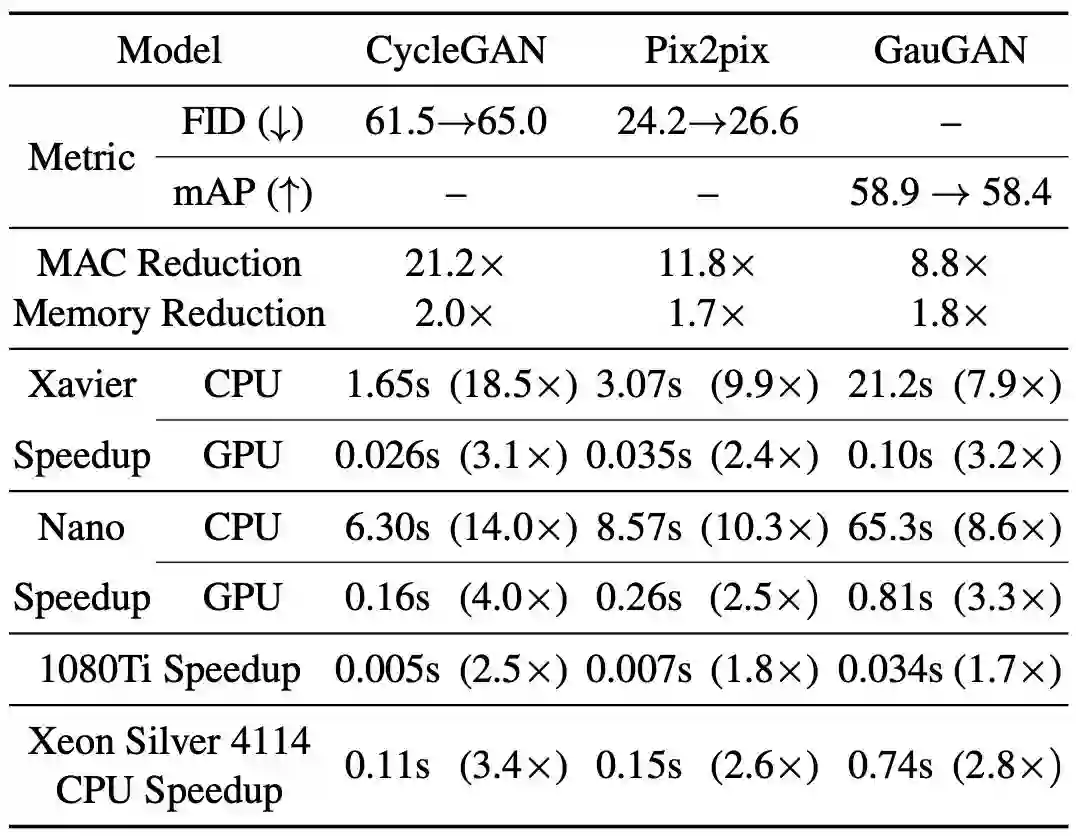

GAN 也可以大幅压缩,MIT 韩松团队的最新研究让众多研究者们为之一振。

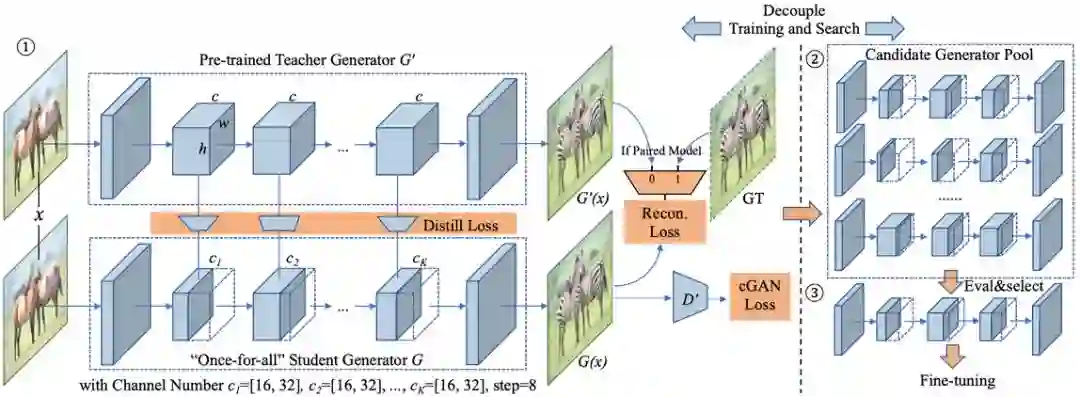

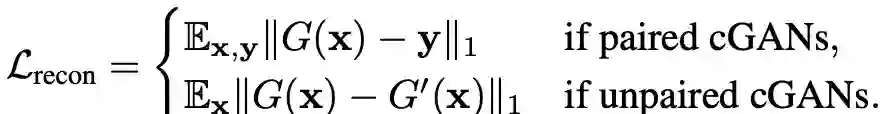

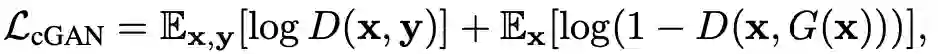

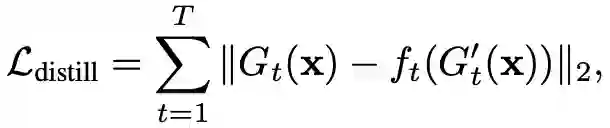

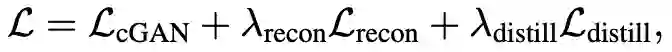

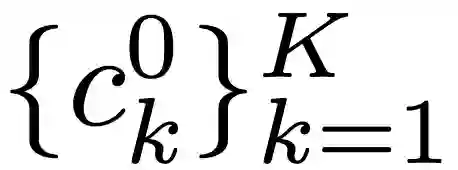

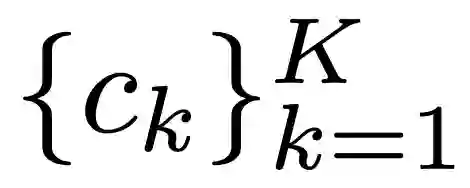

个通道,对于给定的通道数

个通道,对于给定的通道数 ,从「once-for-all」的权重张量提取第一个

,从「once-for-all」的权重张量提取第一个 通道,获得子网络的权重网络。

通道,获得子网络的权重网络。

登录查看更多

相关内容

Arxiv

15+阅读 · 2018年5月24日