【经典】深度学习数学宝典《深度学习所需要的矩阵微积分》

【导读】本文是由Terence Parr 和Jeremy Howard撰写的《深度学习的矩阵运算》论文。我们知道,深度学习是基于线性代数和微积分的,反向传播也离不开求导和矩阵运算,因此了解深度学习内部的数学原理也至关重要。

原文链接:

https://explained.ai/matrix-calculus/index.html

本文从简单函数求导到多元函数求偏导,再到矩阵的微积分运算,逐层深入,引导我们探索深度学习背后的学习规则与数学基础。本文试图解释理解深度神经网络的训练所需要的所有矩阵演算,本文适用于对神经网络基础有所了解的人,不过即使没有数学基础的同学也不要紧,作者提供了相关数学知识链接。在文末作者提供的参考部分,总结了这里讨论的所有关键矩阵演算规则和术语。

请关注专知公众号(点击上方蓝色专知关注)

后台回复“MXDL” 就可以获取最新论文的下载链接~

目录

1.介绍

2.向量演算和偏导简介

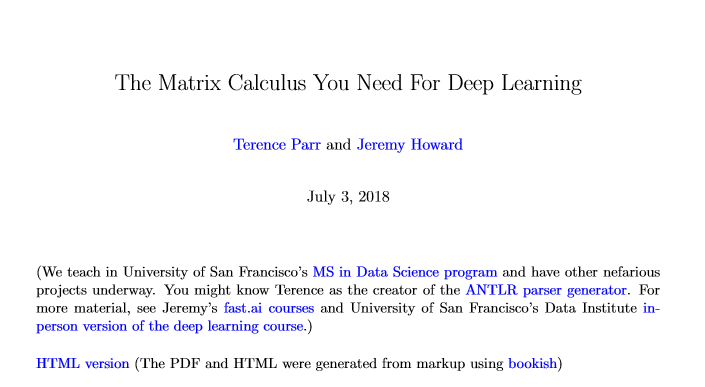

3.矩阵演算

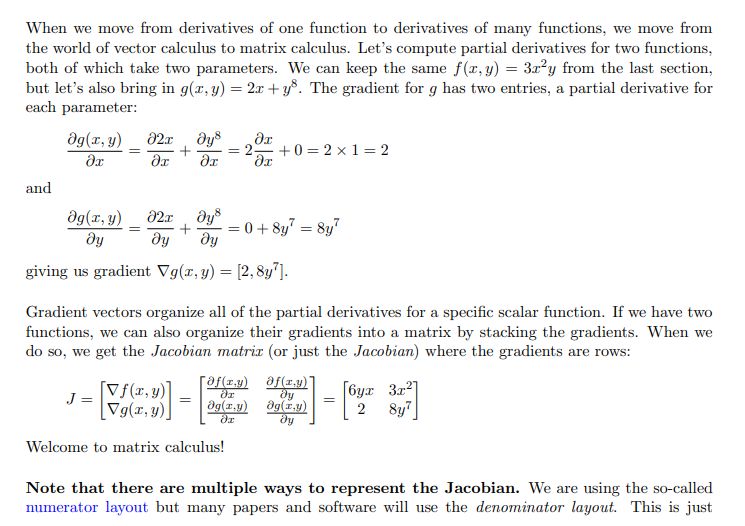

雅可比定律

多元微分

向量

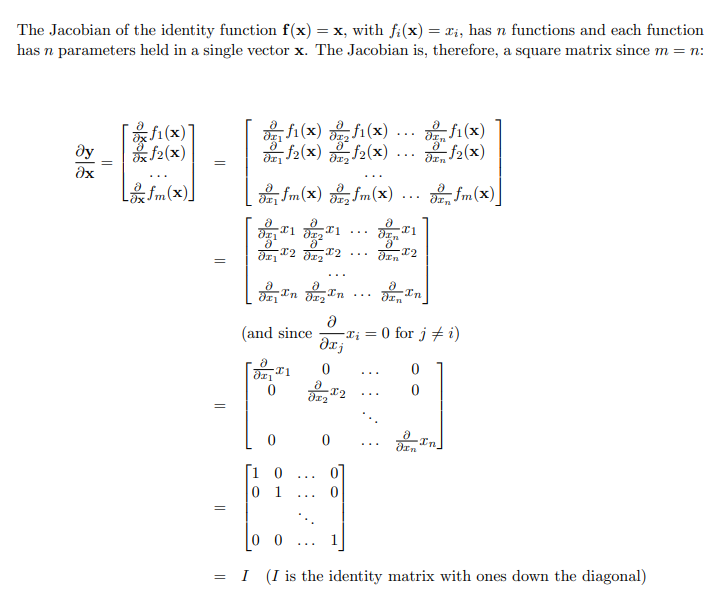

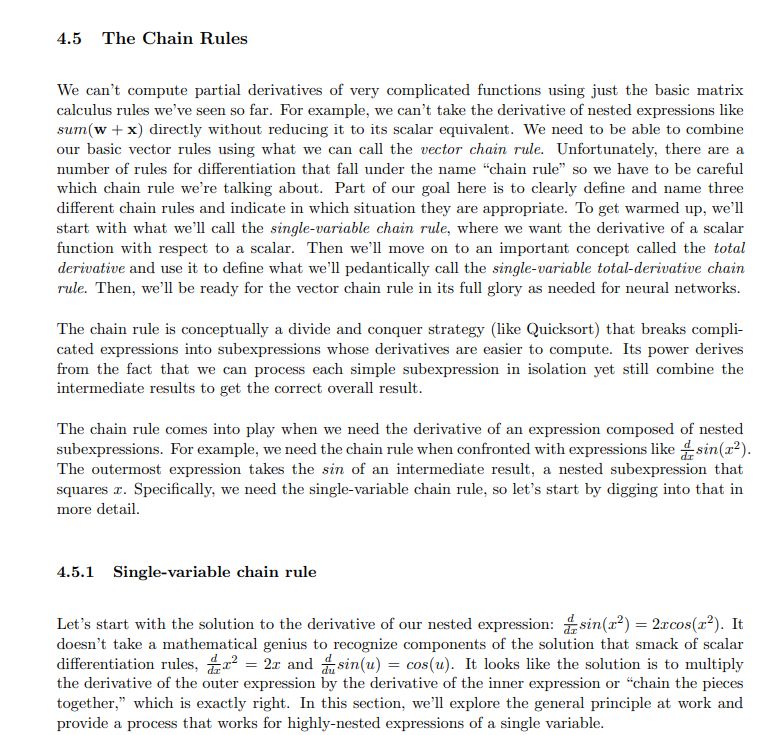

链式法则

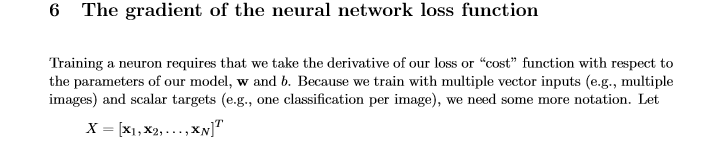

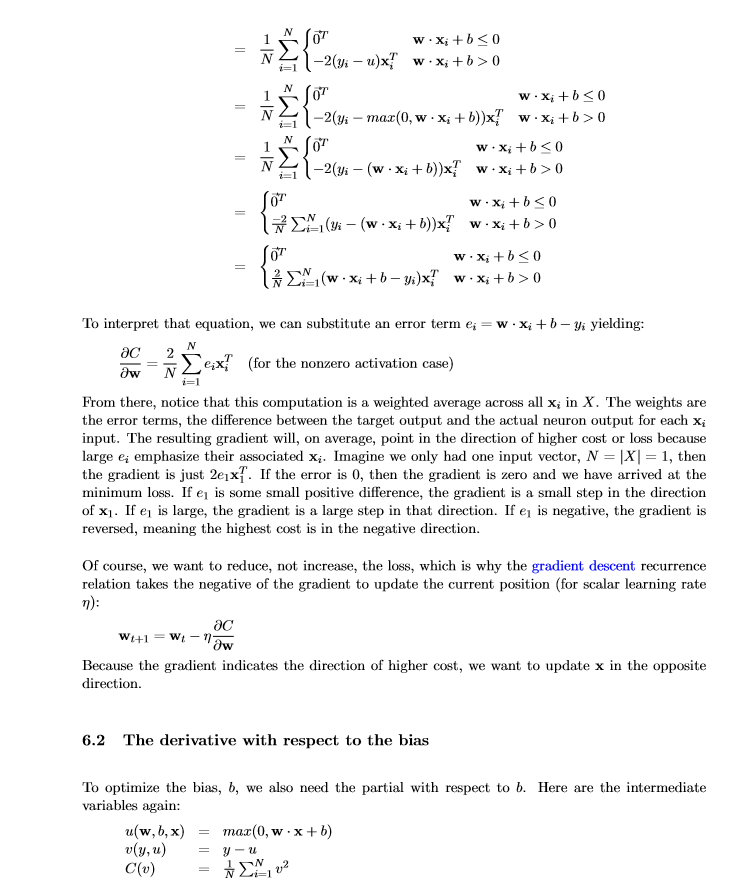

4.损失函数求导

5.矩阵演算参考

6.符号

7.资源链接

论文部分介绍

大多数人最后一次看到微积分应该是在学校里边,然而导数是机器学习的重要组成部分,尤其是深度神经网络,它是通过优化损失函数进行训练的。所以从事人工智能的人不得不重新拾起微积分。很大一部分人只是深度学习的实践者,在使用过程中直接调用了集成的库,但是想要真正了解这些库的功能,查阅相关模型训练技术的最新学术论文,则需要了解矩阵演算的相关知识。

在计算偏导数的过程中,本文做了一些假设。要记住计算输出函数的偏导数(y = w.x +b)和损失函数是很重要的。第一个假设是向量x的基数等于f中的标量函数的个数。这提供了一个方形雅可比矩阵。如果你想知道为什么他们需要相等,考虑这样一个情况,每个神经元xi的输入都与权重wi相关(这里的标量函数类似于xi*wi),所以我们拥有和x一样多的w。

链式法则是微积分中的求导法则,用于求一个复合函数的导数,是在微积分的求导运算中一种常用的方法。复合函数的导数将是构成复合这有限个函数在相应点的 导数的乘积,就像锁链一样一环套一环,故称链式法则。如何求解链式法则,作者在论文中也给了全面的介绍:

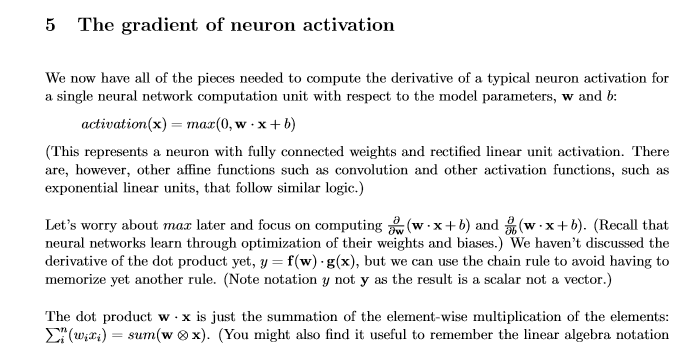

神经网络的梯度计算:

便捷查看:关注专知公众号(点击上方蓝色专知关注)

后台回复“DLMATH” 获取《深度学习所需要的矩阵微积分》pdf简易链接索引~