ICLR 2022 | 基于对抗自注意力机制的预训练语言模型

©作者 | 曾伟豪

单位 | 北京邮电大学

研究方向 | 对话摘要生成

论文名称:

Adversarial Self-Attention For Language Understanding

ICLR 2022

https://arxiv.org/pdf/2206.12608.pdf

Introduction

-

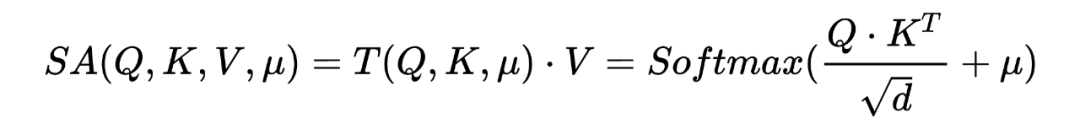

大量的证据表明,自注意力可以从 allowing bias 中获益,allowing bias 可以将一定程度的先验(如 masking,分布的平滑)加入原始的注意力结构中。这些先验知识能够让模型从较小的语料中学习有用的知识。但是这些先验知识一般是任务特定的知识,使得模型很难扩展到丰富的任务上。 adversarial training 通过给输入内容添加扰动来提升模型的鲁棒性。作者发现仅仅给 input embedding 添加扰动很难 confuse 到 attention maps. 模型的注意在扰动前后没有发生变化。

-

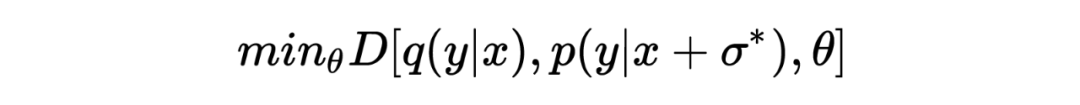

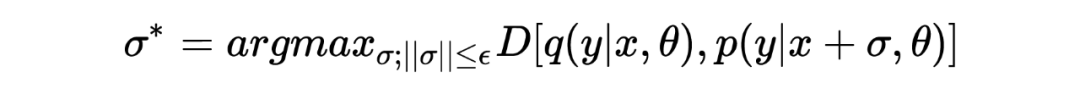

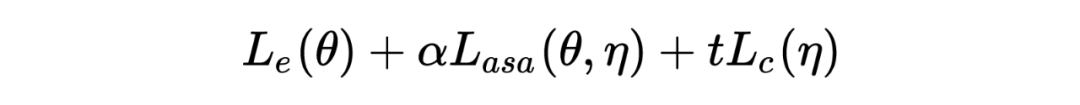

最大化 empirical training risk,在自动化构建先验知识的过程学习得到biased(or adversarial)的结构。 -

adversial 结构是由输入数据学到,使得 ASA 区别于传统的对抗训练或自注意力的变体。 -

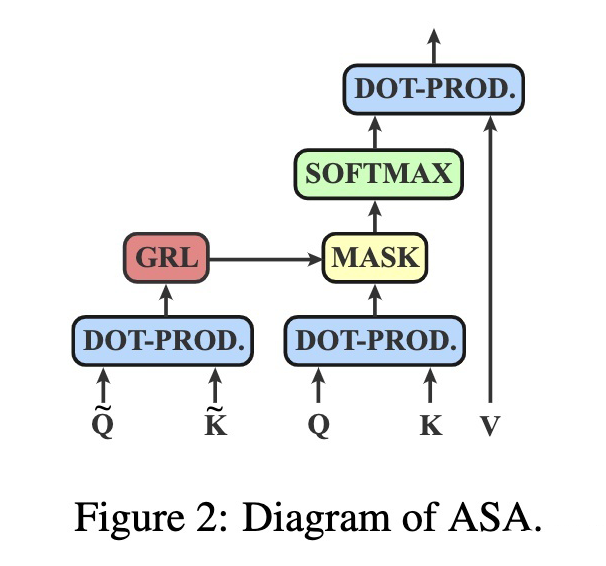

使用梯度反转层来将 model 和 adversary 结合为整体。 ASA 天然具有可解释性。

Preliminary

2.1 Adversarial training

2.2 General Self-Attention

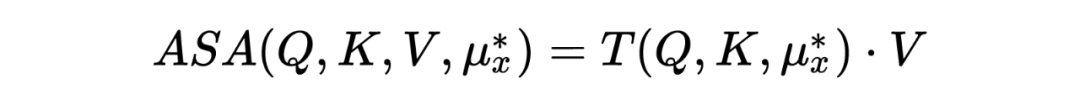

Adversarial Self-Attention Mechanism

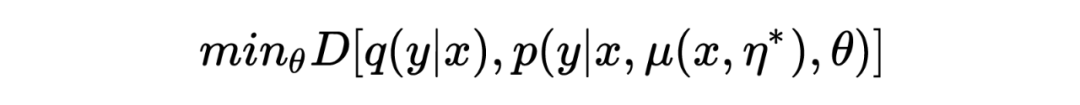

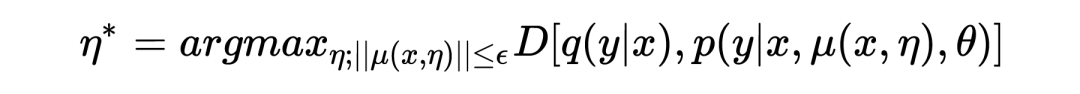

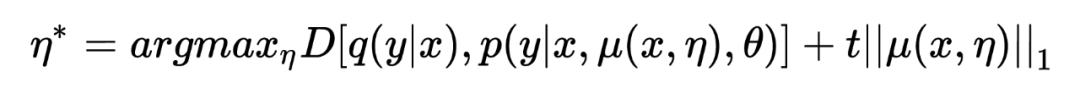

3.1 Optimization

3.2 Implementation

3.3 Training

Experiments

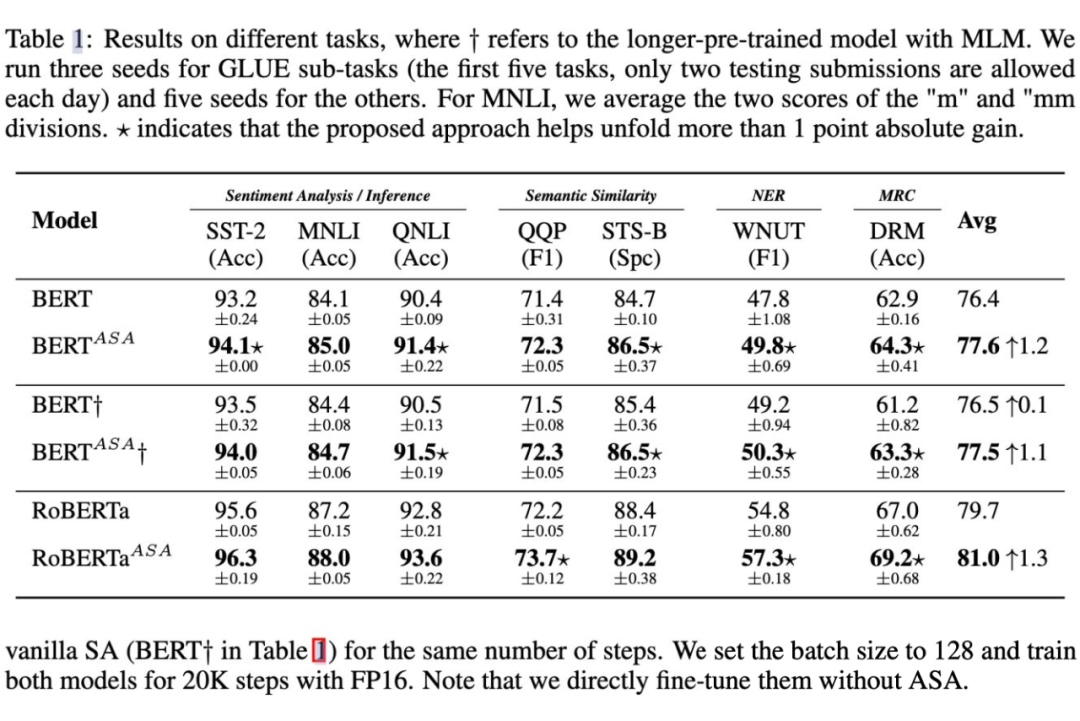

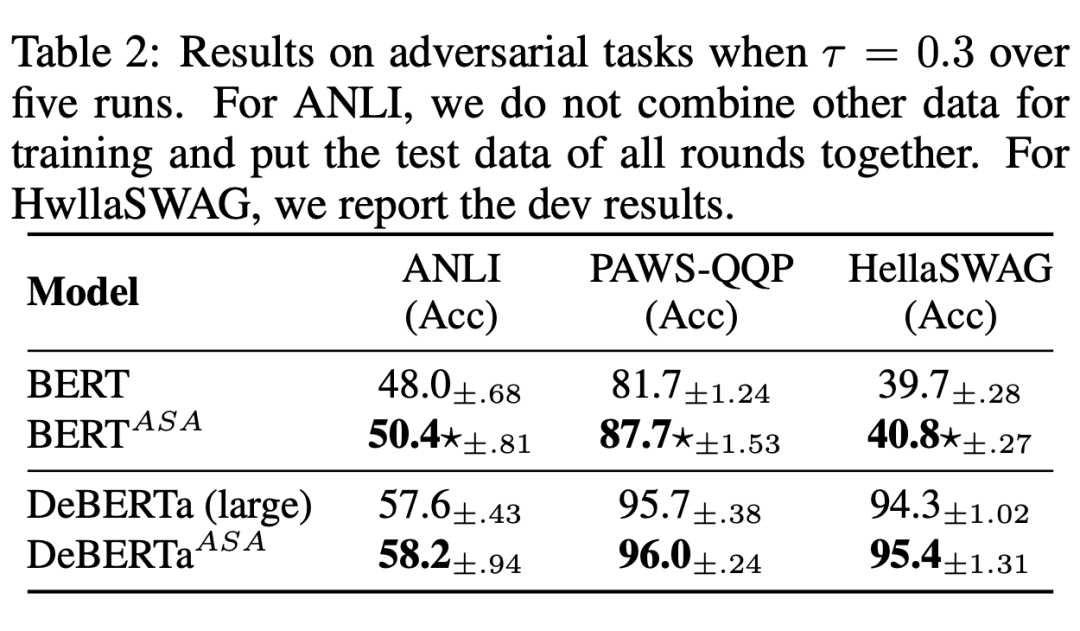

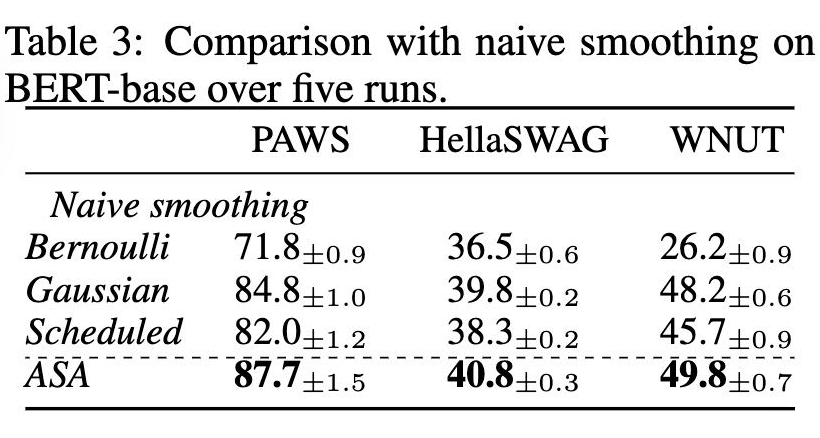

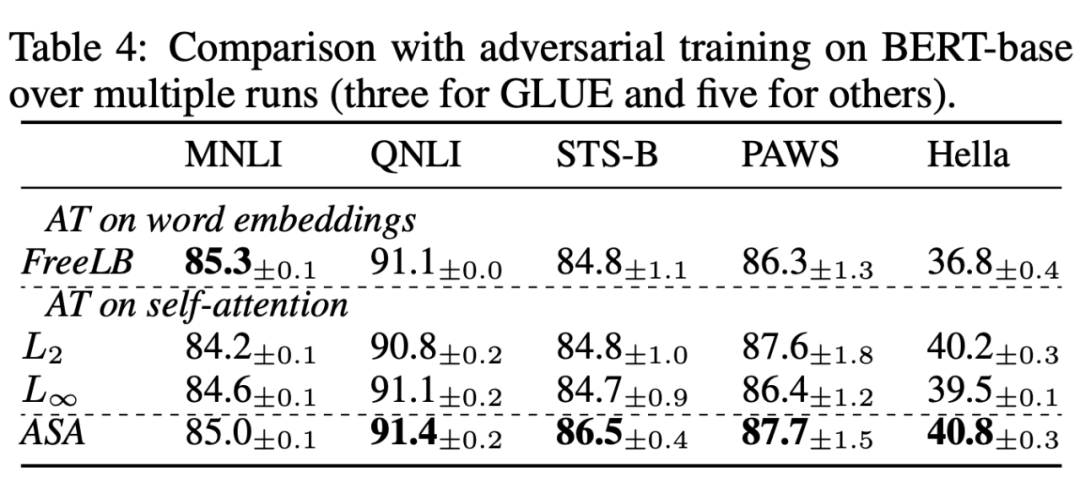

4.1 Result

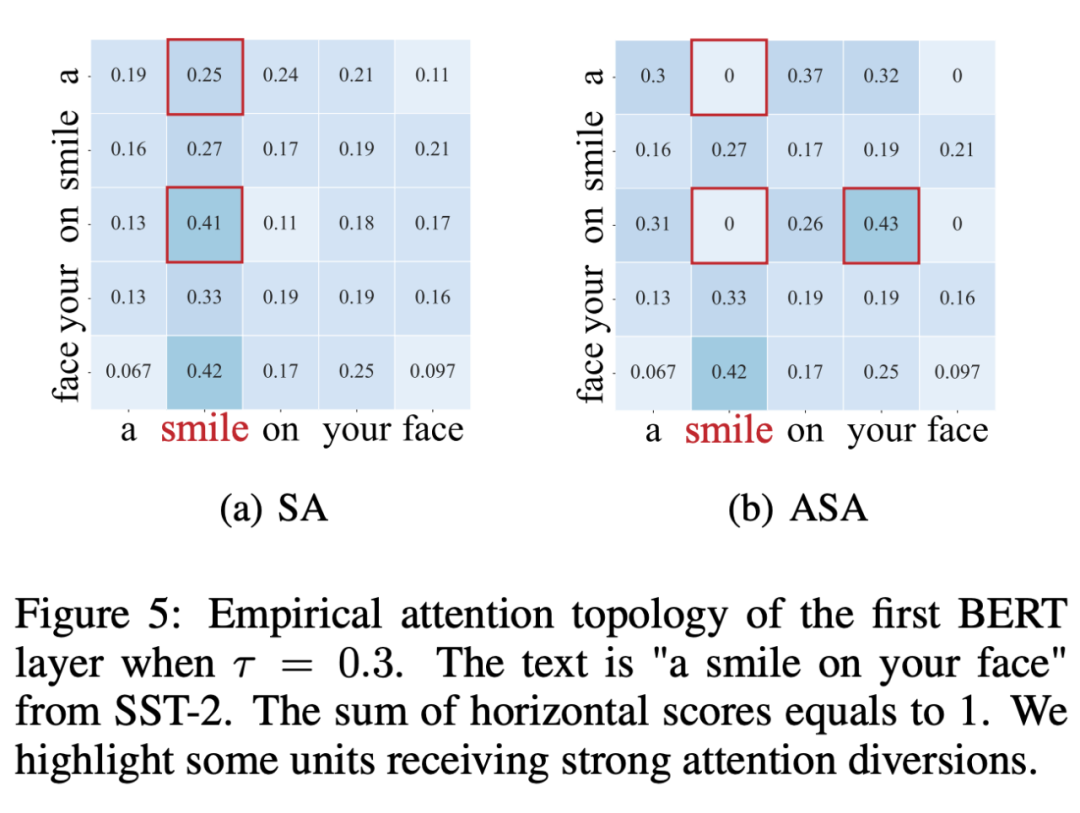

4.2 分析实验

4.3 Visualization

Conclusion

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧