【DeepMind】基于模型的强化学习,174页ppt,Model-Based Reinforcement Learning

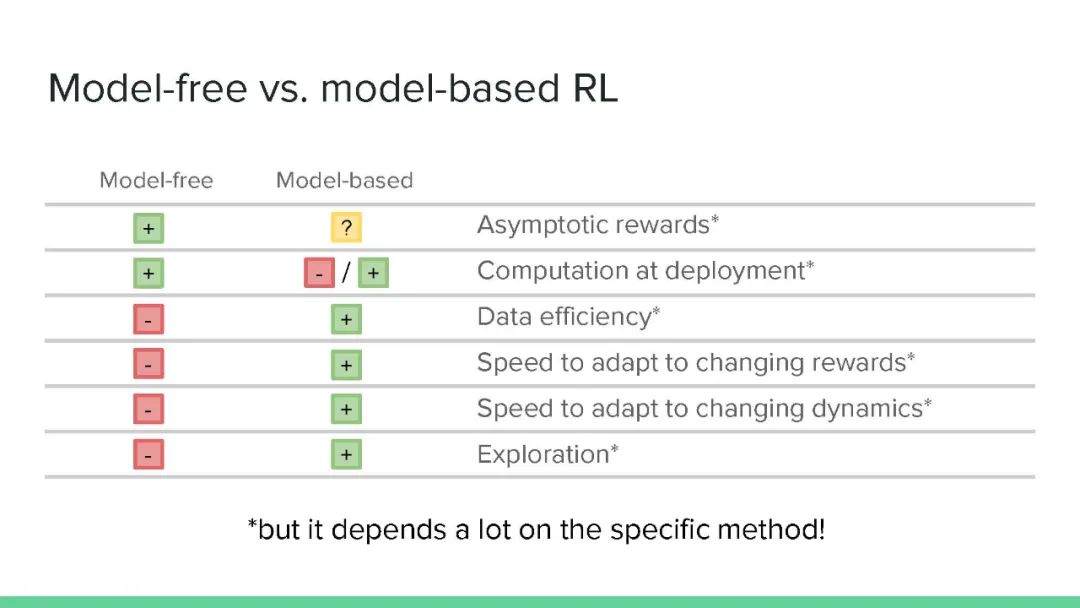

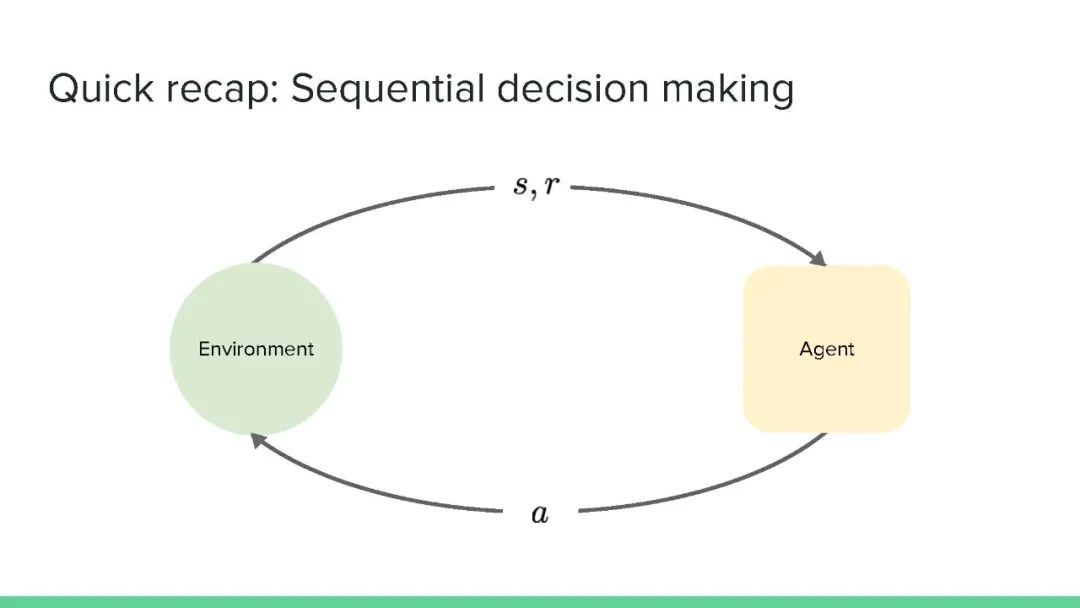

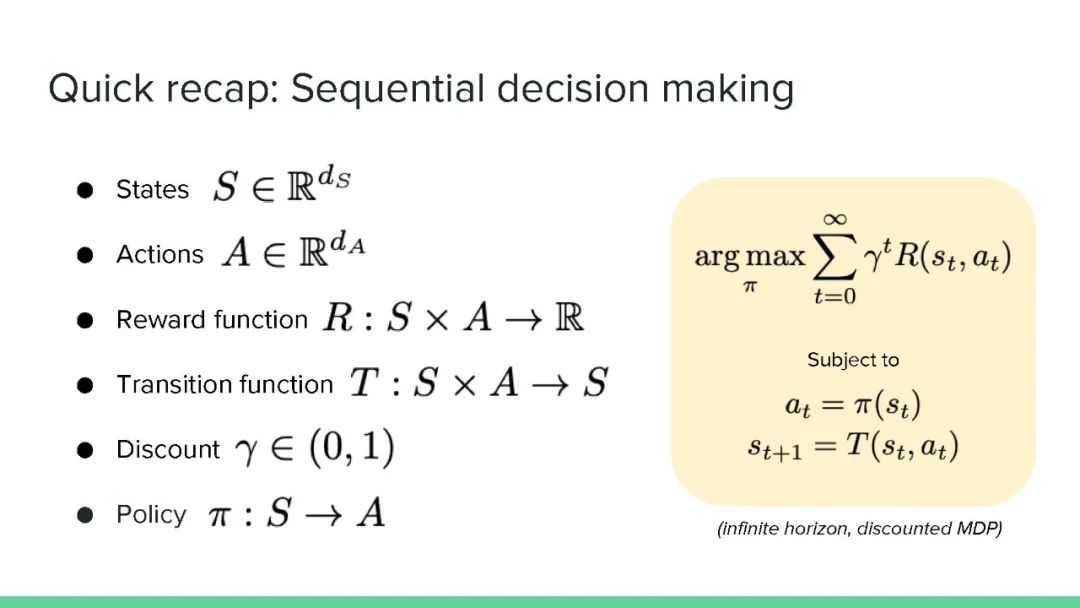

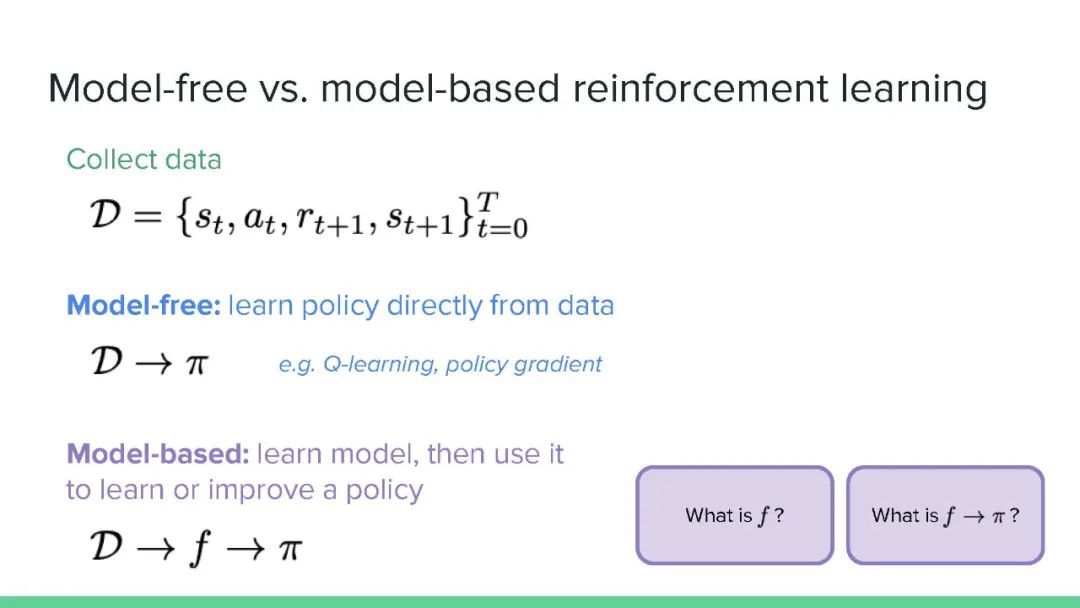

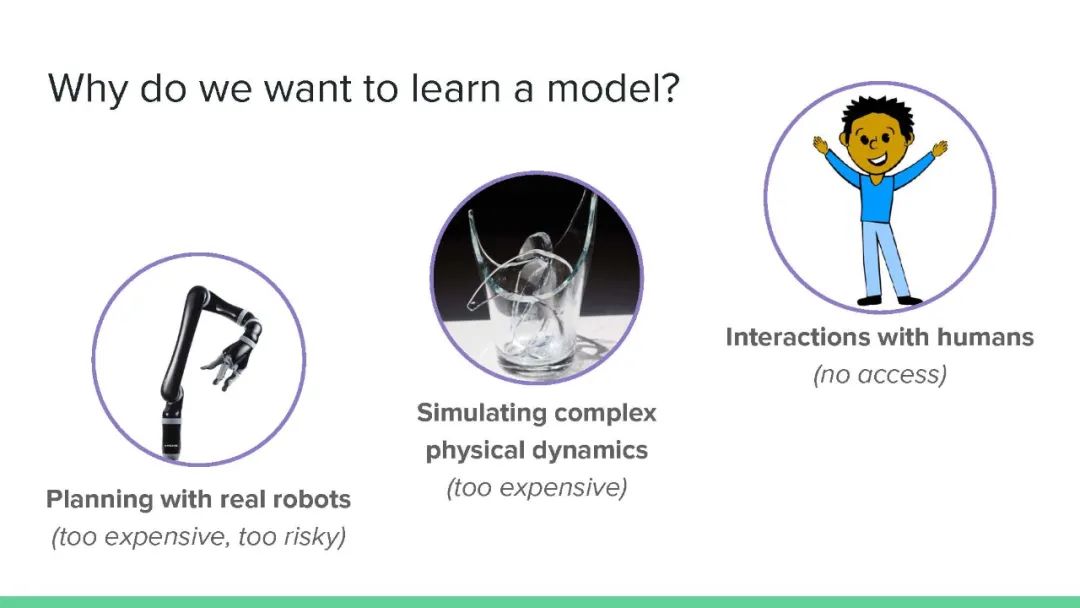

强化学习算法被广泛的认为可以分为两大类:无模型(Model-Free)的算法和基于模型(Model-Based)的算法。无模型的算法在过去一段时间在许多任务中已经取得了巨大的进步,这包括了机器人,视频游戏等。尽管这类算法取得了巨大的成功,但是由于其较高的采样复杂度,即需要与测试任务和环境进行大量的交互,生成样本,从而学习得到效果较好的策略,这使得无模型的强化学习算法难以应用到大量的实际场景问题中,而仅仅应用在具有仿真环境的问题当中。

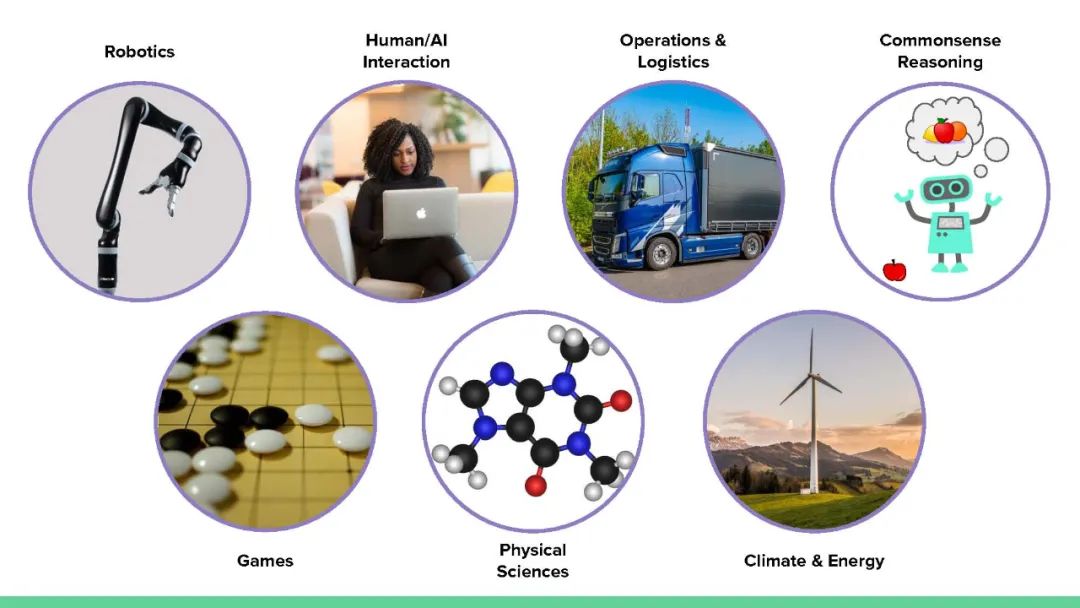

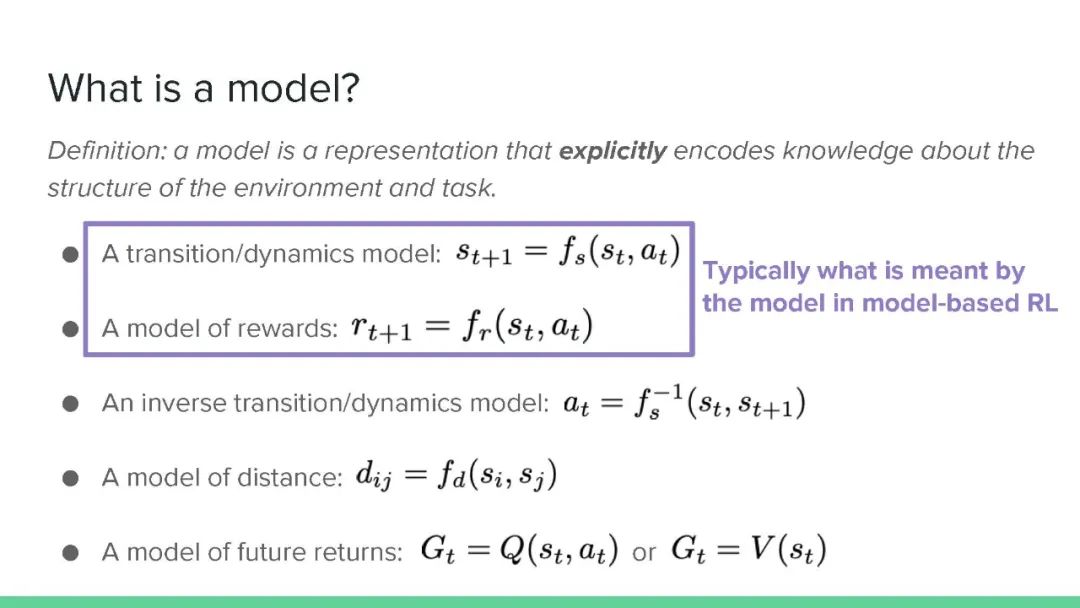

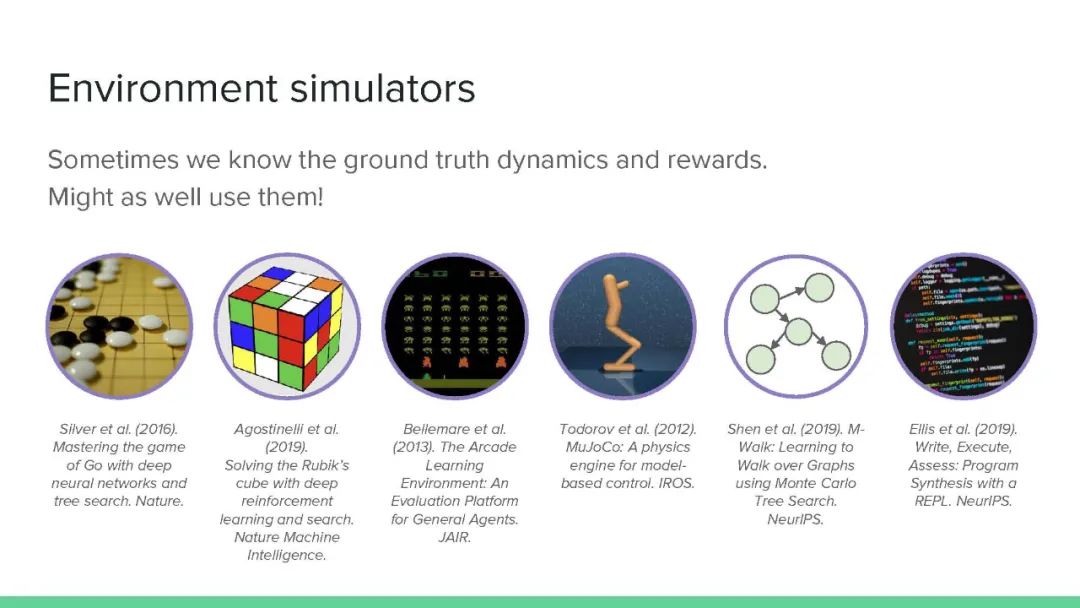

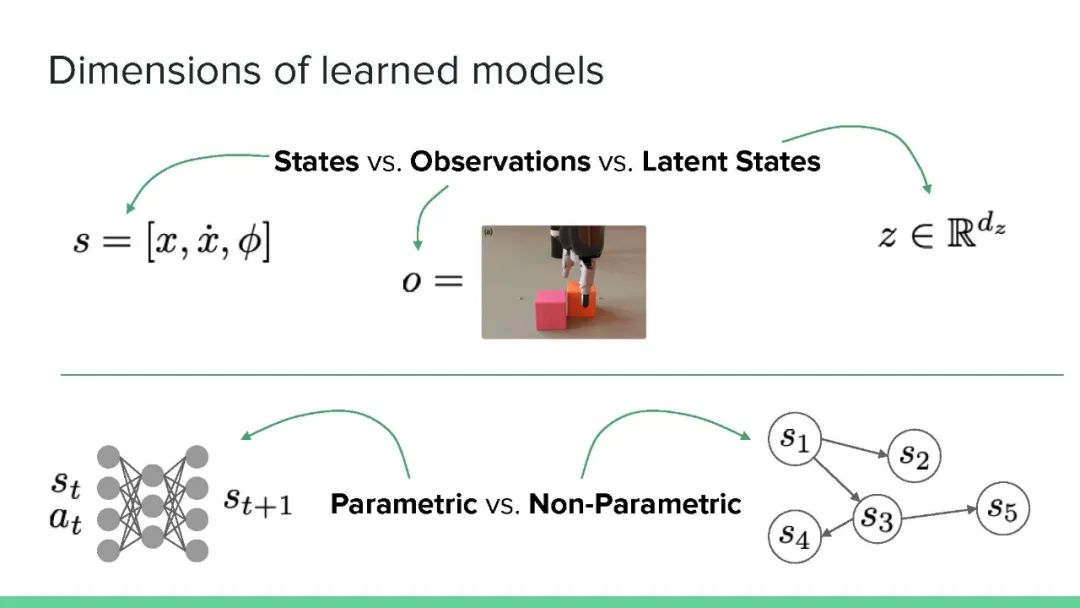

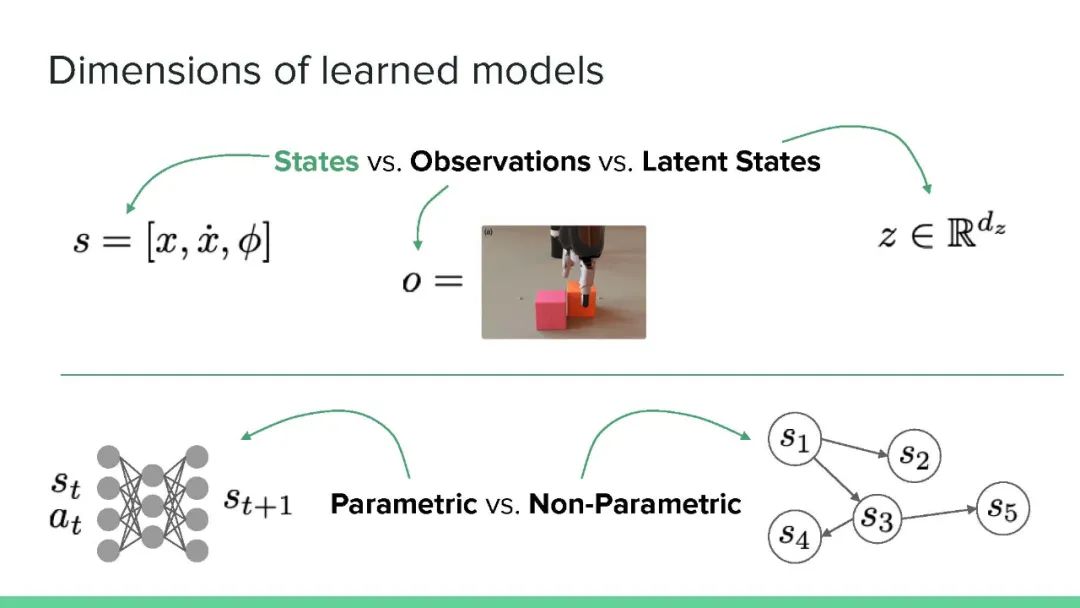

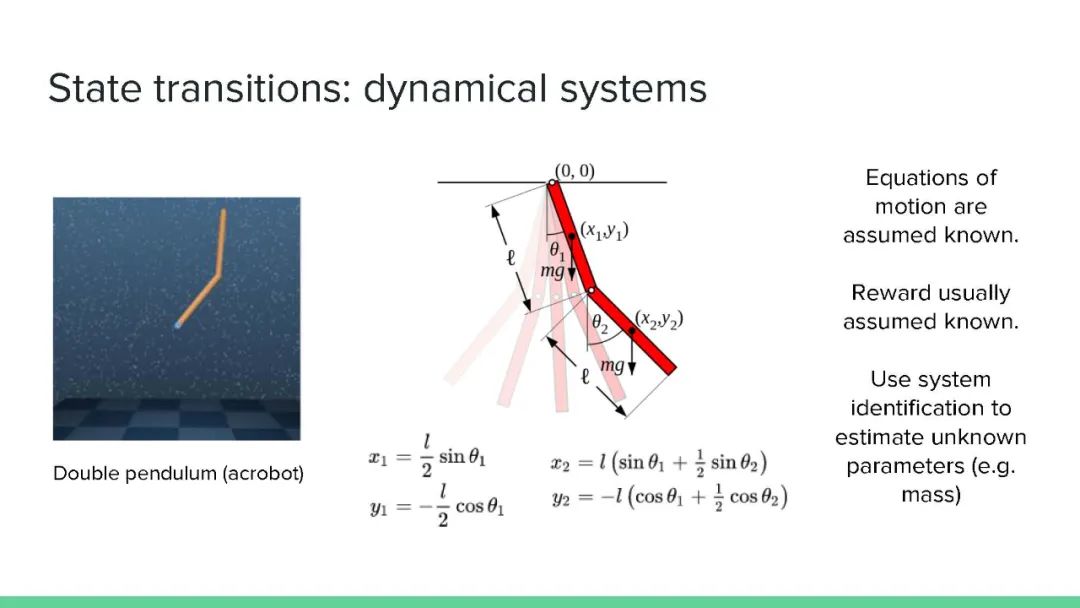

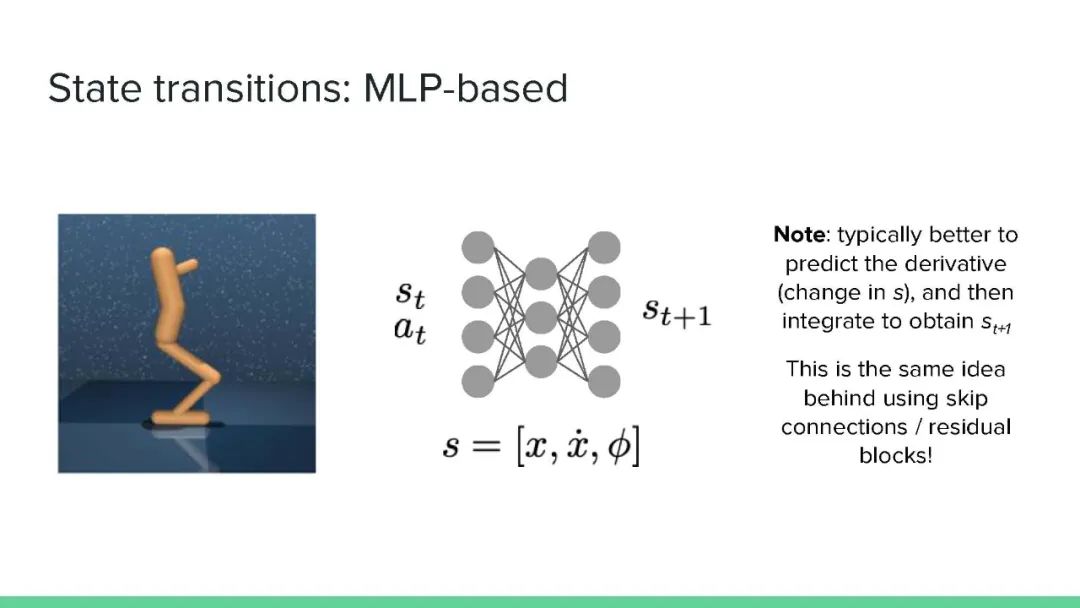

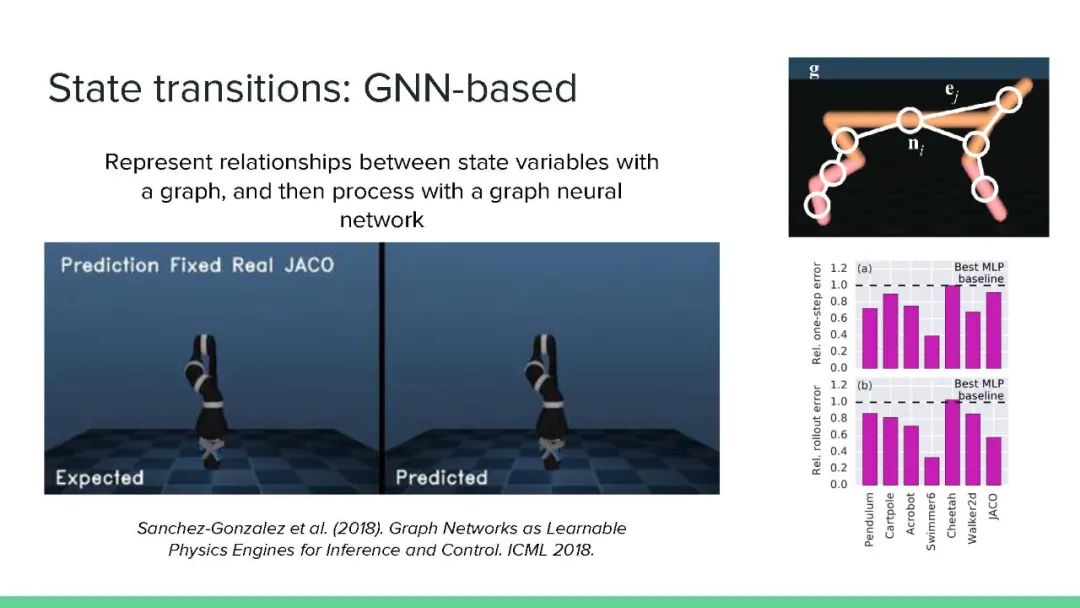

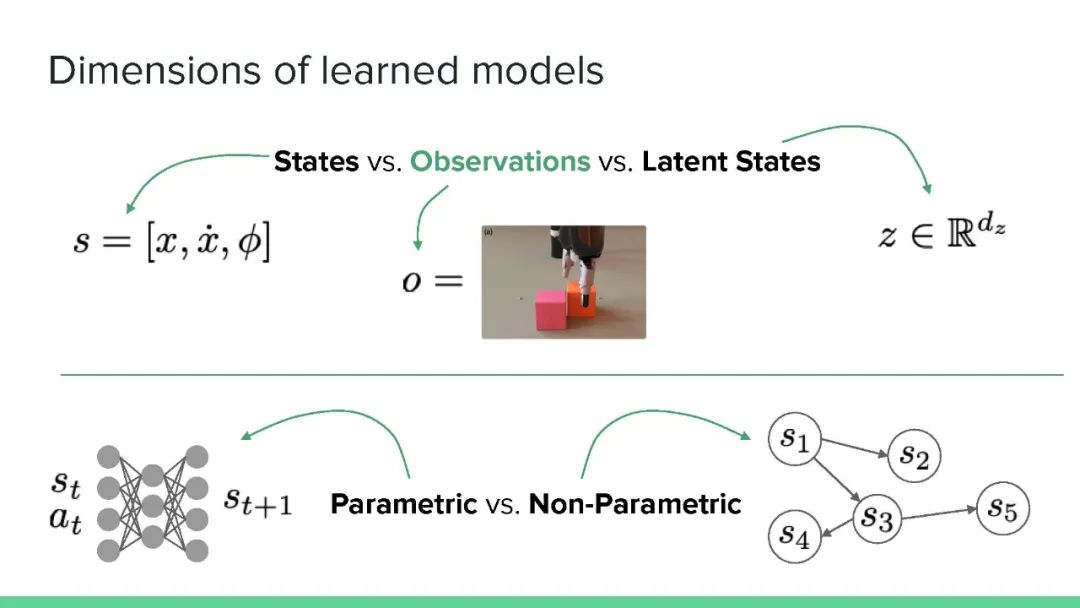

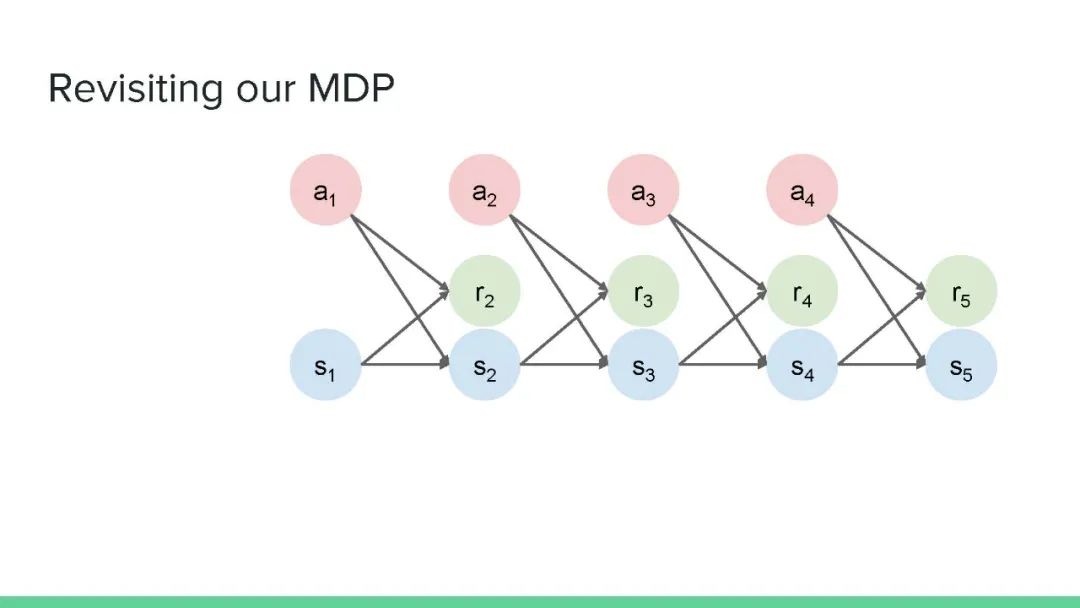

而通过学习一个近似环境的参数化的模型(Model),进而进一步帮助策略的学习的这类算法,被称为基于模型的算法,使得其相比无模型算法可以大大降低采样复杂度。本教程对基于模型的强化学习(MBRL)领域进行了广泛的概述,特别强调了深度方法。MBRL方法利用环境模型来做决策——而不是将环境看作一个黑箱——并且提供了超越无模型RL的独特机会和挑战。我们将讨论学习过渡和奖励模式的方法,如何有效地使用这些模式来做出更好的决策,以及计划和学习之间的关系。我们还强调了在典型的RL设置之外利用世界模型的方式,以及在设计未来的MBRL系统时,从人类认知中可以得到什么启示。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“RL174” 可以获取《【DeepMind】基于模型的强化学习,174页ppt,Model-Based Reinforcement Learning》专知下载链接索引

登录查看更多

相关内容

专知会员服务

131+阅读 · 2020年4月19日

专知会员服务

35+阅读 · 2019年12月12日

Arxiv

10+阅读 · 2021年2月22日