LSTM之父粉丝猛怼 Hinton:五篇主要深度学习论文未引用Jürgen早期工作!

新智元报道

【新智元导读】Reddit有人爆料,深度学习大神Hinton的五篇主要深度学习论文都没有引用Jürgen Schmidhuber早期的相关工作。Jürgen是LSTM之父、著名深度学习专家,然而其知名度远不及“深度学习三巨头”,再次引起业界热议。你怎么看?来新智元AI朋友圈 和AI大咖们一起讨论吧。

今天,一篇帖子打破了Reddit机器学习板块的平静:Geoff Hinton的五篇主要深度学习论文都没有引用Jürgen Schmidhuber早期的相关工作。

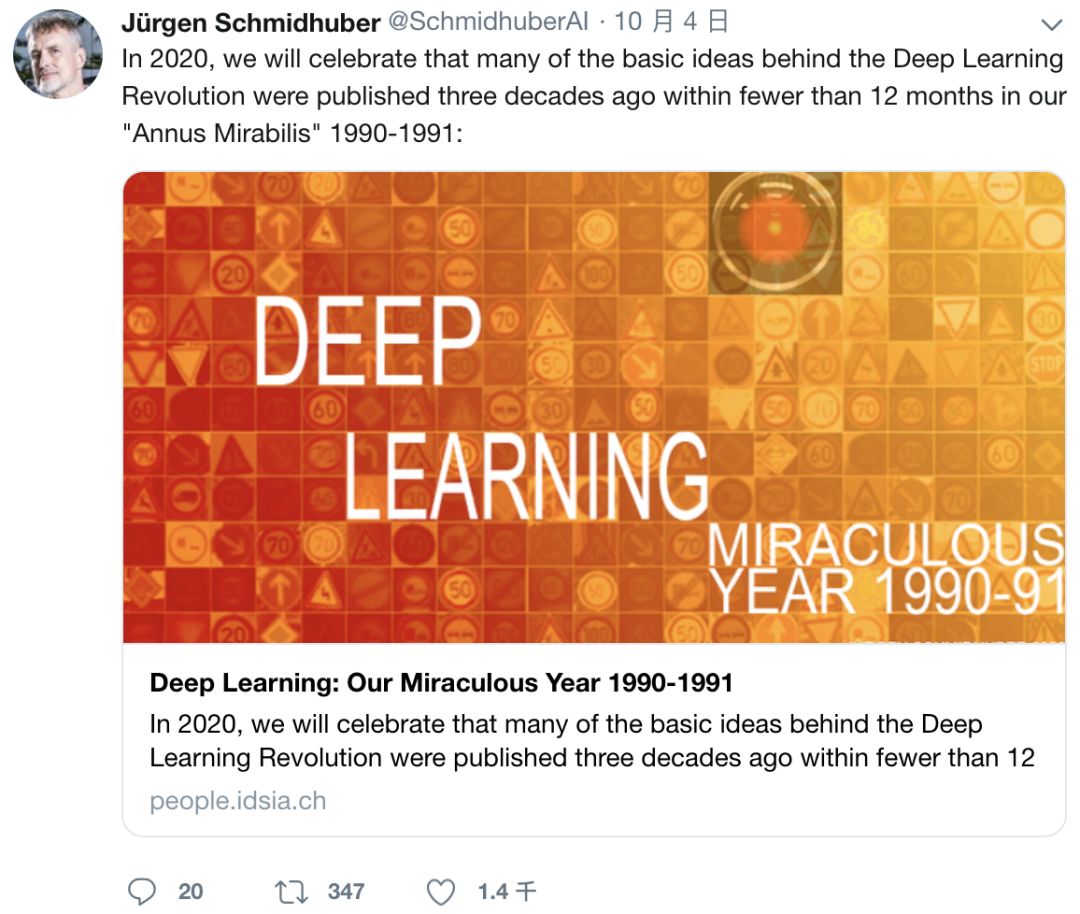

Jürgen Schmidhuber是LSTM 的发明人、著名深度学习专家。事情缘起于Jürgen上个月发表的一篇长文《Deep Learning: Our Miraculous Year 1990-1991》,他详细论述了近30年前,即1990~1991年之间他和团队进行的许多研究,并称这一年为“奇迹之年”。

新智元对这篇文章进行了翻译介绍,请参考:

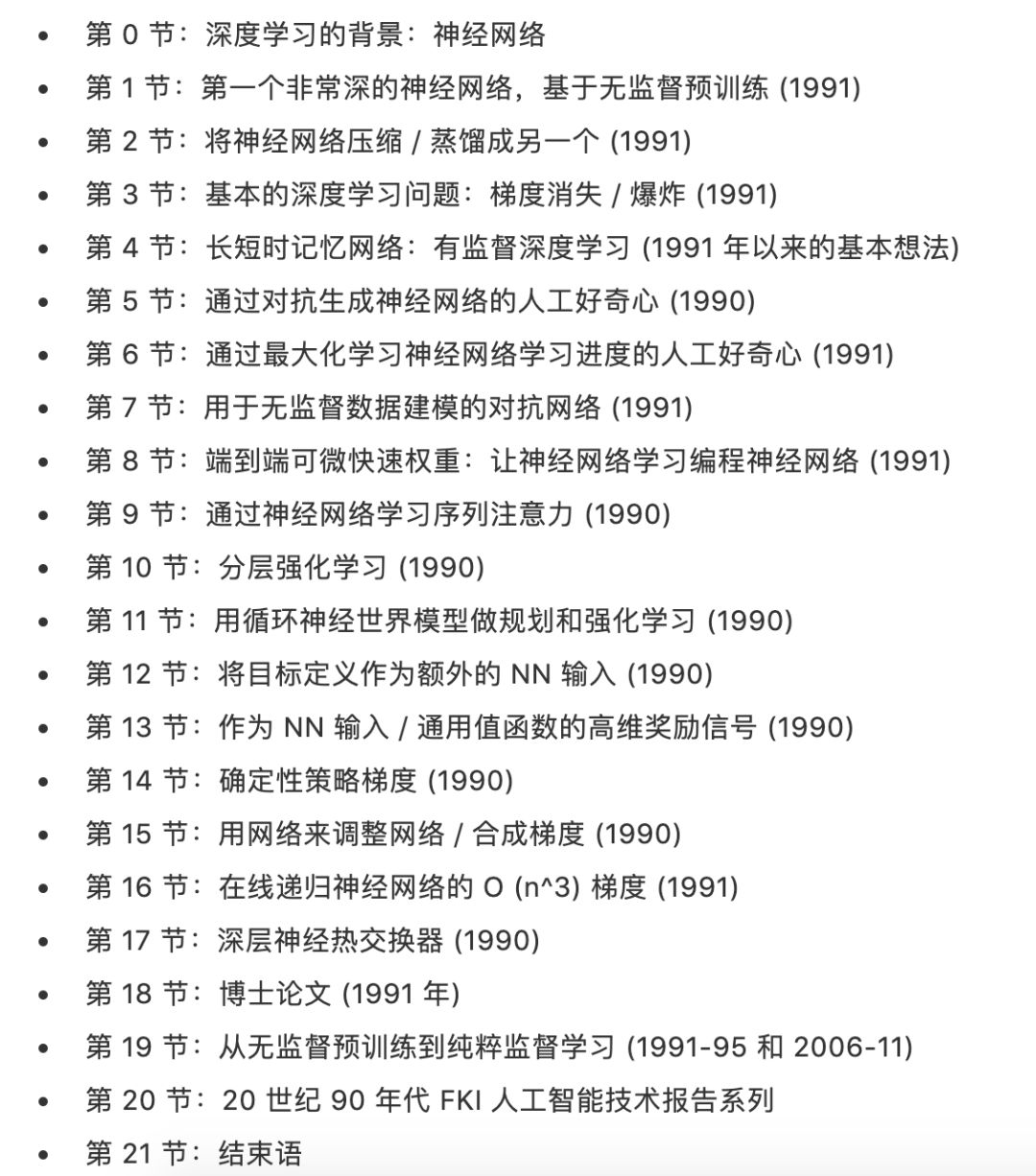

帖主自称是Jürgen“真正的粉丝”,他提到Jürgen的“奇迹之年”文章,指出:请看第1、2、8、9、10节,Jürgen提到了他们在Hinton之前很久做的工作,但Hinton都没有引用,这些研究的参考文献证实了这一点,乍一看,它并不明显,是隐藏的,必须要从参考文献中回溯才能发现。

帖主一一列举:

在“第1节,第一个非常深的神经网络,基于无监督预训练 (1991)”Jürgen“通过对RNN的层次结构进行无监督的预训练,促进了深度RNN的有监督的学习”,并且很快就能够“解决以前无法解决的深度学习任务,神经网络的层数超过了 1000 层”,他提到参考文献[UN4],实际上是Hinton后来的类似工作:

这项工作发表十多年后,一种用于更有限的前馈神经网络的类似方法出现了,称为深度置信网络 (DBN)。该论文的证明基本上就是我在 1990 年代早期为我的 RNN 堆栈使用的证明:每一个更高的层都试图减少下面层中数据表示的描述长度 (或负对数概率)。

在那个时候,无监督的预训练是一件大事,而现在已经不那么重要了。请参阅第19节“从无监督预训练到纯粹监督学习 (1991-95 和 2006-11)”

在“第 2 节:将神经网络压缩 / 蒸馏成另一个 (1991)”,Jürgen还训练了“一个学生NN来模仿教师NN的行为”,简要提到了Geoff后来的类似工作[DIST2]:

我称之为将一个网络的行为 “collapsing” 或 “compressing” 到另一个。今天,这个概念已经被广泛使用,也被称为将教师网络的行为 “蒸馏”(distilling) 或 “克隆” 到学生网络。

在“第 9 节:通过神经网络学习序列注意力 (1990)”,Jürgen写道:我们已经有了两种现在常见的神经序列注意力类型:通过神经网络中的乘法单元来实现端到端可微分的 “软” 注意力,以及在强化学习环境下的 “硬” 注意力。博客上提到后来的大量后续工作都基于此,包括Hinton类似工作[ATT3]:

我在CMSS 1990 [ATT2]上发表的概述论文总结了我们有关注意力的早期工作,据我所知,这是第一个已实现的神经系统,用于结合glimpses,共同训练识别和预测组件与注意力组件。二十年后,我1990年论文的审稿人写了他自己作为相关论文[ATT3]:“据我们所知,这是第一个将glimpses结合在一起的可实现系统,共同训练识别组件…注意力组件。”

与第10节“分层强化学习 (1990)”类似,Jürgen介绍了HRL“使用端到端可微的基于NN的子目标生成器HRL0,以及使用循环的NN学习生成子目标序列[HRL1] [HRL2]”,提到了Hinton后期的工作HRL3:

不久之后,其他人也开始发表HRL的文章。例如,我们参考文献[ATT2]的审稿人是参考文献 [HRL3]的作者(该审稿人在第6节中总结了我们关于HRL的早期工作)。

“第 8 节:端到端可微快速权重:让神经网络学习编程神经网络 (1991)”中,Jürgen发布了一个网络“通过梯度下降学习以快速操作另一个网络的快速权重存储”,和“主动控制快速的权重通过二维张量或外部产品更新权重”,指向的[FAST4a]论文恰好是Hinton后来的论文:

四分之一个世纪后,其他人也采用了这种方法[FAST4a]

确实,Hinton并没有在任何类似的论文中引用Jürgen,更有点疯狂的是,他是Jürgen 1990年的论文[ATT2]的编辑,该论文总结了注意力学习和分层RL,之后他发表了相关的论文,但是他没有引用Jürgen。

Jürgen还有一个著名的抱怨,即Hinton在《自然》杂志上发表的深度学习综述既没有提到反向传播的发明者(1960-1970),也没有提到“深度学习之父Alexey Grigorevich Ivakhnenko”,后者在1965年发表了首个适用于深度网络的通用学习算法。

除了Ivaknenko和Fukushima等六七十年代早期的先行者外,大多数深度学习的概念都来自于Jürgen与Sepp、 Alex和Dan等人的团队:深度网络的无监督预训练,人工好奇心和GAN,梯度消失,语言处理和语音的LSTM,蒸馏网络,注意力学习,赢得视觉比赛的CUDA CNN, 100层以上的深度网络,meta-learning,以及optimal AGI和Godel Machine的理论工作。

Jürgen 表示,深度学习革命背后的许多基本思想,是在 1990~1991 年不到 12 个月的时间里,在慕尼黑理工大学 (TU Munich) 产生的,而这些思想为当今的许多深度学习前沿研究奠定了基础,包括 LSTM、元学习、注意力机制和强化学习等。

Jürgen 称这一年为 “奇迹之年”。尽管当时他们发表的工作几乎无人问津,但四分之一个世纪后,基于这些想法的神经网络不断得到改进,其应用出现在智能手机等 30 多亿设备、每天被使用数十亿次,在全世界消耗大量的计算资源。

在 AI 领域,深度学习三巨头 Geoffrey Hinton、Yoshua Bengio 和 Yann LeCun 人尽皆知,Jürgen Schmidhuber 的知名度却远不及三人,尽管他发明的 LSTM 被认为是教科书级别的贡献。他是被图灵奖遗忘的大神。在Hinton等三巨头获图灵奖之时,Jürgen却得到了很大的呼声:“为什么Jürgen没有得图灵奖?”

除了 LSTM 之外,Jürgen Schmidhuber “引以为傲” 的还有他在 1992 年提出的 PM(Predictability Minimization)模型。他坚持认为现在大火的 GAN 就是 PM 的变种,两者的区别就在于方向是反的,为此,Jürgen 还和 GAN 的提出者 Ian Goodfellow 有过线上线下激烈的交锋,引起业界广泛讨论。

至于对深度学习三巨头 Hinton、Bengio 和 LeCun,Jürgen Schmidhuber 也打过几轮口水仗,认为三人在自己的圈子里玩,对深度学习领域其他更早期先驱人物的贡献则只字不提。

Reddit热议:Schmidhuber太过领先于时代

很多你以为新的东西其实早就存在了

feelings_arent_facts:我也一直在谈论DeepMind。DeepMind(和OpenAI)的发现并不比学术文献中已经发现的更新。他们只是碰巧拥有一支强大的前端和设计团队,以使其广为宣传,并为大众所用而已。

NER0IDE:例如DQN。以前很多人已经将函数逼近应用于Q网络。他们确实添加了一些技巧来使学习更加稳定,但是这个想法并不新鲜。

glockenspielcello:这是我认为人们会误会的地方。实际上,作为一个工程研究机构,DeepMind在许多方面其实更像个纯粹的科研机构。是的,他们并不一定在概念上取得任何突破,但这并不会减少使系统真正发挥作用的工程实践的价值。

之所以没有引用你的工作,是有客观原因的!

NewFolgers:电灯泡是两个人在同一天发明的。电话也是如此。随着GPU的处理技术的进步,2000年代末开始了深度学习的真正曙光,随后不久便开始了爆炸式增长。

我不是要淡化Schmidhuber和他的团队的才华和创新。我认为Schmidhuber及其团队的作品未得到足够重视的原因,是因为它太过领先于时代。任何领先时代的产物都需要从战略上重新审视。

相比图灵奖得主的影响力,我认为Schmidhuber及其团队成果的影响力微乎其微。从一个游戏开发人员的角度来看,这种情况一直存在。尤其是在ML不断加速行业工具和知识迭代的今天,我们要的是在最快的时间、找到正需要的东西。

Henry__Gondorff:我完全可以理解他的沮丧。由于我们的科学家没有得到足够的报酬,因此认可我们的工作就是对我们的最大奖赏。

但是,从他那里读到的内容来看,我必须说,我完全可以理解为什么他未被认可!他的作品(至少对我来说)很难理解,而且他经常将事情的“相似性”延伸得很远,与Goodfellow的互动就是一个很好的例子。科学不仅与发现有关,让其他科学家了解您的工作同样重要。在这一方面,他显然缺乏。

另外:,为什么像Hinton,Goodfellow等几乎所有的天才都拒绝了他的主张?是阴谋反对他吗?不,他们没有理由这样做。或者,更可能的一种推测是:他们都读了他的著作而忽略了它,因为它还不够重要。

另一个可能的原因是影响力会随着时间的流逝“衰落”。即使他提出了所有这些东西,都太久远了。人们的注意力跨度很短,旧的东西很快就会被人遗忘,这就是世界运转的方式。

以我个人的观点:假设Schmidhuber确实是一位出色的科学家,他也是有点自大狂妄(我想即使是他的粉丝也不能否认这一点)如果不是这次事件,可能没有人会知道他的名字。

并且,滥用审稿人的职位,来迫使另一位科学家引用你的那些显然无关的工作,是一件恶心的事情。

参考链接:https://www.reddit.com/r/MachineLearning/comments/e3buo3/d_five_major_deep_learning_papers_by_geoff_hinton/

-

与国内外一线大咖、行业翘楚面对面交流的机会 -

掌握深耕人工智能领域,成为行业专家 -

远高于同行业的底薪 -

五险一金+月度奖金+项目奖励+年底双薪 -

舒适的办公环境(北京融科资讯中心B座) -

一日三餐、水果零食

新智元邀你2020勇闯AI之巅,岗位信息详见海报: