Reddit热议被引最多的机器学习论文:上世纪LSTM称霸,何恺明今年被引1.8w居首

新智元报道

新智元报道

来源:reddit

整理:大明

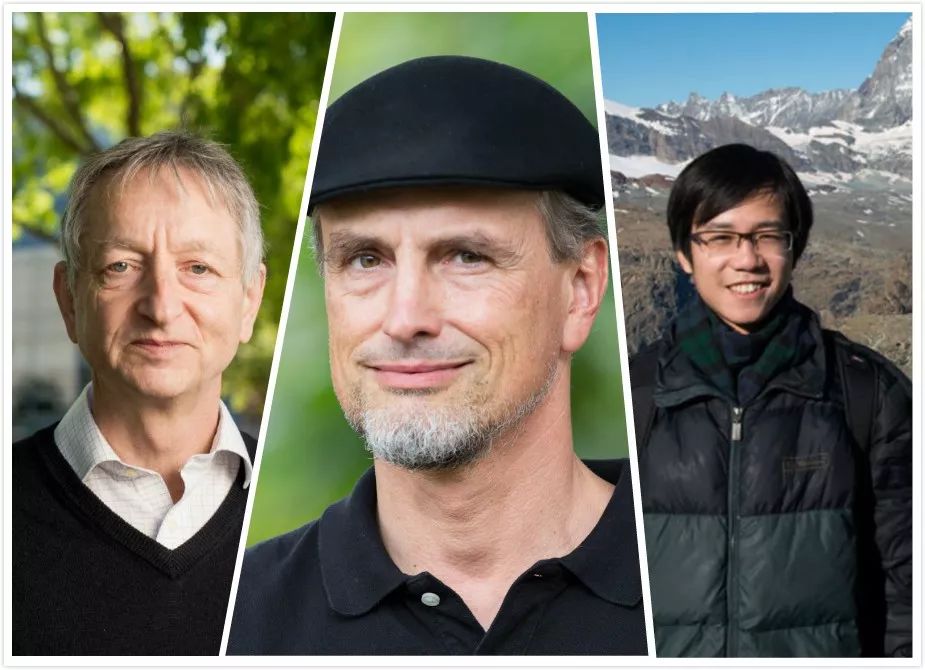

【新智元导读】机器学习和AI今天的繁荣离不开前辈们的辛勤耕耘。近日,Reddit网友总结了20世纪和21世纪被引用数最多的一些机器学习论文。这些论文的作者很多都已成为“大神”,正是因为他们的“披荆斩棘”,才有了今天的“花团锦绣”,吃水不忘打井人,一起来看看这些文章吧!戳右边链接上 新智元小程序 了解更多!

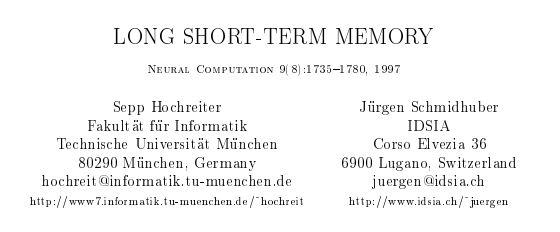

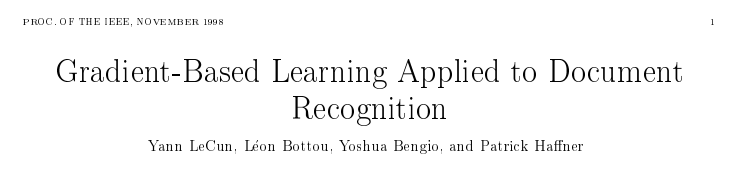

20世纪:LSTM以2.6w次居榜首,超越经典的“反向传播”算法

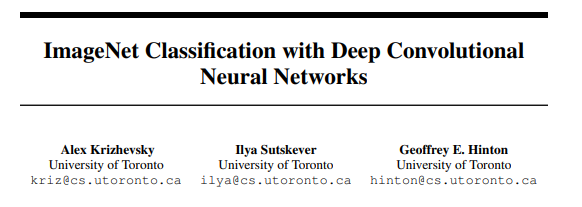

21世纪:ImageNet冠军受热捧,何恺明ResNet今年被引1.8w

深度学习革命的核心:一切源自LSTM?

登录查看更多

相关内容

专知会员服务

29+阅读 · 2019年12月25日

专知会员服务

36+阅读 · 2019年10月17日

Arxiv

4+阅读 · 2019年12月12日

Arxiv

6+阅读 · 2018年6月21日