![]()

本文为约2384字,建议阅读4分钟

本文介绍了LLNL国家实验室发布的《计算高效深度学习:算法趋势和机遇》。

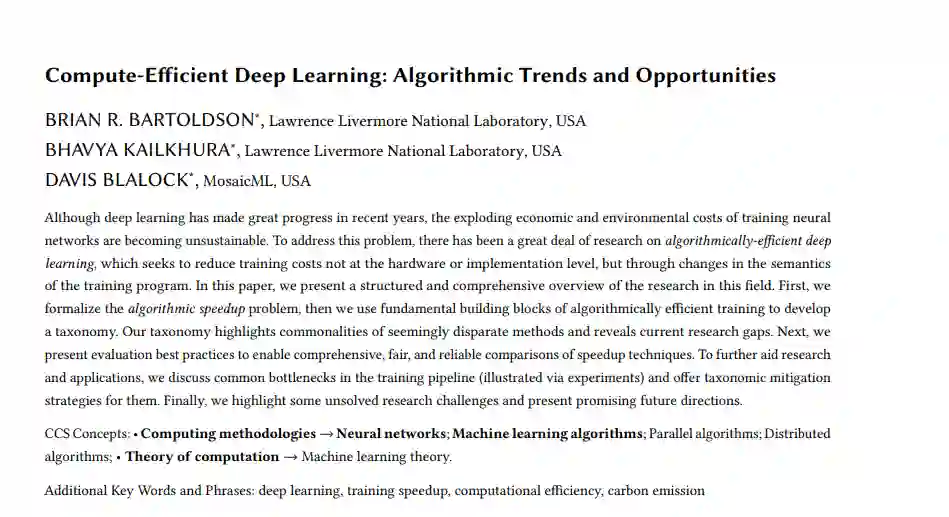

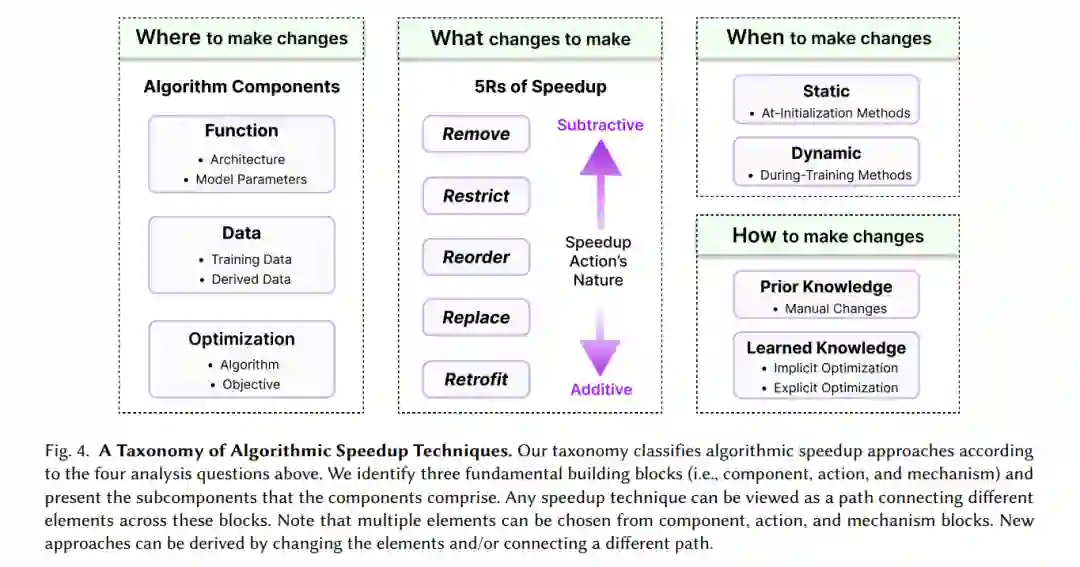

尽管近年来深度学习取得了巨大进展,但训练神经网络所带来的爆炸式经济和环境成本正变得不可持续。为了解决这个问题,已经有大量关于算法高效深度学习的研究,这些研究旨在通过改变训练程序的语义,而不是在硬件或实现级别上降低训练成本。本文对该领域的研究进行了系统、全面的综述。首先,我们将算法加速问题形式化,然后我们使用算法高效训练的基本构建块来开发分类。我们的分类强调了看似不同的方法的共性,并揭示了当前的研究差距。接下来,我们将介绍评估最佳实践,以实现对加速技术的全面、公平和可靠的比较。为进一步帮助研究和应用,讨论了训练管道中的常见瓶颈(通过实验说明),并为它们提供分类缓解策略。最后,我们强调了一些尚未解决的研究挑战,并提出了有希望的未来方向。

原文链接:https://arxiv.org/abs/2210.06640

在过去的几年里,深度学习(DL)在广泛的应用领域取得了显著的进展,如蛋白质结构预测(AlphaFold [Jumper et al。2021])、文本到图像合成(DL - e [Ramesh et al。2021])、文本生成(GPT-3 [Brown等人。2020a])等。实现这些性能提升的关键策略是将DL模型扩展到非常大的规模,并对它们进行大量数据的训练。对于大多数应用程序,可训练参数的数量至少每18至24个月翻一番——语言模型以4至8个月的翻倍时间领先(Sevilla and Villalobos 2021)。

大规模人工智能模型的著名例子包括:用于视觉应用的Swin Transformer-V2 [Liu等人2022a],用于语言建模的PaLM [Chowdhery等人2022],用于内容推荐的波斯[Lian等人2021],具有100万亿参数。

尽管扩大DL模型正在实现前所未有的进步,但训练大型模型已经变得极其昂贵。例如,GPT-3训练成本估计为165万美元,使用谷歌v3 TPU[Lohn和Musser 2022],且transformer 模型的低效/幼稚开发将产生相当于5辆汽车终生碳足迹的二氧化碳(CO2) [Strubell等人,2019]。值得关注的是,DL仍然没有达到许多应用所要求的性能水平:例如,在现实世界中部署全自动驾驶汽车需要人类水平的性能,但还没有达到。不断增长的模型和数据规模以达到所需的性能将使当前的训练策略在金融、环境和其他方面不可持续。事实上,根据目前的趋势推断,

2026年最大的人工智能模型的训练成本将超过美国的GDP总量

(Lohn and Musser 2022)。此外,DL对计算的高度依赖引发了人们对财务资源有限的用户(如学者、学生和研究人员(特别是来自新兴经济体的人)的边缘化的担忧[Ahmed and Wahed 2020]。我们将在附录A中更详细地讨论这些关键问题。

考虑到其计算负担的不可持续增长,DL的进步需要更多的计算效率训练方法。一个自然的方向是

消除学习过程中的算法效率低下,以减少DL训练的时间、成本、能量和碳足迹

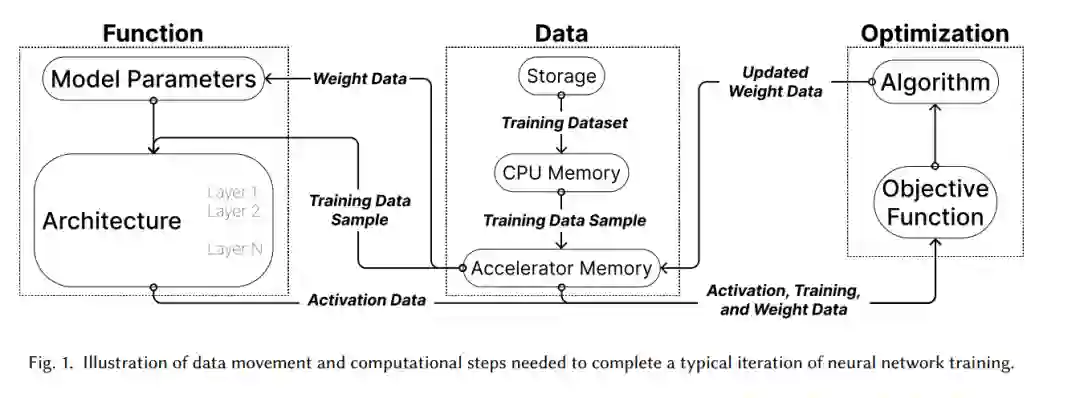

。这种算法高效的深度学习方法可以通过多种方式改变训练过程,包括:改变数据或样本呈现给模型的顺序;调整模型的结构;改变优化算法。这些算法改进对于实现有效深度学习训练所需计算负担的估计下界至关重要,目前的做法导致的负担大大超过了该下界[Thompson等人,2020]。此外,这些算法增益与软件和硬件加速技术相结合[Hernandez和Brown 2020]。因此,我们相信算法高效的逻辑学习提供了一个巨大的机会来增加逻辑学习的收益并降低其成本。

虽然最近涌现的算法效率论文支持了这一观点,但这些论文也表明,算法效率方法的研究和应用受到碎片化的阻碍。不同的指标被用来量化效率,这产生了不一致的加速方法的排名。评估是在狭窄或特征不佳的环境中执行的,这将导致不正确或过于宽泛的结论。在讨论算法效率方法时,缺乏反映它们的广度和关系的分类法,这使得人们很难理解如何遍历加速环境,将不同的方法结合起来并开发新的方法。因此,本文的核心贡献是组织算法效率文献(通过受[Von Rueden等人2019]启发的分类法和调研),以及对影响报告和实现加速的实际问题的技术描述(通过评估和实践指南)。我们的讨论始终强调这两个重点的关键交集:例如,算法效率方法是否会导致实际的加速确实取决于方法(通过我们的分类法可以理解)和计算平台(通过我们的从业者指南可以理解)之间的交互。我们的

贡献

总结如下:

-

形式化加速

:我们回顾DNN效率指标,然后形式化算法加速问题。

-

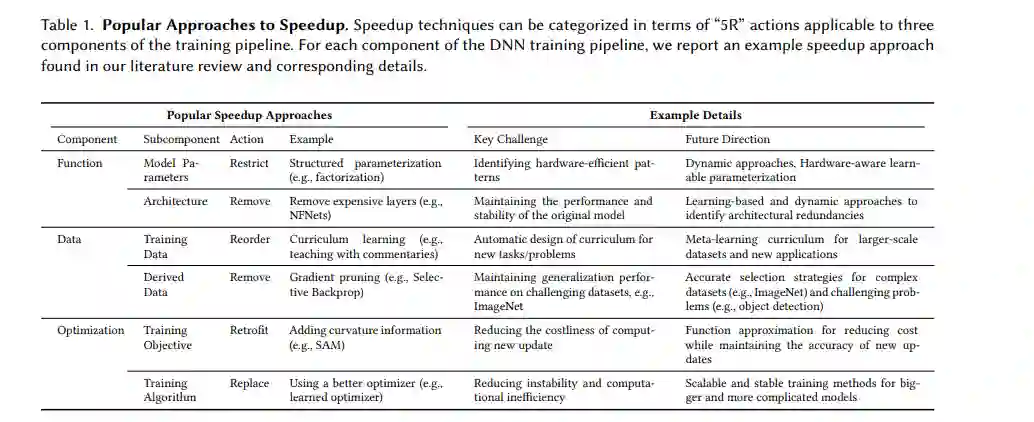

分类和调研

:我们通过适用于3个培训管道组成部分的5个加速行动(5Rs)对200多篇论文进行分类(见表1和表3)。分类有助于为从业者选择方法,为读者消化文献,并为研究人员识别机会。

-

最佳评估实践

:我们识别了文献中常见的评估陷阱,并相应地提出最佳评估实践,以实现对各种加速技术的全面、公平和可靠的比较。

-

从业者指南

:我们讨论了影响加速方法有效性的计算平台瓶颈。根据训练管道中瓶颈的位置,提出适当的方法和缓解措施。

![]()

有了这些贡献,我们希望改进算法效率的研究和应用,这是计算效率深度学习的关键部分,需要克服现有研究面临的经济、环境和包容相关的障碍。本文主要分为四个部分:第2节概述了DNN训练和效率度量以及算法加速问题的形式化。第3节使用广泛适用的加速方法的构建块以及它们影响的训练管道组件来开发我们的分类法。第4节根据我们的分类法对加速文献进行了全面的分类,并讨论了研究机会和挑战。第5节和第6节分别讨论了比较不同方法的最佳评估实践和选择合适的加速方法的实际建议。最后,第7节总结并提出了算法效率领域的开放问题。

![]()

![]()

报告链接:

https://www.zhuanzhi.ai/vip/8eeded2b8ab57cba639c26c2c58b4477