机器学习三个时代的计算趋势

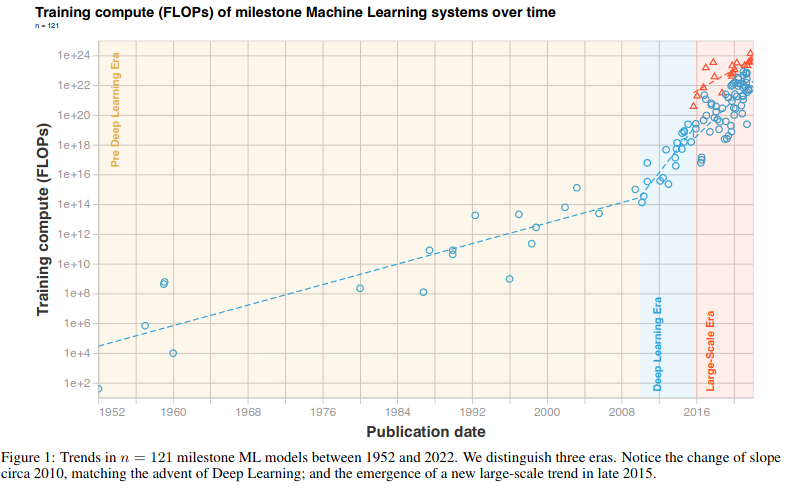

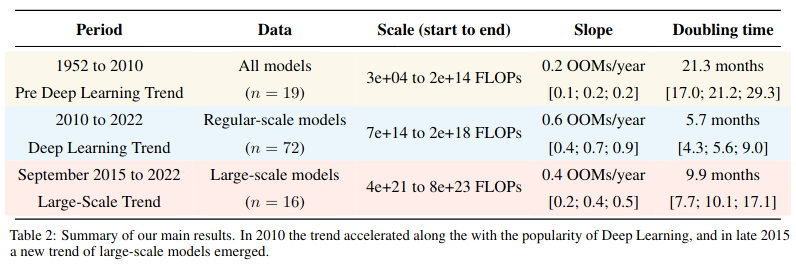

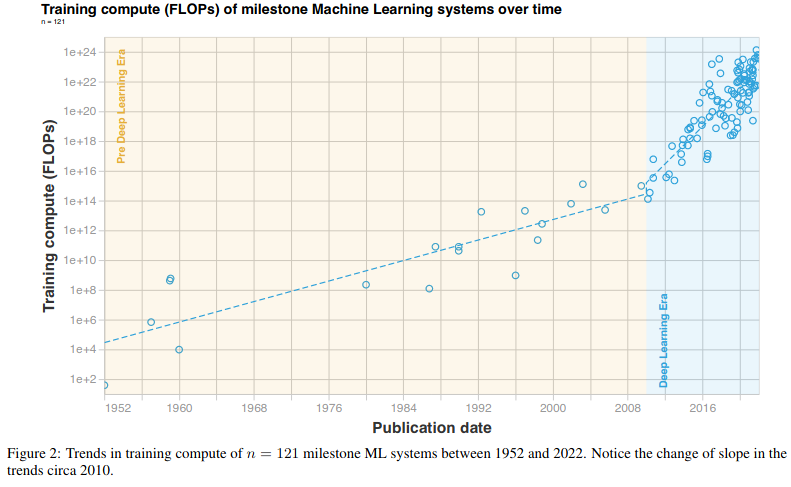

在 2010 年之前,训练计算的发展与摩尔定律同步,每两年一翻;自 2010 年代初,引入深度学习以来,训练计算的速度已经加快,大约每六个月增加一倍;2015 年末,出现了一种新的趋势。

基于这些观察,机器学习的计算历史被划分为三个时代——前深度学习时代、深度学习时代 和 大规模时代。本文总结了用于训练高级机器学习系统快速增长的计算需求。

比较是在一个由 123 个里程碑式的机器学习系统组成的数据集上进行的,并标注了训练它们所需的计算量。在深度学习起步之前,有一段进展缓慢的时间,这种趋势在 2010 年加速,此后一直没有放缓。另外,在 2015 年和 2016 年,出现了大规模模型的新趋势,以比上一个时代快两个数量级的速度扩张。

来源: https://arxiv.org/pdf/2202.05924.pdf

在深度学习出现之前和之后,人们注意到了两种不同的趋势机制。

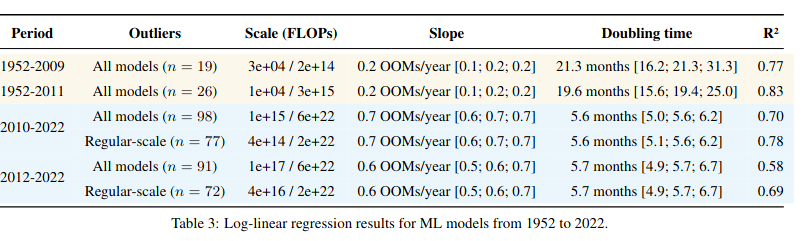

此前,训练机器学习算法所需的算力是每 17 至 29 个月翻一番。之后,整体趋势加快速,每 4 到 9 个月翻一番。

根据摩尔定律,晶体管密度每两年翻一番(Moore,1965 年),通常简化为计算性能每两年翻一番——基本上符合前深度学习时代的趋势。目前尚不清楚深度学习时代何时开始,从前深度学习到深度学习时代的过渡没有明显的间断。此外,无论深度学习时代始于 2010 年还是 2012 年,结果几乎都不会改变。

来源:https://arxiv.org/pdf/2202.05924.pdf

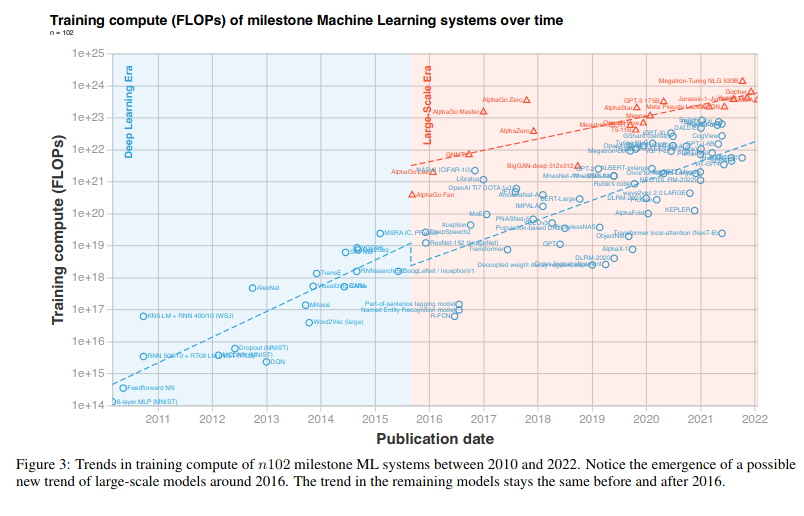

数据显示,大规模型模型的新趋势始于 2015-2016 年,这种新趋势始于 2015 年底的 AlphaGo,一直持续到现在,大规模模型是由大公司训练的,更高的训练预算可能是打破先前的趋势的原因。

另外,常规规模模型受欢迎的程度并未受到影响,这一趋势在 2016 年之前和之后是相同的速度,每 5 到 6 个月翻一番,如下表所示。大规模模型的计算量增加的趋势明显放缓,每 9 到 10 个月翻一番。由于这些模型的数据有限,明显放缓可能是噪声的结果。

这一发现与 Amodei & Hernandez (2018) 和 Lyzhov (2021) 形成对比,前者发现 2012 年至 2018 年的倍增期为 3.4 个月,后者发现 2018 年至 2020 年的倍增期超过 2 年。以前的评估无法区分这两个独立的模式,因为大规模的趋势是最近才发展起来的。

来源:https://arxiv.org/pdf/2202.05924.pdf

研究结果与早期研究一致,这显示了训练计算更适度的规模。1952 年到 2010 年有 18 个月的倍增时间,2010 年到 2022 年有 6 个月的倍增时间,从 2015 年末到 2022 年的大规模新趋势,快了 2 到 3 个数量级,倍增时间为 10 个月。

总而言之,在前深度学习时代,计算进展缓慢,随着 2010 年进入深度学习时代,这种趋势加速了。在 2015 年底,企业开始生产优于趋势的大规模模型,如 AlphaGo,标志着大规模时代的开始。然而,这并不能确定区分大规模和常规规模的模型而形成模式。

在计算机教学中,硬件基础设施和工程师的作用越来越大,凸显了两者的战略必要性。获得巨大的计算预算或计算集群,以及应用它们的专业知识,已经成为前沿机器学习研究的代名词。

原文链接:

https://www.marktechpost.com/2022/03/18/this-research-paper-explain-the-compute-trends-across-three-eras-of-machine-learning

你也「在看」吗?👇