CVPR2019丨首个siamese网络中训练GCNs的视觉追踪方法《Graph Convolutional Tracking》

加入极市专业CV交流群,与6000+来自腾讯,华为,百度,北大,清华,中科院等名企名校视觉开发者互动交流!更有机会与李开复老师等大牛群内互动!

同时提供每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流。关注 极市平台 公众号 ,回复 加群,立刻申请入群~

本文转自CSDN,作者授权转载,不得二次转载

作者:INDEMIND

原文链接:https://blog.csdn.net/weixin_43922139/article/details/93203536

论文:Graph Convolutional Tracking

链接:

http://nlpr-web.ia.ac.cn/mmc/homepage/jygao/JY_Gao_files/Conference_Papers/GCT-CVPR2019-GJY.pdf

视觉目标跟踪是计算机视觉中的一个基本问题,具有广泛的应用前景,视觉跟踪的典型场景是跟踪未知目标对象。虽然近几十年来有了很大的进展,但是视觉跟踪仍然是一个具有挑战性的问题,主要是由于遮挡、变形、突然运动、光照变化、背景杂波等引起的较大外观变化。

在本次CVPR 2019峰会论文中,来自中科院模式识别国家重点实验室、中国科学院大学、中国科学技术大学Junyu Gao、Tianzhu Zhang、Changsheng Xu团队的一篇《Graph ConvolutionalTracking》为我们提供了一种在siamese网络下训练GCNS的视觉追踪方法,实现了存在遮挡、突然运动、背景杂波情景下的鲁棒视觉追踪。

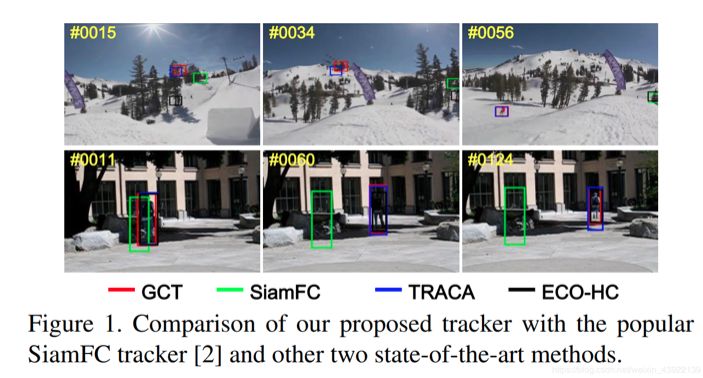

论文为了综合利用目标样本的时空结构并从语境(context)信息中获得更多信息,提出了一种用于高性能视觉追踪的图形卷积追踪(GCT)方法。该方法采用时空GCN对历史目标范例的结构化表示进行建模,并利用当前帧的语境学习目标定位的自适应让GCT将两种类型的图关联网络(GCNs)合并到一个siamese框架中,用来为目标外观建模,使该方法在50帧/秒的情况下实现优于最先进的追踪器的性能。

方法亮点

论文探索了一种端到端图卷积跟踪框架。据论文描述,这是第一个在siamese深度视觉跟踪网络中训练GCNs的方法。

ST-GCN和CT-GCN都是在Siamese网络中设计的。提出的GCT可以联合实现目标的时空外观建模和基于语境的自适应学习,实现目标的鲁棒定位。

五种视觉跟踪benchmarks的大量实验结果证明了所提出的GCT算法优于最先进的跟踪器,并且可以实时运行。

方法思路

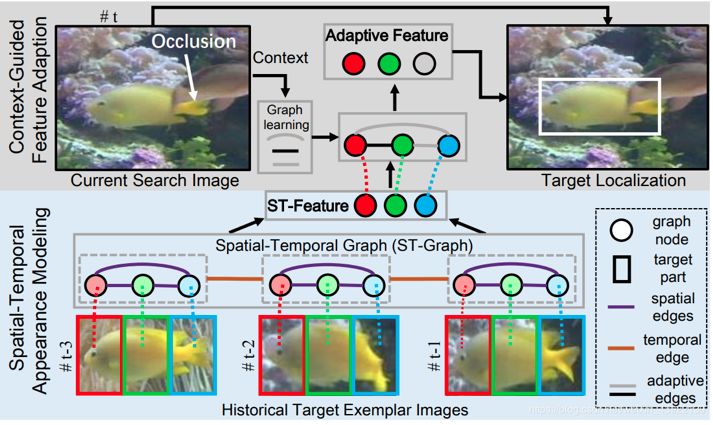

该方法共分为两个部分:时空外观建模及语境(context)引导下的特征自适应学习。前者负责将历史目标范例图像转换成ST-graph,其中每个目标的一部分分别对应红绿蓝三点,利用这种方法,生成用于表示目标对象的ST-Feature;后者负责搜索当前图像并提供有用的前景/背景信息,帮助图形学习以适应特性。在上图中,红色和绿色部分相较于蓝色部分更为重要,因为蓝色部分在当前图像中被遮掩掉了。正是利用这种自适应特征,该方法才实现了更具鲁棒的目标定位。

Siamese 网络追踪

论文提出的一种基于siamese框架的端到端图卷积跟踪(GCT)方法,该方法可以同时考虑历史帧的时间、空间目标外观结合和当前搜索图像的语境信息。

结构化目标外观建模

如下图所示,为了对目标外观建模,该方法构建了一个时空图谱以形成历史目标范例的结构化表示。利用同一时空GCN(ST-GCN)学习该图中的鲁棒目标外观模型,生成时空特征(ST-Feature)。

基于语境信息的目标定位

为了将当前搜索图像的语境信息整合到目标定位中,该方法提出了一种基于语境(context)信息的目标定位方法。通过将ST-Feature和当前图像前后语境想结合,生成自适应图像。然后通过前后预警GCN(CT-GCN)对该图进行操作,生成目标定位的自适应特征。

方法验证

为了验证方法的有效性和效率,作者团队在5个较为流行的跟踪基准上对该方法进行了验证。

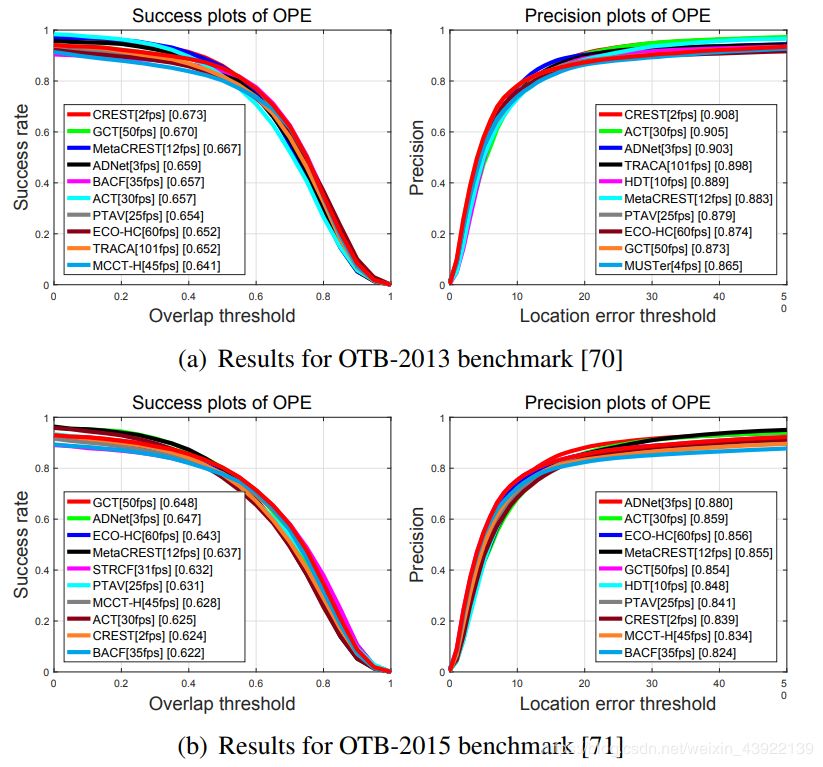

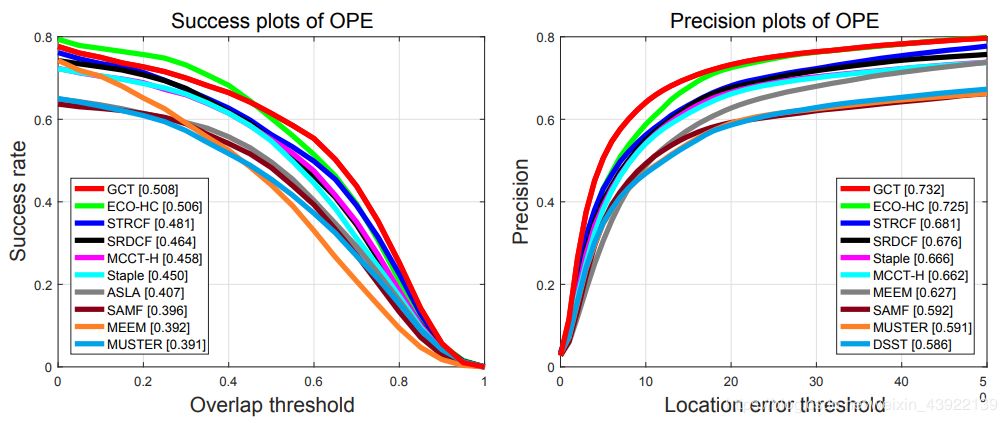

OTB2013、2015数据集的测试结果:

在OTB数据集测试中,论文GCT方法对比最先进的追踪方法,GCT表现良好。

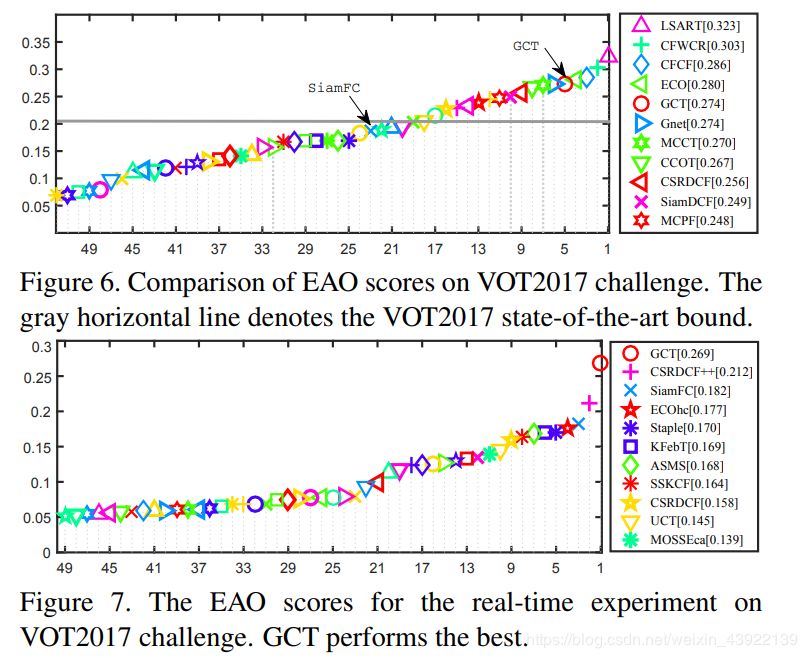

EAO对比:

在VOT2017实时实验EAO评分中,GCT表现最好。

UAV123基准测试:

在UAV123基准测试中,论文提出的GCT方法性能良好。

结论

本论文提出了一种新的图卷积追踪框架,该框架能够再统一的框架下联合实现目标的时空外观建模和语境(context)感知自适应学习,进而实现目标的鲁棒定位。上述测试结果表明,通过对GCN的时空和前后语境设计,本论文提出GCT方法再精度和速度上都到了新的一个阶段,相信在未来这种方法将在多目标追踪和行人识别等多个领域落地应用。

-End-

*延伸阅读

添加极市小助手微信(ID : cv-mart),备注:研究方向-姓名-学校/公司-城市(如:目标检测-小极-北大-深圳),即可申请加入目标检测、目标跟踪、人脸、工业检测、医学影像、三维&SLAM、图像分割等极市技术交流群,更有每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流,一起来让思想之光照的更远吧~

△长按添加极市小助手

△长按关注极市平台

觉得有用麻烦给个在看啦~