ACL 开幕首日:评审制度改革,主题报告探讨 NLP 未来方向

作者 | 蒋宝尚、青暮

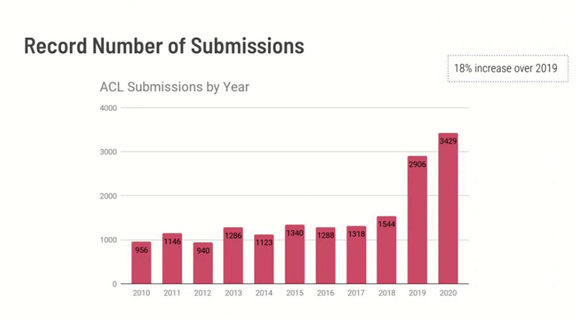

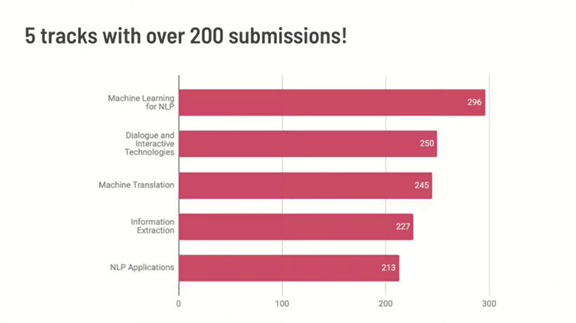

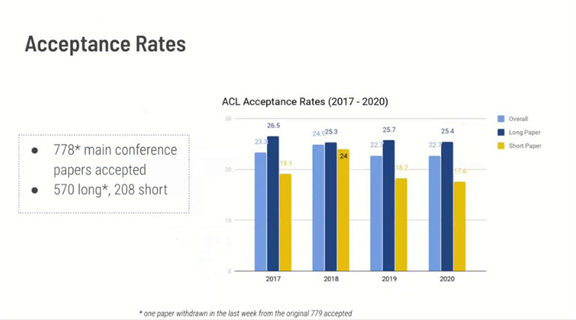

ACL论文情况:投稿创历史新高

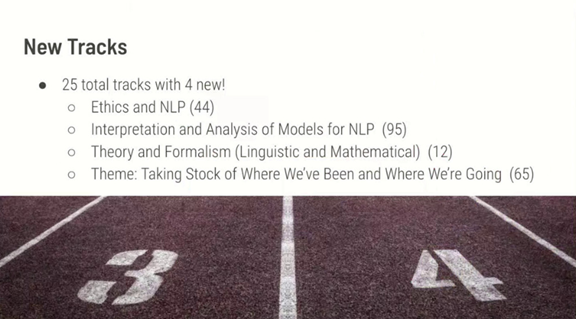

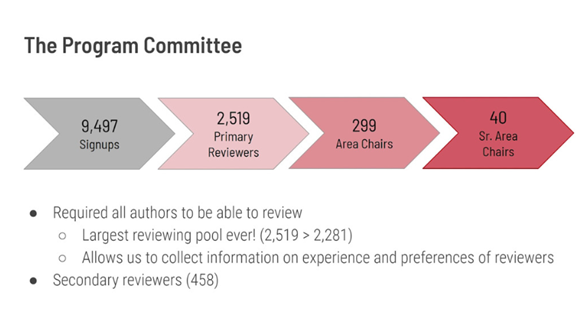

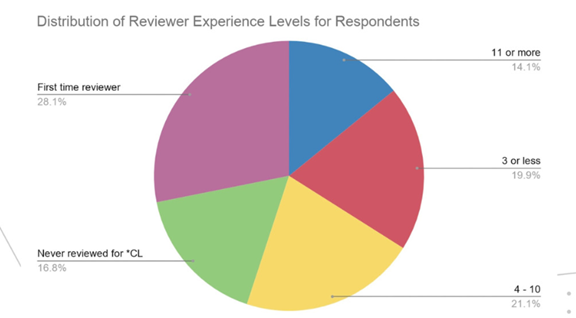

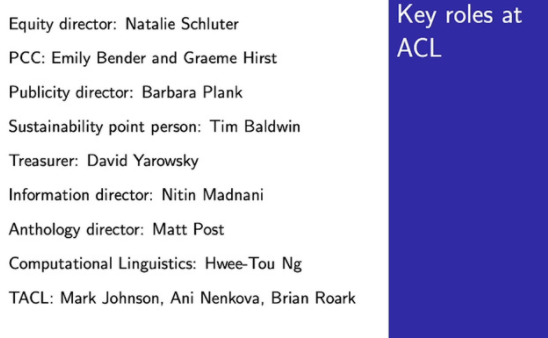

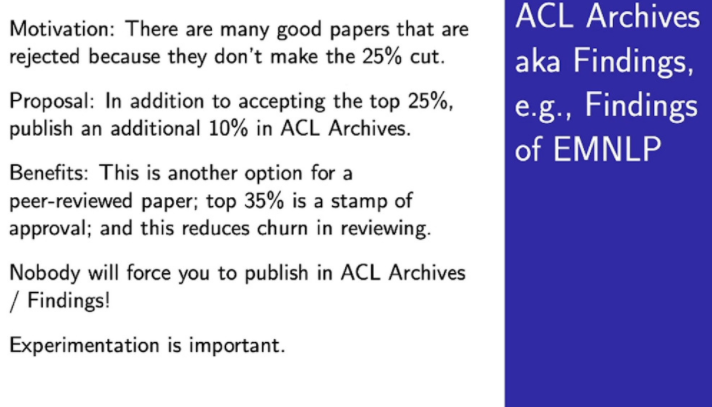

主席演讲:评审制度改革

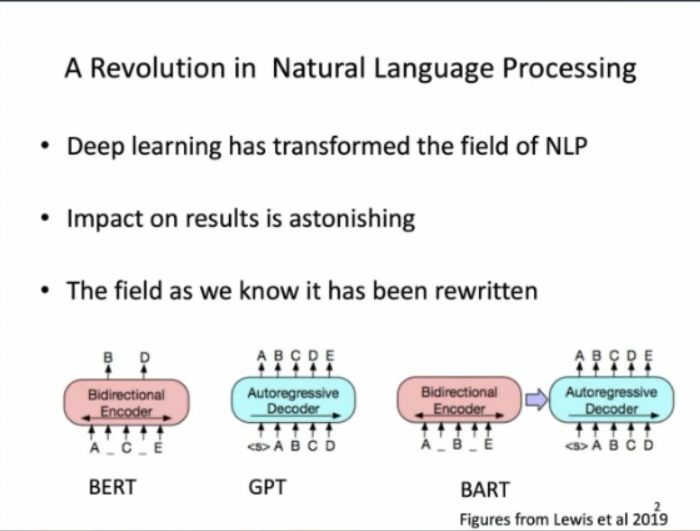

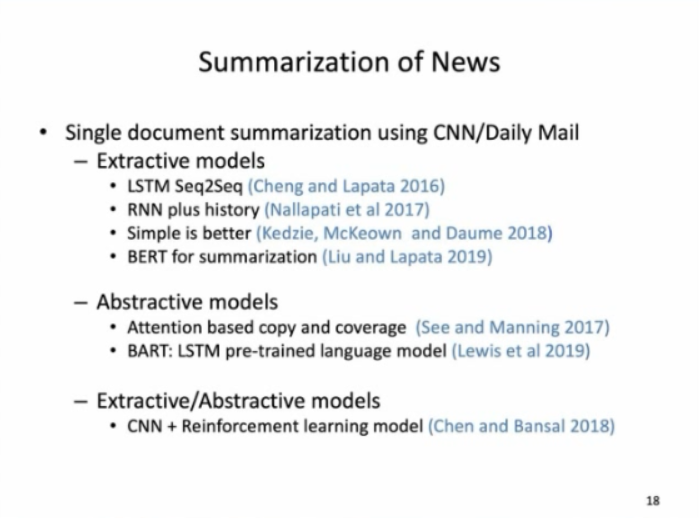

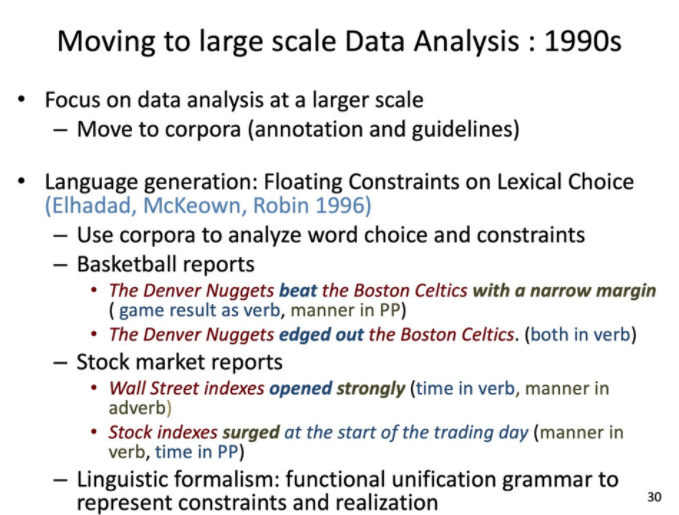

主题报告:Rewriting the Past

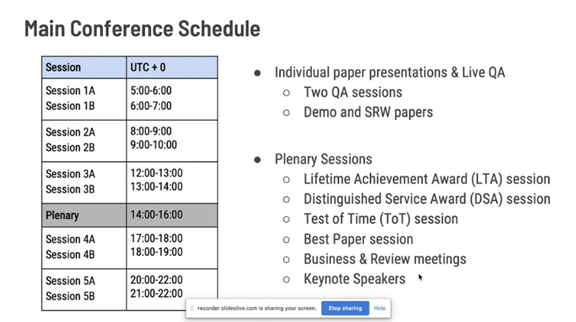

ACL 2020原定于2020年7月5日至10日在美国华盛顿西雅图举行,因新冠肺炎疫情改为线上会议。为促进学术交流,方便国内师生提早了解自然语言处理(NLP)前沿研究,AI 科技评论将推出「ACL 实验室系列论文解读」内容,同时欢迎更多实验室参与分享,敬请期待!

![]()

点击"阅读原文",直达“ACL 交流小组”了解更多会议信息。

登录查看更多

相关内容

专知会员服务

33+阅读 · 2019年10月23日

Arxiv

3+阅读 · 2019年6月26日

Arxiv

4+阅读 · 2018年4月13日