ACL 2022 | 序列标注的小样本NER:融合标签语义的双塔BERT模型

©作者 | SinGaln

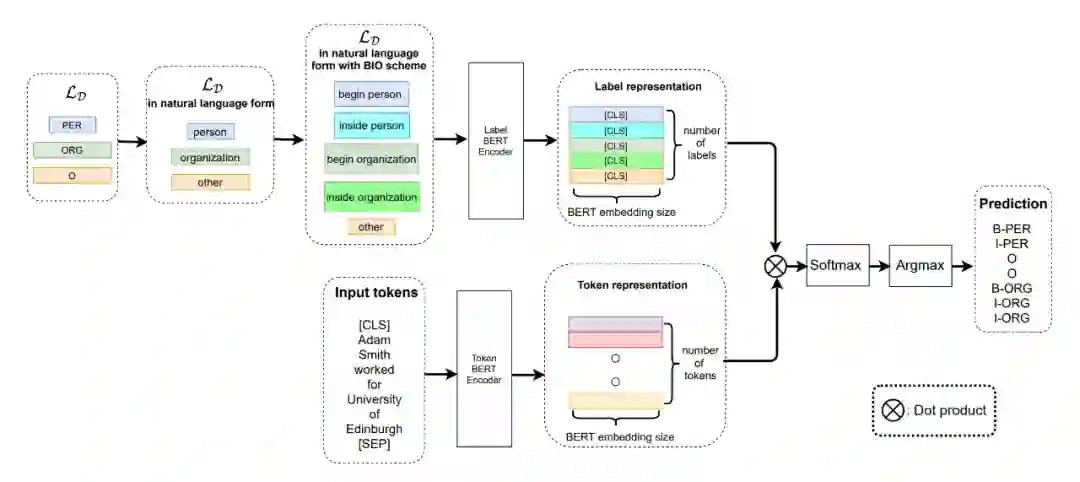

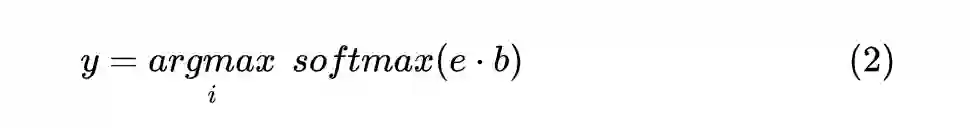

这是一篇来自于 ACL 2022 的文章,总体思想就是在 meta-learning 的基础上,采用双塔 BERT 模型分别来对文本字符和对应的label进行编码,并且将二者进行 Dot Product(点乘)得到的输出做一个分类的事情。文章总体也不复杂,涉及到的公式也很少,比较容易理解作者的思路。对于采用序列标注的方式做 NER 是个不错的思路。

论文标题:

Label Semantics for Few Shot Named Entity Recognition

https://arxiv.org/pdf/2203.08985.pdf

模型

1.1 架构

▲图1.模型整体构架

1.2 Detail

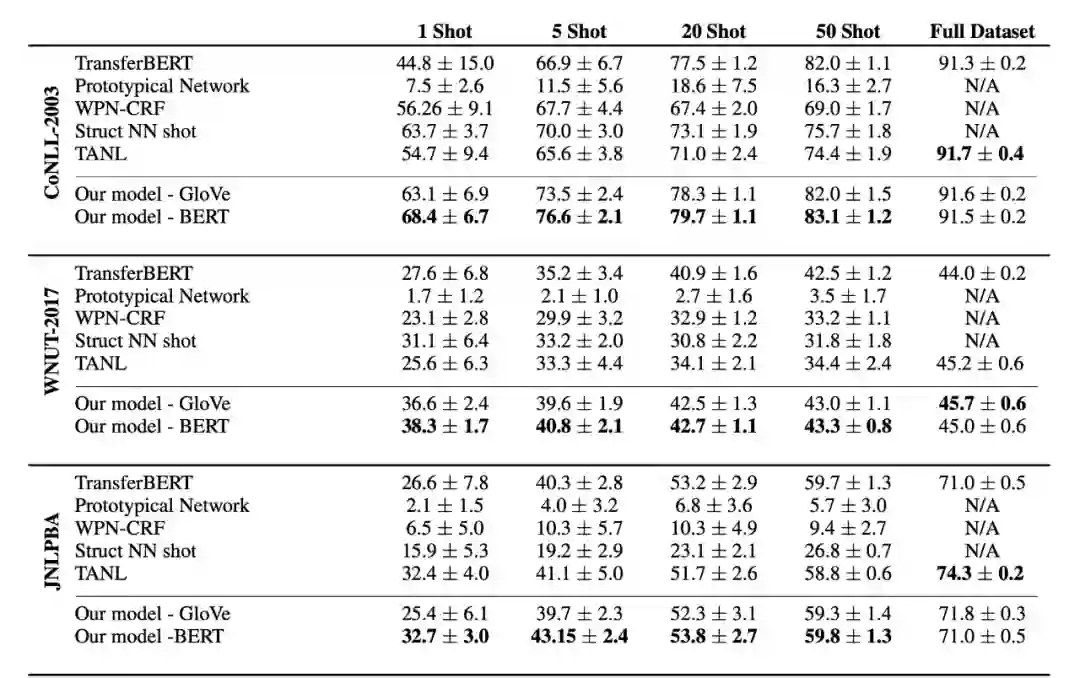

1.3 Label Transfer

▲图2. 实验数据集Label Transfer

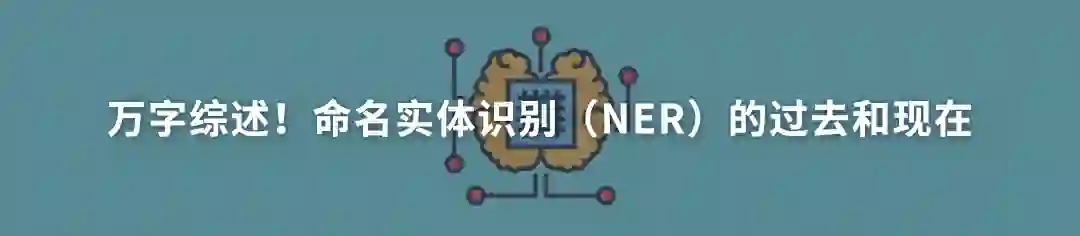

1.4 Support Set Sampling Algorithm

采样伪代码如下所示:

▲图3. 采样伪代码

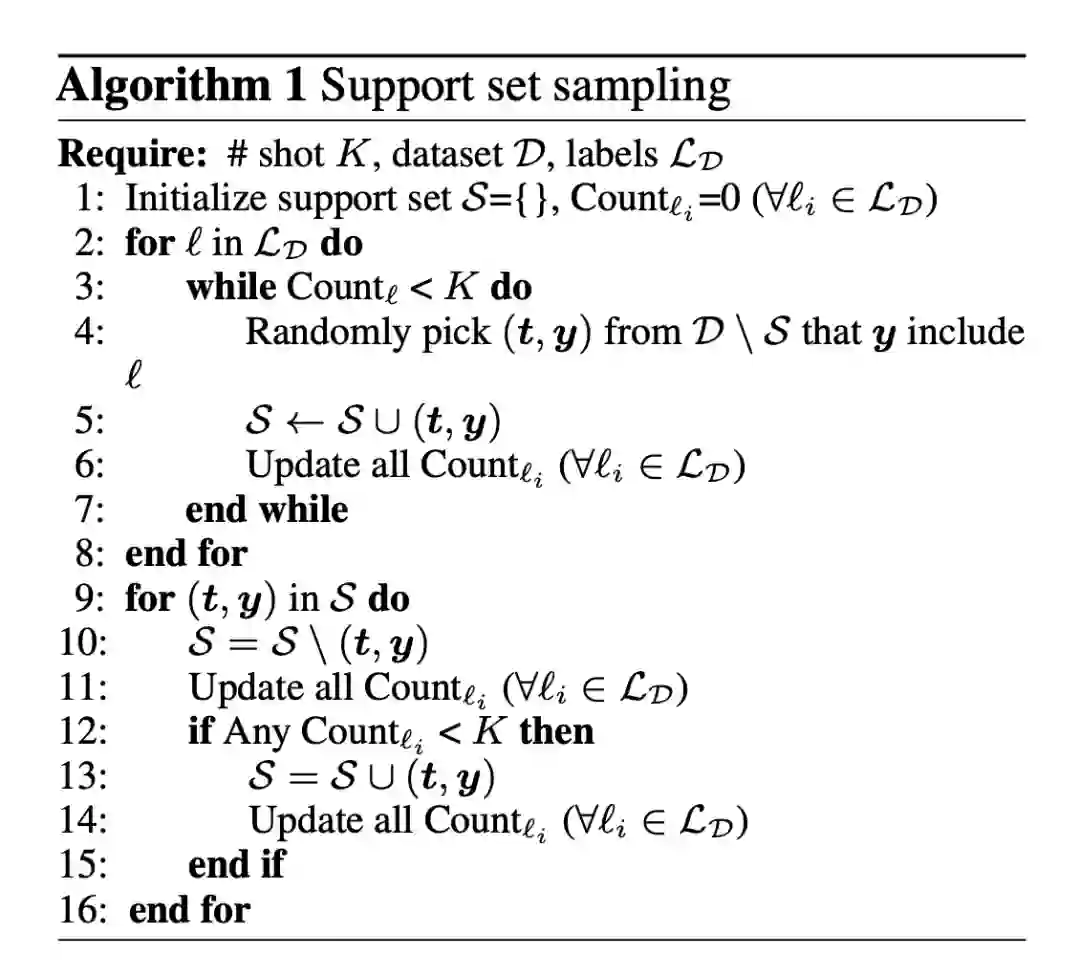

实验结果

▲图4. 部分实验结果

#!/usr/bin/env python

# -*- coding:utf-8 -*-

# @Time : 2022/5/23 13:49

# @Author : SinGaln

import torch

import torch.nn as nn

from transformers import BertModel, BertPreTrainedModel

class SinusoidalPositionEmbedding(nn.Module):

"""定义Sin-Cos位置Embedding

"""

def __init__(

self, output_dim, merge_mode='add'):

super(SinusoidalPositionEmbedding, self).__init__()

self.output_dim = output_dim

self.merge_mode = merge_mode

def forward(self, inputs):

input_shape = inputs.shape

batch_size, seq_len = input_shape[0], input_shape[1]

position_ids = torch.arange(seq_len, dtype=torch.float)[None]

indices = torch.arange(self.output_dim // 2, dtype=torch.float)

indices = torch.pow(10000.0, -2 * indices / self.output_dim)

embeddings = torch.einsum('bn,d->bnd', position_ids, indices)

embeddings = torch.stack([torch.sin(embeddings), torch.cos(embeddings)], dim=-1)

embeddings = embeddings.repeat((batch_size, *([1] * len(embeddings.shape))))

embeddings = torch.reshape(embeddings, (batch_size, seq_len, self.output_dim))

if self.merge_mode == 'add':

return inputs + embeddings.to(inputs.device)

elif self.merge_mode == 'mul':

return inputs * (embeddings + 1.0).to(inputs.device)

elif self.merge_mode == 'zero':

return embeddings.to(inputs.device)

class DoubleTownNER(BertPreTrainedModel):

def __init__(self, config, num_labels, position=False):

super(DoubleTownNER, self).__init__(config)

self.position = position

self.num_labels = num_labels

self.bert = BertModel(config=config)

self.fc = nn.Linear(config.hidden_size, self.num_labels)

if self.position:

self.sinposembed = SinusoidalPositionEmbedding(config.hidden_size, "add")

def forward(self, sequence_input_ids, sequence_attention_mask, sequence_token_type_ids, label_input_ids,

label_attention_mask, label_token_type_ids):

# 获取文本和标签的encode

# [batch_size, sequence_length, embed_dim]

sequence_outputs = self.bert(input_ids=sequence_input_ids, attention_mask=sequence_attention_mask,

token_type_ids=sequence_token_type_ids).last_hidden_state

# [batch_size, embed_dim]

label_outputs = self.bert(input_ids=label_input_ids, attention_mask=label_attention_mask,

token_type_ids=label_token_type_ids).pooler_output

label_outputs = label_outputs.unsqueeze(1)

# 位置向量

if self.position:

sequence_outputs = self.sinposembed(sequence_outputs)

# Dot 交互

interactive_output = sequence_outputs * label_outputs

# full-connection

outputs = self.fc(interactive_output)

return outputs

if __name__=="__main__":

pretrain_path = "../bert_model"

from transformers import BertConfig

token_input_ids = torch.randint(1, 100, (32, 128))

token_attention_mask = torch.ones_like(token_input_ids)

token_token_type_ids = torch.zeros_like(token_input_ids)

label_input_ids = torch.randint(1, 10, (1, 10))

label_attention_mask = torch.ones_like(label_input_ids)

label_token_type_ids = torch.zeros_like(label_input_ids)

config = BertConfig.from_pretrained(pretrain_path)

model = DoubleTownNER.from_pretrained(pretrain_path, config=config, num_labels=10, position=True)

outs = model(sequence_input_ids=token_input_ids, sequence_attention_mask=token_attention_mask, sequence_token_type_ids=token_token_type_ids, label_input_ids=label_input_ids,

label_attention_mask=label_attention_mask, label_token_type_ids=label_token_type_ids)

print(outs, outs.size())

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧