自导自演皮克斯动画不再是梦,这个工具实现了高分辨率、高度可控的真人视频转动画

机器之心报道

这个框架能将人物视频转成动画,还是高清、高度可控的。

在社交网络、短视频平台上使用卡通头像录制视频是很多人喜欢的玩法,但我们也会发现一些问题,比如头像调整范围比较窄,和本人没有那么像等。

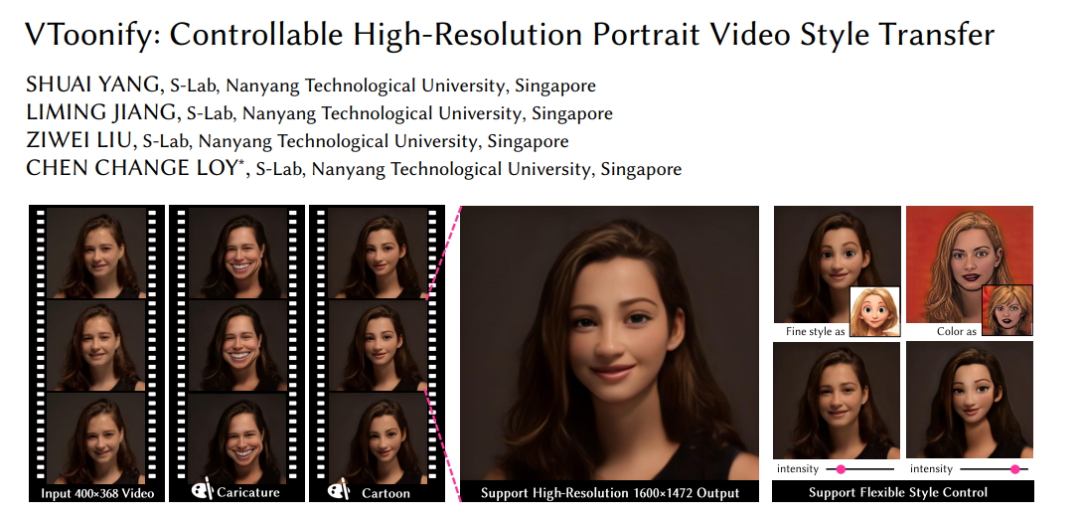

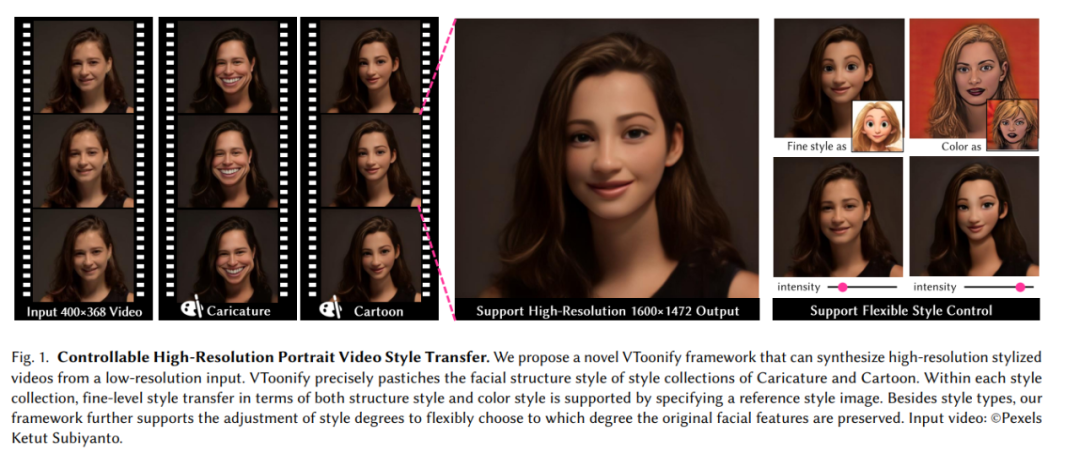

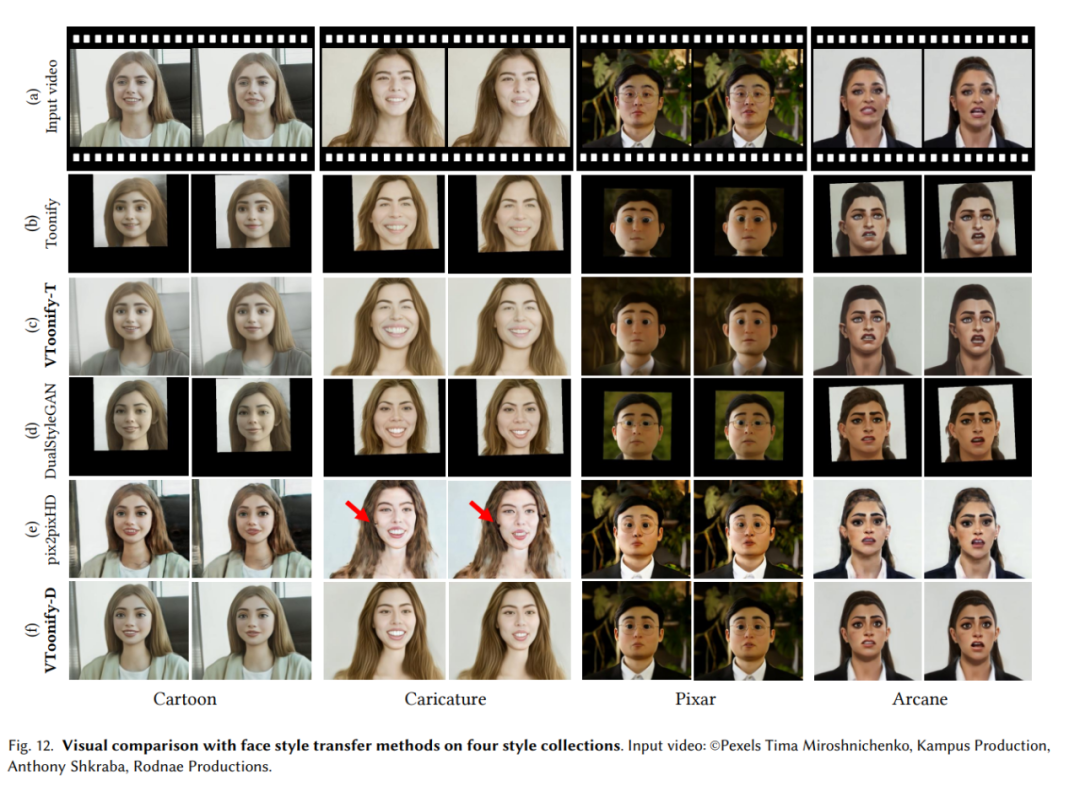

近日,来自新加坡南洋理工大学的一项相关研究在 reddit、推特上都收获了上千的点赞量。他们开发了一个能够进行可控高分辨率人像视频风格转换的框架——VToonify,在风格控制的灵活性、生成视频的质量、时间上的连贯性等方面都有着出色的表现。

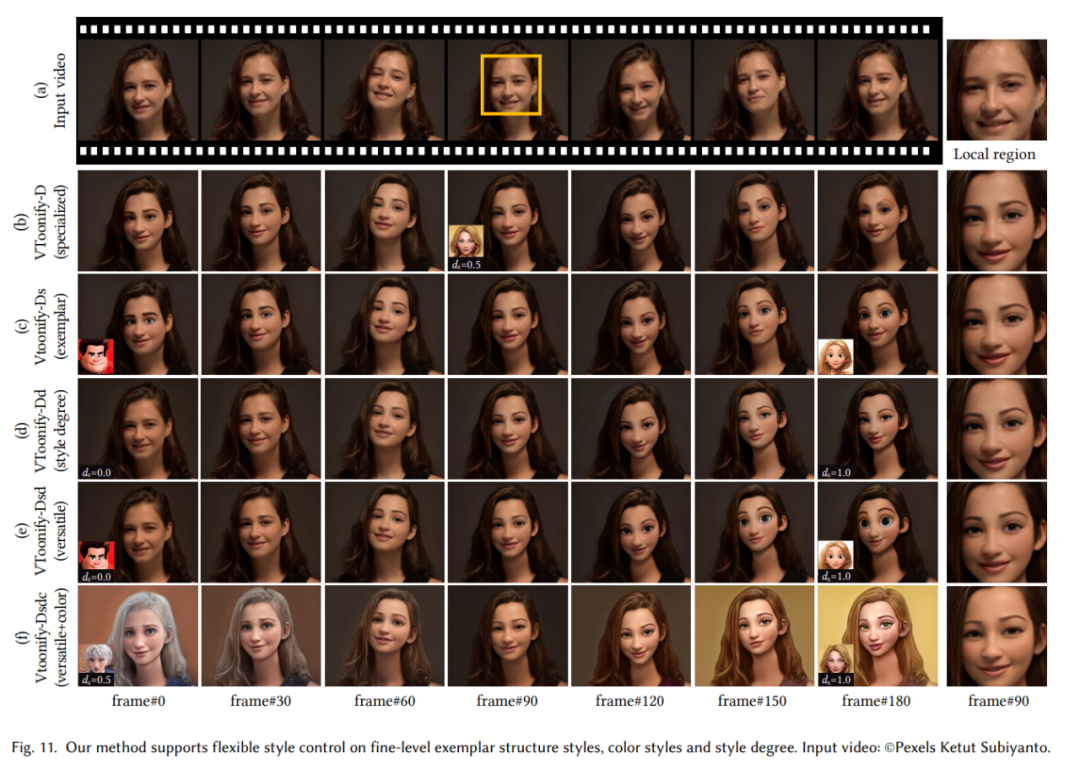

你可以根据自己的需要灵活调整生成的风格类型以及卡通化的程度等指标:

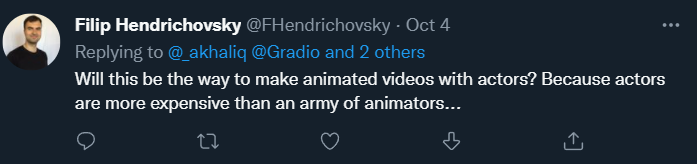

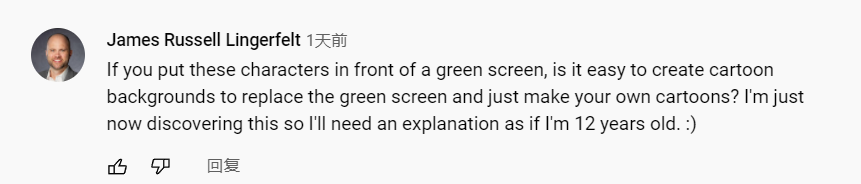

从 demo 中可以看出,VToonify 生成的这些人像不仅具有高度可调的卡通风格,而且包含了人像的很多细节,有一种千人千面的感觉。因此,不少网友表示,有了这个工具,动画电影做起来岂不是很容易?

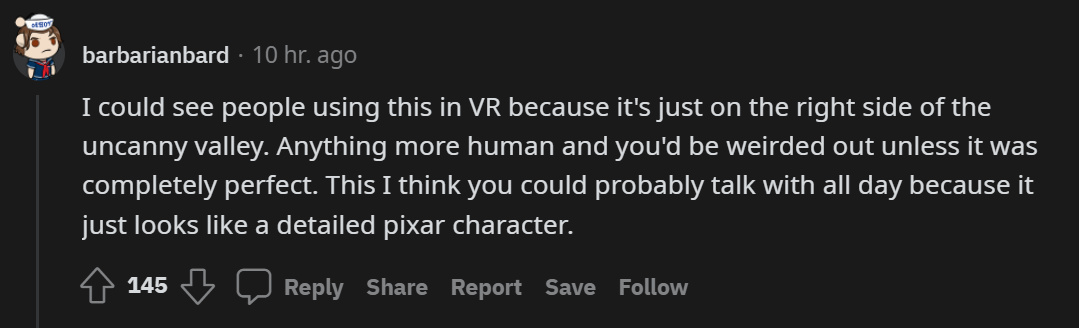

还有人畅想将其应用到 VR 领域。

当被问及能否当实时滤镜用时,作者表示:目前模型还很大,做到实时还需要一些工程努力。

以下是完整的 demo 视频:

论文概览

论文链接:https://arxiv.org/pdf/2209.11224.pdf

项目链接: https://github.com/williamyang1991/VToonify

demo 链接: https://huggingface.co/spaces/PKUWilliamYang/VToonify

colab 链接:https://colab.research.google.com/github/williamyang1991/VToonify/blob/master/notebooks/inference_playground.ipynb

生成高质量的艺术人像视频是计算机图形学和计算机视觉中的一个重要任务。虽然基于强大的 StyleGAN,研究者们已经提出了一系列成功的人像卡通模型,但这些面向图像的方法在应用于视频时存在明显的局限性,如固定帧大小、人脸对齐要求、缺少非面部细节和时间不一致等。

也就是说,一个高效的视频卡通化方法需要克服以下挑战:

能够处理未对齐的人脸和不同的视频大小,以保持运动自然。增大视频尺寸或使用广角可以捕捉更多的信息,防止人脸移动出帧;

为了匹配目前广泛使用的高清设备,生成的视频要有足够高的分辨率;

要想构建一个实用的用户交互系统,新方法应该提供灵活的风格控制,让用户调整并选择自己喜欢的风格。

为了满足以上需求,研究者们提出了专门用于视频卡通化的混合框架——VToonify。

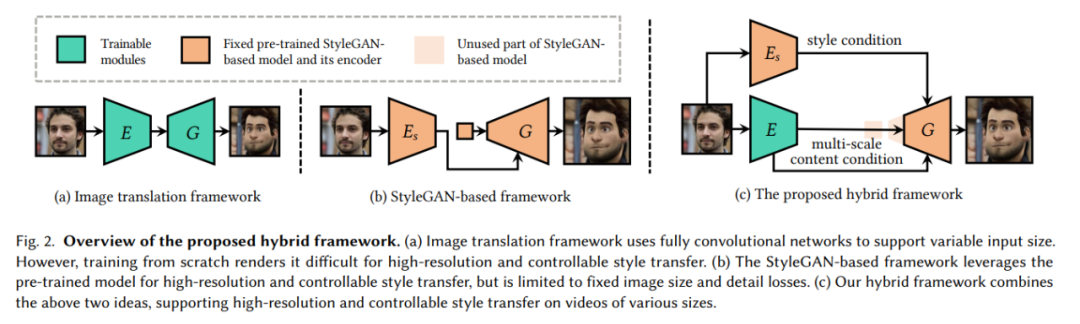

具体来说,他们首先分析了 StyleGAN 的平移同变性,这是克服「固定帧大小」局限性的关键。如下图 2(c)所示,VToonify 结合了基于 StyleGAN 的框架和图像转换框架的优点,实现了可控的高分辨率人像视频风格转换。

他们采用[Pinkney and Adler 2020] 的 StyleGAN 架构进行高分辨率的视频风格转换,但通过删除固定大小的输入特征和低分辨率层来调整 StyleGAN,构建了一个全新的全卷积编码器 - 生成器架构,类似于图像转换框架中的架构,支持不同的视频大小。

除了原始的高级风格代码外,他们还训练编码器提取输入帧的多尺度内容特征作为生成器的附加内容条件,以便在风格转换过程中更好地保存帧的关键视觉信息。

他们遵循 [Chen et al. 2019; Viazovetskyi et al. 2020] 的做法,在合成的配对数据上蒸馏 StyleGAN。

此外,他们还进一步提出了基于单一合成数据模拟相机运动的闪烁抑制损失来消除闪烁。

因此,VToonify 无需真实数据、复杂的视频合成和显式的光流计算,就可以学习快速连贯的视频转换。

不同于 [Chen et al. 2019; Viazovetskyi et al. 2020] 中标准的图像转换框架,VToonify 将 StyleGAN 模型合并到生成器中,以蒸馏数据和模型。因此,VToonify 继承了 StyleGAN 的风格调整灵活性。通过重用 StyleGAN 作为生成器,研究者只需要训练编码器,大大减少了训练时间和训练难度。

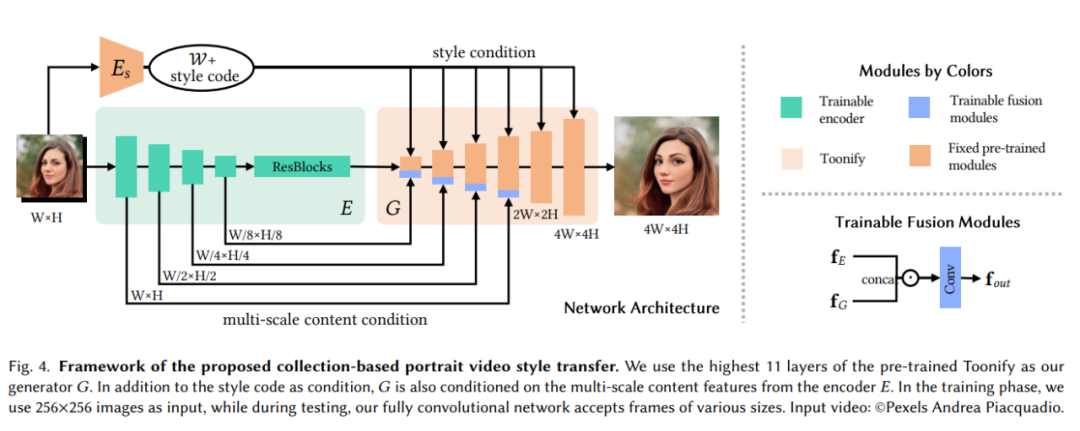

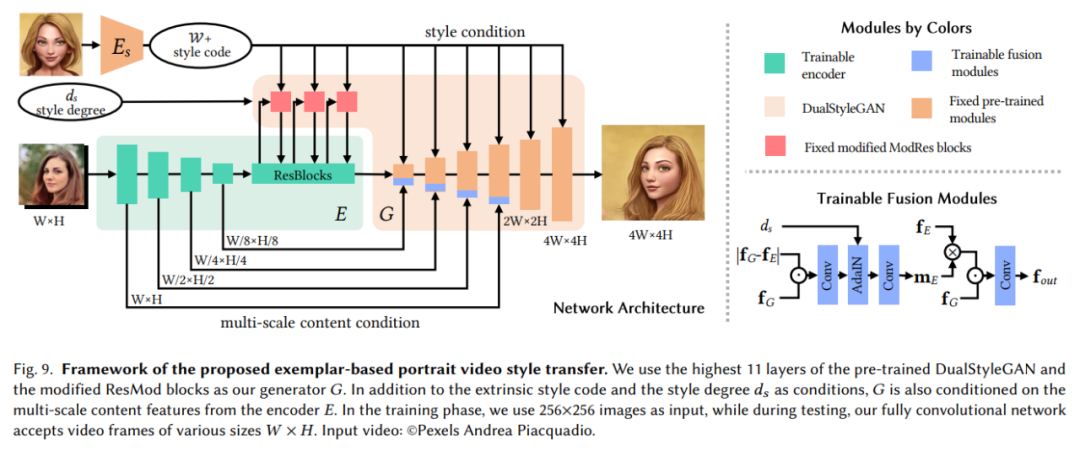

根据上述做法,研究者提出了基于两个代表性 StyleGAN 主干——Toonify [Pinkney and Adler 2020] 和 DualStyleGAN [Yang et al. 2022]——的两种 VToonify 变体,分别用于 collection-based 和 exemplar-based 的人像视频卡通化。

前者根据数据集的整体风格对人脸进行风格化,而后者则使用数据集中的一张图像来指定更精细的风格,如图 1 的右上角所示。

研究者通过采用 DualStyleGAN 的风格控制模块 [Yang et al. 2022] 来调整编码器的特征,并精心设计数据生成和训练目标。VToonify 继承了 DualStyleGAN 灵活的风格控制和风格程度的调整,并进一步将这些功能扩展到视频(如图 1 右上角所示)

collection-based 人像视频风格转换

在 collection-based 人像视频风格转换中,研究者利用具有代表性的 Toonify 作为主干,它使用原始的 StyleGAN 架构,并仅以风格代码为条件。

如图 4 所示,collection-based VToonify 框架包含构建在 Toonify 之上的编码器𝐸和生成器𝐺。𝐸接受视频帧并生成内容特征,然后将这些特征输入𝐺以生成最终的风格化人像。与现有的使用整个 StyleGAN 架构的基于 StyleGAN 的框架不同,他们只使用最高级的 11 层 StyleGAN 来构建𝐺。正如 [Karras et al. 2019] 中所分析的,StyleGAN 的低分辨率层和高分辨率层分别主要捕获与结构相关的风格和颜色 / 纹理风格。因此,𝐺的主要任务是对内容特征进行上采样,并为它们渲染风格化的颜色和纹理。

exemplar-based 人像视频风格转换

在 exemplar-based 人像视频风格转换中,研究者使用 DualStyleGAN 作为主干,它向 StyleGAN 添加了一个外部风格路径,并以内部风格代码、外部风格代码和风格程度为条件。内部风格代码描述了人脸的特征,外部风格代码描述了艺术人像外部的结构和色彩风格。结构风格度𝑑_𝑠和颜色风格度𝑑_𝑐决定了所应用风格的强度。

exemplar-based 框架和上面提到的 collection-based 框架有很多共同之处,它通过两方面修改来实现灵活的风格控制,一是借助 Modified ModRe 实现结构风格控制,二是添加了 Style-Degree-Aware 融合模块。完整架构如图 9 所示。

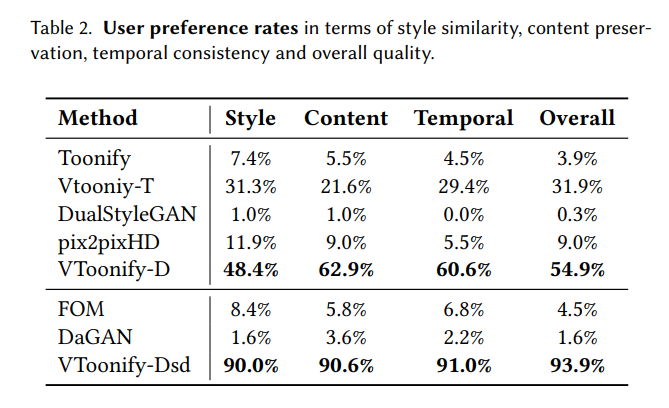

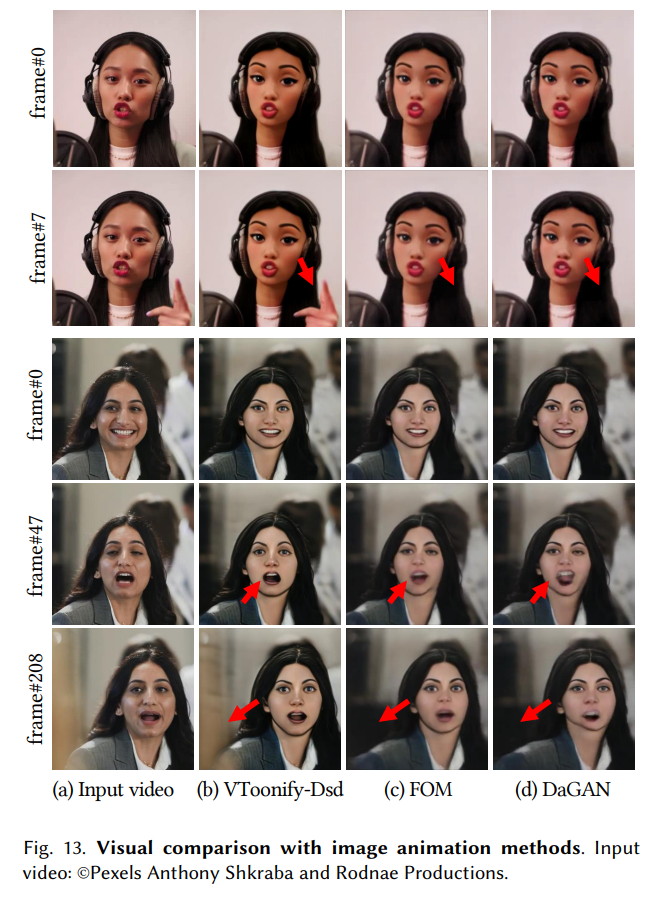

实验结果

实验结果表明,VToonify 生成的风格化帧不仅与主干帧一样质量高,而且更好地保留了输入帧的细节。

更多细节请参见原论文。

2023 AI 应届生,准备好冲刺更满意的offer了吗?

交流高效——设置报告、对谈、自由交流、晚宴等环节,不仅可以聆听业界前辈学术研究指导与建议,还可以与专家学者面对面自由深入交流。

量身打造——提供有行业竞争力的薪酬和优先落户等硬核福利,以及广阔的发展空间。

参与便捷——视报名同学学校分布情况提供定点接驳车,获取接驳时间、地址与更多活动详情请添加小助手微信号REDtech01。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com