慕尼黑大学LMU博士论文「自然语言文本神经网络信息提取」240页pdf

-

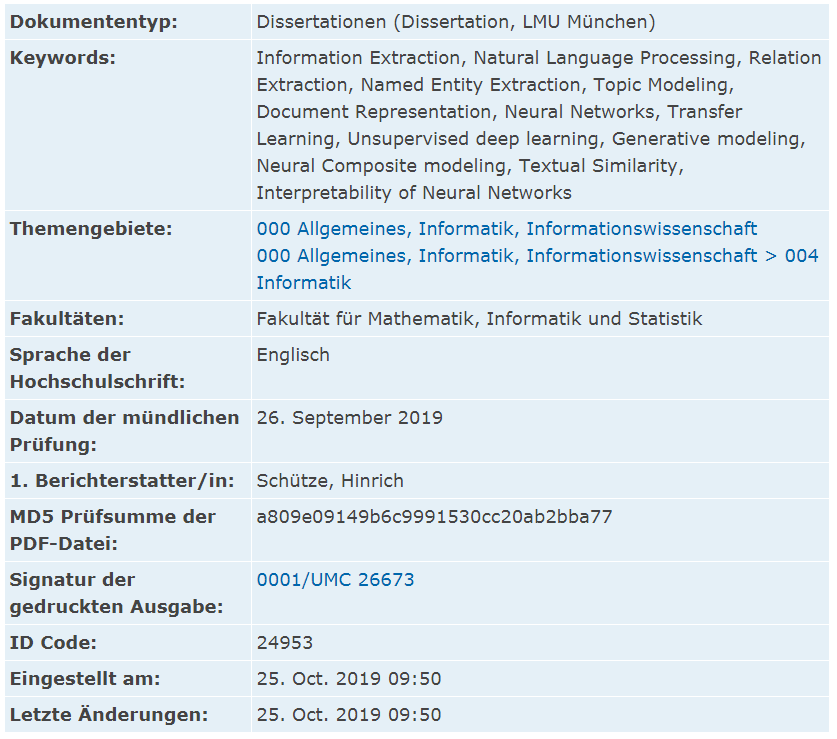

神经关系提取 :首先,我们提出了一种新的基于递归神经网络的table-filling体系结构,以便在句子中联合执行实体和关系提取。然后,我们进一步扩展了跨句子边界实体之间关系的提取范围,并提出了一种新的基于依赖关系的神经网络体系结构。这两个贡献在于机器学习的监督范式。此外,我们还在构建一个受缺乏标记数据约束的鲁棒关系提取器方面做出了贡献,其中我们提出了一种新的弱监督引导技术。考虑到这些贡献,我们进一步探索了递归神经网络的可解释性,以解释它们对关系提取的预测。 -

神经主题建模 :除了有监督神经体系结构外,我们还开发了无监督神经模型,以学习主题建模框架中有意义的文档表示。首先,我们提出了一种新的动态主题模型,它捕获了随着时间的推移的主题。接下来,我们在不考虑时间依赖性的情况下建立了静态主题模型,其中我们提出了神经主题建模体系结构,这些体系结构也利用外部知识,即Word嵌入来解决数据稀疏性。此外,我们还开发了神经主题模型,其中包含了使用单词嵌入和来自许多来源的潜在主题的知识迁移。最后,我们通过引入语言结构(如语序、局部句法和语义信息等)来改进神经主题建模。它处理传统主题模型中的词袋问题。本节中提出的神经NLP模型是基于PGMs、深度学习和ANN交叉技术。

-

后台回复“LNLP” 就可以获取《Neural information extraction from natural language text. Dissertation》相关资源专知下载链接索引

登录查看更多