EMNLP2018 | 基于短语和神经网络的无监督机器翻译系统

机器翻译系统在某些语言上实现了接近人类的能力,但他的性能依赖大量的平行双语语料,这降低了机器翻译的适用性。本研究探讨了如何在只有大规模单语种语料库的情况下进行机器翻译。本文提出了两个模型,一个基于神经网络和一个基于短语的模型。两个模型都使用了精心设计的参数初始化、语言模型的降噪和基于迭代反向翻译的并行预料生成。这些模型优于引用文献中的方法,而且更简单、具有更少的超参数。在广泛使用的WMT'14 English - French 和WMT'16German - English 基准测试中,分别获得了28.1 和25.2 BLEU 点(在不使用平行语料的情况下),比当前最好的方法高出了11 个BLEU 点。在资源较少的语言如English-Urdu 和 English-Romanian 中,甚至比利用短缺的bitexts 的半监督和监督方法要好。

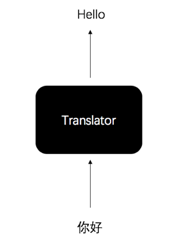

无监督的机器翻译,可以拆分成以下几步:

> 初始化翻译模型参数:

在没有平行语料的情况下,可以设计方法对模型进行预训练。例如:利用字对字的翻译字典,先进行单字对单字的翻译训练。虽然这种方式在语言和语料库不是高度相关,模型表现很差,但还是可以保留些原始的语言意义。

>> 训练语言模型:

拥有大量单语语料后,我们可以在这批单语语料上,训练语言模型,并把参数用在翻译模型上。

>>> 迭代反向翻译:

利用现有的模型,翻译单语语料,再将获得的结果,反向翻译并训练模型。

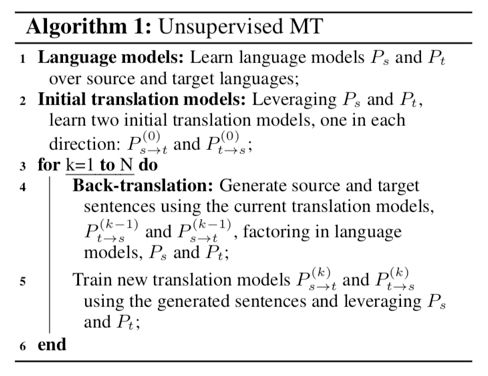

以下是无监督机器翻译的算法:

下面两个小节,我们会详细描述无监督神经网络和短语模型机器翻译的细节。

> 初始化翻译模型参数:

不同于使用字对字翻译的初始化,本节采用字节对编码(Byte-pair encoding)的方式,对字节对进行翻译。这带来两个好处,第一,可以大幅减少字典大小,第二,这项工作的字节对编码方式,是当翻译的双语语料都拥有相同的字节对时,才进行编码,这可以帮助模型,理解双语间的意涵。

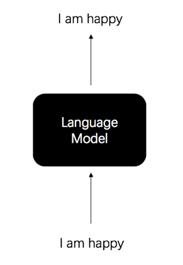

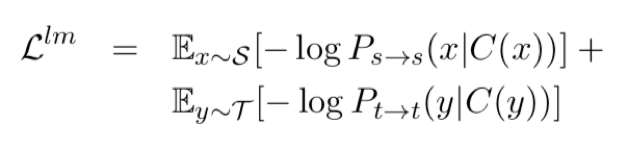

>> 训练语言模型:

利用以下的目标函示,训练语言模型(细节可以参考论文):

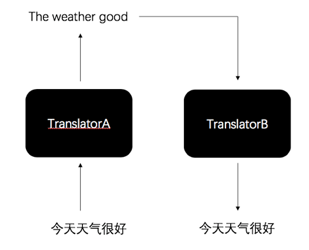

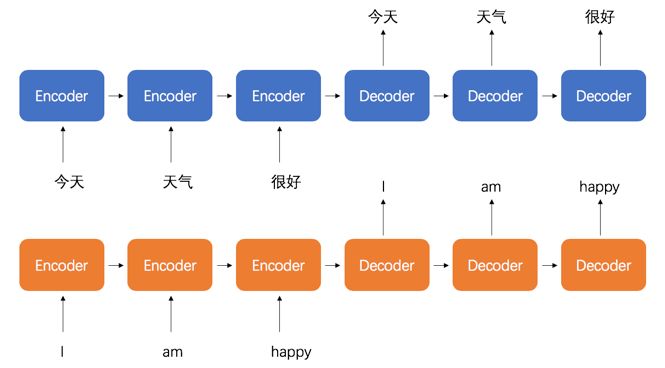

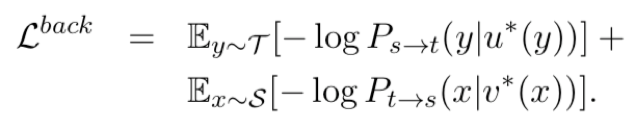

>>> 迭代反向训练:

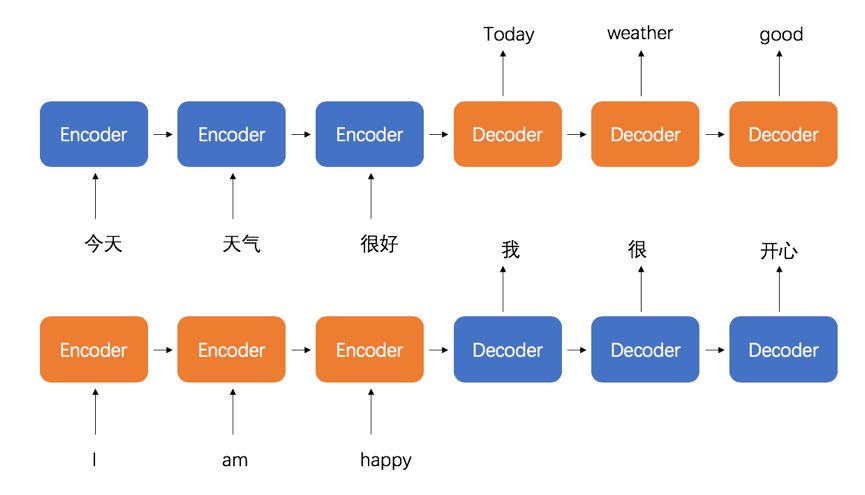

假设我们今天试图训练从中文到英文的翻译模型,我们可以利用上面两个步骤,产生的模型,将中文的语料,先翻译成英文,制造假的目标语料,在利用英翻中的模型,将假的目标语料翻译回中文,并训练我们的英翻中模型,反之亦然。整题可以看成我们在优化以下的目标函式:

利用来回迭代的方式,翻译模型的参数会渐渐收敛。

在语料比较少的情况下,基于短语的机器翻译效果会比神经网络翻译还要好很多。

> 初始化翻译模型参数:

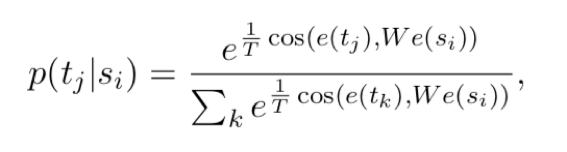

将每个字的字向量,利用以下的公式,预训练初始化参数:

>>语言模型:

学习KenLM的语言模型。也可以使用神经网络模型,但在语料库很小的情况下,使用n-gram的模型效果会好一些。

>>> 迭代反向翻译:

利用和神经网络机器翻译一样的方式,进行迭代反向翻译。

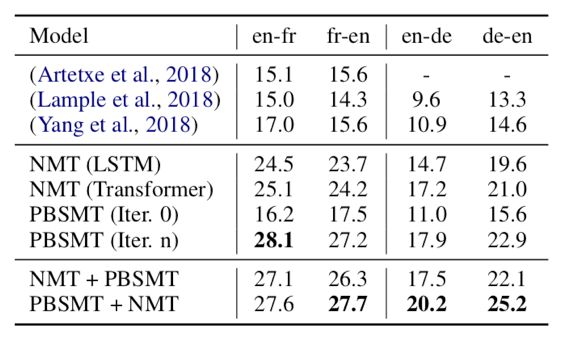

图表一

图表一,比较了本篇文章与以前无监督的翻译方法在英法翻译与英德翻译的效果。可以看到,神经网络模型与基于短语的模型均比过往的方法好上10个BLEU score。甚至,还没有进行迭代反向训练的短语模型,就已经比以前的方法好,可见语言模型在非监督式学习的巨大贡献。

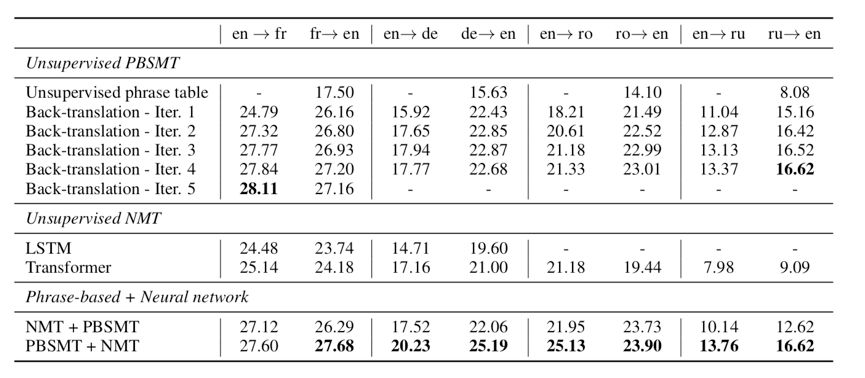

图表二

图表二,点出了迭代反向训练的好处。从表中可以得知,经过越多次的迭代,翻译模型的效果越好。另外,结合神经网络模型与基于短语的模型,可以达到更好的效果。

本篇文章提供了非常好的思路,让我们可以巧妙的应用无监督式学习在机器翻译上。在没有平行语料的情况下,如何好好的利用语言模型带给我们的资讯,是所有做自然语言处理的人,都绞尽脑汁在思考的议题。期待日后有更多有关无监督式学习的文章出现。

微信ID:WeChatAI

微信ID:WeChatAI