AI大牛李沐装机视频来了!你也能练100亿的大模型

新智元报道

新智元报道

【新智元导读】AI大牛李沐带你来装机!

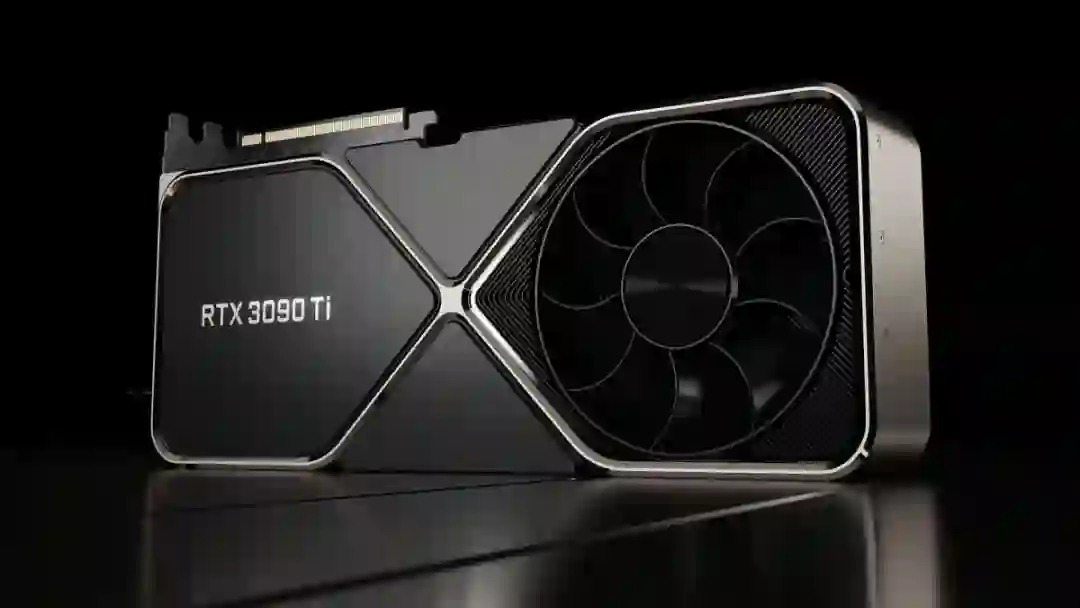

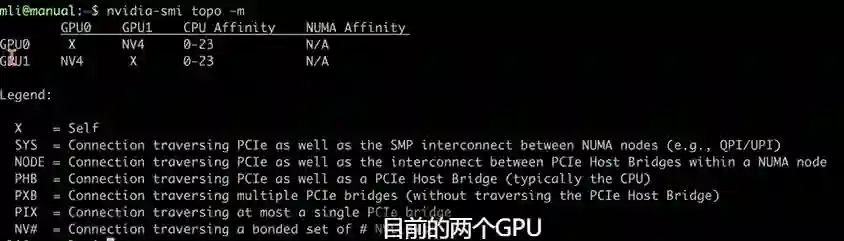

装机清单

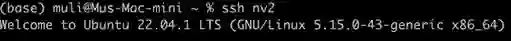

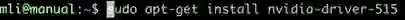

装机步骤

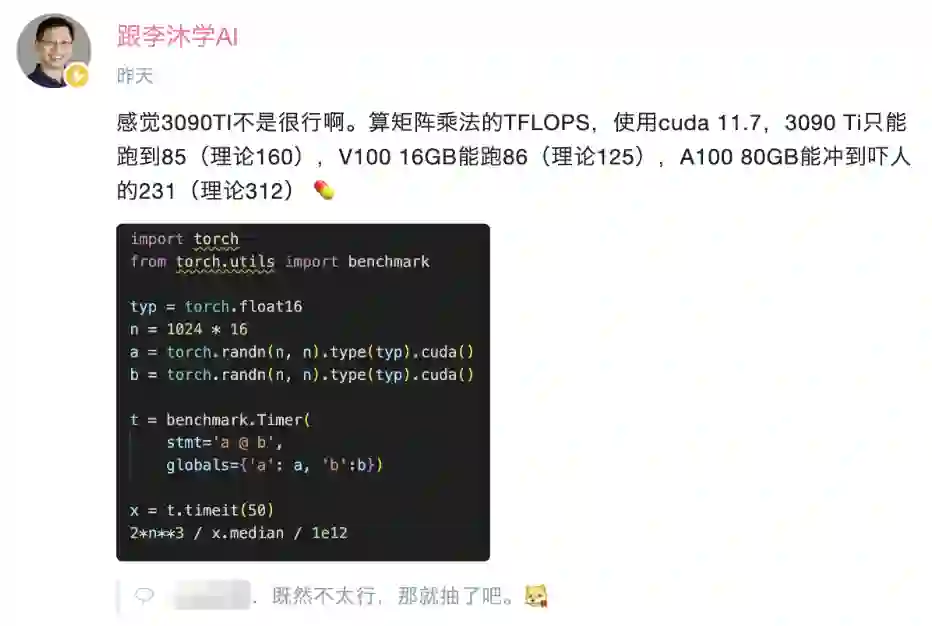

压力测试

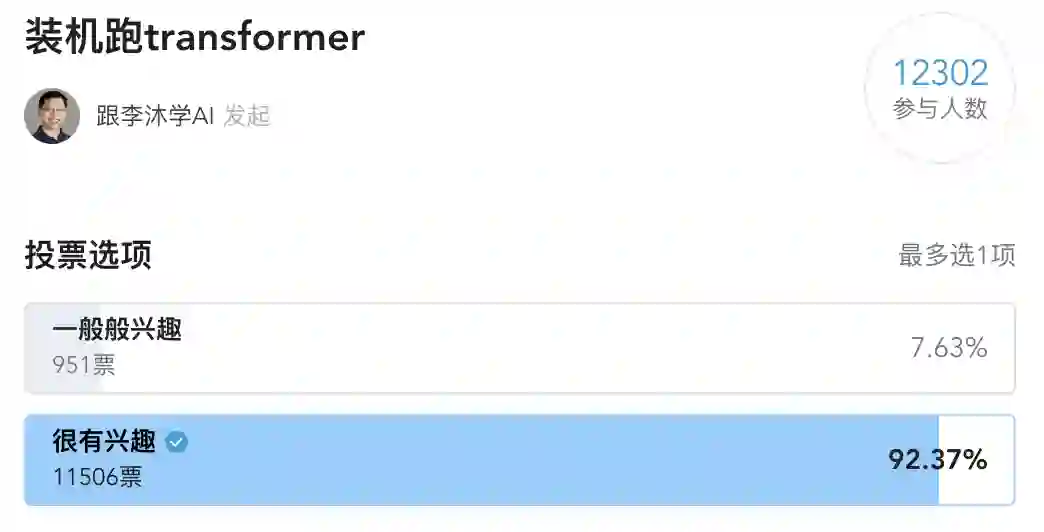

网友热评

登录查看更多