7 Papers & Radios | MIT学神开源微分太极;北大等提出没有乘法的神经网络

本周的重要论文有 MIT 学神胡渊鸣等开源的自动微分版太极以及北大、华为诺亚方舟实验室等主张以加法运算代替深度神经网络中的乘法运算。此外,机器之心联合由楚航、罗若天发起的 ArXiv Weekly Radiostation,在 7 Papers 的基础上,精选本周更多重要论文,包括 NLP、CV、ML 领域各 10 篇精选,并提供音频形式的论文摘要简介。

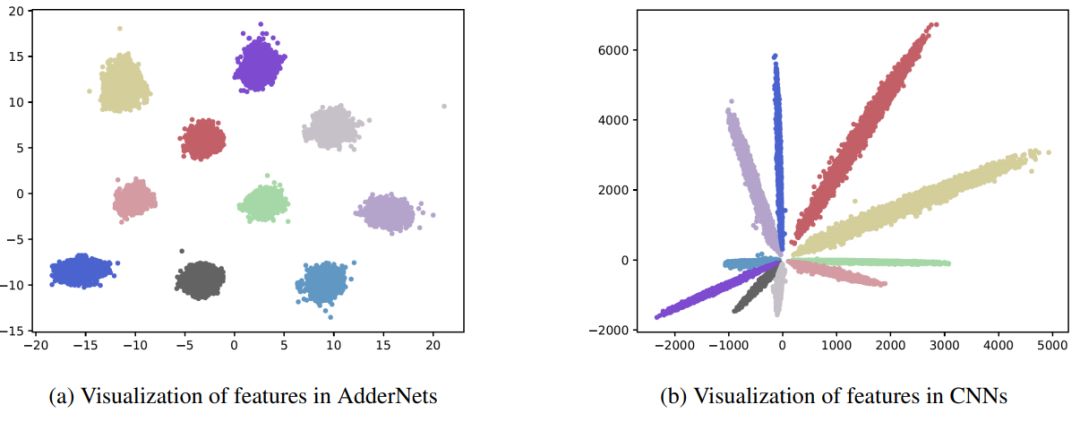

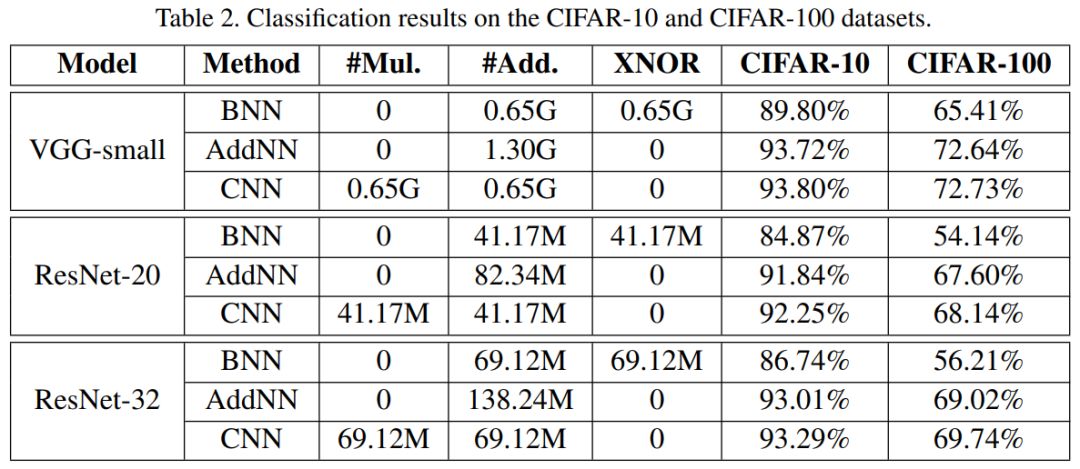

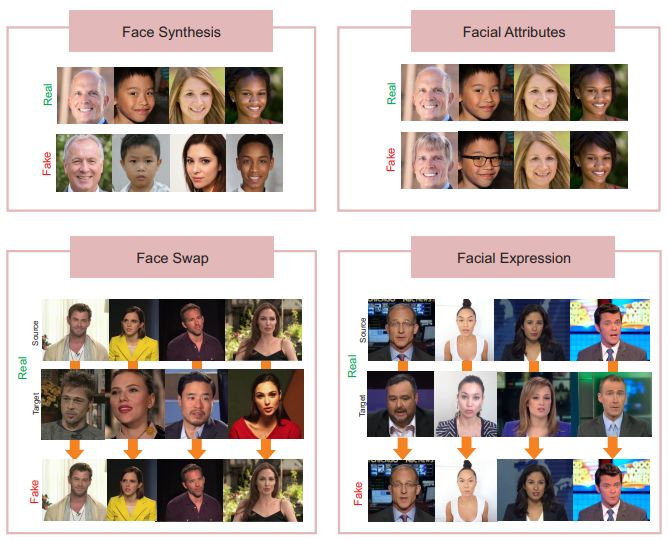

AdderNet: Do We Really Need Multiplications in Deep Learning?

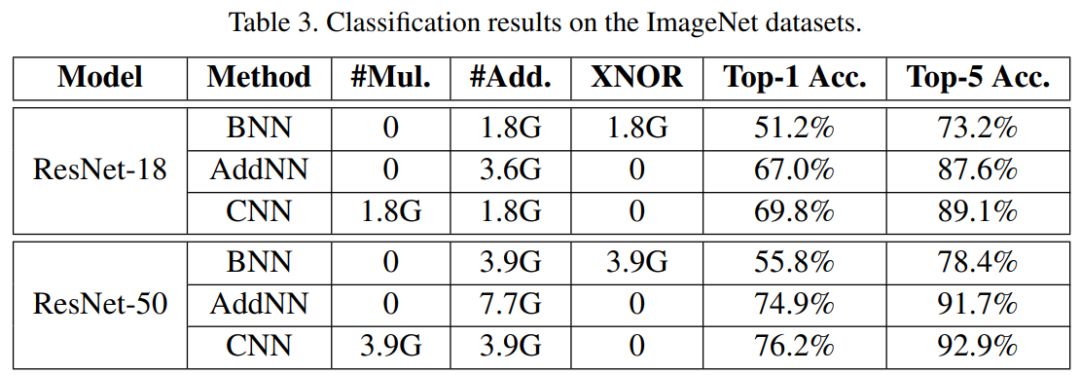

DeepFakes and Beyond: A Survey of Face Manipulation and Fake Detection

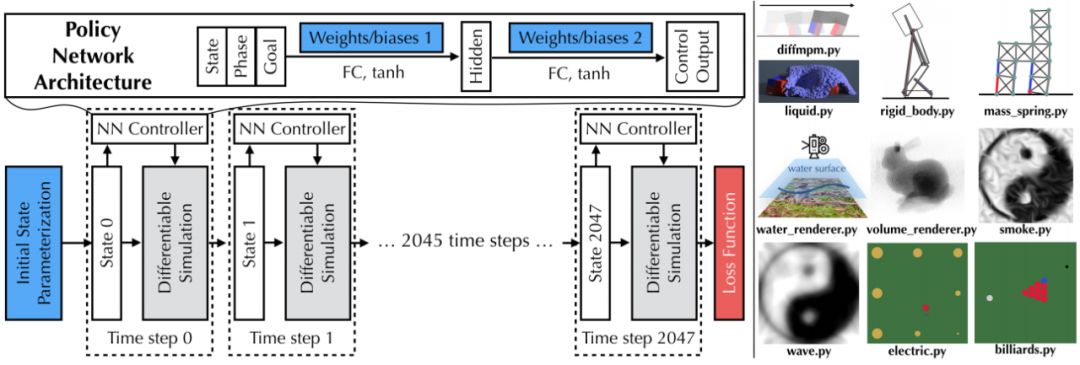

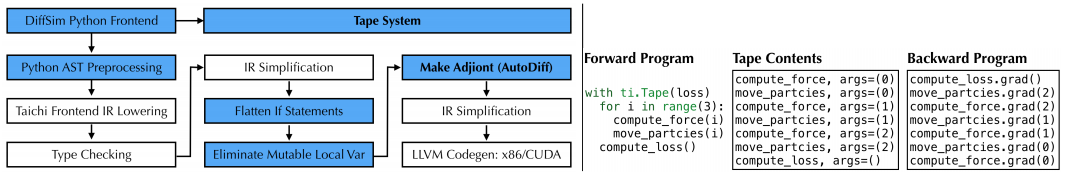

DiffTaichi: Differentiable Programming for Physical Simulation

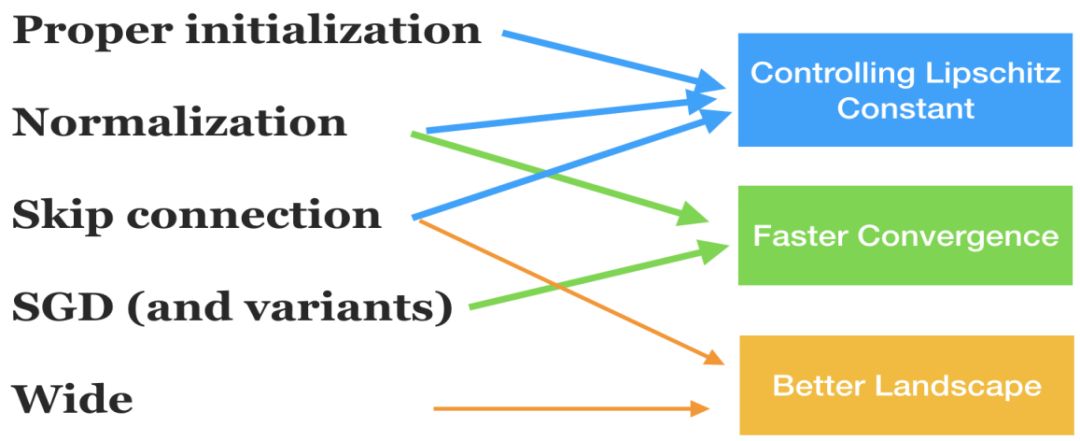

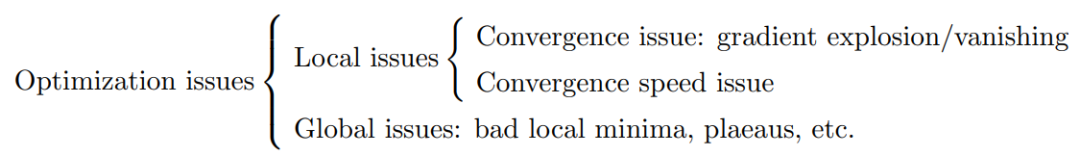

Optimization for deep learning: theory and algorithms

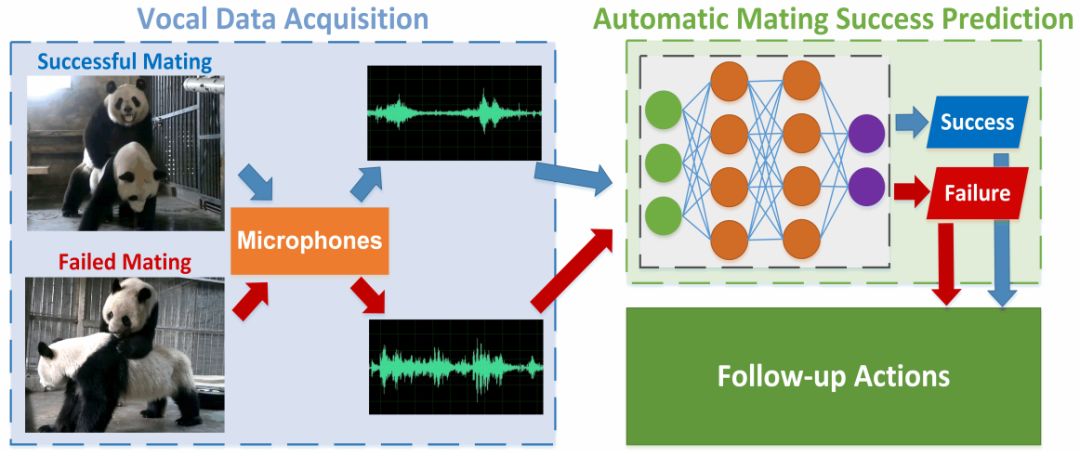

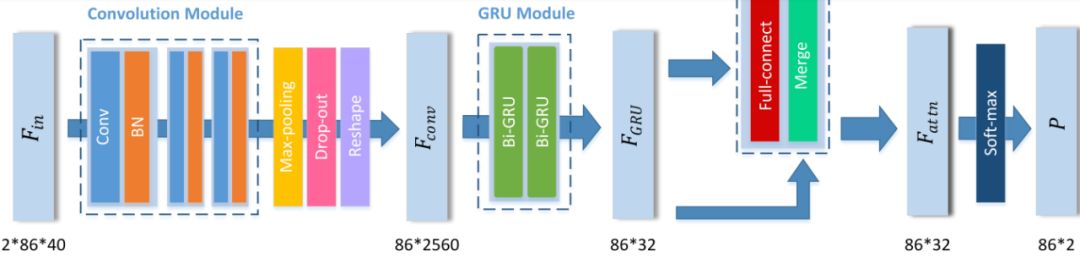

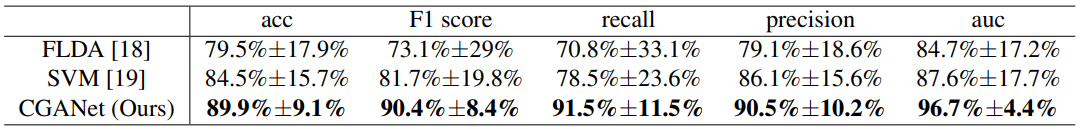

Audio-based automatic mating success prediction of giant pandas

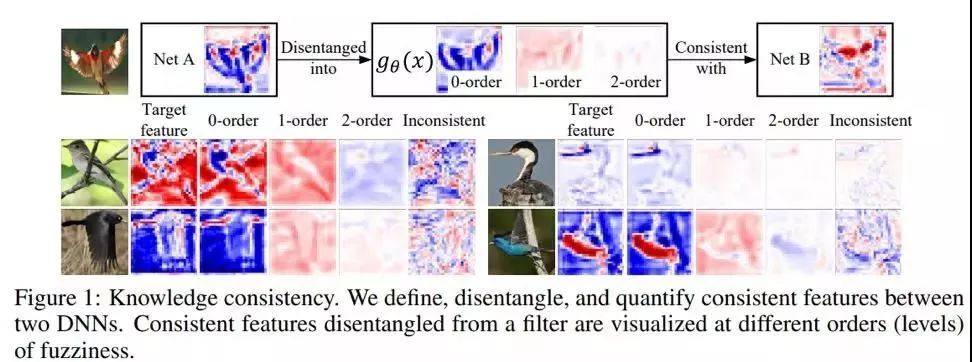

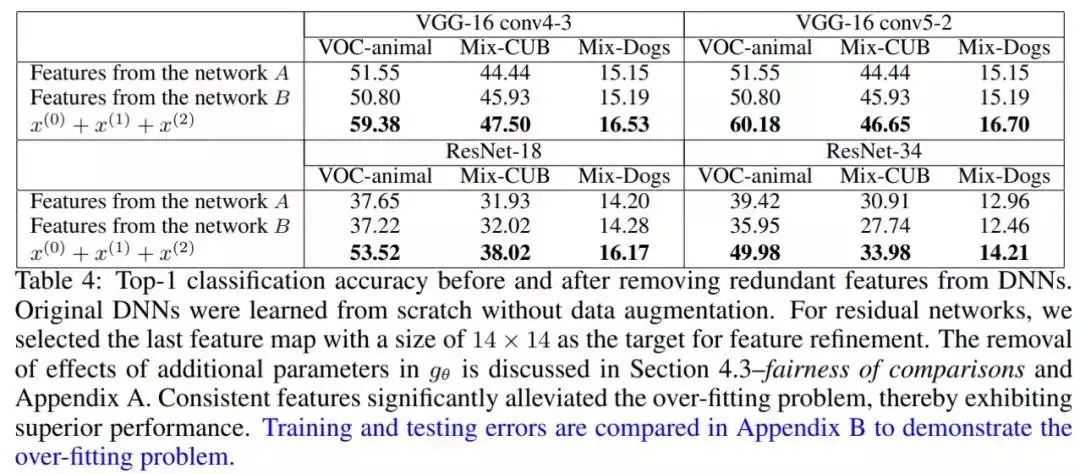

Knowledge Consistency between Neural Networks and Beyond

Q-BERT: Hessian Based Ultra Low Precision Quantization of BERT

ArXiv Weekly Radiostation:NLP、CV、ML更多精选论文(附音频)

作者:Hanting Chen、Yunhe Wang、Chunjing Xu 等

论文链接:https://arxiv.org/pdf/1912.13200v2.pdf

作者:Ruben Tolosana、Ruben Vera-Rodriguez、Julian Fierrez 等

论文链接:https://arxiv.org/pdf/2001.00179v1.pdf

作者:Yuanming Hu、Luke Anderson、Tzu-Mao Li 等

论文链接:https://arxiv.org/pdf/1910.00935.pdf

作者:Ruoyu Sun

论文链接:https://arxiv.org/pdf/1912.08957.pdf

作者:WeiRan Yan、MaoLin Tang、Qijun Zhao 等

论文链接:https://arxiv.org/abs/1912.11333

作者:Ruofan Liang、Tianlin Li、Longfei Li、Quanshi Zhang

论文链接:https://arxiv.org/pdf/1908.01581.pdf

作者:Sheng Shen、Zhen Dong、Jiayu Ye 等

论文链接:https://arxiv.org/pdf/1909.05840.pdf

ArXiv Weekly Radiostation

机器之心联合由楚航、罗若天发起的ArXiv Weekly Radiostation,在 7 Papers 的基础上,精选本周更多重要论文,包括NLP、CV、ML领域各10篇精选,并提供音频形式的论文摘要简介,详情如下:

本周 10 篇 NLP 精选论文是:

1. Multiplex Word Embeddings for Selectional Preference Acquisition. (from Hongming Zhang)

2. REST: A thread embedding approach for identifying and classifying user-specified information in security forums. (from Michalis Faloutsos)

3. A Neural Approach to Discourse Relation Signal Detection. (from Yang Liu)

4. Improving Entity Linking by Modeling Latent Entity Type Information. (from Chin-Yew Lin)

5. Learning Bilingual Word Embeddings Using Lexical Definitions. (from Kai-Wei Chang)

6. Stance Detection Benchmark: How Robust Is Your Stance Detection?. (from Iryna Gurevych)

7. Leveraging Prior Knowledge for Protein-Protein Interaction Extraction with Memory Network. (from Zhuang Liu)

8. Binary and Multitask Classification Model for Dutch Anaphora Resolution: Die/Dat Prediction. (from Marie-Francine Moens)

9. Paraphrase Generation with Latent Bag of Words. (from John P. Cunningham)

10. Adapting Deep Learning for Sentiment Classification of Code-Switched Informal Short Text. (from Asim Karim)

本周 10 篇 CV 精选论文是:

1.Agriculture-Vision: A Large Aerial Image Database for Agricultural Pattern Analysis. (from Thomas S. Huang)

2. Weakly Supervised Visual Semantic Parsing. (from Shih-Fu Chang)

3. Bridging Knowledge Graphs to Generate Scene Graphs. (from Shih-Fu Chang)

4. General Partial Label Learning via Dual Bipartite Graph Autoencoder. (from Shih-Fu Chang)

5. RPR: Random Partition Relaxation for Training; Binary and Ternary Weight Neural Networks. (from Luca Benini)

6. Chained Representation Cycling: Learning to Estimate 3D Human Pose and Shape by Cycling Between Representations. (from Michael J. Black, Konrad Schindler)

7. Few-shot Learning with Multi-scale Self-supervision. (from Philip H. S. Torr)

8. Compression of convolutional neural networks for high performance imagematching tasks on mobile devices. (from Krystian Mikolajczyk)

9. MW-GAN: Multi-Warping GAN for Caricature Generation with Multi-Style Geometric Exaggeration. (from Yang Gao)

10. FrequentNet : A New Deep Learning Baseline for Image Classification. (from Zheng Wang)

本周 10 篇 ML 精选论文是:

1. Semi-supervised Classification using Attention-based Regularization on Coarse-resolution Data. (from Vipin Kumar)

2. Think Locally, Act Globally: Federated Learning with Local and Global Representations. (from Ruslan Salakhutdinov, Louis-Philippe Morency)

3. Information Theoretic Model Predictive Q-Learning. (from Dieter Fox)

4. Meta-modal Information Flow: A Method for Capturing Multimodal Modular Disconnectivity in Schizophrenia. (from Daniel H. Mathalon, Judith M. Ford, Jessica A. Turner, Vince D. Calhoun)

5. Deep Time-Stream Framework for Click-Through Rate Prediction by Tracking Interest Evolution. (from Ming Li)

6. On Interpretability of Artificial Neural Networks. (from Ge Wang)

7. Convolutional Networks with Dense Connectivity. (from Laurens van der Maaten, Kilian Q. Weinberger)

8. Supervised Discriminative Sparse PCA with Adaptive Neighbors for Dimensionality Reduction. (from Chin-Teng Lin)

9. EEG-based Drowsiness Estimation for Driving Safety using Deep Q-Learning. (from Chin-Teng Lin)

10. SGD with Hardness Weighted Sampling for Distributionally Robust Deep Learning. (from Sebastien Ourselin)

点击阅读原文,查看 ArXiv Weekly Radiostation 全部图文内容。