Fisher信息量检测对抗样本代码详解

©PaperWeekly 原创 · 作者 | 鬼谷子

在上一篇《Fisher信息量在对抗样本中的应用》中详尽地阐述了 Fisher 信息量在对抗攻击,防御,以及检测中的应用,并解析了三篇具有代表性的论文。Fisher 信息量是可以用来去挖掘深度学习模型对抗行为的深层原因的非常好用一个数学工具。

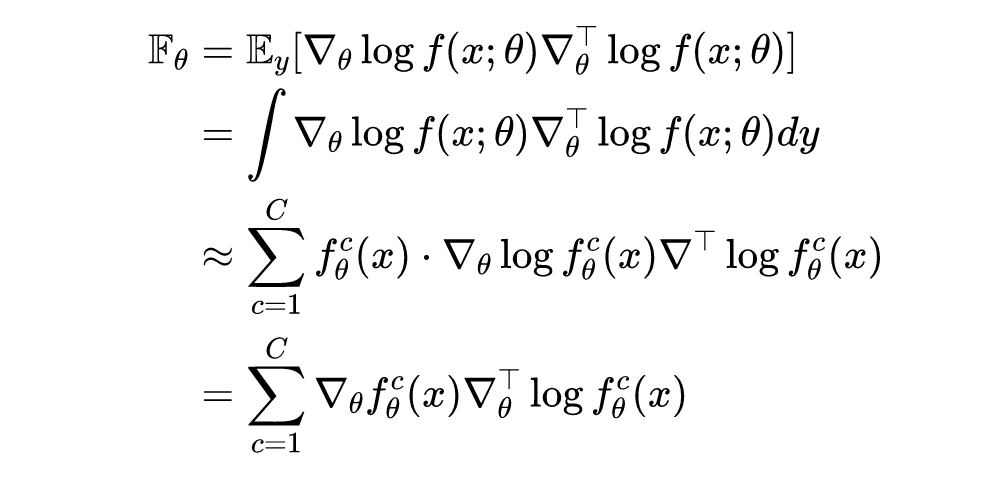

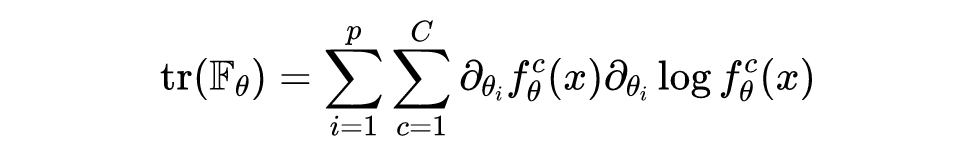

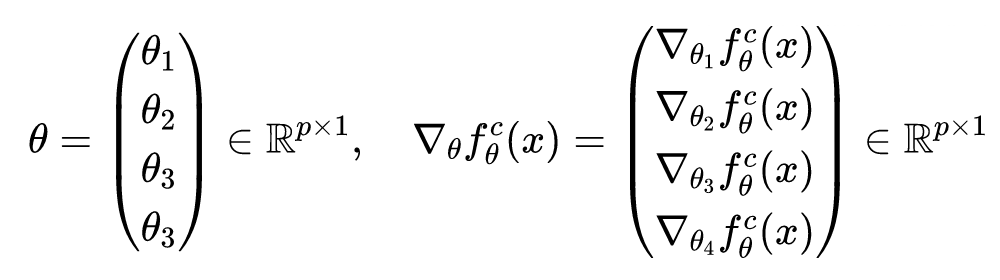

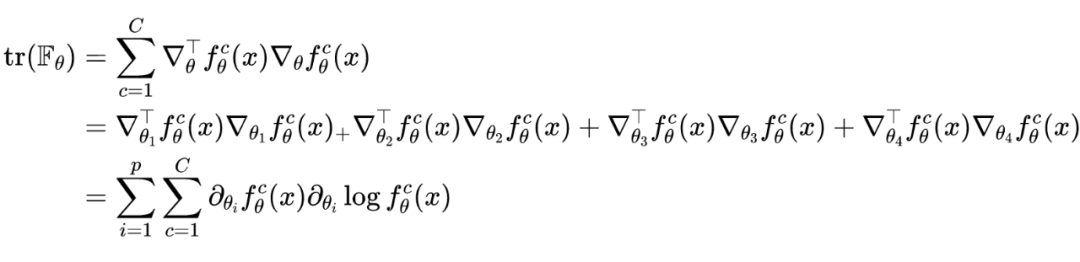

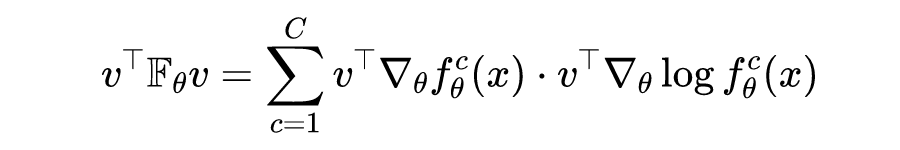

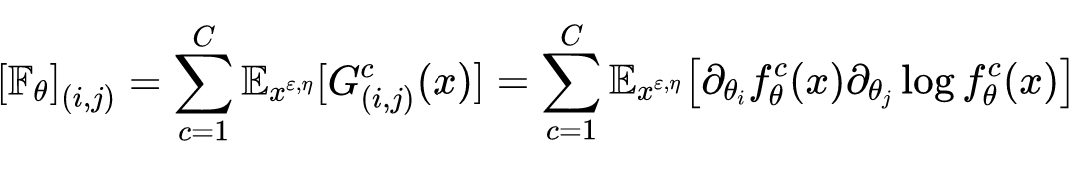

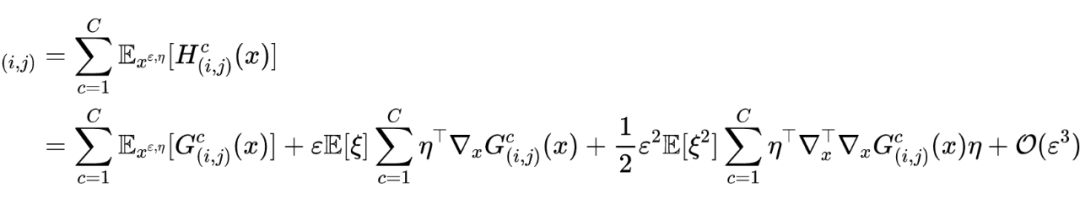

Fisher信息二次型

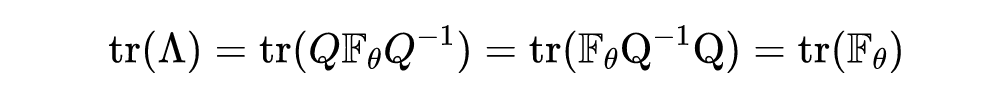

这里需要注意的是选取的方向并不唯一,如果想让二次型的取值达到最大,则是 Fisher 矩阵的最大特征值,选取的方向为在最大特征值对应的特征向量。需要指明一点的是,Fisher 矩阵的迹要大于 Fisher 矩阵的最大特征值,具体证明如下所示:

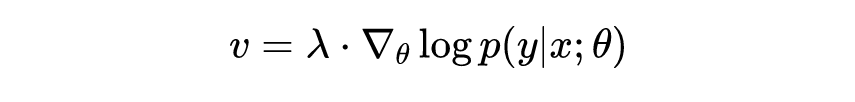

进而则有:

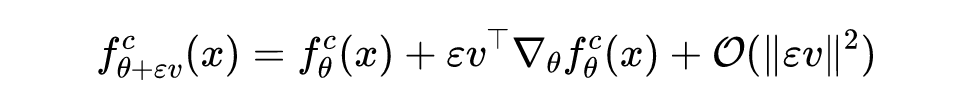

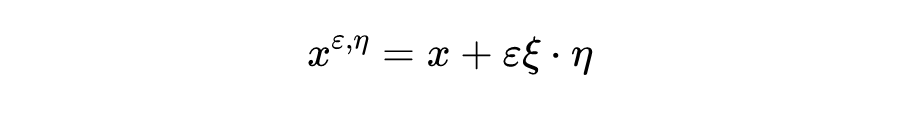

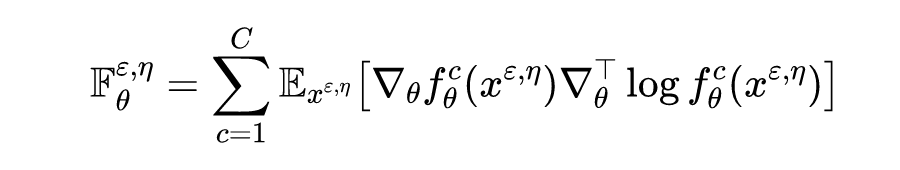

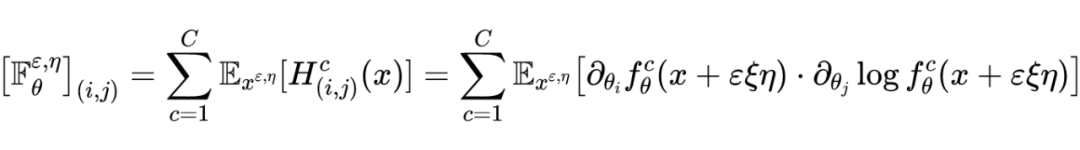

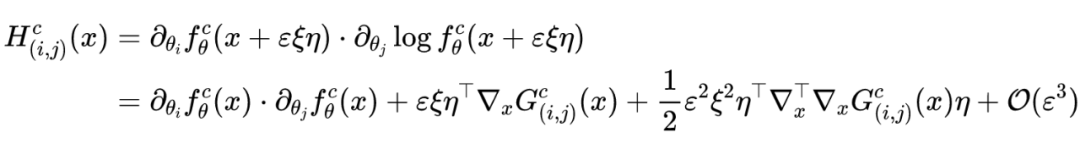

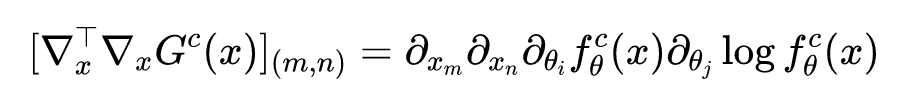

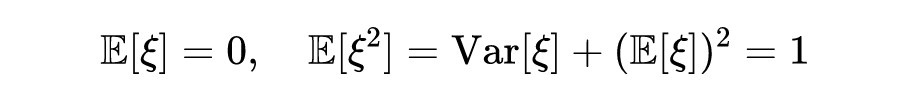

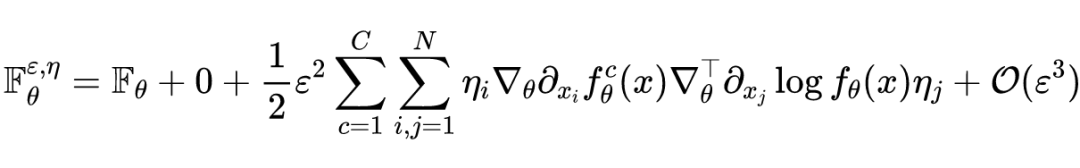

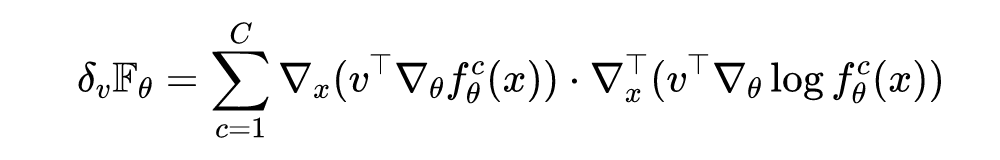

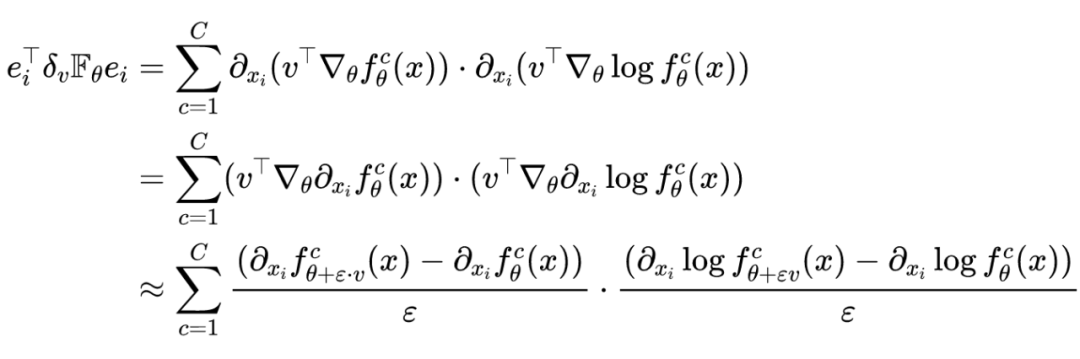

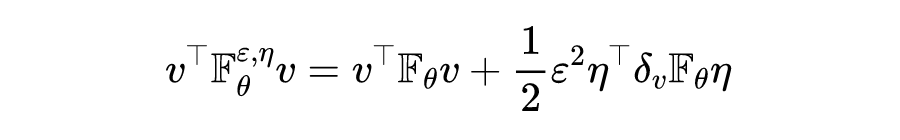

Fisher信息敏感度

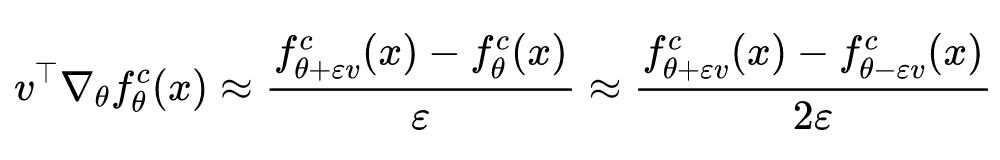

则有泰勒展开式可知:

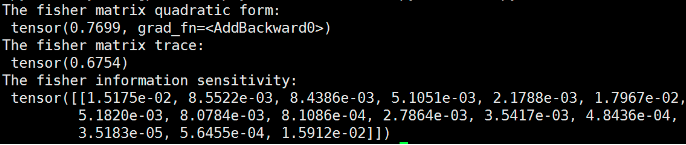

代码示例

Fisher 信息矩阵的迹,Fisher 信息二次型以及 Fisher 信息敏感度的代码示例和实验结果如下所示,对应上文的原理介绍,可以更好的理解代码示例中相关原理的实现细节。

import torch

import torch.nn.functional as F

from copy import deepcopy

class FISHER_OPERATION(object):

def __init__(self, input_data, network, vector, epsilon = 1e-3):

self.input = input_data

self.network = network

self.vector = vector

self.epsilon = epsilon

# Computes the fisher matrix quadratic form along the specific vector

def fisher_quadratic_form(self):

fisher_sum = 0

## Computes the gradient of parameters of each layer

for i, parameter in enumerate(self.network.parameters()):

## Store the original parameters

store_data = deepcopy(parameter.data)

parameter.data += self.epsilon * self.vector[i]

log_softmax_output1 = self.network(self.input)

softmax_output1 = F.softmax(log_softmax_output1, dim=1)

parameter.data -= 2 * self.epsilon * self.vector[i]

log_softmax_output2 = self.network(self.input)

solfmax_output2 = F.softmax(log_softmax_output2, dim=1)

parameter.data = store_data

# The summation of finite difference approximate

fisher_sum += (((log_softmax_output1 - log_softmax_output2)/(2 * self.epsilon))*((softmax_output1 - solfmax_output2)/(2 * self.epsilon))).sum()

return fisher_sum

# Computes the fisher matrix trace

def fisher_trace(self):

fisher_trace = 0

output = self.network(self.input)

output_dim = output.shape[1]

parameters = self.network.parameters()

## Computes the gradient of parameters of each layer

for parameter in parameters:

for j in range(output_dim):

self.network.zero_grad()

log_softmax_output = self.network(self.input)

log_softmax_output[0,j].backward()

log_softmax_grad = parameter.grad

self.network.zero_grad()

softmax_output = F.softmax(self.network(self.input), dim=1)

softmax_output[0,j].backward()

softmax_grad = parameter.grad

fisher_trace += (log_softmax_grad * softmax_grad).sum()

return fisher_trace

# Computes fisher information sensitivity for x and v.

def fisher_sensitivity(self):

output = self.network(self.input)

output_dim = output.shape[1]

parameters = self.network.parameters()

x = deepcopy(self.input.data)

x.requires_grad = True

fisher_sum = 0

for i, parameter in enumerate(parameters):

for j in range(output_dim):

store_data = deepcopy(parameter.data)

# plus eps

parameter.data += self.epsilon * self.vector[i]

log_softmax_output1 = self.network(x)

log_softmax_output1[0,j].backward()

new_plus_log_softmax_grad = deepcopy(x.grad.data)

x.grad.zero_()

self.network.zero_grad()

softmax_output1 = F.softmax(self.network(x), dim=1)

softmax_output1[0,j].backward()

new_plus_softmax_grad = deepcopy(x.grad.data)

x.grad.zero_()

self.network.zero_grad()

# minus eps

parameter.data -= 2 * self.epsilon * self.vector[i]

log_softmax_output2 = self.network(x)

log_softmax_output2[0,j].backward()

new_minus_log_softmax_grad = deepcopy(x.grad.data)

x.grad.zero_()

self.network.zero_grad()

softmax_output2 = F.softmax(self.network(x), dim=1)

softmax_output2[0,j].backward()

new_minus_softmax_grad = deepcopy(x.grad.data)

x.grad.zero_()

self.network.zero_grad()

# reset and evaluate

parameter.data = store_data

fisher_sum += 1/(2 * self.epsilon)**2 * ((new_plus_log_softmax_grad - new_minus_log_softmax_grad)*(new_plus_softmax_grad - new_minus_softmax_grad))

return fisher_sum

import torch

import torch.nn as nn

import fisher

network = nn.Sequential(

nn.Linear(15,4),

nn.Tanh(),

nn.Linear(4,3),

nn.LogSoftmax(dim=1)

)

epsilon = 1e-3

input_data = torch.randn((1,15))

network.zero_grad()

output = network(input_data).max()

output.backward()

vector = []

for parameter in network.parameters():

vector.append(parameter.grad.clone())

FISHER = fisher.FISHER_OPERATION(input_data, network, vector, epsilon)

print("The fisher matrix quadratic form:", FISHER.fisher_quadratic_form())

print("The fisher matrix trace:", FISHER.fisher_trace())

print("The fisher information sensitivity:", FISHER.fisher_sensitivity())

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧