图表示学习工具包CogDL + TensorFlow开源项目,期待你的参与

编辑:深度传送门

加“CogDL+TensorFlow交流群“请添加助手:deepdeliver(备注:姓名-学校/公司-方向)

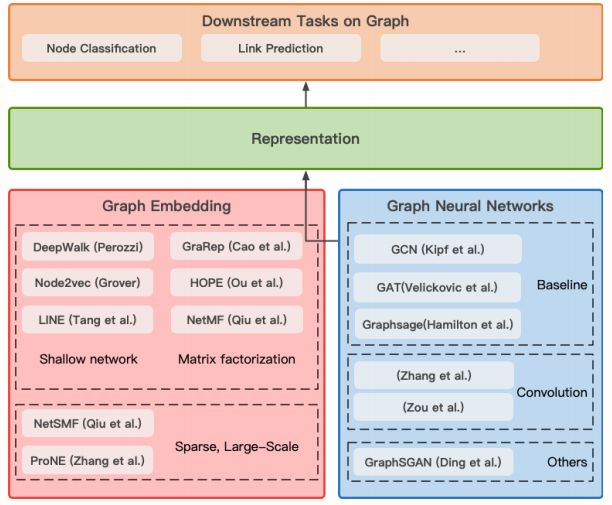

近日,清华大学知识工程研究室(KEG)推出了一个大规模图表示学习工具包 CogDL,可以让研究者和开发者更加方便地训练和对比用于节点分类、链路预测以及其他图任务的基准或定制模型。 该工具包集成了 Deepwalk、LINE、node2vec、GraRep、NetMF、NetSMF、ProNE 等非图神经网络和 GCN、GAT、GraphSage、DrGCN、NSGCN、GraphSGAN 等图神经网络基准模型的实现。

项目页面:http://keg.cs.tsinghua.

edu.cn/cogdl/index.html

GitHub 链接:https://github.com/

THUDM/cogdl/

项目介绍

CogDL当前采用PyTorch实现,考虑到当前工业界TensorFlow仍然占主导地位且有很多工业界场景需要使用CogDL中包含的各大算法的需求,经过与唐杰老师的线下沟通获得同意,我们发起了一个CogDL-TensorFlow的开源项目。

项目的初衷是将CogDL里面的各个算法使用TensorFlow来复现并且使用统一的接口流程来封装,方便大家在工业界各场景中接入对比各自的效果。我们计划召集一批感兴趣且乐于参与贡献的小伙伴,拆分任务列表且各自认领任务,以周为单位推进项目进展,欢迎对此项目感兴趣想参与贡献的小伙伴加入我们的交流群。

欢迎大家前往下面的GitHub地址进行学习、star以及fork。CogDL工具箱后续会增加更多新的算法,本仓库也将持续同步更新、迭代。

https://github.com/imsheridan/CogDL-TensorFlow

对项目感兴趣希望加入“CogDL+TensorFlow交流群”参与贡献的朋友,请加助手:deepdeliver。

(备注:姓名+学校/公司+方向)

CogDL工具箱介绍

稀疏性:在具有数千万节点的大规模网络上实现快速网络嵌入;

任意性:能够处理属性化、多路和异构等不同图结构的网络;

并行处理:在多个 GPU 上实现不同种子和模型的并行训练并自动输出结果表格;

可扩展性:轻松添加新的数据集、模型和任务并在所有现有的模型/数据集上测试。

本文转载自公众号:深度传送门,作者:深度传送门

推荐阅读

我们建了一个免费的知识星球:AINLP芝麻街,欢迎来玩,期待一个高质量的NLP问答社区

AINLP-DBC GPU 云服务器租用平台建立,价格足够便宜

关于AINLP

AINLP 是一个有趣有AI的自然语言处理社区,专注于 AI、NLP、机器学习、深度学习、推荐算法等相关技术的分享,主题包括文本摘要、智能问答、聊天机器人、机器翻译、自动生成、知识图谱、预训练模型、推荐系统、计算广告、招聘信息、求职经验分享等,欢迎关注!加技术交流群请添加AINLP君微信(id:AINLP2),备注工作/研究方向+加群目的。