DeepMind发表Nature论文:「预测地图」海马体催生强化学习新算法

选自DeepMind

作者:Kimberly Stachenfeld等

机器之心编译

参与:路雪、黄小天

DeepMind 近日在《Nature Neuroscience》上发布最新研究,认为海马体能够通过预期的后续状态来展示每一个当前状态,从而传输对未来事件的细致总结。这种特殊形式的预测地图使大脑快速适应奖励不同的环境,而无需运行对未来的模拟。受此启发,DeepMind 提出将强化学习中基于模型的算法和无模型算法结合起来,既保证计算成本低廉,又能快速适应奖励变化。DeepMind 表示,预测地图理论可以转换成神经网络架构。

想一下你如何选择上班路线、搬家地点,甚至游戏里下一步的操作。所有这些场景都要求你评估决策可能带来的未来奖励。这很复杂,因为当一个人越来越深入未来,可能的场景数量会大大增加。理解我们如何做一件事是神经科学领域主要的研究问题,而构建有效预测奖励的系统是 AI 研究的重点。

我们在最近发表在《自然-神经科学》(Nature Neuroscience)的论文中,从神经科学的角度看待长期存在的数学理论(从机器学习到为学习和记忆的本质提供新见解)。具体来说,我们提出海马体使用「预测地图」细致地总结未来事件,这为解决该问题提供了独特的方案。

传统观点认为海马体只是呈现动物的当前状态,尤其是在空间任务中,如走迷宫。这个观点在发现啮齿动物海马体中的「位置细胞」后得到了广泛传播,位置细胞在动物处于特定位置时会有选择性地放电。尽管该理论可以解释很多神经生理学的研究发现,但是它无法解释为什么海马体还参与其他功能,如记忆、关系推理和决策。

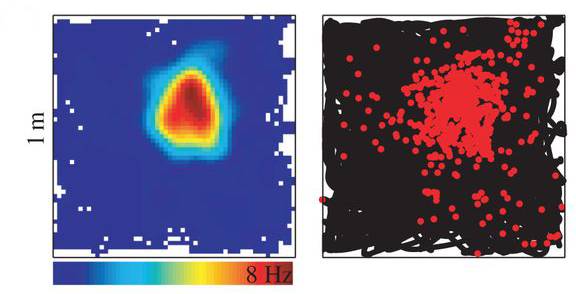

在老鼠探索方形房间时,记录下来的海马体单个位置细胞的活动。左图中,每一个空间位置展示了神经元的平均活动或「放电率」。右图中,黑线指老鼠去过的地方,红点指细胞每次活跃或「放电」时老鼠的位置。该细胞是典型的位置细胞,它倾向于在靠近它喜欢的位置(房间右上角)时放电。

我们的新理论认为导航是最大化未来奖励的计算规划这一更普遍问题的一部分。这一观点来自强化学习,聚焦于通过试错进行学习的系统。我们得出的关键计算方法是:为评估未来奖励,智能体必须首先评估它对每个状态期望的直接奖励,然后用未来进入每个状态的频率对期望奖励进行加权。智能体总结所有可能状态的加权奖励,从而获取对未来奖励的评估。

类似地,我们认为海马体用预测到的未来状态展示每一种情况或状态。比如,如果你要下班(当前状态),海马体会预测你可能很快就要乘车下班、到学校接孩子,或者更长远一点,到家了。海马体通过进行这些预测来展示你的状态。海马体通过预期的后续状态来展示每一个当前状态,从而传输了未来事件的细致总结,正式说法叫作「后续表征」(successor representation)。我们认为这种特殊形式的预测地图使大脑快速适应奖励不同的环境,而无需运行对未来的模拟,这种模拟往往代价较高。

钢琴家状态的后续表征应该同时展现当前弹奏的琴键和之后的音符。

该方法将强化学习中广为人知的两种算法的力量连接起来,同时人们认为这两种算法在人类和啮齿动物中都存在。「基于模型」(model-based)的算法学习环境模型,然后模拟以输出对未来奖励的评估;而「无模型」(model-free)算法直接从在环境中的经验来学习未来奖励评估。基于模型的算法比较灵活但是计算成本高昂,而无模型算法计算成本低廉但不够灵活。

我们理论中的新算法将基于模型的算法的灵活性和无模型算法的高效性结合起来。由于计算只是简单的加权总和,因此该算法的计算成本像无模型算法那样低廉。同时,通过分离奖励期望和状态期望(预测地图),该算法可以通过简单地更新奖励期望、保持状态期望不变来快速适应奖励变化(更多细节见 DeepMind 之前的论文《The successor representation in human reinforcement learning》)。

我们计划在未来的工作中进一步测试该理论。预测地图理论可以转换成神经网络架构,因此我们想探索该学习策略能够多大程度上提高生物信息学中灵活、快速的规划。

未来主要的任务是研究大脑如何整合不同类型的学习。尽管我们将该模型作为大脑中基于模型和无模型学习的替代方法,但一个更现实的观点是:大脑在学习和规划过程中同时协调多种学习。理解如何结合这些学习算法是通向理解人类和动物大脑的重要一步,并且能够为设计同样复杂、多层次的 AI 提供重要思路。

论文:The hippocampus as a predictive map

论文链接:https://www.nature.com/neuro/journal/vaop/ncurrent/full/nn.4650.html

摘要:由于「位置细胞(place cell)编码空间的几何表征」这一观点的流行,海马体长期被喻为认知地图。然而,位置细胞中预测编码、奖励敏感度和策略依赖的证据表明位置细胞并不纯粹是空间表征。我们从强化学习的角度出发试图解开这一谜题:何种空间表征最利于最大化未来奖励?结果表明答案是预测表征。预测表征获取位置细胞反应的诸多方面,这些反应与传统认知地图不同。此外,我们认为内嗅网格细胞(entorhinal grid cell)编码一个低维度基组用于预测表征,有效抑制预测中的噪声,并提取用于分层规划的多尺度结构。

原文链接:https://deepmind.com/blog/hippocampus-predictive-map/

本文为机器之心编译,转载请联系本公众号获得授权。

✄------------------------------------------------

加入机器之心(全职记者/实习生):hr@jiqizhixin.com

投稿或寻求报道:content@jiqizhixin.com

广告&商务合作:bd@jiqizhixin.com