©PaperWeekly 原创 · 作者|张玮玮

学校|东北大学硕士

研究方向|脑电情绪识别

论文标题:

A Two-Step Graph Convolutional Decoder for Molecule Generation

论文链接:

https://arxiv.org/abs/1906.03412

药物发现和材料科学的一个基本问题是设计具有优化化学性质的任意分子。由于分子本质上是组合在一起的,化学结构中的任何小扰动都可能导致所需分子性质的大变化。因此,这是一个极具挑战性的数学和计算问题。

此外,随着原子和键的组合排列数量的不断增加,有效分子的空间也越来越大。目前,大多数药物都是经过化学和药理学专家多年的反复试验而制作的。最近机器学习和深度学习的进展开辟了一个新的研究方向,有望学习这些分子空间来优化分子生成,减少实验流程。

1.2 论文工作

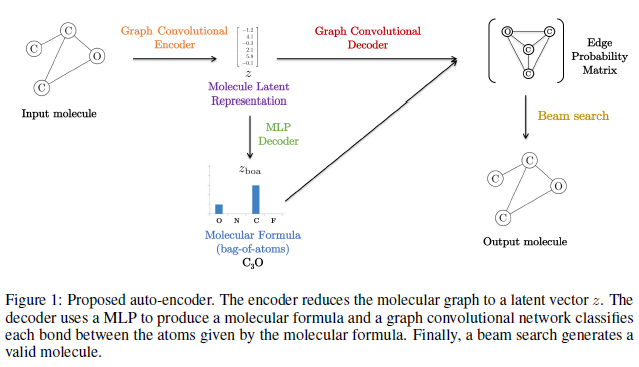

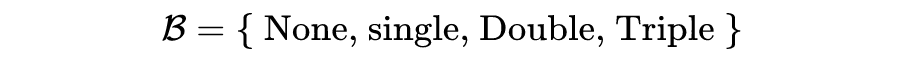

论文提出了一个分子生成自动编码器框架。分子图首先被编码成一个连续的潜在表示

,然后再被解码回一个分子。编码过程很简单,但解码过程仍然具有挑战性。

在本工作中,我们介绍了一个简单的两步译码过程。在第一步,一个完全连接的神经网络使用潜在的向量

生成一个分子式,例如二氧化碳(一个碳和两个氧原子)。

在第二步中,图形卷积神经网络使用相同的潜在向量

在第一步中产生的原子之间建立键(例如,将在碳和每个氧之间建立一个双键)。这个两步过程,首先生成一袋原子,然后组装,允许开发一个高效的分子自动编码器。

图1表示自动编码器框架。在本节中,详细介绍系统的各个部分:

2.1 分子编码器

每个原子类型和边缘类型首先嵌入到空间

中,然后这些特征通过

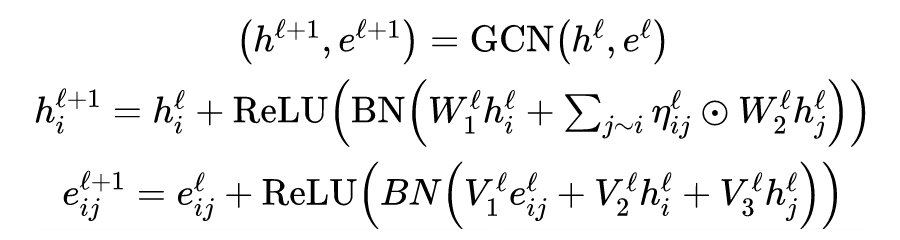

层图神经网络进行处理。本文使用 Bresson 和 Laurent 中引入的 garph ConvNet 技术来计算隐藏节点和边缘特征表示。

表示节点特征,

表示边

之间的关系。图卷积网络更新

和

如下:

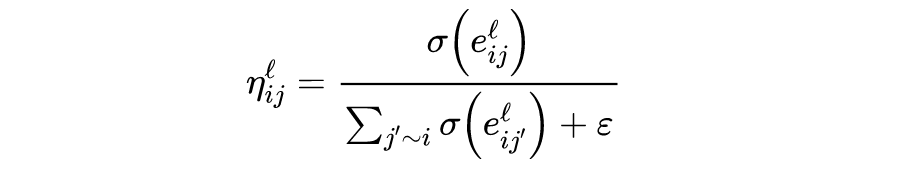

其中,

表示 dense attention function,

表示 sigmoid 函数,ReLU 表示 ReLU 非线性函数,BN 为 batch normalization。每一层都有一组不同的参数,最后,利用缩减步骤来产生固定大小的向量

:

2.2 原子生成

编码器的第一步是产生分子式,分子式表示分子中每种类型原子的数量,而没有键结构的信息。例如二氧化碳的分子式是

,表示这个分子含有一个碳和三个氧。分子式可以看作是分子的一个简单的原子袋表示。

三氧化二碳的分子式可用向量表示

(1 个碳,0 个氮,3 个氧)。一般来说,如果我们考虑具有 m 种可能类型的原子的分子,分子公式可以用包含每种类型原子的 m 个分量的向量表示。

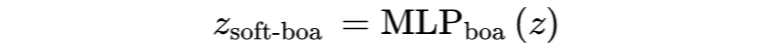

由于分子式是由一个固定大小的向量 m 表示的,它可以很容易地由一个全连接的神经网络产生。因此,解码器的第一步是将潜在向量 z 输入到一个完全连接的神经网络(这里是一个隐藏层的 MLP):

是一个

矩阵,其中

为原子类型的数量,

为训练集中最大分子大小。分子式

是沿着

的第二维得分最大值的指标产生的。分子式生成之后,解码器将决定如何通过生成原子之间的键来连接每个原子。

2.3 连接键的生成

解码器的第二步是利用原子袋向量

和潜在表示

在一个单一通道中组装原子,为此,本文首先通过连接分子式中的每个原子来创建一个完全连通的图。全连通图的每个顶点通过某个嵌入矩阵接收到

中对应于原子类型的特征,每条边接收到相同的嵌入特征向量

,

为某个可学习的权值矩阵。

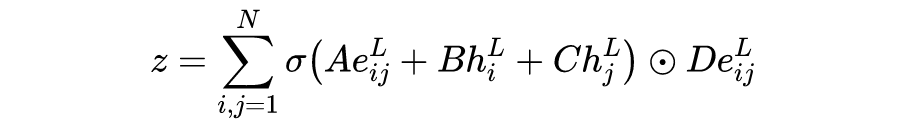

然后由第一个所描述的图卷积网络的

层对该全连通图进行处理,并添加新的分子解码参数。由此得到的最后一个卷积层的特征向量

可以用来预测在可能的类型中连接原子

和原子

的键的类型:

预测边缘类型的一种简单方法是使用 MLP 对每个向量

进行独立分类:

其中

为边得分,n 为 b 中的键数,最终取最大边得分指数来选择边类型。

2.4 位置编码

图 1 右上方所示的全连通图,初始化时,键解码器的 5 条边每条都有完全相同的特征

,3 个碳原子每条都有相同的特征向量(碳类型的嵌入向量)。

当 GCN 处理此图时,碳原子上的特征将无法彼此区分(以及连接碳和氧的 3 条边上的特征)。为了弥补这一对称性问题,我们引入了一些位置特征,允许将同一类型的原子嵌入到不同的向量中,从而区分同一类型的原子。

位置特征

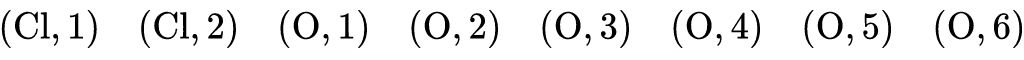

化合物二氯氧 3,它的分子式是

(2 个氯和 6 个氧)。假设我们有一种自然的方式来排列分子中的原子,这样组成二氯六氧化合物的 8 个原子可以写成:

表示分子中的第 3 个氧。”在本例中,我们将数字 3 称为位置特性”,作者只是根据原子在分子的标准 SMILES 表示中出现的位置,这些位置特征包含了一些关于分子的弱结构信息。

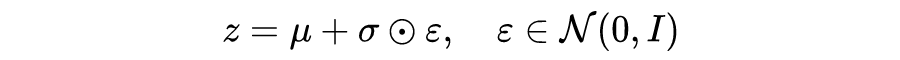

2.5 变分自编码器(VAE)

最后,本文使用了 VAE 方法来填充潜在空间来改善分子生成任务,VAE 需要学习参数化的分子潜在向量表示

:

其中,

与

可以通过带有 reduction layer 的编码器学习到:

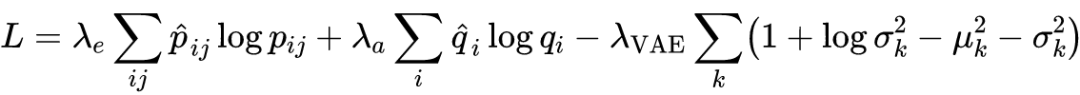

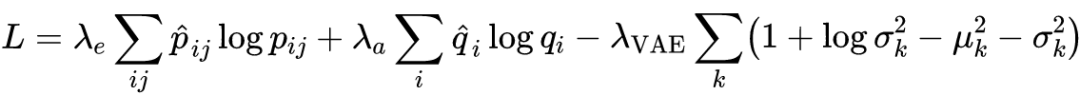

总损失由三项组成:边缘概率的交叉熵损失、原子袋概率的交叉熵损失和 VAE 高斯分布的 Kullback Leibler 散度:

最后,输入和输出分子之间不需要匹配,因为使用了相同的原子顺序。

2.6 束搜索 由于潜在的原子价破坏,所提出的一次性解码器可能不能产生化学上有效的分子。我们使用波束搜索技术来产生一个有效分子。波束搜索的定义如下。我们从一条随机的边开始。

我们选择(1)有最大概率(或通过伯努利抽样)的下一条边,(2)连接到所选的边,且(3)不违反价原理。当边选择结束时,生成一个分子。本文对不同随机初始化的

重复这个过程,生成

候选分子。最后,本文选择了最大限度的边缘概率或化学性质的乘积的分子。

实验

3.1 数据集

本文使用的 ZINC 分子数据集,该数据集有 250k 类药物分子,有 38 个重原子(氢原子除外)。数据集最初是用 smile 编码的,并使用开源的化学信息学软件包 Rdkit2 来获得规范的 smile 表示。

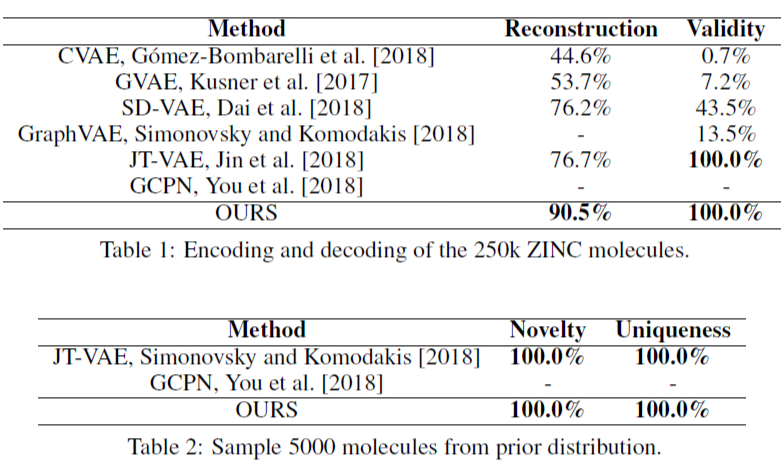

3.2 分子重构

第一个任务是重构潜在空间的分子并从中取样。表 1 了重表示了分子重建和有效性结果。为了评估系统的新颖性和唯一性,我们从先验分布

采样 5000 个分子。

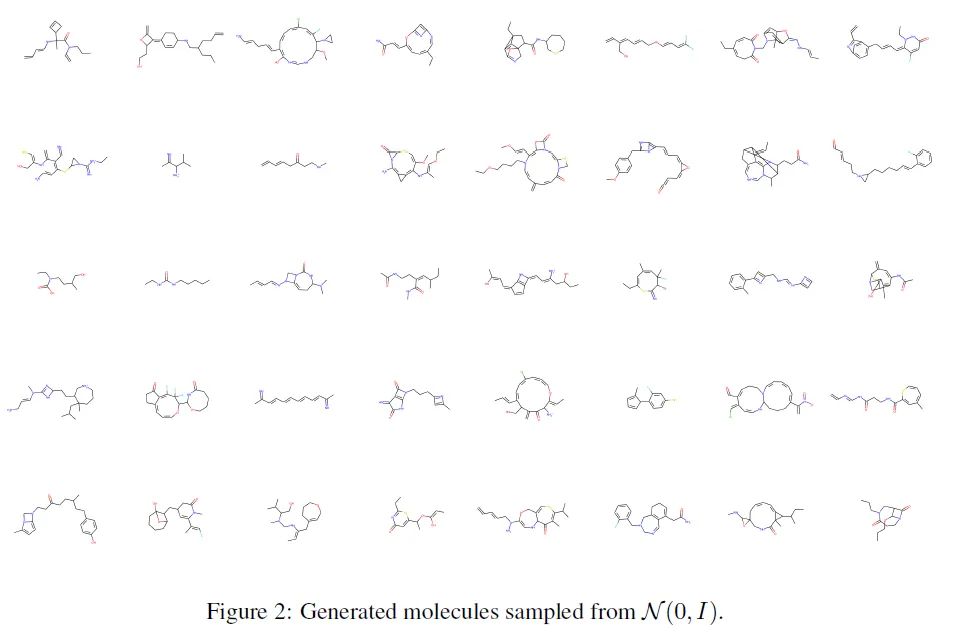

表 2 给出了结果表示,我们的系统不只是简单地记忆训练集,它还能够生成 100% 的新的有效分子。此外,所有的新分子都是不同的,因为新颖性度量是 100%(生成数据集中分子的唯一百分)。图2展示了一些生成的分子。

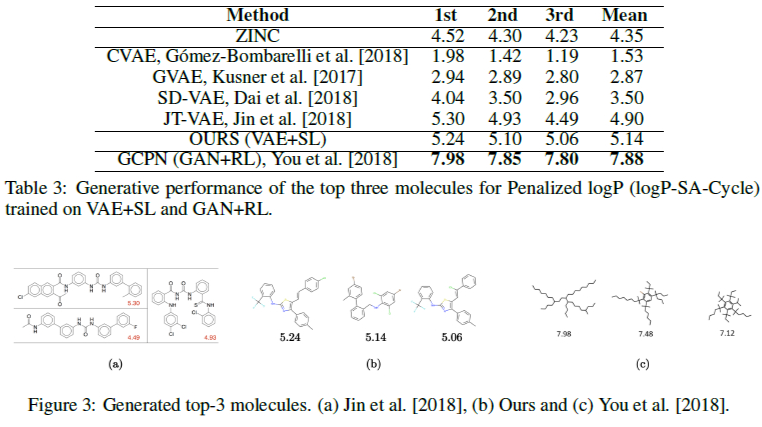

3.3 性质优化

第二个任务是生产具有理想化学性质的新分子。本文选择目标性质为辛醇-水分配系数(logP),由合成可达性(SA)评分和长循环次数惩罚。为了进行分子优化,我们训练我们的 VAE 同时自动编码训练分子和目标化学性质。

为此,我们在图形卷积编码器之后添加了一个 MLP 层来预测化学性质,并添加了一个

回归损失来惩罚不良的性质预测.

利用梯度上升法对潜在空间的化学性质进行优化,然后对分子进行解码并计算目标性质。本文对训练集中属性值排名前 100 的分子进行了优化。表 3 报告了我们的模型和文献中排名前 3 的分子。

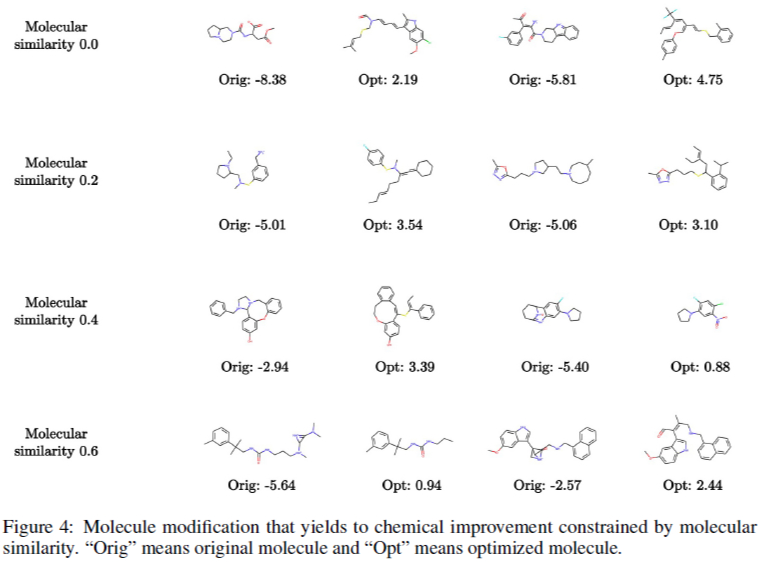

第三个任务是生成具有优化化学性质的新分子,同时约束原始分子和生成分子之间的分子相似性。在表4中报告了性能的改进和原始分子与生成分子之间的分子相似性。图4给出了约束优化的分子与分子距离。

总结

针对分子生成任务,本文引入了一种简单有效的 VAE 模型。解码器可以一次性生成分子式和键结构。据我们所知,这也是束搜索首次用于改进分子生成任务,beam 搜索可以高度并行化,就像自然语言处理系统一样,总体而言,本文提出的技术更容易实现。

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读 ,也可以是学习心得 或技术干货 。我们的目的只有一个,让知识真正流动起来。

📝 来稿标准:

• 稿件确系个人原创作品 ,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

📬 投稿邮箱:

• 投稿邮箱: hr@paperweekly.site

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

🔍

现在,在「知乎」 也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」 订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」 ,小助手将把你带入 PaperWeekly 的交流群里。