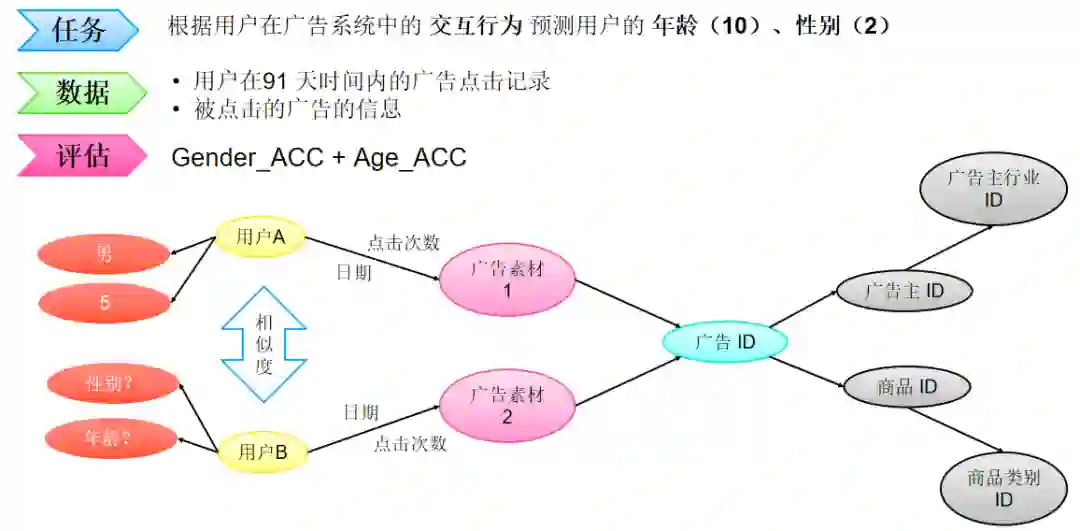

本届算法大赛的题目来源于一个重要且有趣的问题。众所周知,像用户年龄和性别这样的人口统计学特征是各类推荐系统的重要输入特征,其中自然也包括了广告平台。这背后的假设是,用户对广告的偏好会随着其年龄和性别的不同而有所区别。许多行业的实践者已经多次验证了这一假设。然而,大多数验证所采用的方式都是以人口统计学属性作为输入来产生推荐结果,然后离线或者在线地对比用与不用这些输入的情况下的推荐性能。本届大赛的题目尝试从另一个方向来验证这个假设,即以用户在广告系统中的交互行为作为输入来预测用户的人口统计学属性。

我们认为这一赛题的“逆向思考”本身具有其研究价值和趣味性,此外也有实用价值和挑战性。例如,对于缺乏用户信息的实践者来说,基于其自有系统的数据来推断用户属性,可以帮助其在更广的人群上实现智能定向或者受众保护。与此同时,参赛者需要综合运用机器学习领域的各种技术来实现更准确的预估。

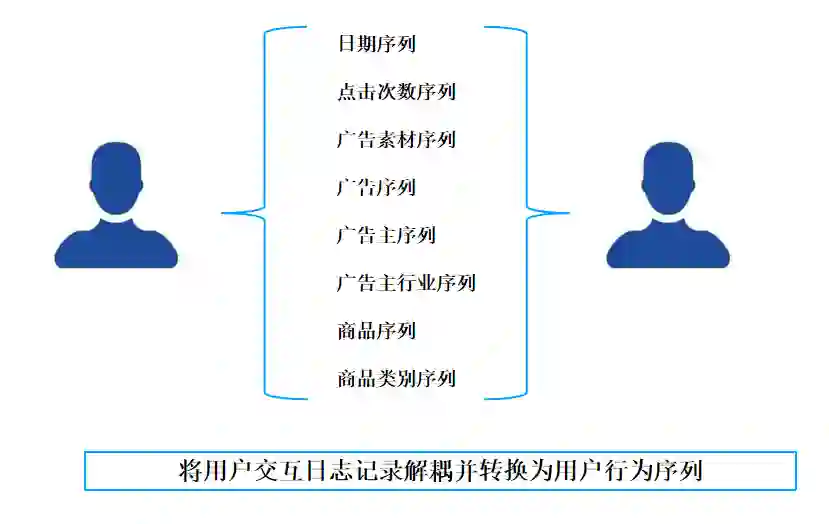

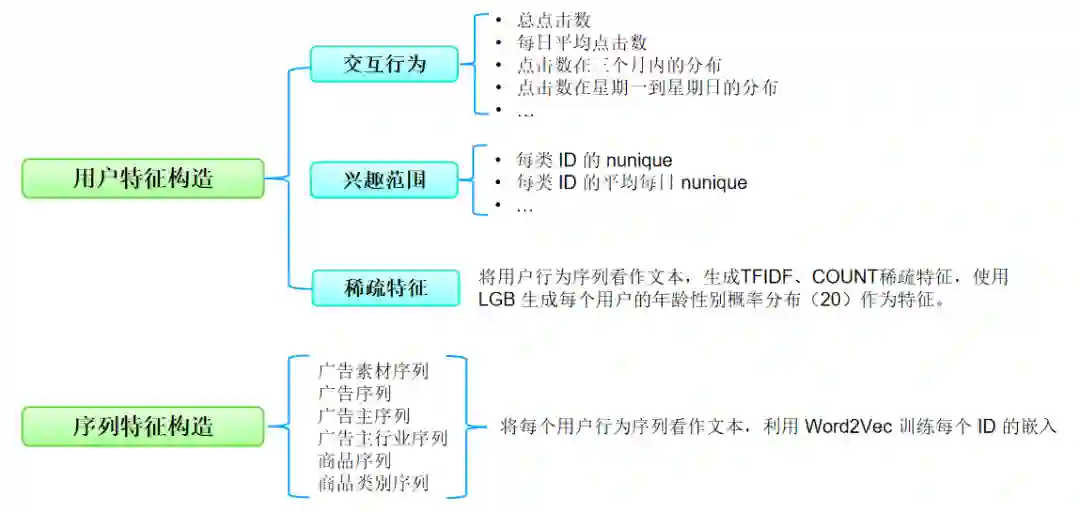

在比赛期间,主办方将为参赛者提供一组用户在长度为 91 天(3 个月)的时间窗口内的广告点击历史记录作为训练数据集。每条记录中包含了日期(从 1 到 91)、用户信息(年龄,性别),被点击的广告的信息(素材 id、广告 id、产品 id、产品类目 id、广告主id、广告主行业 id 等),以及该用户当天点击该广告的次数。测试数据集将会是另一组用户的广告点击历史记录。

提供给参赛者的测试数据集中不会包含这些用户的年龄和性别信息。本赛题要求参赛者预测测试数据集中出现的用户的年龄和性别,并以约定的格式提交预测结果。

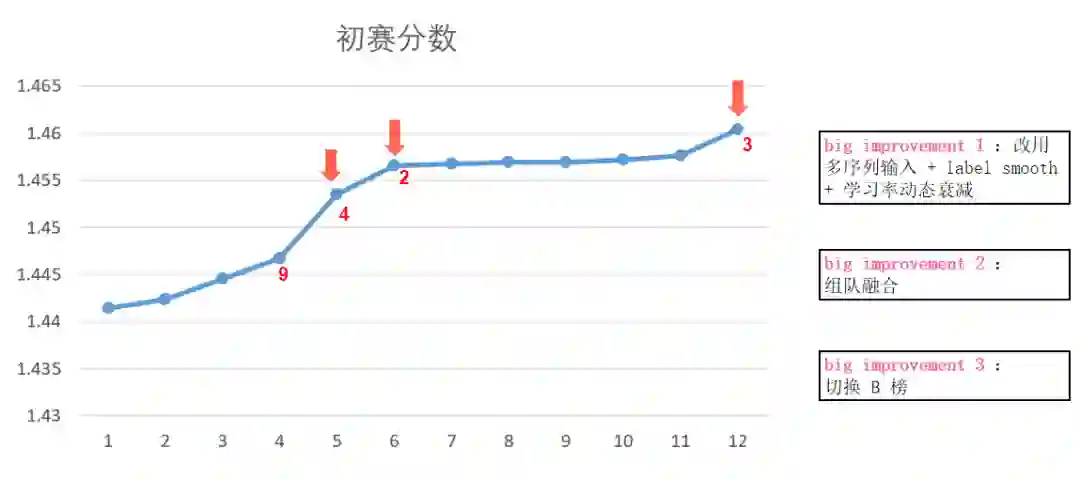

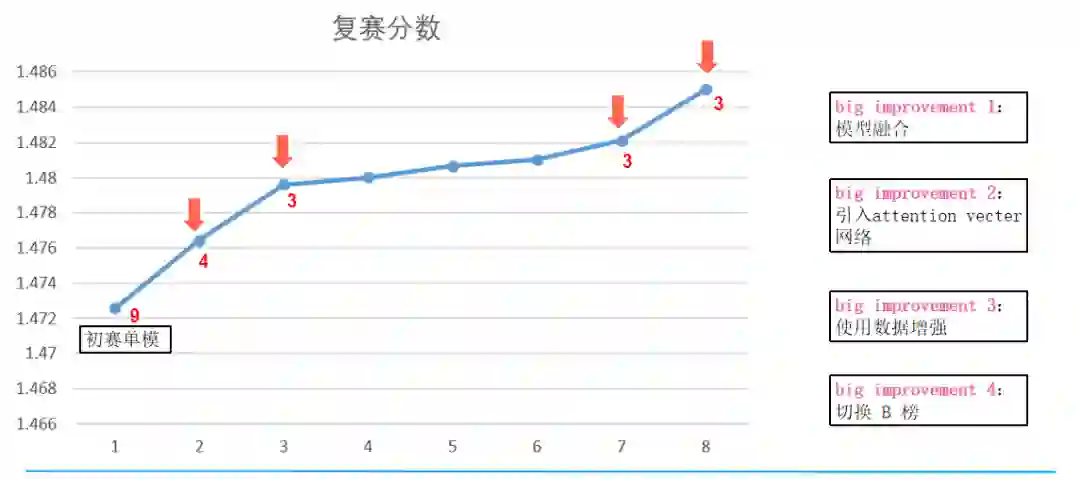

大赛会根据参赛者提交的结果计算预测的准确率(accuracy)。年龄预测和性别预测将分别评估准确率,两者之和将被用作参赛者的打分。

测试数据集会和训练数据集一起提供给参赛者。大赛会将测试数据集中出现的用户划分为两组,具体的划分方式对参赛者不可见。其中一组用户将被用于初赛和复赛阶段除最后一天之外的排行榜打分计算,另一组则用于初赛和复赛阶段最后一天的排行榜打分计算,以及最后的胜出队伍选择。

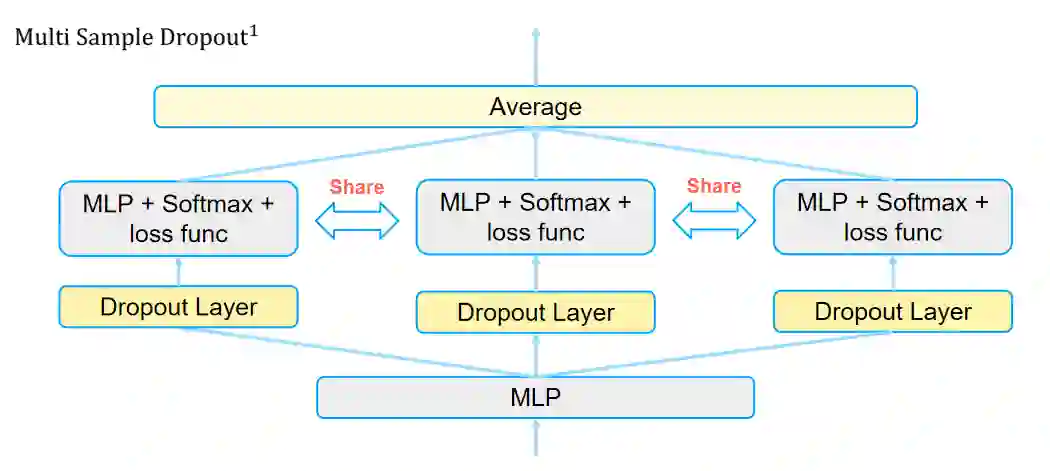

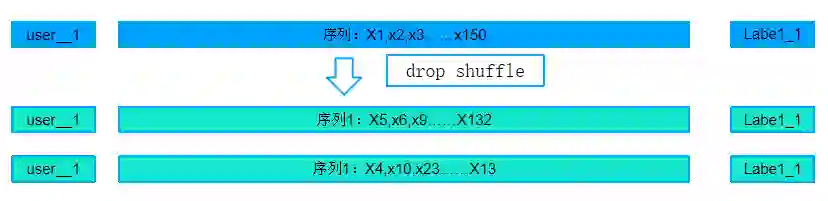

增加样本多样性,减轻过拟合现象Dropout 的概率值较为敏感

增加 Mini-batch 内多样性,在不显著增加计算成本情况下,加速模型收敛,提高模型泛化能力

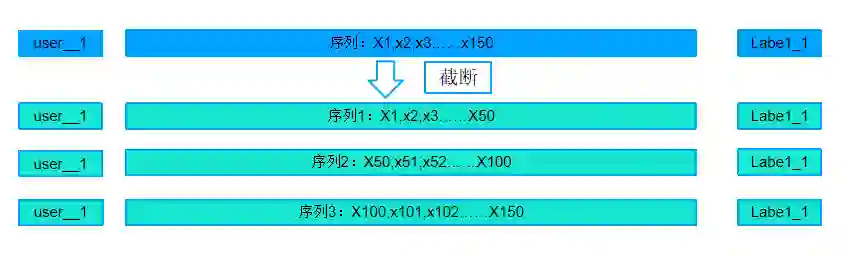

方案一:将一个用户的序列进行截断,分成多序列,增加样本数量,同时预测时候可以对一个用户预测多次,加权平均

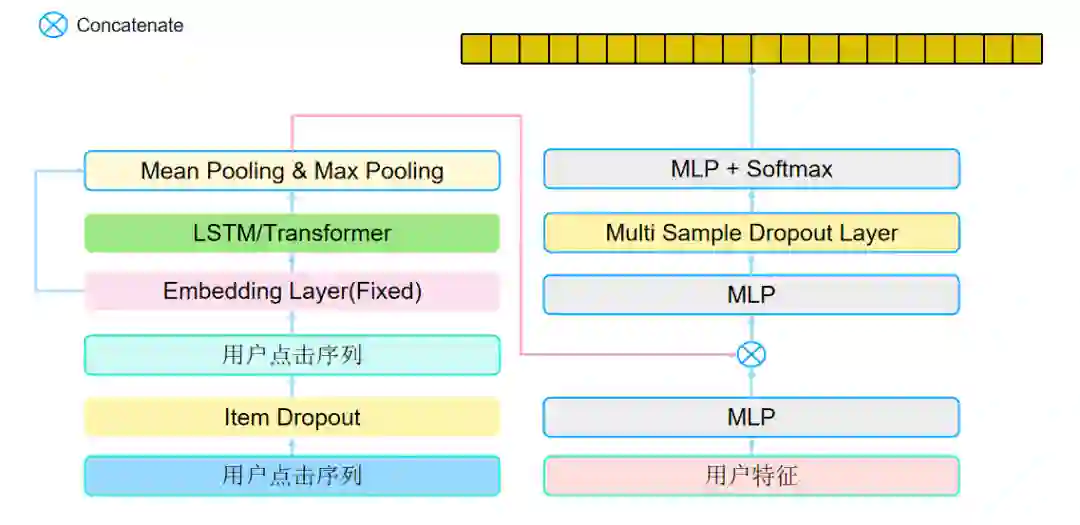

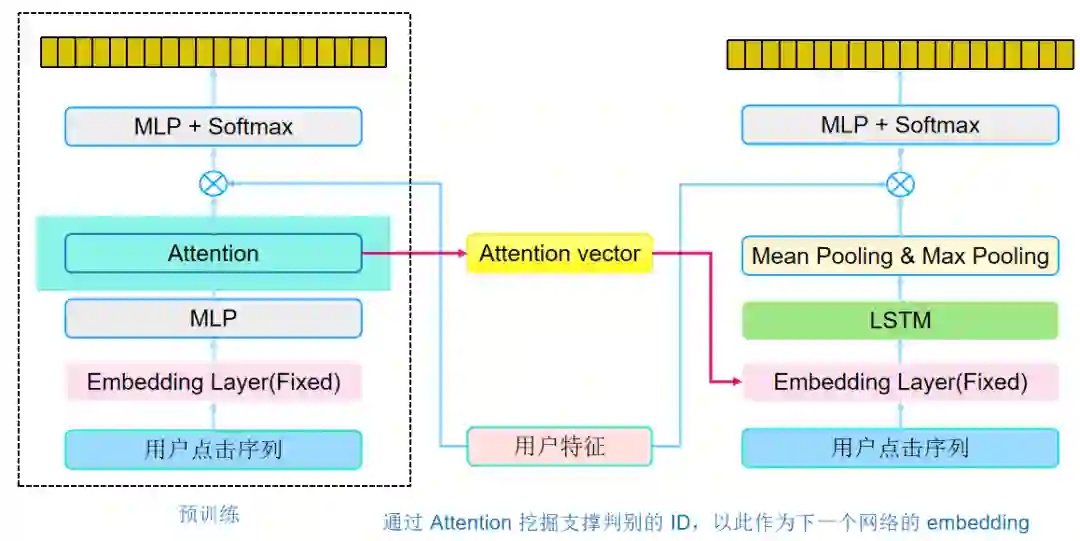

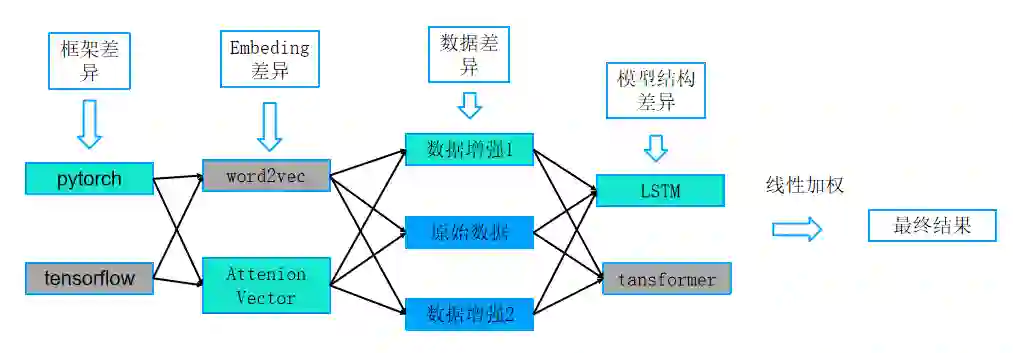

通过将每个模块的差异点,进行交叉组合,训练多个模型,再对结果进行线下加权

数据探索与处理是模型能获得强大泛化能力的基础。结合对实际业务的理解,去除异常数据,增广数据能有效的提高模型的泛化能力。

模型结构的设计是至关重要的,不仅要保证训练过程的高效率、高质量,还要保证构建的模型具有差异性;差异性模型的融合往往会收获意想不到的结果。

模型能否收敛到最优点直接决定了模型的泛化能力,优秀的训练技巧和经验可以使得模型快速地收敛到更优的值。在训练模型的过程中,尝试各种训练技巧是非常有必要的。

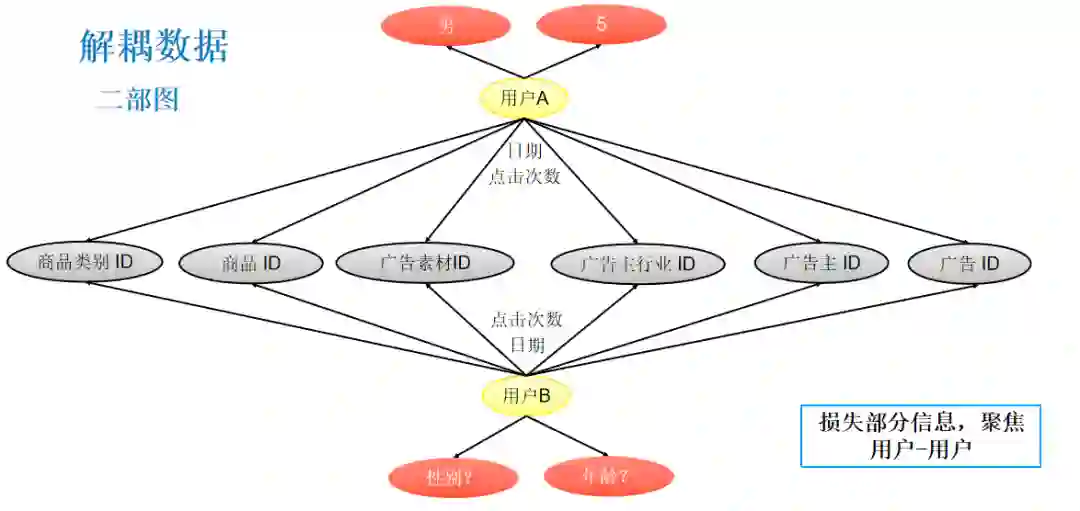

我们将人口属性预估任务转化为序列建模建模的同时,丢失了许多拓扑结构信息,如果可以将任务转化为图上的半监督学习任务,使用 GNN 对拓扑结构信息建模,相信模型的性能还会再上一层楼

进群请添加AINLP小助手微信 AINLPer(id: ainlper),备注竞赛

![]()

推荐阅读

这个NLP工具,玩得根本停不下来

征稿启示| 200元稿费+5000DBC(价值20个小时GPU算力)

完结撒花!李宏毅老师深度学习与人类语言处理课程视频及课件(附下载)

从数据到模型,你可能需要1篇详实的pytorch踩坑指南

如何让Bert在finetune小数据集时更“稳”一点

模型压缩实践系列之——bert-of-theseus,一个非常亲民的bert压缩方法

文本自动摘要任务的“不完全”心得总结番外篇——submodular函数优化

Node2Vec 论文+代码笔记

模型压缩实践收尾篇——模型蒸馏以及其他一些技巧实践小结

中文命名实体识别工具(NER)哪家强?

学自然语言处理,其实更应该学好英语

斯坦福大学NLP组Python深度学习自然语言处理工具Stanza试用

关于AINLP

AINLP 是一个有趣有AI的自然语言处理社区,专注于 AI、NLP、机器学习、深度学习、推荐算法等相关技术的分享,主题包括文本摘要、智能问答、聊天机器人、机器翻译、自动生成、知识图谱、预训练模型、推荐系统、计算广告、招聘信息、求职经验分享等,欢迎关注!加技术交流群请添加AINLPer(id:ainlper),备注工作/研究方向+加群目的。

![]()

阅读至此了,分享、点赞、在看三选一吧🙏