【ICML2020】深度神经网络置信感知学习

题目:

Confidence-Aware Learning for Deep Neural Networks

简介:

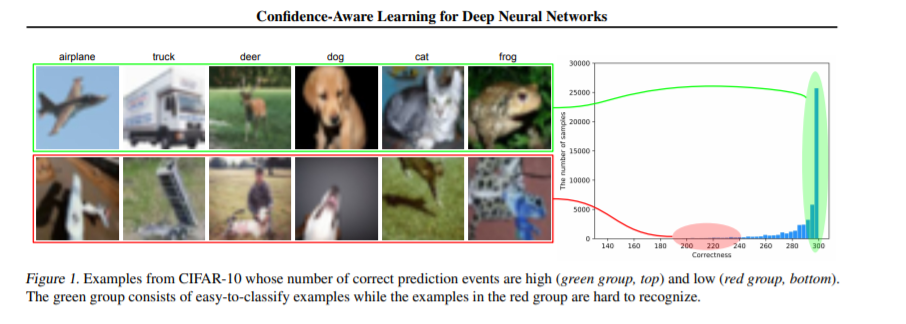

尽管深度神经网络可以执行多种任务,但过分一致的预测问题限制了它们在许多安全关键型应用中的实际应用。已经提出了许多新的工作来减轻这个问题,但是大多数工作需要在训练和/或推理阶段增加计算成本,或者需要定制的体系结构来分别输出置信估计。在本文中,我们提出了一种使用新的损失函数训练深度神经网络的方法,称为正确排名损失,该方法将类别概率显式规范化,以便根据依据的有序等级更好地进行置信估计。所提出的方法易于实现,并且无需进行任何修改即可应用于现有体系结构。而且,它的训练计算成本几乎与传统的深度分类器相同,并且通过一次推断就可以输出可靠的预测。在分类基准数据集上的大量实验结果表明,所提出的方法有助于网络产生排列良好的置信度估计。我们还证明,它对于与置信估计,分布外检测和主动学习密切相关的任务十分有效。

https://arxiv.org/pdf/2007.01458.pdf

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“CADN” 可以获取《ICML2020深度神经网络置信感知学习》专知下载链接索引

登录查看更多