作为强化学习领域的经典导论性教材,第 2 版《强化学习》中文版从强化学习基本思想出发,深入浅出又严谨细致地介绍了马尔可夫决策过程、蒙特卡洛方法、时序差分方法、同轨离轨策略等强化学习的基本概念和方法,并以大量的实例帮助读者理解强化学习的问题建模过程以及核心的算法细节。

自强化学习教父 Richard Sutton 的经典教材《Reinforcement Learning:An Introduction》出版的 20 年以来,在机器学习 (包括强化学习) 前沿技术发展的推动下,人工智能取得了重大进展。这些进展不仅归功于这些年迅猛发展起来的计算机强大的计算能力,也受益于许多理论和算法上的创新。

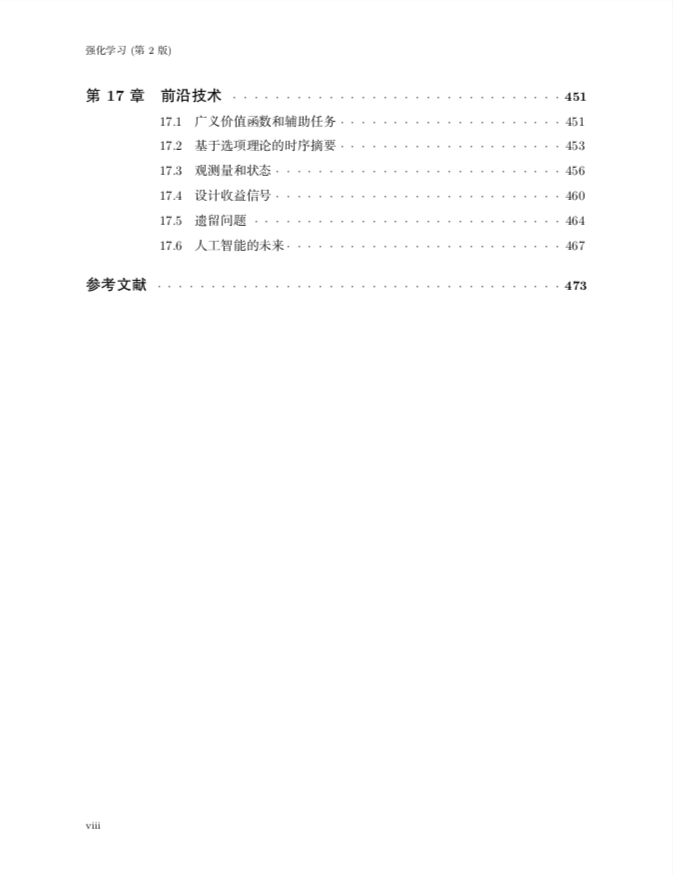

去年,《Reinforcement Learning:An Introduction》第 2 版完成了,这本书的中文版本近日也已在京东平台上架。该书分为三大部分,共十七章,机器之心对其内容和框架做了简要介绍,并为强化学习爱好者们送出 20 本作为读者福利(见文末)。

当然读者们也可以看看 Sutton 原版的书籍主页,它包含了 PDF、课程代码和资料等众多开放资源。

原版书籍主页:http://incompleteideas.net/book/the-book.html

作为强化学习思想的深度解剖之作,《Reinforcement Learning:An Introduction》被业内公认为是一本强化学习基础理论的经典著作。

![]()

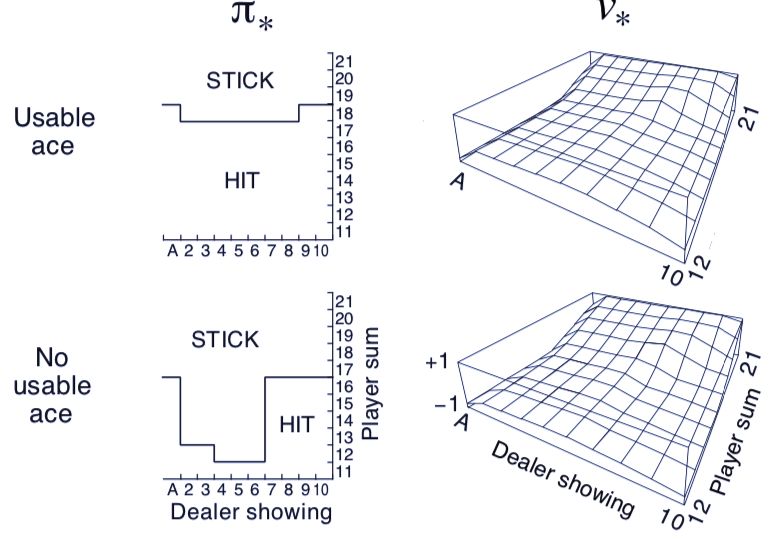

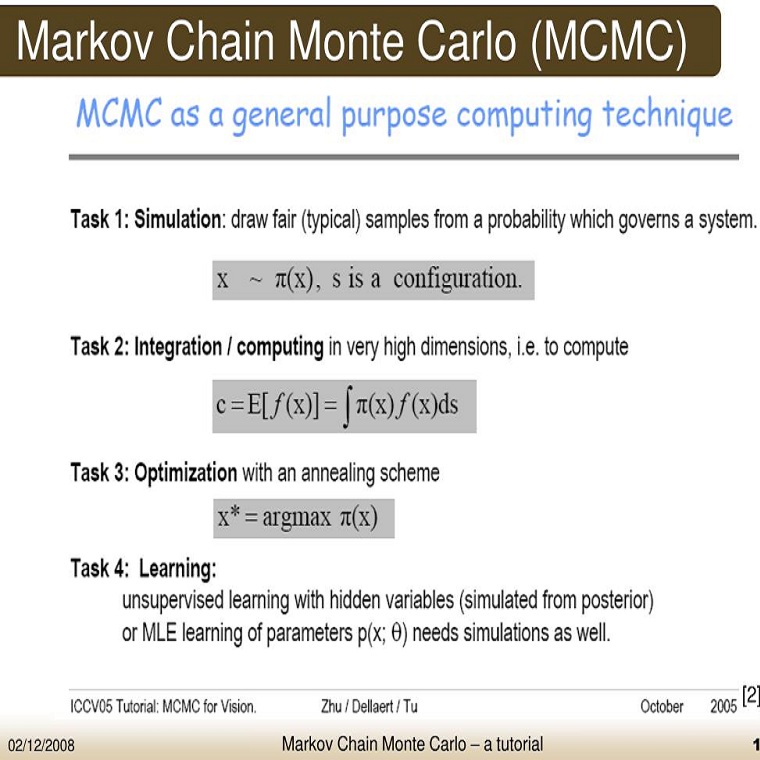

第 2 版中,它从强化学习的基本思想出发,深入浅出又严谨细致地介绍了马尔可夫决策过程、蒙特卡洛方法、时序差分方法、同轨离轨策略等强化学习的基本概念和方法,并以大量的实例帮助读者理解强化学习的问题建模过程以及核心的算法细节。

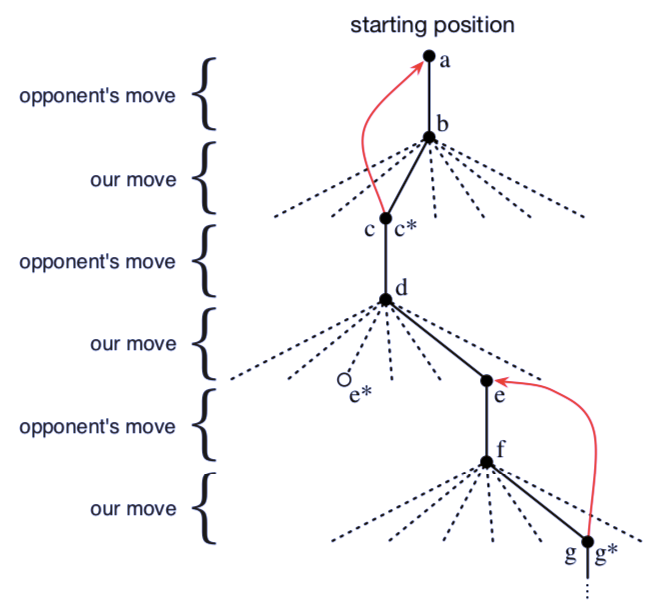

基于强化学习近来的蓬勃发展,作者补充了很多新的内容:人工神经网络、蒙特卡洛树搜索、平均收益最大化等,涵盖了当今最关键的核心算法和理论。不仅如此,作者还以真实世界的应用为例阐述了这些内容。

「思想总是走在行动的前面,就好像闪电总是走在雷鸣之前。」德国诗人海涅的诗句恰如其分地描述了译者余凯第一次读到本书英文原版时的感受。本书的两位作者 Richard S. Sutton 和 Andrew G. Barto 就是这样的思想先行者,而本书所介绍的「强化学习」,则是后深度学习时代技术发展的重要火种之一。

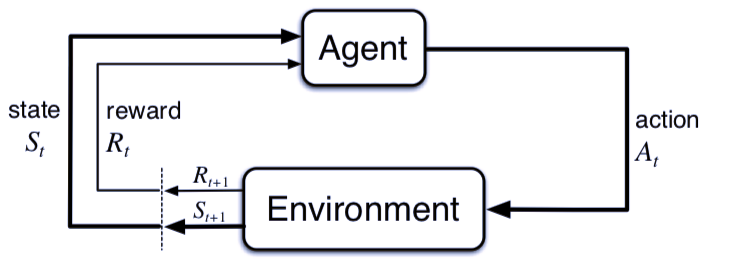

当一个婴儿玩耍时,挥舞手臂,左顾右盼,旁边没有老师指导他,他与环境却有着一种直接的感知连接。通过这种连接,他懂得了因果关系,行动带来的结果,以及为了达成目标所需做的一切。

人的一生中,这样的交互成了我们关于环境和自身知识的主要来源。不管学习驾驶汽车,还是进行一场交谈,实际上我们自始至终观察着环境如何回应我们的所为,并通过自身行为影响当下情景。

我们将这一方法称之为「强化学习」。相较于其他机器学习方法,它更专注于交互之中的目标导向性学习。

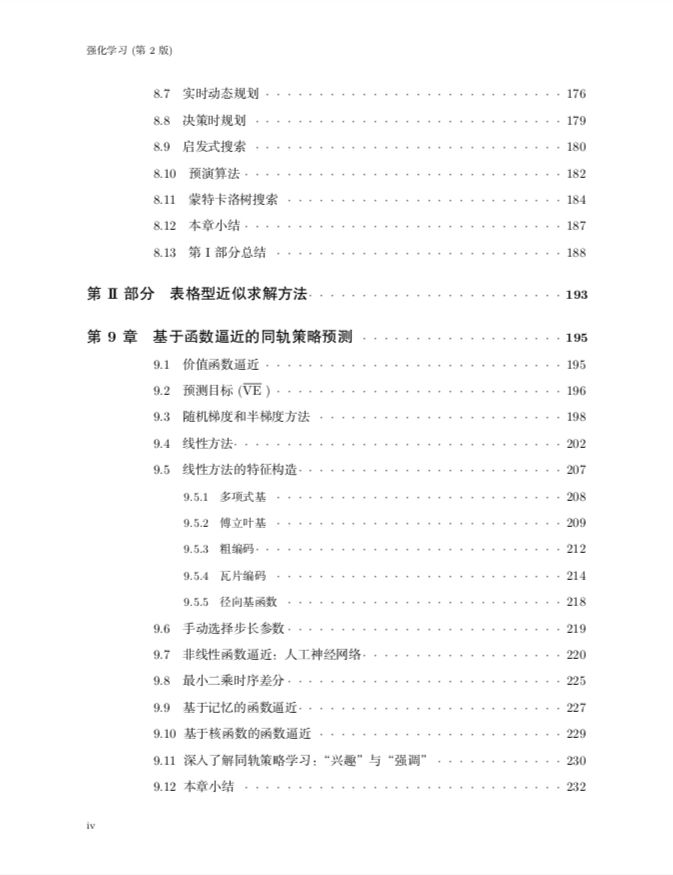

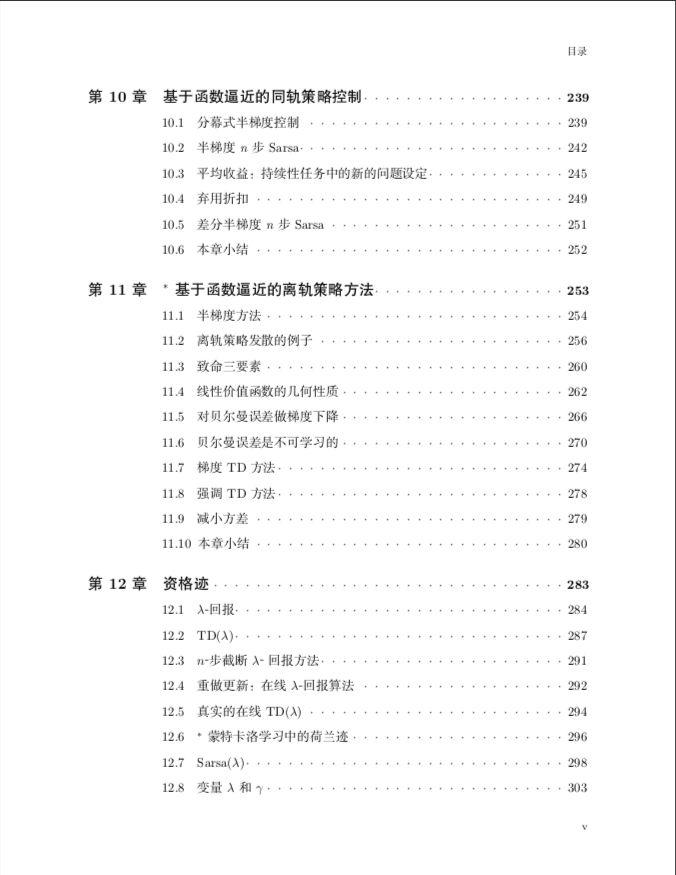

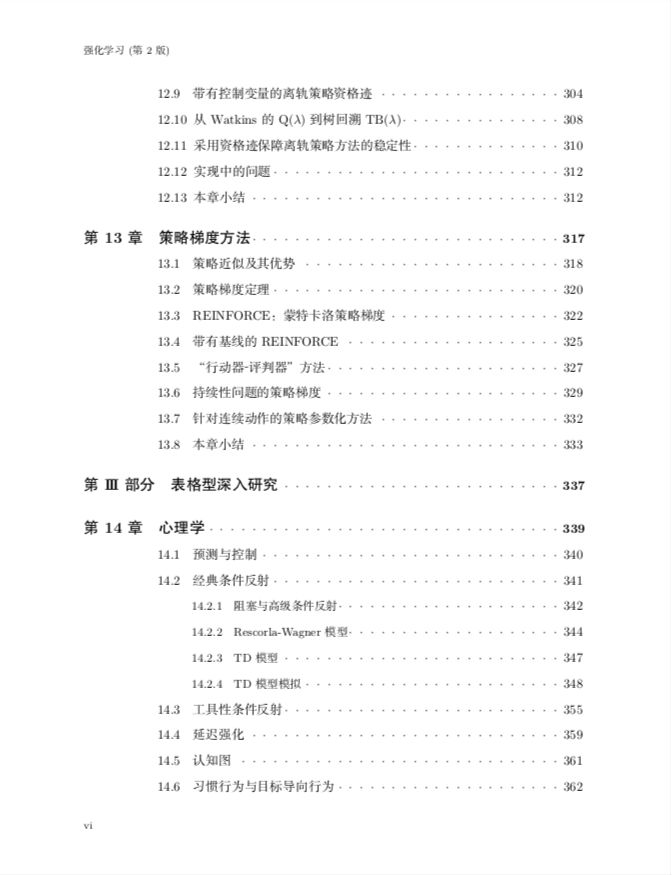

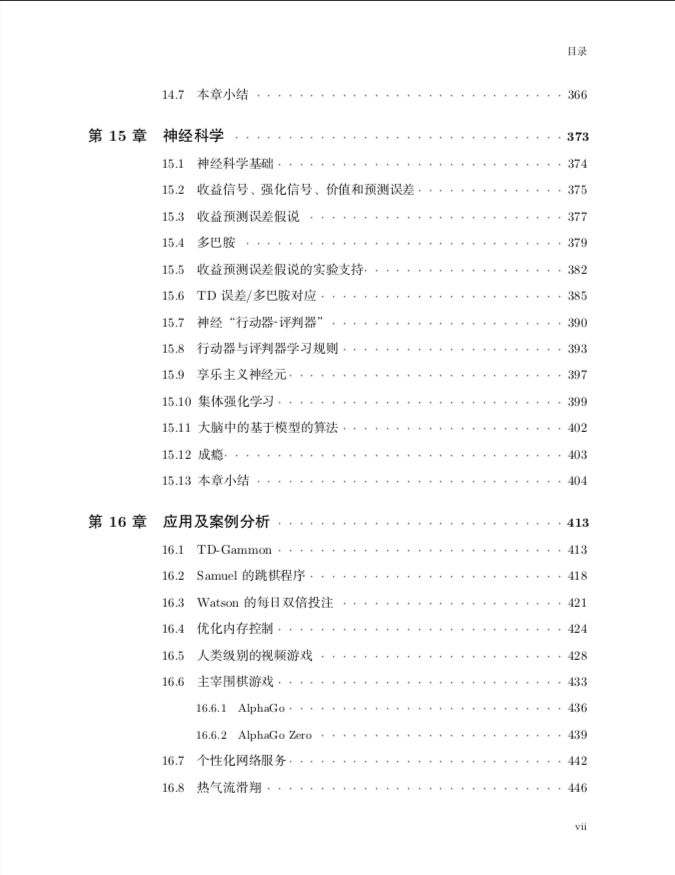

第 2 版在原先的基础上进行了许多拓展,整体结构也有所变化。本书包含三部分内容:

第一部分以最简单形式描述了强化学习算法几乎所有的核心的概念;

第二部分扩展了第一部分中介绍的列表法以应用于任意大的状态空间;

第三部分简单地概述了强化学习和心理学以及神经科学的关系,讨论了一个强化学习应用的采样过程,和一些未来的强化学习研究的活跃前沿。

![]()

埃德蒙顿(DeepMind)公司杰出科学家,阿尔伯塔大学计算科学系教授。他于 2003 年加入阿尔伯塔大学,2017 年加入 DeepMind。在此之前,他曾在美国电话电报公司(AT&T)和通用电话电子公司(GTE)实验室工作,以及在马萨诸塞大学做学术研究。

理查德•萨顿于 1978 年在斯坦福大学获得心理学学士学位,1984 年获得马萨诸塞大学计算机科学博士学位,加拿大皇家学会院士和人工智能促进会的会士。他的主要研究兴趣在于决策者与环境相互作用时所面临的学习问题,他认为这是智能的核心问题。其他研究兴趣有:动物学习心理学、联结主义网络,以及能够不断学习和改进环境表征和环境模型的系统。

他被称为「强化学习教父」,同时也是自由主义者、国际象棋选手和癌症幸存者。

![]()

马萨诸塞大学阿默斯特分校信息与计算机科学学院名誉教授。安德鲁•巴图 1970 年获得密歇根大学数学专业的杰出学士学位,并于 1975 年获该校计算机科学专业的博士学位,1977 年加入马萨诸塞州阿默斯特大学计算机科学系。在 2012 年退休之前,他带领了马萨诸塞大学的自主学习实验室,该实验室培养了许多著名的机器学习研究者。

目前担任 Neural Computation(《神经计算》)期刊的副主编,Journal of Machine Learning Research(《机器学习研究》)期刊的顾问委员会成员,以及 Adaptive Behavior(《自适应行为》)期刊的编委员会成员。2004 年,安德鲁•巴图因强化学习领域的贡献荣获 IEEE 神经网络学会先锋奖,并因在强化学习理论和应用方面的开创、富有影响力的研究获得 IJCAI-17 卓越研究奖,2019 年获得马萨诸塞大学神经科学终身成就奖。

![]()

上海交通大学计算科学与工程系教授,思必驰公司创始人、首席科学家。清华大学自动化系本科、硕士,剑桥大学工程系博士。青年千人,国家自然科学基金委优青,上海市「东方学者」特聘教授。曾获得 2014「吴文俊人工智能科学技术奖」进步奖,「2016 科学中国人年度人物」,2018 中国计算机学会「青竹奖」等个人荣誉。

俞凯长期从事交互式人工智能,尤其是智能语音及自然语言处理的研究和产业化工作。发表国际期刊和会议论文 150 余篇,获得 Computer Speech and Language、Speech Communication 等多个国际期刊及 InterSpeech 等国际会议的最优论文奖,所搭建的工程系统曾获美国国家标准局语音识别评测冠军,对话系统国际研究挑战赛冠军等。

![]()

![]()

![]()

http://incompleteideas.net/book/the-book.html

https://item.jd.com/12696004.html

https://book.douban.com/subject/34809689/

获赠方式:请留言说出你对强化学习的理解,点赞量最高的前 20 名读者将获得赠书。

✄------------------------------------------------

加入机器之心(全职记者 / 实习生):hr@jiqizhixin.com

投稿或寻求报道:content@jiqizhixin.com

广告 & 商务合作:bd@jiqizhixin.com