B站学强化学习?港中文周博磊变身up主,中文课程已上线

机器之心编辑部

众所周知,B 站是一个学习网站。 在看完罗翔老师的刑法课之后,是时候探索人工智能了。

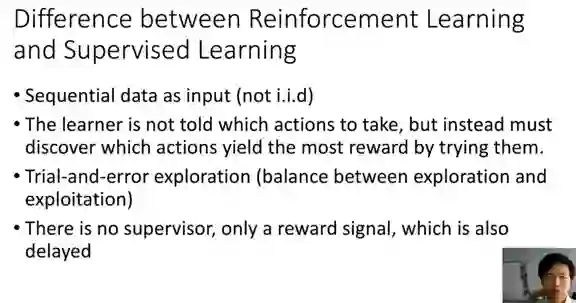

输入数据时序相关(非独立同分布);

智能体并不知道什么是正确的策略,其策略需要通过从环境得到的奖赏值中自行习得;

通过试错进行探索(强化学习里非常经典的探索与利用(exploration and exploitation)问题);

训练过程中没有严格的标签,学习信号仅为奖赏值(往往还是延迟的奖赏)。

Pieter Abbeel 个人主页:https://people.eecs.berkeley.edu/~pabbeel/

Sergey Levine 个人主页:https://people.eecs.berkeley.edu/~svlevine/

OpenAI Spinning Up :从 VPG(Vanilla Policy Gradient) 到 TRPO(Trust Region Policy Optimization)、SAC(Soft Actor-Critic) 均有实现,关键是 OpenAI 出品,代码质量高。

资源链接:https://openai.com/blog/spinning-up-in-deep-rl/

Stable Baselines:大量深度强化学习算法优质实现,文档丰富,包含 Colab Notebook,深度强化学习入坑必看 repo。

资源链接:https://stable-baselines.readthedocs.io/en/master/

登录查看更多

相关内容

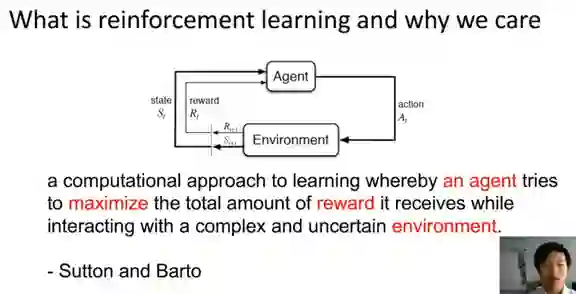

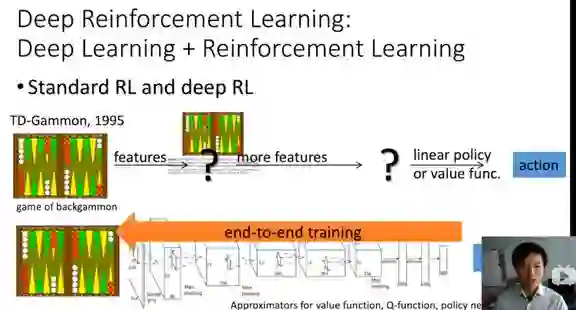

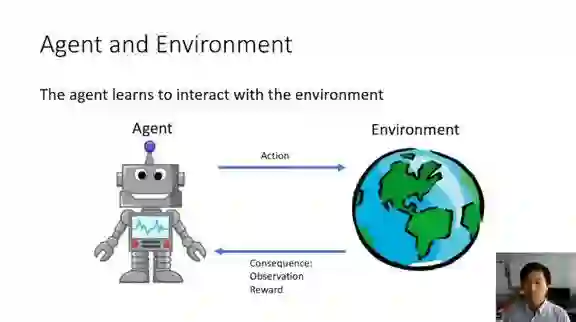

强化学习(RL)是机器学习的一个领域,与软件代理应如何在环境中采取行动以最大化累积奖励的概念有关。除了监督学习和非监督学习外,强化学习是三种基本的机器学习范式之一。

强化学习与监督学习的不同之处在于,不需要呈现带标签的输入/输出对,也不需要显式纠正次优动作。相反,重点是在探索(未知领域)和利用(当前知识)之间找到平衡。

该环境通常以马尔可夫决策过程(MDP)的形式陈述,因为针对这种情况的许多强化学习算法都使用动态编程技术。经典动态规划方法和强化学习算法之间的主要区别在于,后者不假设MDP的确切数学模型,并且针对无法采用精确方法的大型MDP。

Arxiv

11+阅读 · 2019年10月30日