来自谷歌的研究团队提出了一种 3D 视觉体验生成新方法 Infinite Nature,仅用一张自然景观图片就能生成该场景的高质量 3D 「航拍」视频。

![]()

![]()

怎么样,是不是体会到飞鸟的快乐了?但你能想象吗,这些景观视频全部都是计算机合成的!

为了构建沉浸式的虚拟现实体现,近几年人们开始思考计算机如何合成细节丰富的三维视觉体验。来自谷歌的研究团队近日做了一项名为「Infinite Nature」的研究工作,该研究表明计算机可以通过观看自然视频和照片来学习生成丰富的 3D 视觉体验。新模型 InfiniteNature-Zero 甚至可以仅在静态照片上训练,以单张图像作为「种子」,生成高分辨率、高质量的景观视频,这是前所未有的突破性能力。

项目主页:https://infinite-nature-zero.github.io/

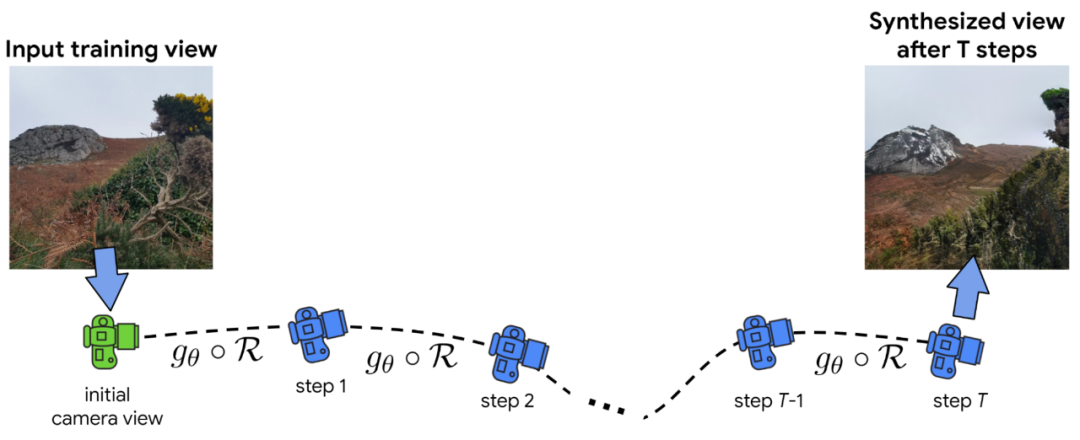

谷歌将主要研究问题称为「永久型视图生成(perpetual view generation)」,即给定场景的单个输入视图,按照给定的相机路径,合成照片级真实的输出视图集。这一任务非常具有挑战性,因为系统必须为输入图像上的大型地标(例如山脉)的另一侧生成新内容,并以高逼真度和高分辨率渲染新内容。

下图是使用 InfiniteNature-Zero 生成的飞行效果示例:仅输入单个自然场景图像,模型运行时就能生成「飞入」该场景的新内容,体验非常真实。

该研究首先收集了一组沿海岸线飞行的无人机拍摄的在线视频,最初的想法是学习合成类似于这些真实视频的新飞行视频。这组收集到的在线视频称为 ACID 数据集(Aerial Coastline Imagery Dataset)。

研究者发现,为了学会合成动态响应任何 3D 相机路径的场景,不能简单地将这些视频视为像素的原始集合——还必须计算它们底层的 3D 几何图形,包括每帧的相机位置。

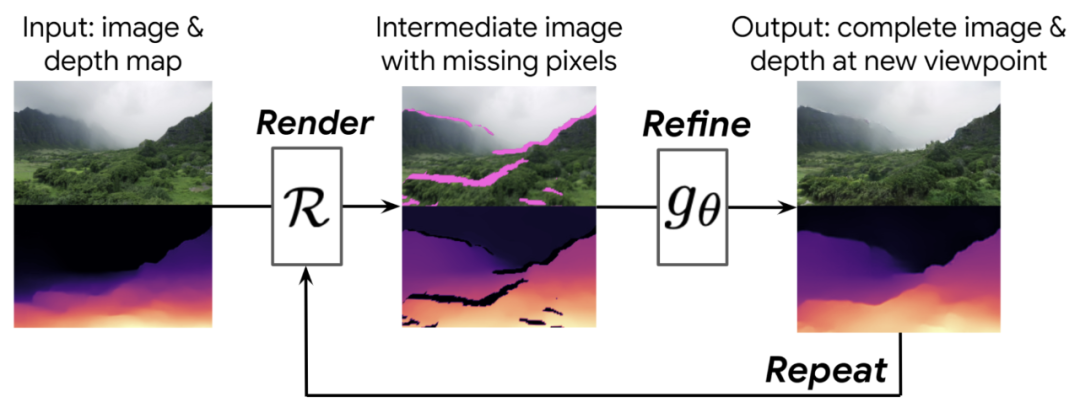

给定一个起始视图,该研究首先要使用单图像深度预测方法计算深度图,然后再使用该深度图将图像向前渲染到新的相机视点,从新视点生成新图像和深度图。

该研究构建了一个神经图像细化网络,采用低质量的中间图像(缺失部分像素),输出一个完整的、高质量的图像和相应的深度图,并将新的合成图像作为输入图像多次重复上述步骤。由于该研究同时优化了图像和深度图,所以这个过程可以根据需要重复多次——当相机进一步进入场景时,系统会自动学习生成新的风景,包括山脉、岛屿和海洋等。

![]()

该研究使用使用 ACID 数据集来训练这种渲染 - 优化 - 重复的合成方法。具体来说,该研究从数据集中采样视频,再从视频中采样一帧,然后使用上述方法渲染几个新的视图,沿着与地面实况视频相同的摄像机轨迹移动到场景中,并将这些渲染帧与相应的地面实况视频帧进行比较,以得出训练信号。其中还包括一个对抗性设置,它试图将合成帧与真实图像区分开来,旨在让生成的图像看起来更真实。Infinite Nature 方法可以合成任何相机轨迹对应的视图。

具体而言,整个研究中最核心的问题是:如何从静态图像生成场景视频?

为了解决这个问题,该研究提出一个关键的思路:如果我们拍摄一张图像并渲染一个循环的相机路径,即最后一张图像与第一张图像来自相同的视点,那么沿着这条路径最后合成的图像应该与输入图像相同。这种循环一致性提供了一个训练约束,帮助模型在视图生成的每个步骤中学习填充缺失的区域并提高图像分辨率。

然而,使用相机周期进行训练不足以生成长而稳定的视图序列,因此该研究在原始工作中包含了一种对抗策略,考虑长的、非循环的相机路径,如下图所示。

如果从起始帧开始渲染 T 帧,该研究会优化上述「渲染 - 优化 - 重复」模型,使得判别器网络无法分辨哪个是起始帧,哪个是最终合成帧。最后,该研究还添加了一个经过训练的组件,以生成高质量、高真实感的合成图像。

与之前的视频合成方法相比,Infinite Nature 方法的生成结果在内容的质量和多样性方面显著提高。此外,这种方法还允许用户交互控制摄像机,并生成更长的相机路径。

https://ai.googleblog.com/2022/11/infinite-nature-generating-3d.html

2022 NeurIPS China Meetup

2022 NeurIPS Meetup China 将设置 Keynote、圆桌论坛、论文分享、 Poster 展示、企业招聘等环节,邀请顶级专家、论文作者与现场参会观众共同交流。

本次活动免费,欢迎大家点击「

阅读原文」

报名,我们将在审核后反馈报名结果。

同时

欢迎论文作者作为嘉宾参与论文分享与 Poster 展示,请在报名页面提交演讲主题、论文介绍等信息,我们将与你联系沟通相关事宜。

![]()

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com