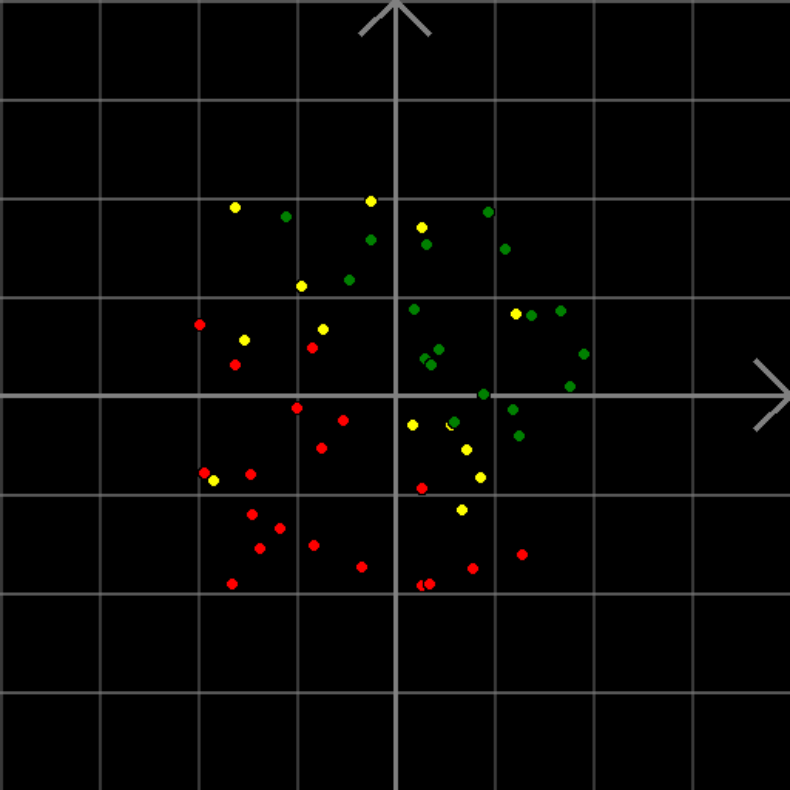

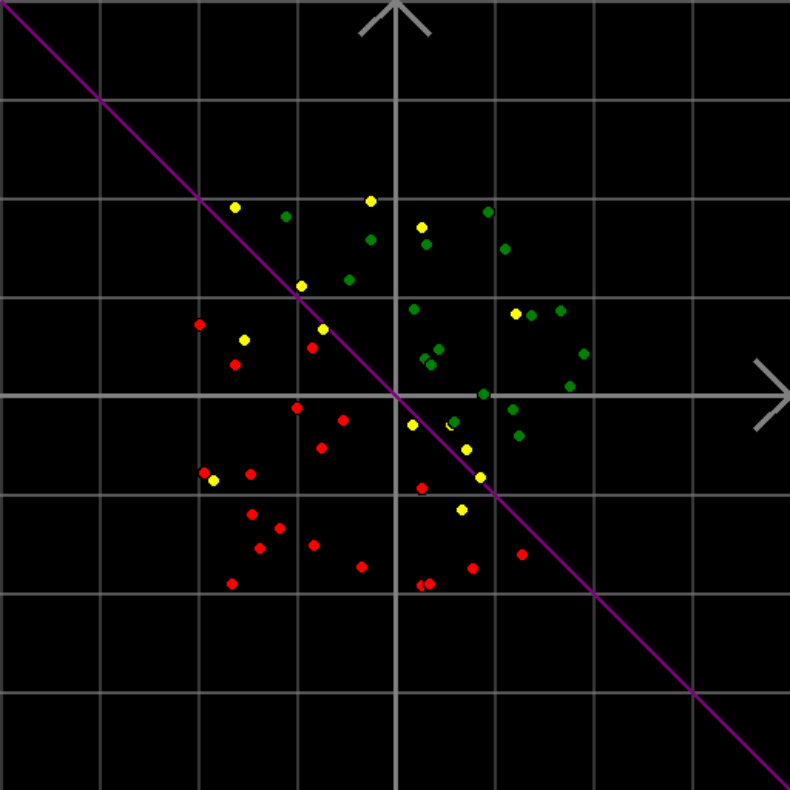

透过现象看本质,图解支持向量机

选自towardsdatascience

作者:Rohit Pandey

机器之心编译

参与:魔王、张倩

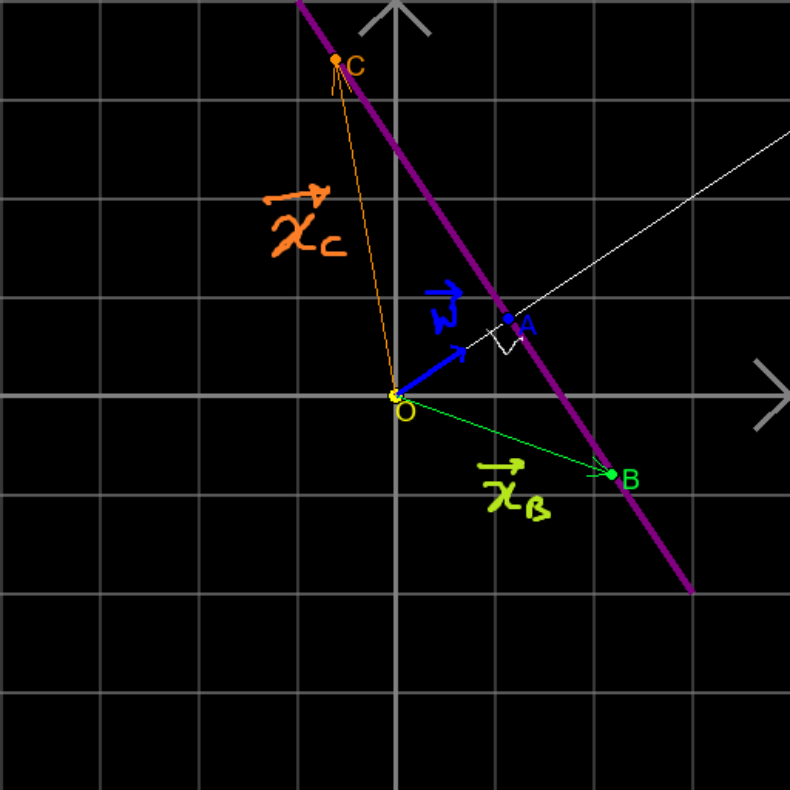

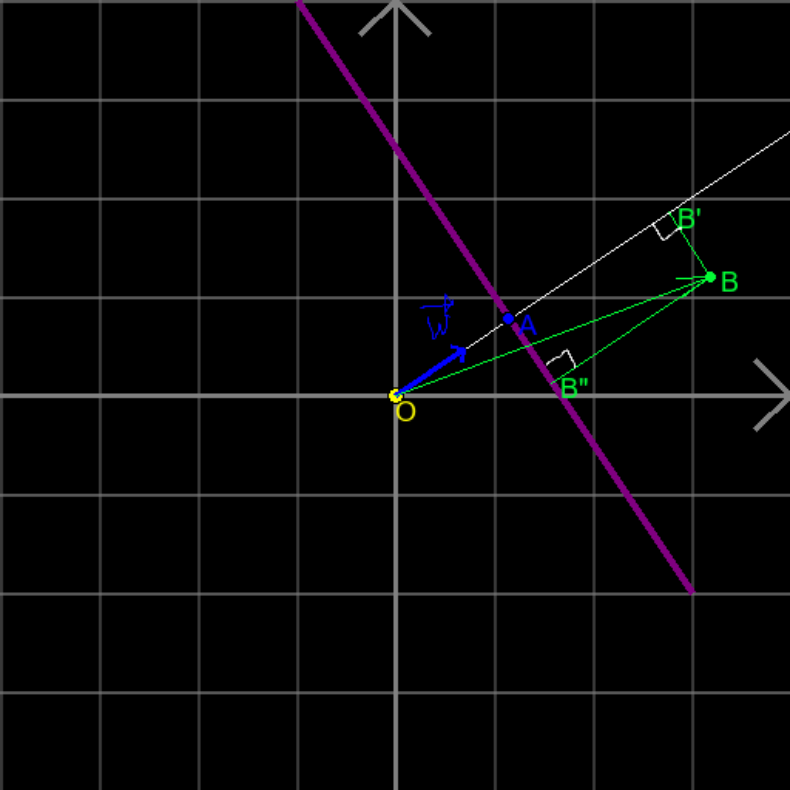

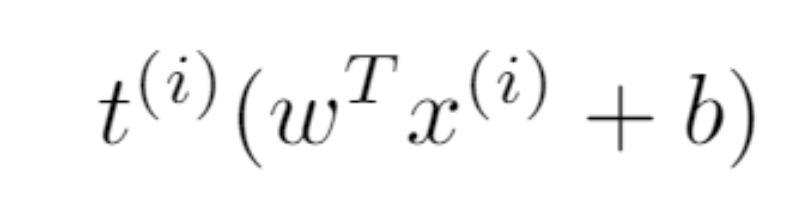

作者说:我以前一直没有真正理解支持向量机,直到我画了一张图。

基于图像的像素数据,判断这张图像中是否有猫(有猫则标签为正类);

基于邮件的主题、发送者、文本等,判断该邮件是否为垃圾邮件;

判断某个病人是否患有某种疾病。

博客地址:https://towardsdatascience.com/lagrange-multipliers-with-pictures-and-code-ace8018dac5e

吴恩达文章地址:http://cs229.stanford.edu/notes/cs229-notes3.pdf

登录查看更多

相关内容

Arxiv

3+阅读 · 2018年4月28日

Arxiv

5+阅读 · 2018年2月3日

Arxiv

4+阅读 · 2018年1月23日