从特征融合的视角设计图神经网络的拓扑结构

论文标题:

Designing the Topology of Graph Neural Networks: A Novel Feature Fusion Perspective

https://arxiv.org/pdf/2112.14531.pdf

https://github.com/AutoML-Research/F2GNN

该论文已经被国际顶级数据挖掘会议 WebConf 2022 (CCF-A)接收,欢迎大家关注。如有任何问题,欢迎联系 weilanning18z@ict.ac.cn。该论文第一作者卫岚宁是第四范式的研究实习生。

简介

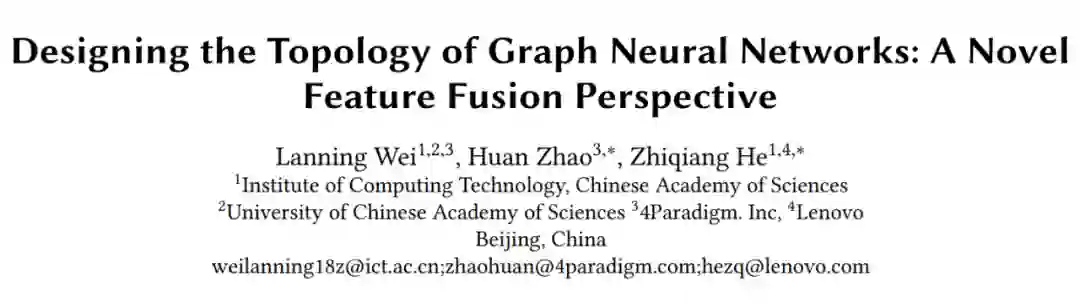

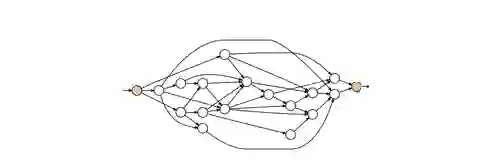

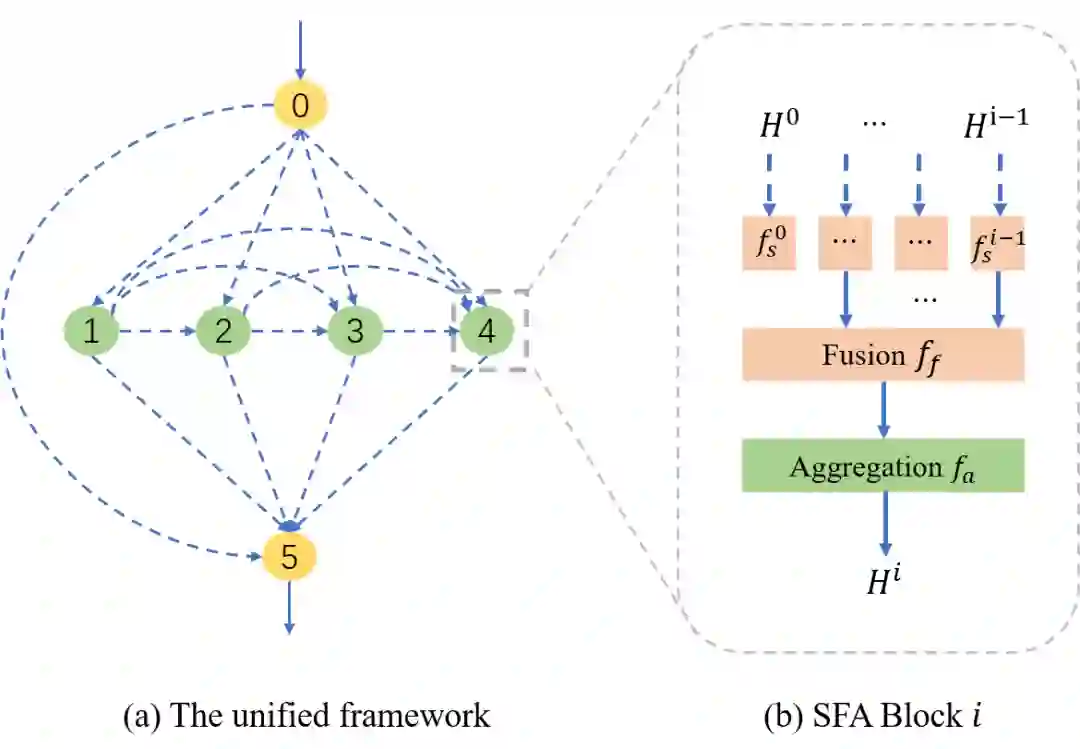

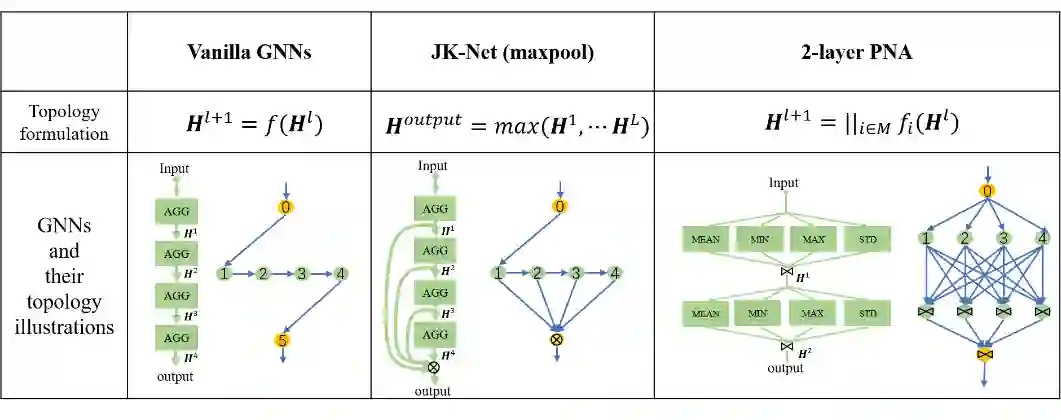

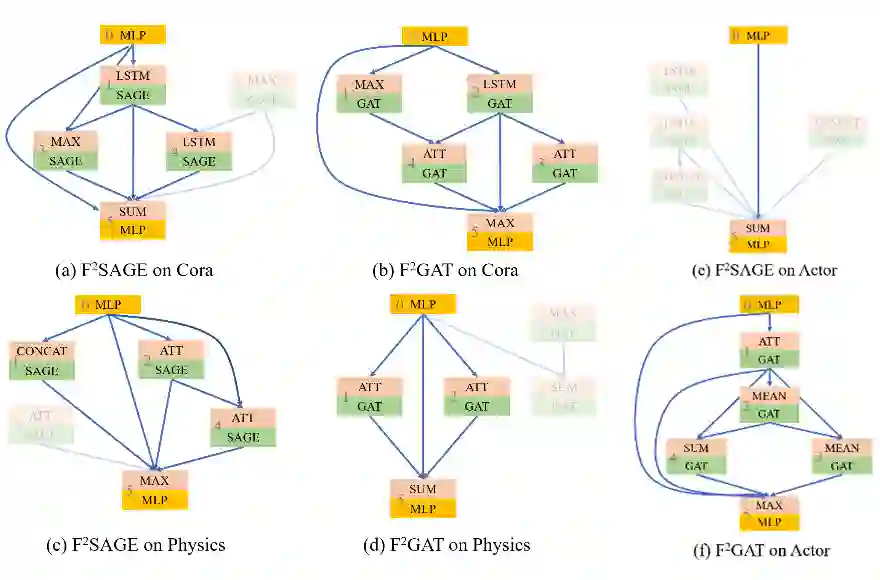

▲ 图1:两种拓扑结构设计示意图。左侧为基于堆叠的模式,右侧为基于多分支的模式。

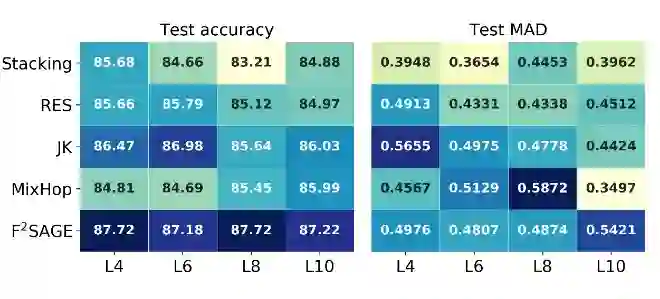

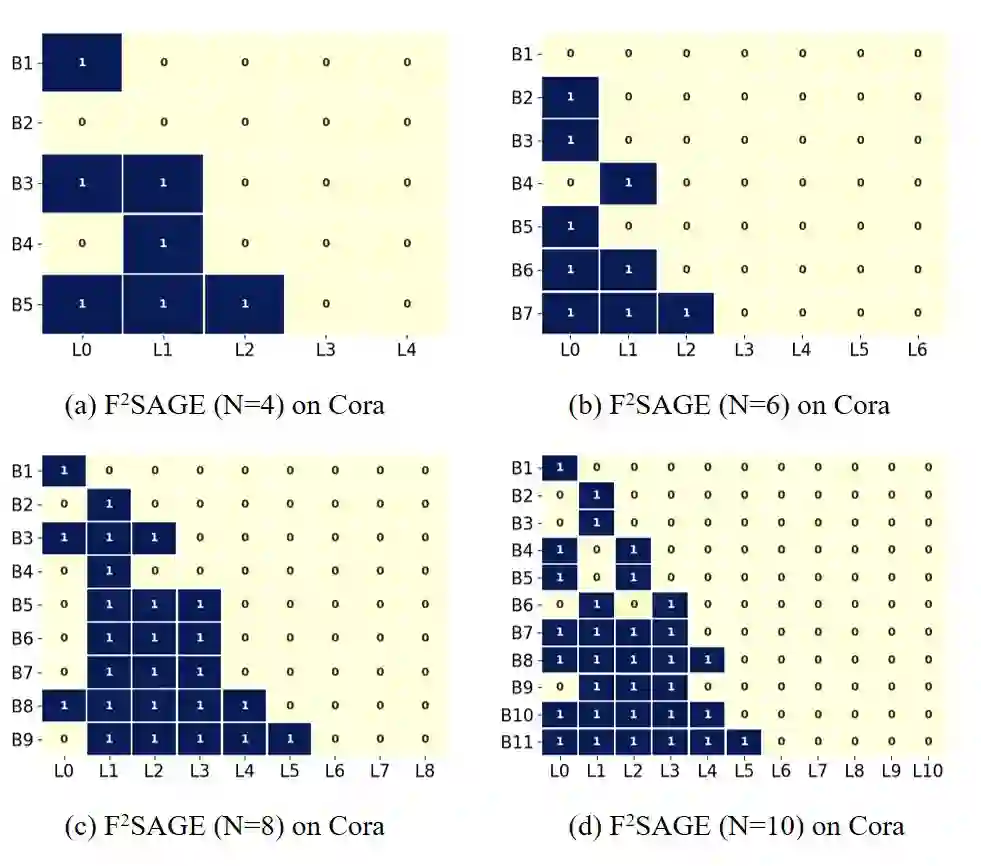

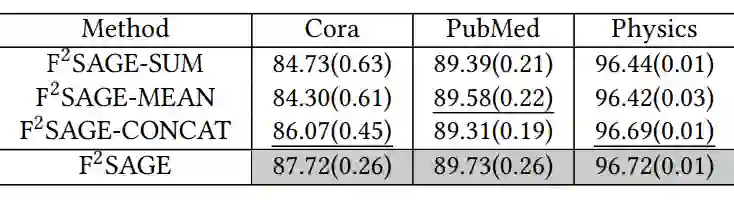

登录查看更多