近期必读 ICLR 2021 【模型压缩】&【预训练】相关论文】

导读

上一期我们精选了ICLR2021中【NLP】话题的论文,为大家带来了论文解读。

本期的关注焦点是【模型压缩】&【预训练】的7篇论文。点击文末“阅读原文”,获取正在接受盲审的论文列表。

模型压缩

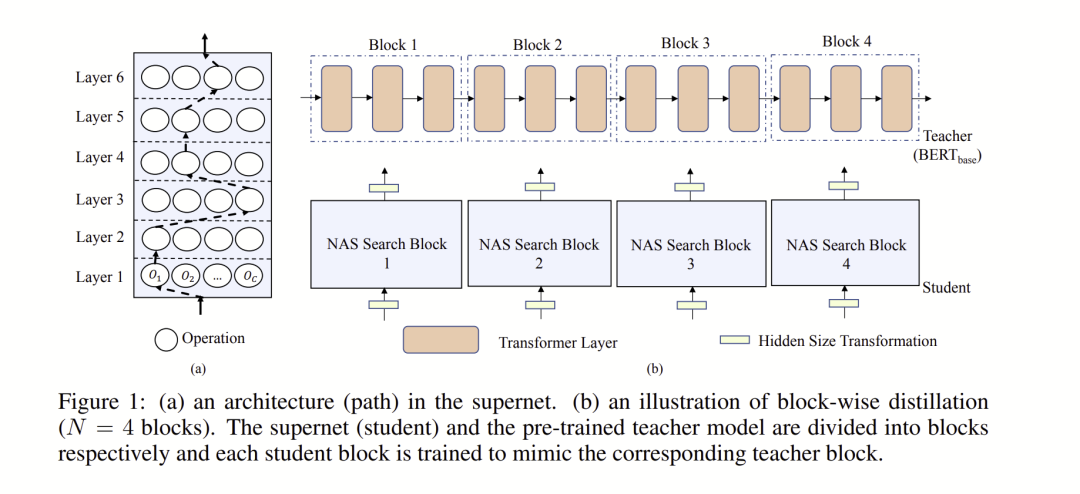

Task-Agnostic and Adaptive-Size BERT Compression

本文的目标是通过压缩可以得到模型对不同大小和延迟的限制下的小模型;另外压缩后的模型是任务不可知(task agnostic)即对所有的下游任务都是通用的。为了实现这个目标,本文使用的方法是基于NAS架构搜索的方法,由于待搜索的空间非常大,对于预训练任务难度较大,本文提供了3种策略来优化。

论文链接: https://openreview.net/forum?id=wZ4yWvQ_g2y¬eId=wZ4yWvQ_g2y

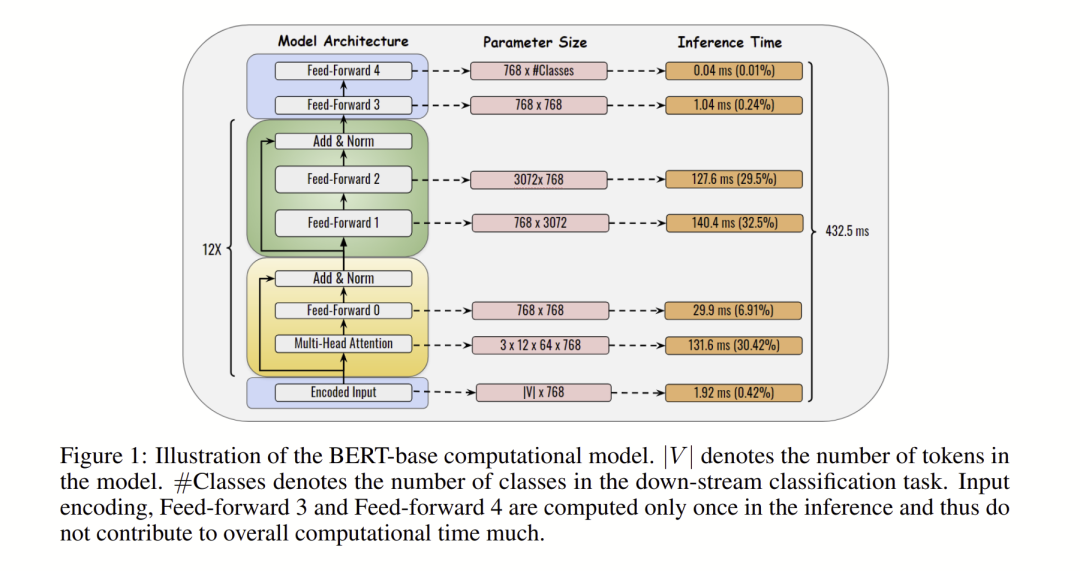

Data-Aware Low-Rank Compression for Large NLP Models

本文的目标是对BERT模型中最为占用时间部分,即矩阵乘法进行优化。基于一个观察,权重矩阵本身并不是低秩矩阵,但是每一层的表示(输出)却是处于低维空间。基于这个观察本文提出了DRONE方法,通过最小化表示输出的误差而不是单纯的权重矩阵的误差,来对权重矩阵进行分解。

论文链接:https://openreview.net/forum?id=_sSHg203jSu

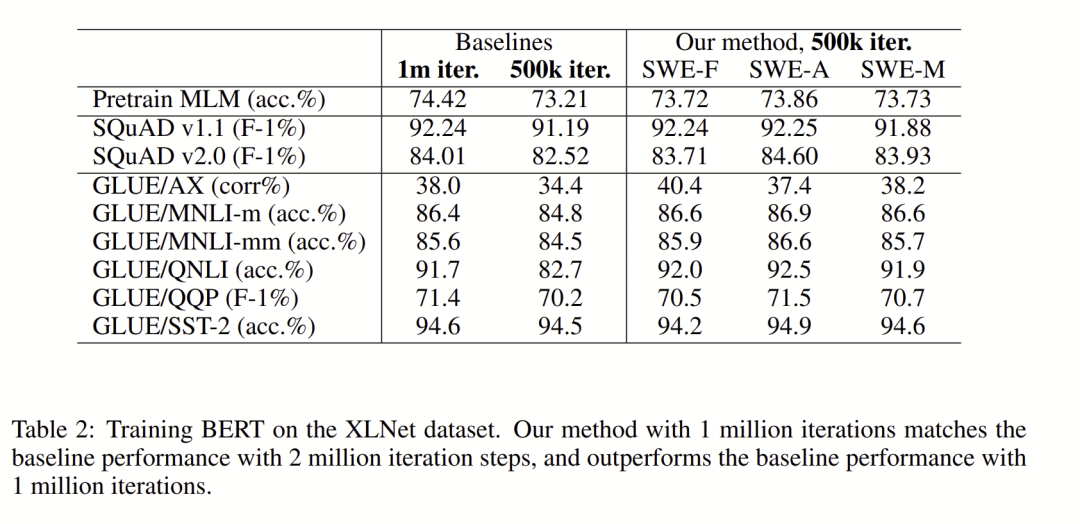

Speeding up Deep Learning Training by Sharing Weights and then Unsharing

本文的目标是解决深度模型中提升模型深度带来的计算复杂度提高的问题,主要针对模型中存在多个重复结构的情况,本文中则是以BERT中的transformer结构为例。本文采用的方法是首先共享所有重复结构的权重,然后达到一定条件下解除共享。

论文链接:https://openreview.net/forum?id=jz7tDvX6XYR

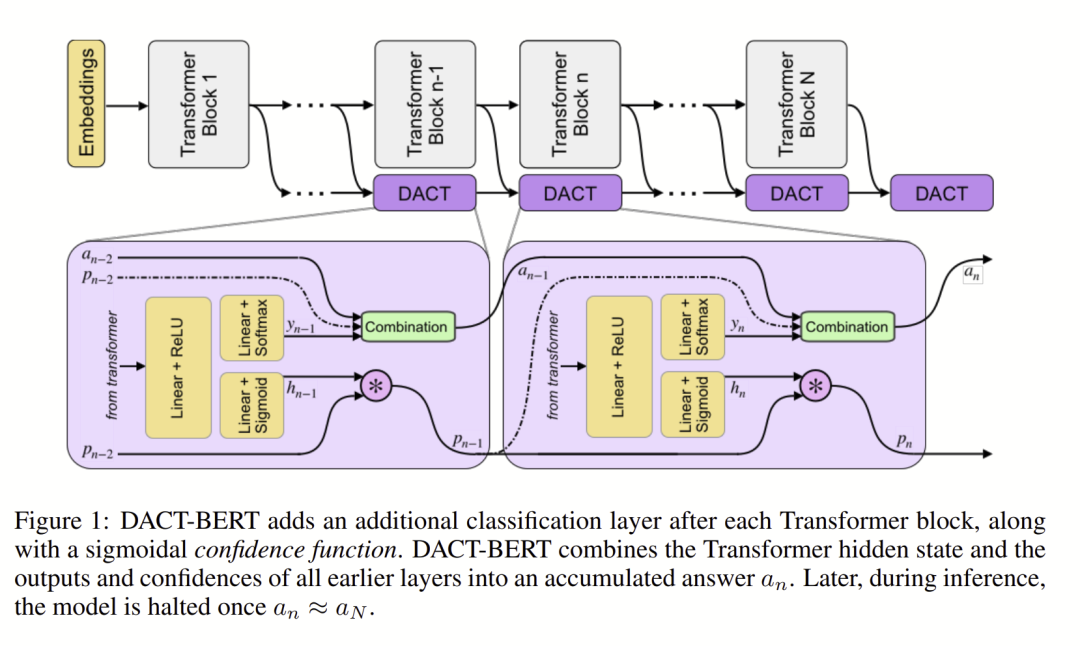

Dact-BERT: Increasing the Efficiency and Interpretability of BERT by Using Adaptive Computation Time

本文的目标是缩短大模型的预测阶段的耗时。本文以BERT为基础,在BERT模型中加了一个DACT结构,最终学习出来在预测节点所需要的模型深度(numbert of transformers blocks)。DACT结构原本是用于在视觉推理任务中,目标是来选择一个合适的推理的中间steps。本文将DACT结构融入BERT的transformer block中间,直接学习什么时候就可以达到预测的标准,那么在预测阶段只需要这部分子结构就可以完成预测的任务。

论文链接:https://openreview.net/forum?id=wKfXaxPist

预训练

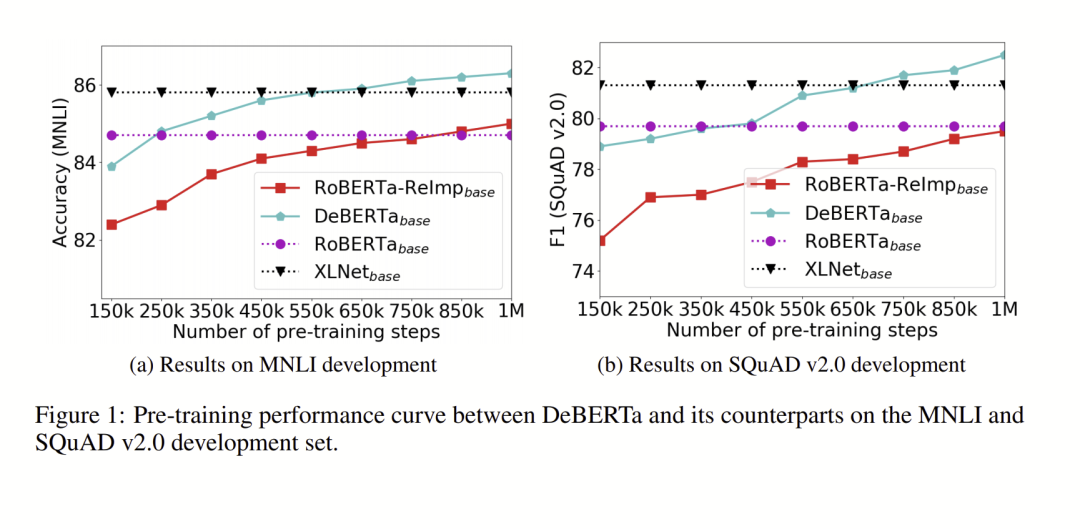

DeBERTa: DECODING-ENHANCED BERT WITH DISENTANGLED ATTENTION

本文对现有的BERT模型做了改进。一组词的 Attention 不光取决于内容,还和它们的相对位置有关(比如 deep learning 挨在一起时的依赖关系比不在一起时要强)。解决预训练和精调的不匹配问题(精调时没有 MASK)。文中提出了两类策略,Disentangled Attention:增加计算 “位置-内容” 和 “内容-位置” 注意力。Enhanced Mask Decoder:用 EMD 来代替原 BERT 的 SoftMax 层预测遮盖的 Token。

论文链接:https://openreview.net/forum?id=XPZIaotutsD

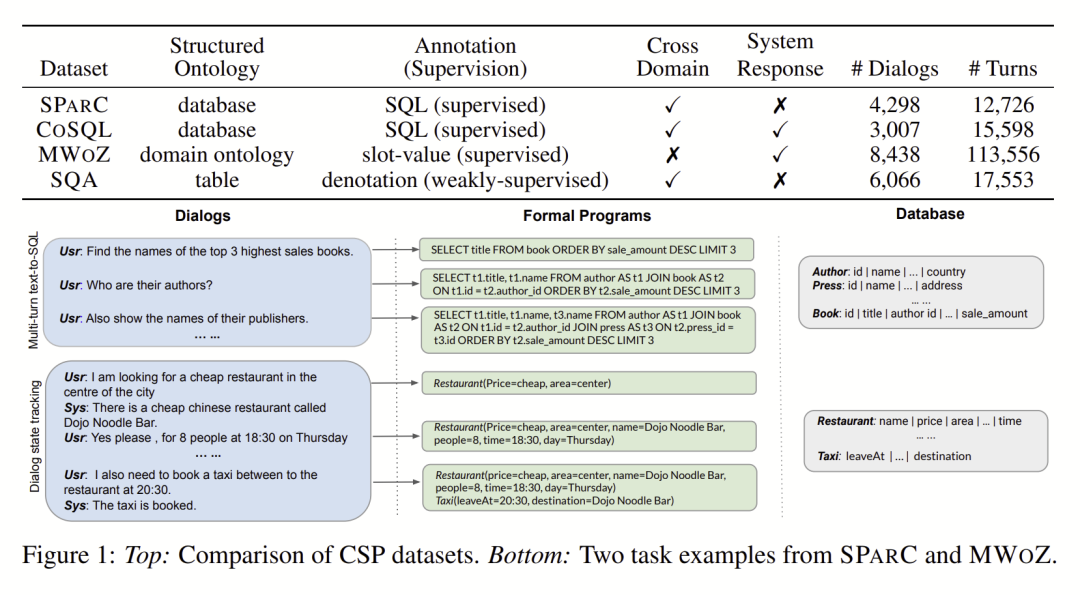

SCoRe: Pre-Training for Context Representation in Conversational Semantic Parsing

为了将自然语言对话转为成形式化语言,CSP系统需要在描述对话的多回合动态变化的同时,对非结构化语言和结构化本体之间的关系进行建模。本文提出了一种新的用于CSP任务的训练方法,旨在获得表示以捕捉对话流与结构化上下文的一致性。

论文链接:https://openreview.net/forum?id=5ip8nV7F4Qn

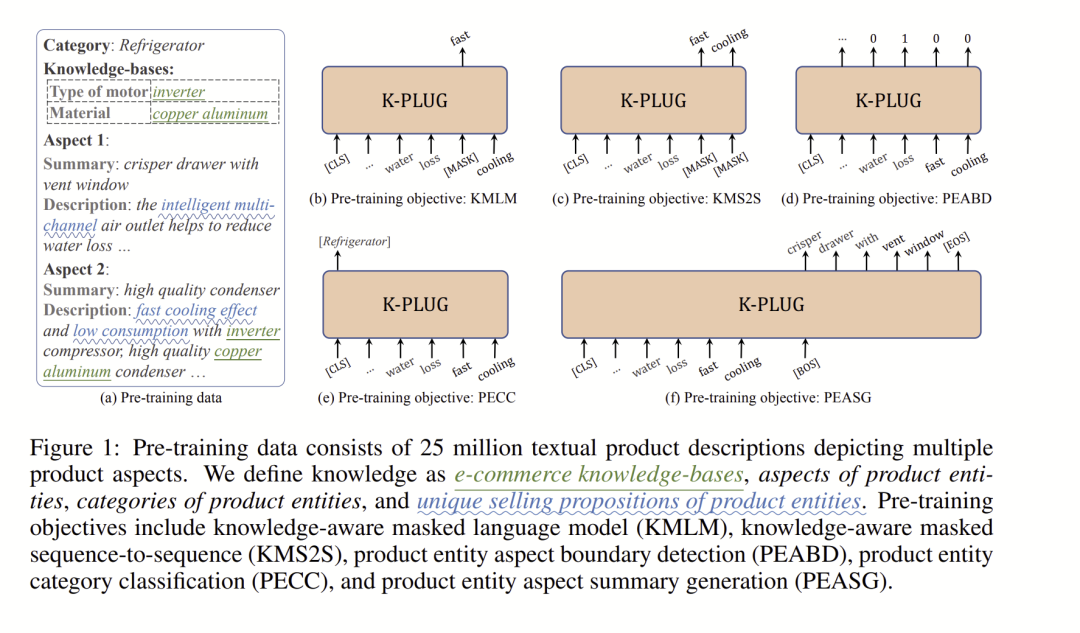

K-PLUG: KNOWLEDGE-INJECTED PRE-TRAINED LANGUAGE MODEL FOR NATURAL LANGUAGE UNDERSTANDING AND GENERATION

虽然PLM已经在众多NLP任务中证明了有效性,但他们中的大多数并没有明确地学习特定领域的知识。在本文中,我们提出了K-PLUG,一种基于编解码转换器的知识注入的预训练语言模型,它既适用于自然语言理解任务,也适用于生成任务。具体来说,我们提出了五个具有知识意识的自我监督的预训练目标,以实现特定领域的知识学习。