封面故事|单图超分辨重建

杨云, 张海宇, 朱宇, 张艳宁. 类别信息生成式对抗网络的单图超分辨重建[J]. 中国图象图形学报, 2018, 23(12): 1777-1788.

DOI: 10.11834/jig.180331

单幅图像超分辨率(SISR)技术应用范围广阔,其与深度学习的结合是近年来该领域研究的热点。本文以基于生成式对抗网络的超分辨率(SRGAN)模型为基础,通过引入类别分类器产生的类别损失项,使生成网络重建结果的细节特征更加显著,实验结果验证了本文方法在超分辨率重建任务中的优势和有效性。

论文看点

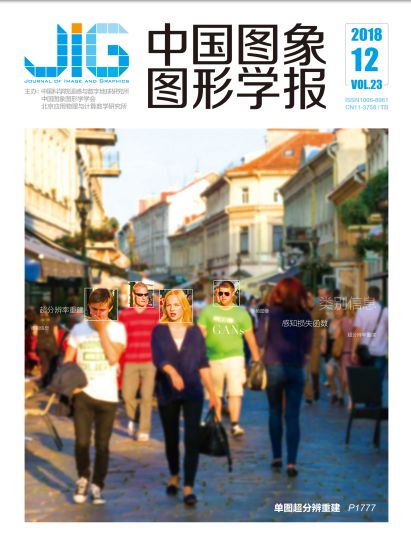

在SRGAN模型工作的基础上,增设类别分类器,并将类别损失项添加至生成网络损失中,再利用反向传播训练更新网络参数权重,以实现对SRGAN模型损失函数与网络结构的优化。主要工作包括:

①调研了典型的图像超分辨率重建算法及其分类—非深度学习方法和深度学习方法,通过综合比较各类方法的特点,重点突出了深度学习方法在图像超分辨率重建问题中整体所表现出的优越性。

② 针对现有SRGAN模型重建结果细节特征不明显的问题,提出了一种类别信息生成式对抗网络的超分辨率(Class-info SRGAN)模型:通过附加的信息变量限制超分辨率重建任务的解空间范围,协助模型更加准确地参照数据的语义特征进行训练并重建出高分辨率的图像。

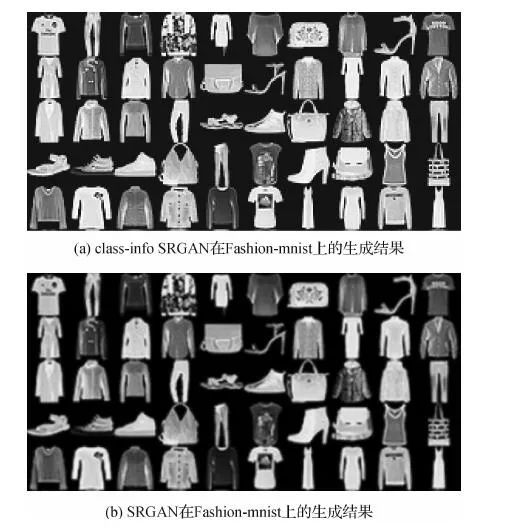

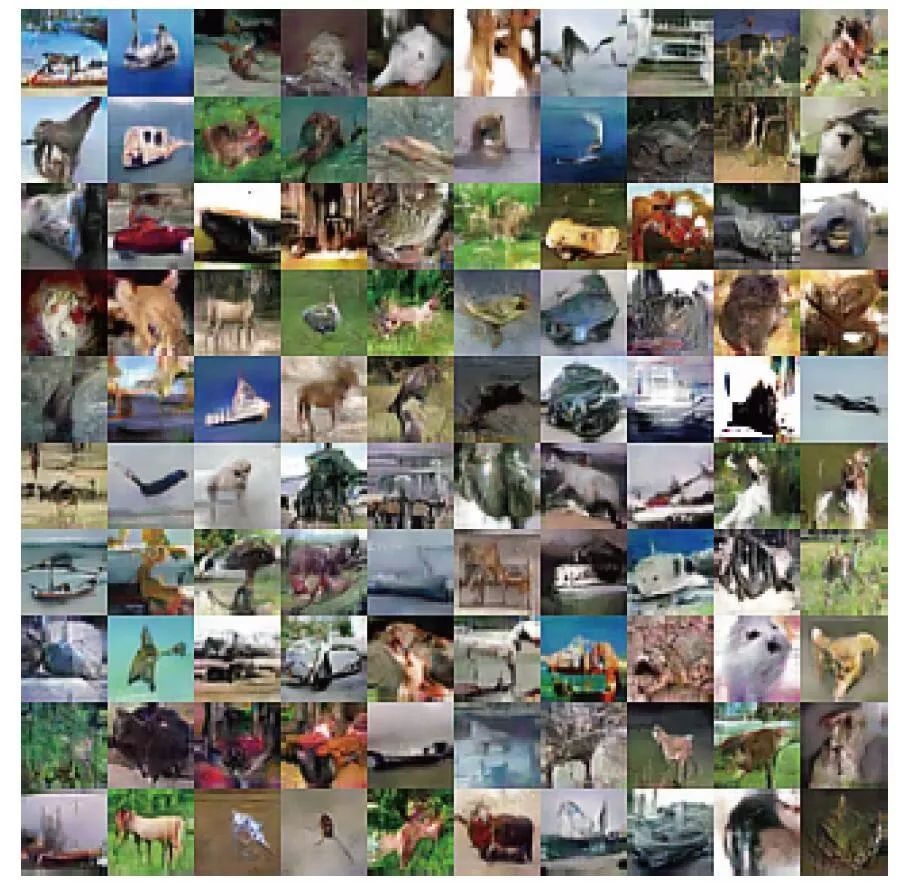

③ 通过在CelebA、Fashion-mnist与Cifar-10数据集上的实验,验证了Class-info SRGAN模型在超分辨率重建任务中的优势与有效性。

专家推荐

论文作者在SRGAN方法的基础上,给出了一种类别信息生成式对抗网络的超分辨模型。作者的实验分析部分较为充足,论述较为充分。

本文方法

对SRGAN模型增设类别分类器, 并将类别损失项添加至生成网络损失中, 再利用反向传播训练更新网络参数权重, 以达到为模型提供特征类别信息的目的, 最终生成具有可识别特征的重建图像。创新及优势在于将特征类别信息引入损失函数, 改进了超分辨模型的优化目标, 使得重建结果的特征表示更加突出。

图1 类别信息生成式对抗网络的超分辨原理示意图

本文结果

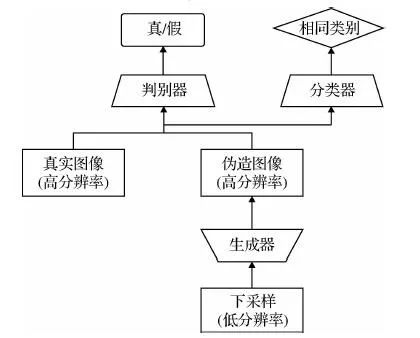

经CelebA数据集测试表明:添加性别分类器的Class-info SRGAN的生成图像性别特征识别率整体偏高(58%~97%); 添加眼镜分类器的class-info SRGAN的生成图像眼镜框架更加清晰。此外, 模型在Fashion-mnist与Cifar-10数据集上的结果同样表明其相较于SRGAN的重建质量更佳。

图2 类别信息生成式对抗网络的超分辨在CelebA上的

重建结果

图3 类别信息生成式对抗网络的超分辨模型与

生成式对抗网络的超分辨模型生成结果比较

图4 生成式对抗网络的超分辨在Cifar-10上的重建结果

图5 类别信息生成式对抗网络的超分辨在Cifar-10上的

重建结果

实验结果验证了本方法在超分辨重建任务中的优势和有效性, 同时结果显示:虽然class-info SRGAN更适用于具有简单、具体属性特征的图像, 但总体而言仍是一种效果显著的超分辨模型。

END

前沿丨观点丨资讯丨独家

长按识别二维码关注

论文投稿