ICLR 2020 | 互信息视角下的表征学习

互信息(MI)在表征学习中广泛被用到,但由于其 intractable 的性质,很多方法只是将其一个下界作为优化的目标。本文简单阐述了两篇文章,其中一篇将如今的词表示学习方法统一到 MI 的视角下,另一篇首次提出了近似 MI 的导数而非直接近似 MI 来得到更好的近似效果。

A Mutual Information Maximization Perspective of Language Representation Learning

作者指出如今 SOTA 的词表示学习的方法在优化的目标函数其实是一个词序列的不同部分的互信息(MI)的下界。互信息是度量两个随机变量之间依赖程度的标准。给定两个随机变量 A 和 B,它可以被理解为对于 A 的知识可以多大程度上减少 B 的不确定性,反之亦然。

其一个典型的下界为 InfoNCE,这类方法是众所周知的 contrast learning。文章的贡献如下:

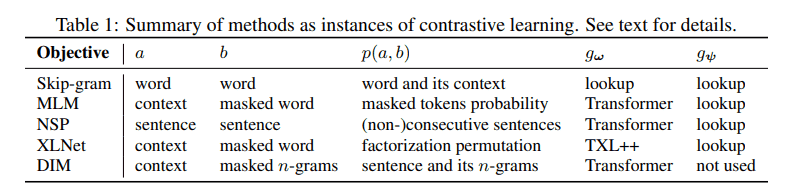

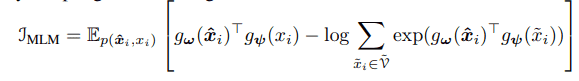

(1)提出了一个基于最大化 MI 的理论框架来理解词表示学习模型,并将已知的方法统一到这个框架之中,如 skip-gram,masked language modeling(如 BERT)和 permutation language modeling(如 XLNET)。并指出 BERT 和 Skip-gram 其实在最大化一个相似的目标式,而他们最大的不同即为所选择的 encoder----一个依赖于语境的以一个句子作为输入的 Transformer 还是一个查表式的嵌入矩阵。

(2)与此同时,这样一个框架可以提出一种普遍的表示学习模型,这种模型可以作为设计并将自监督训练的目标函数结合进来来得到更好的语言表示的基础。此外我们还可以联想到 Deep InfoMax(DIM)---一个基于互信息的图像表示学习的方法,而 DIM 旨在最大化一个图像的局部和整体表示向量的互信息。对于一个词序列,我们也可以考虑其整体表示和局部的表示(如一个单词),并借鉴这一思路将其作为我们希望最大化目标函数的一部分。

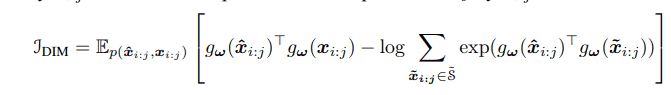

(3)在此基础上作者提出了 INFOWORD 这一模型。其优化目标有两项,一个来源于 DIM,选取一个 masked 单词序列为整体表示,一个 n-gram 为局部表示;另一个来源于 Masked Language Modeling。

作者在选取三个模型,BERT,BERT-NCE(作者对于 BERT 的改动版本),INFOWORD,并在两个数据集(GLUE 和 SQuAD)上检测其效果。

Mutual Information Gradient Estimation for Representation Learning

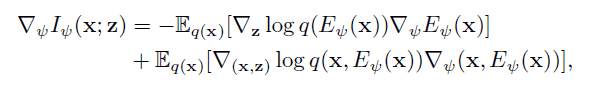

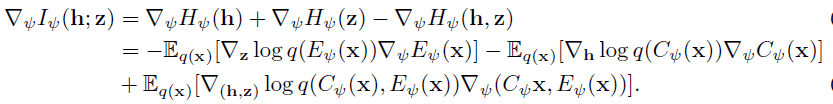

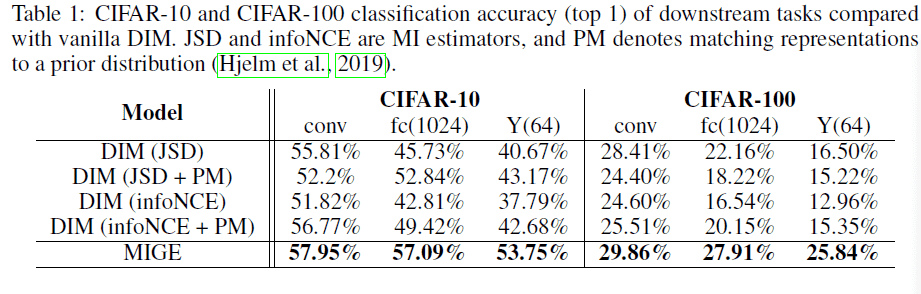

互信息(MI)在表示学习中占据很重要的地位,但不幸的是,对于连续的高维变量 MI 是 intractable 的。目前解决这一问题的思路是使用 MI 的一种估计来近似 MI,但大多数现存的方法并不能在 MI 很大的时候很好地给出 MI 的较为精确值。据此,作者提出一种直接估计 MI 的导数的方法(MIGE)来使其在表示学习中比估计 MI 自身取得更好的效果,并将其应用在无监督学习的方法如 Deep InfoMax 与 Information Bottleneck 上。文章贡献主要如下:

(1)提出了 MIGE,它可以在高维变量且 MI 较大时更好地给出 MI 一个更紧的具有较为光滑的导数估计;

(2)提出了 Scalable SSGE 可以在高维情形时避免计算 SSGE 时所需的较高的计算代价。

作者分三种情形给出了 MI 导数的估计。

并将其应用在 Deep InfoMax 和 Information Bottleneck 上,均取得了较好的效果。

近期精彩集锦——

【2020科技趋势】:《2020科技趋势报告》

【AI女神】:《AI全球最具影响力女性学者报告》

【AI10】:《浅谈人工智能下一个十年》

【GNN】:《图神经网络及认知推理》

【AI指数】:《2019人工智能指数报告》

点击左下角“阅读原文”,一键直达 ICLR 2020 专题!