报名 | ACL 2020 复旦大学系列解读【第二/三期】

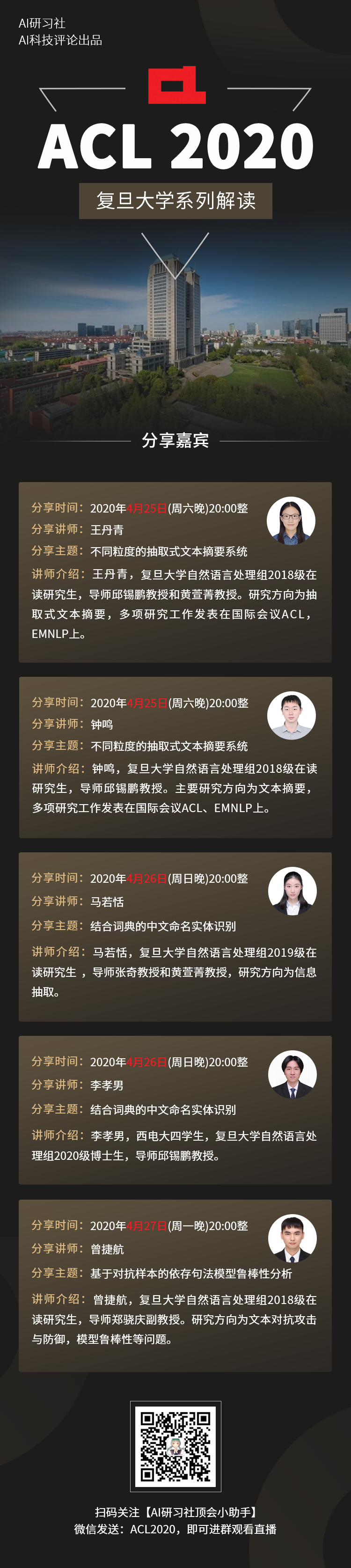

AI 科技评论联合复旦大学,推出「ACL 2020 - 复旦大学系列论文解读」。 AI科技评论 X 复旦大学

为促进学术交流,让更多师生及时了解最新前沿研究,AI科技评论联合复旦大学,重磅推出「ACL 2020 -复旦大学系列论文解读」。我们将在4月25-27日,连续三天进行 3 场直播,其中包含 5 篇 ACL 论文以及复旦大学在相关方面的研究进展。

福利放送:在每场直播中,我们会挑出两位幸运听众,寄送一本复旦大学邱锡鹏教授新书《神经网络与深度学习》(被誉为“蒲公英书”)。

此书已有Github版(https://nndl.github.io),各位也可以去下载电子版本阅读。

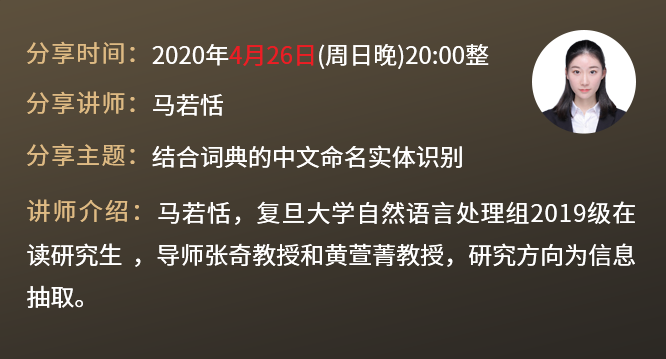

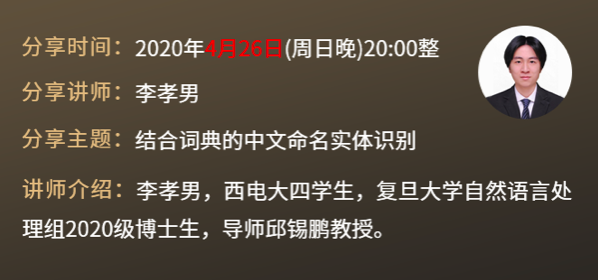

ACL 2020-复旦大学系列论文解读 · 第二期

直播主题:结合词典的中文命名实体识别

直播时间:2020年4月26日(周日)晚20:00整

论文:

主讲人介绍

分享提纲

直播信息

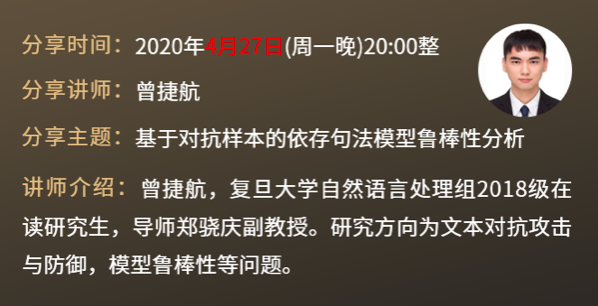

直播主题:

基于对抗样本的依存句法模型鲁棒性分析

直播时间:2020年4月27日(周一)晚20:00整

论文:

主讲人介绍

分享提纲

登录查看更多

相关内容

专知会员服务

64+阅读 · 2020年4月28日

专知会员服务

52+阅读 · 2019年12月28日

专知会员服务

48+阅读 · 2019年10月21日