题目: TENER: Adapting Transformer Encoder for Named Entity Recognition

摘要:

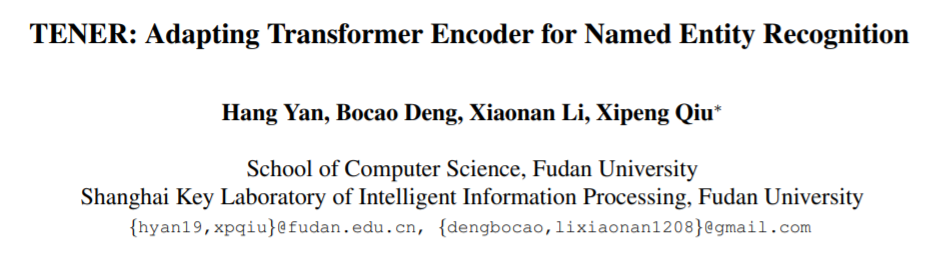

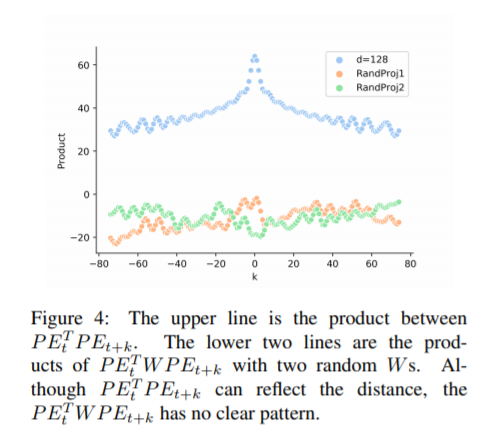

双向长短时记忆网络(BiLSTM)在解决命名实体识别(NER)任务的模型编码中得到了广泛的应用。近年来,转换器以其并行性和优越的性能被广泛应用于各种自然语言处理(NLP)任务中。然而,在NER中变压器的性能不如在其它NLP任务中。在本文中,我们提出了一种采用自适应变压器编码器对字符级特征和字级特征进行建模的NER结构TENER。通过结合方向感知、相对距离感知和非尺度感知,证明了该编码器与其它NLP任务一样有效。

作者:

邱锡鹏,复旦大学计算机科学技术学院副教授,博士生导师。于复旦大学获得理学学士和博士学位。主要从事自然语言处理、深度学习等方向的研究,在ACL、EMNLP、AAAI、IJCAI等计算机学会A/B类期刊、会议上发表50余篇学术论文,引用 1900余次。开源中文自然语言处理工具FudanNLP作者,FastNLP项目负责人。2015年入选首届中国科协人才托举工程,2017年ACL杰出论文奖,2018年获中国中文信息学会“钱伟长中文信息处理科学技术奖—汉王青年创新奖”。

成为VIP会员查看完整内容

相关内容

A/D或D/A转换器:将模拟信号转换成数字信号,或将数字信号转换成模拟信号。

模拟信号是连续变化的电压或电流, 对应的数字信号是数字流,表示模拟信号在某一瞬间的幅度。

Ref: Glossary Definition for 数据转换器

Ref: Glossary Definition for 数据转换器

专知会员服务

43+阅读 · 2019年11月12日

专知会员服务

48+阅读 · 2019年10月21日

专知会员服务

84+阅读 · 2019年10月18日

Arxiv

6+阅读 · 2019年4月30日

Arxiv

16+阅读 · 2019年4月3日

Arxiv

10+阅读 · 2018年1月30日