PyTorch 1.11、TorchData 和 functorch 现已推出。

近日,PyTorch 官方宣布推出 PyTorch 1.11,此版本由 1.10 版本以来的 3,300 多次 commits 组成,由 434 位贡献者完成。此外,本次 PyTorch 官方同时发布了受 JAX 启发的库 TorchData 和 functorch 的 Beta 版本。

假如你是一名长期的 TensorFlow 用户,你一直想切换到 JAX 或 PyTorch,或许 1.11 版本能为你带来帮助。

![]()

PyTorch地址:https://pytorch.org/blog/pytorch-1.11-released/

网友也不禁感叹:终于可以安装 functorch,一套受 JAX 启发的 ops!vjp、 jvp、 vmap... 终于可用了!!!

![]()

TorchData Beta 版:这是一个通用模块化数据加载原型库,用于轻松构建灵活且高性能的数据 pipeline。根据社区反馈,PyTorch 官方发现现有的 DataLoader 将太多的功能捆绑在一起,难以扩展。此外,不同的用例通常必须重写相同的数据加载实用程序。TorchData 的目标是通过 Iterable-style 和 Map-style 的构建块 DataPipes 来实现可组合数据加载,这些构建块与 PyTorch 的 DataLoader 达到开箱即用。

DataPipe 接受 Python 数据结构上一些访问函数:__iter__用于 IterDataPipe,__getitem__用于 MapDataPipe,它们会返回一个新的访问函数。你可以将多个 DataPipe 连接在一起,形成数据 pipeline,以执行必要的数据转换工作。PyTorch 官方已经实现了超过 50 个 DataPipes,它们提供了不同的核心功能,比如打开文件、解析文本、转换样本、缓存、shuffling 和批处理。那些对连接到云提供商(如谷歌 Drive 或 AWS S3)感兴趣的用户, fsspec 和 iopath DataPipes 会提供帮助。想了解更对关于 IterDataPipe 和 MapDataPipe 的研究者,可以参考官方文档。

在 PyTorch1.1 版本中,一些 PyTorch 域库已经将数据集迁移到 DataPipes。在 TorchText 中提供的流行数据集是使用 DataPipes 实现的,其 SST-2 二进制文本分类教程的一部分演示了如何使用 DataPipes 为模型预处理数据。在 TorchVision 和 TorchRec 中还有其他数据集的原型实现。你可以参考官方提供的具体的示例。

TorchData 文档已经上线,它包含一个教程,教程介绍了如何使用 DataPipes、将它们与 DataLoader 一起使用、如何实现自定义。

PyTorch 官方宣布推出 functorch 的首个 beta 版本。受到 Google JAX 的极大启发,functorch 是一个向 PyTorch 添加可组合函数转换的库。该库旨在提供可组合的 vmap(向量化)和 autodiff 转换,可与 PyTorch 模块和 PyTorch autograd 一起使用,并具有良好的渴望模式(eager-mode)性能。

可组合的函数转换可以帮助解决当前在 PyTorch 中难以实现的许多用例:

vmap(向量化)、vjp(反向模式 AD)和 jvp(前向模式 AD)转换的组合使得用户毫不费劲地表达上述内容,无需为每个转换设计单独的库。

DDP 静态图假设用户的模型在每次迭代中都使用相同的一组已使用 / 未使用的参数,因此它可以确定地了解相关状态,例如哪些钩子(hook)将触发、钩子将触发多少次以及第一次迭代后的梯度计算就绪顺序。

静态图在第一次迭代中缓存这些状态,因此它可以支持 DDP 在以往版本中无法支持的功能,例如无论是否有未使用的参数,在相同参数上支持多个激活检查点。当存在未使用的参数时,静态图功能也会应用性能优化,例如避免遍历图在每次迭代中搜索未使用的参数,并启用动态分桶(bucketing)顺序。DDP 静态图中的这些优化为一些推荐模型带来了 10% 的 QPS 增益。

要启用静态图,只需在 DDP API 中设置 static_graph=True ,如下代码所示:

ddp_model = DistributedDataParallel(model, static_graph=True)

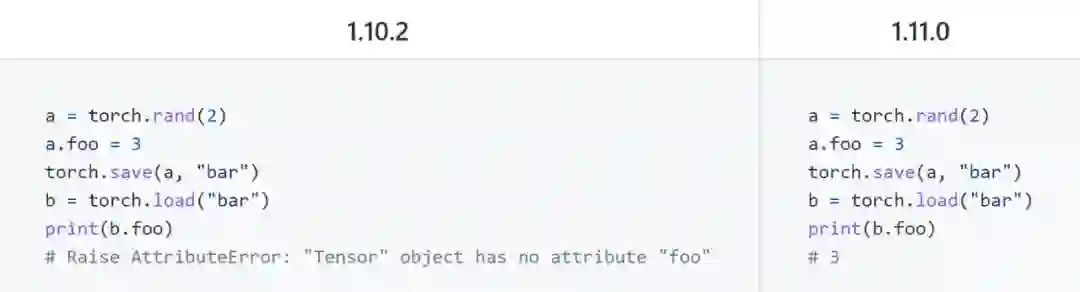

在 Python API 方面:修复了 python deepcopy 以正确复制 Tensor 对象上的所有属性,此更改可确保 Tensor 上的 deepcopy 操作能正确复制所有属性(而不仅仅是普通的 Tensor 属性)。

![]()

在 torch.linspace 和 torch.logspace 中,steps 参数不再是可选的。此参数在 PyTorch 1.10.2 中默认为 100,但已被弃用。在 PyTorch 1.11 中,它不再是可选的。

![]()

在 CUDA 方面,删除了 THCeilDiv 函数和相应的 THC/THCDeviceUtils.cuh header;删除 THCudaCheck;删除 THCudaMalloc(), THCudaFree(), THCThrustAllocator.cuh。

添加复数支持 Adagrad 和 Adadelta 优化器;

添加 torch.nn.utils.rnn.{unpack_sequence,unpad_sequence}函数;

为 GPU 上的 CSR 张量添加了 torch.sparse.sampled_addmm;

更多内容请参考:https://github.com/pytorch/pytorch/releases/tag/v1.11.0

PyTorch 1.11 的发布,给用户带来了一些惊喜。有网友表示,我都转到 JAX 了,这波是要诱惑我回归 PyTorch 啊。

![]()

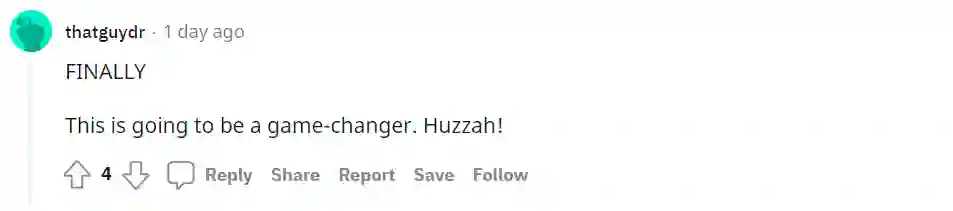

更有网友认为,PyTorch 1.11 将成为游戏改变者(game-changer)。

![]()

还有网友对首个 beta 版本的 functorch 库表示了肯定,有了它,终于补足了与 JAX 相比的一块短板。

![]()

![]()

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com