[WWW2020-腾讯QQ看点团队]未来上下文建模会话推荐,Modeling Future Contexts

论文主要作者来自腾讯QQ看点团队,团队在2019-2020期间在相关AI顶会和期刊发表多篇推荐系统领域学术论文,包括会议论文WSDM2019[1],IJCAI2019[2],WWW2020[3]和TOIS与TKDE等期刊论文。

摘要:会话时序(session-basedrecommendation)推荐系统在最近几年引起了学界广泛的研究兴趣。为了捕获用户点击行为的时序依赖关系,现有的深度学习方法在优化时通常借助用两种常用增强技术:数据提升或者自左向右的自回归方式。由于这两种方法目标在于建模用户行为的时序特性,在构建预测函数时候,往往忽略了目标交互行为的未来信息。然而,我们认为目标交互行为的未来数据(在模型训练阶段是可以获取到的)往往也包含了重要的用户喜好信号,从而可以用来提升模型的推荐质量。

然而恰当的结合未来数据用于模型训练并不简单,因为这种方式违反了机器学习的基本原理很容易产生信息泄漏问题。为了解决这个问题,我们提出一种编码器-解码器推荐框架,命名为基于空缺填充的推荐器GRec,GRec在训练编码器和解码器时采用填空机制。具体来讲,编码器采用部分完整的用户会话序列(一部分交互反馈被特意抠除)作为输入,解码器专门预测这部分被扣除的交互点击记录,建立在不完整的编码器表征上。考虑推荐模型的效率和准确率因素,本项工作我们采用卷积网络配合稀疏卷积滤波器来展示GRec这一通用框架。通过在真实的推荐数据集上(包括较短的、中等的和较长的会话序列)做大量的实验,我们展示了GRec显著地超过了各种最新的时序推荐系统算法。大量的经验研究证实了未来数据在GRec框架下十分有效。

现有编码器解码器结构分析:

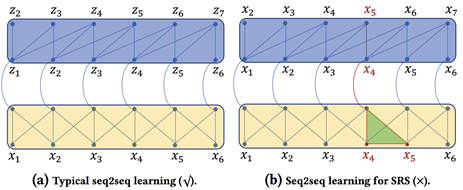

图1: 编码器-解码器结构,黄色模块为编码器,蓝色模块为解码器。(a)标准的编码器解码器结构,常见于NLP任务(例如翻译,文档摘要)和图像领域(例如图像生成标题)。由于x与z来自不同的序列不存在信息泄漏问题。(2)常规的编码器解码器结构直接用于时序推荐系统场景。可以发现解码器需要预测的物品(例如) 直接可以在编码器中看到,从而引起信息泄漏问题。

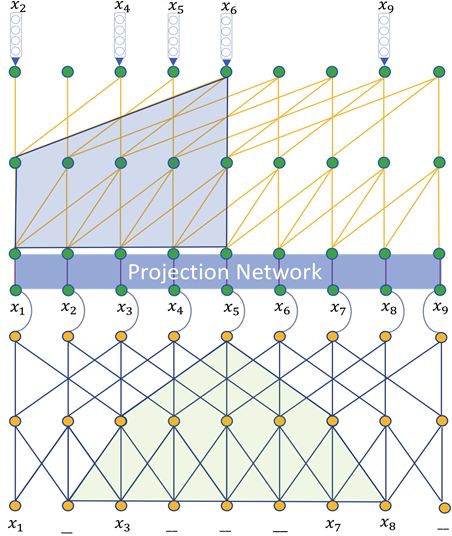

图2: GRec框架(采用两层卷积网络)。编码器中被有意遮挡,解码器只预测这部分被遮挡的物品。解码器的输入端并不发生变化,包含整个原始输入序列。在解码器embedding 和编码器的最后hidden之间设计了一个基于残差结构的映射网络,很够更大程度的结合编码器和解码器表征。可以发现的可视域相对于只有解码器结构变得更大了,不仅包含解码器中,同时包含了编码器中的。由于遮挡策略是随机生成的,在多次训练过程会覆盖除了以外序列中所有item表征。

论文框架与最新的自回归解码器模型NextItNet [1]做了比较,如下:

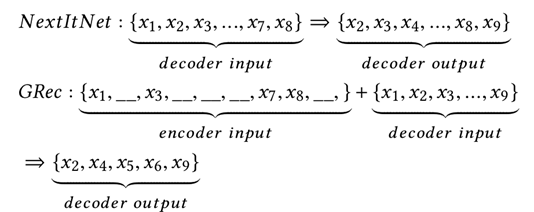

同时论文证实GRec是一种通用框架,通过采用将编码器或者解码器替换为其它时序模型,例如GRU,GRec仍然显著的超越仅有的解码结构的网络,如图3。

图3:GRec变种,通过替换编码器或者解码器为RNN网络。(a)的编码器为双向RNN结构,解码器为因果卷积网络;(b)与(a)刚好相反,编码器为双向CNN结构,解码器为单向RNN结构。

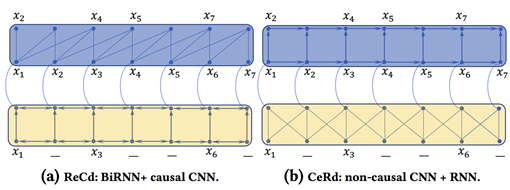

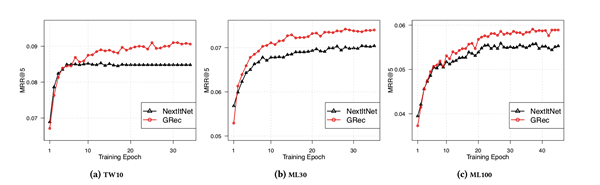

论文主要对比了GRec与最新的卷积网络NextItNet,如图4所示。

图4:GRec vs. NextItNet。可以发现NextItNet在最初epoch略优于GRec,但随着进一步优化 GRec慢慢领先于NextItNet直至最终收敛。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“SRC” 就可以获取《未来上下文建模会话推荐,Modeling Future Contexts》论文专知下载链接