【XAUTOML】可解释自动机器学习,27页ppt

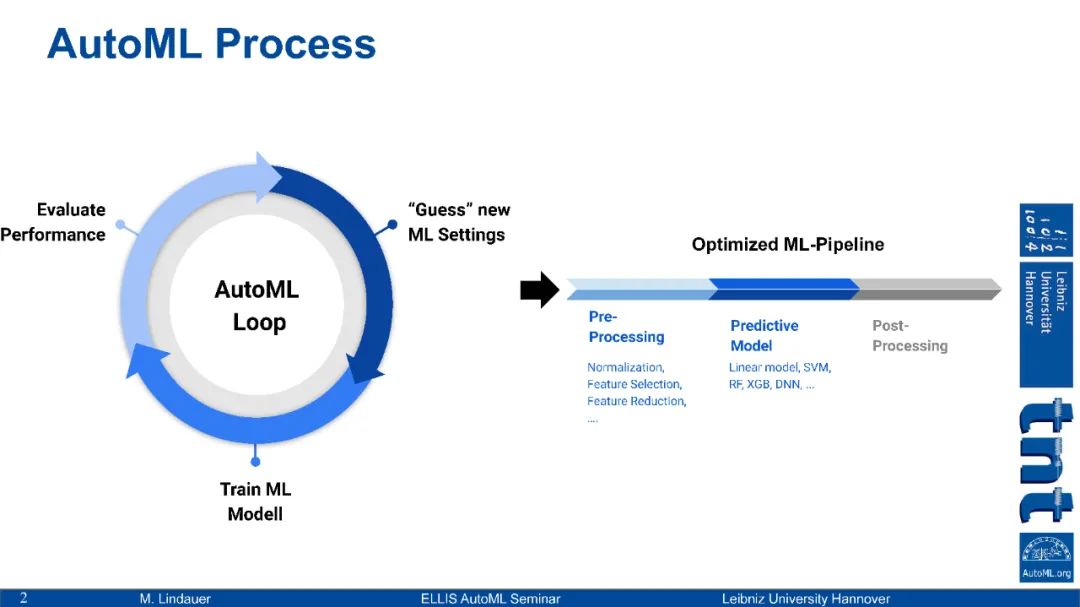

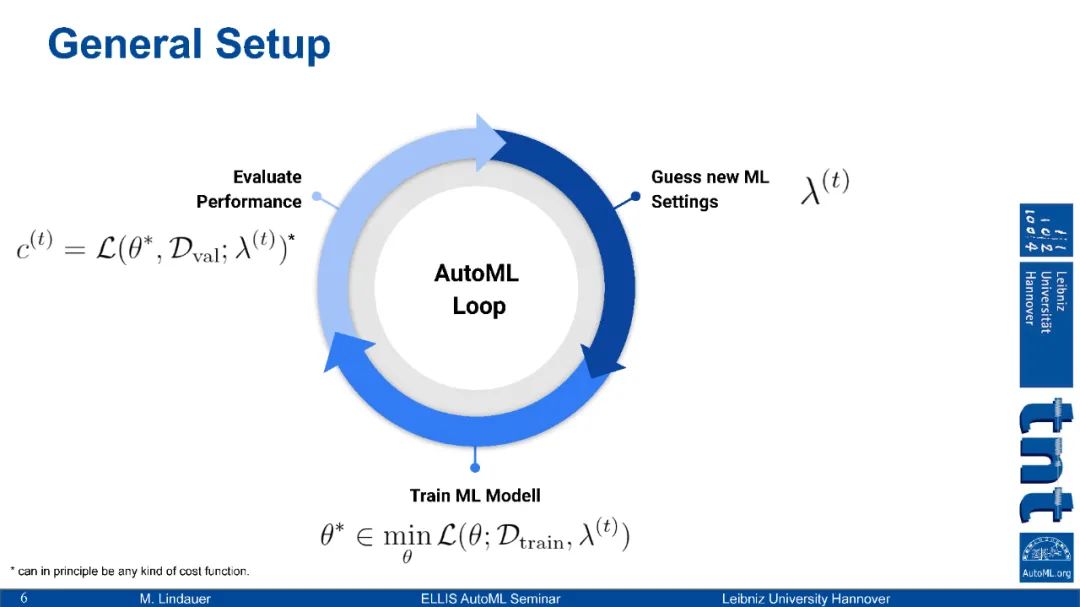

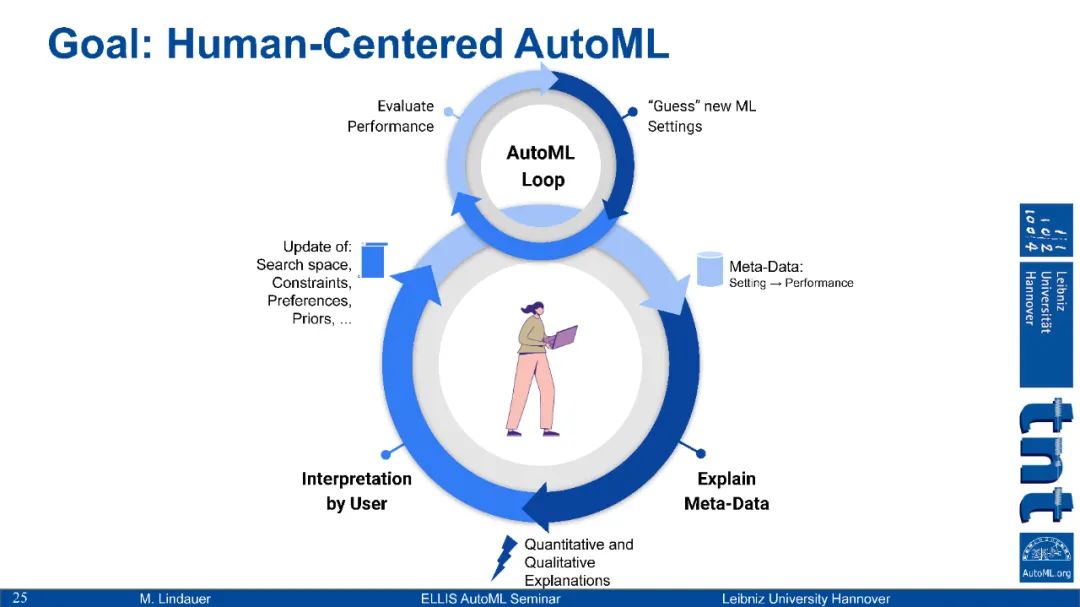

自动化机器学习支持用户、开发人员和研究人员快速开发新的ML应用程序。然而,AutoML工具的输出并不总是能够很容易地用人类的直觉或专家知识来解释,因此专家有时会对AutoML工具缺乏信任。因此,我们开发了一些方法,提高了AutoML系统的透明度和可解释性,增加了对AutoML工具的信任,并对其他不透明的优化过程产生了有价值的见解。解释AutoML的方法包括:

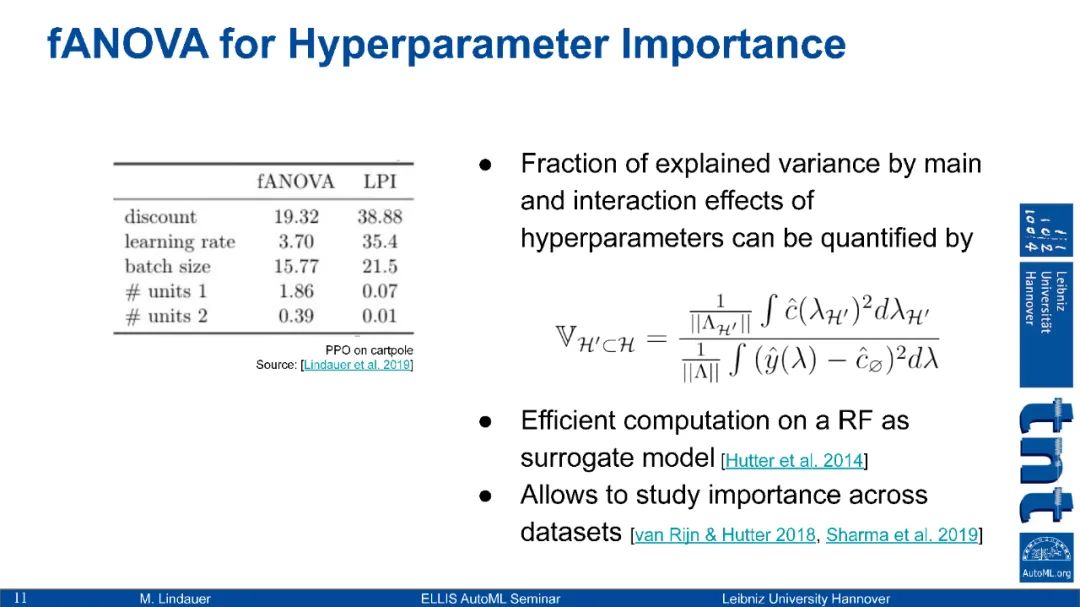

超参数的重要性: 哪些超参数(或其他设计决策)对提高ML系统的性能具有全局重要性?[Hutter等人2014]

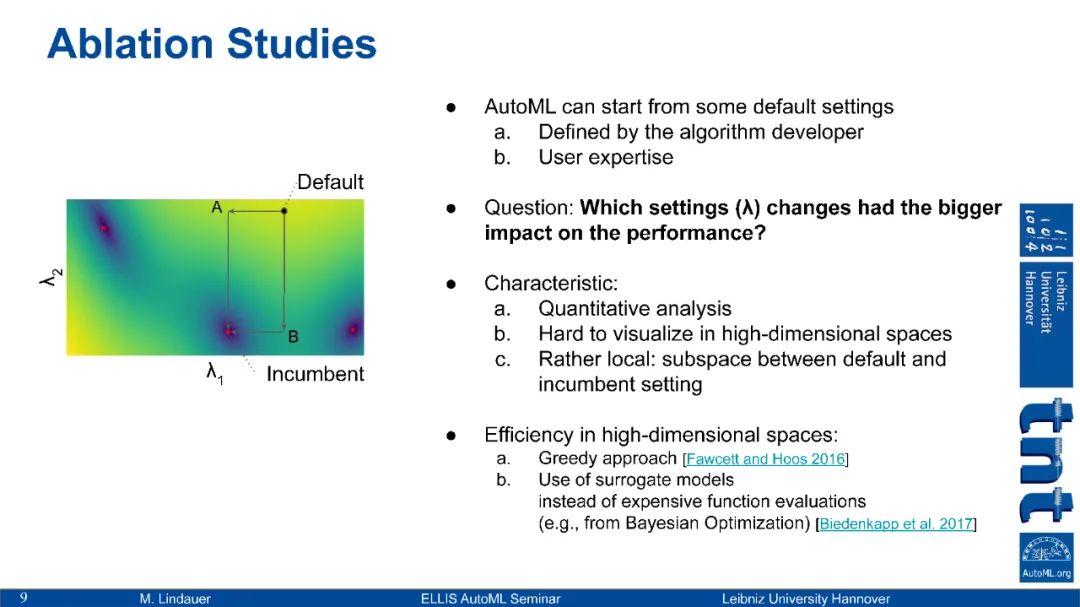

自动消融研究: 如果一个AutoML工具从一个给定的配置开始(例如,由用户或ML算法的原始开发人员定义),与AutoML工具返回的配置相比,哪些更改是重要的,以实现观察到的性能改进?[Biedenkapp等人2017]

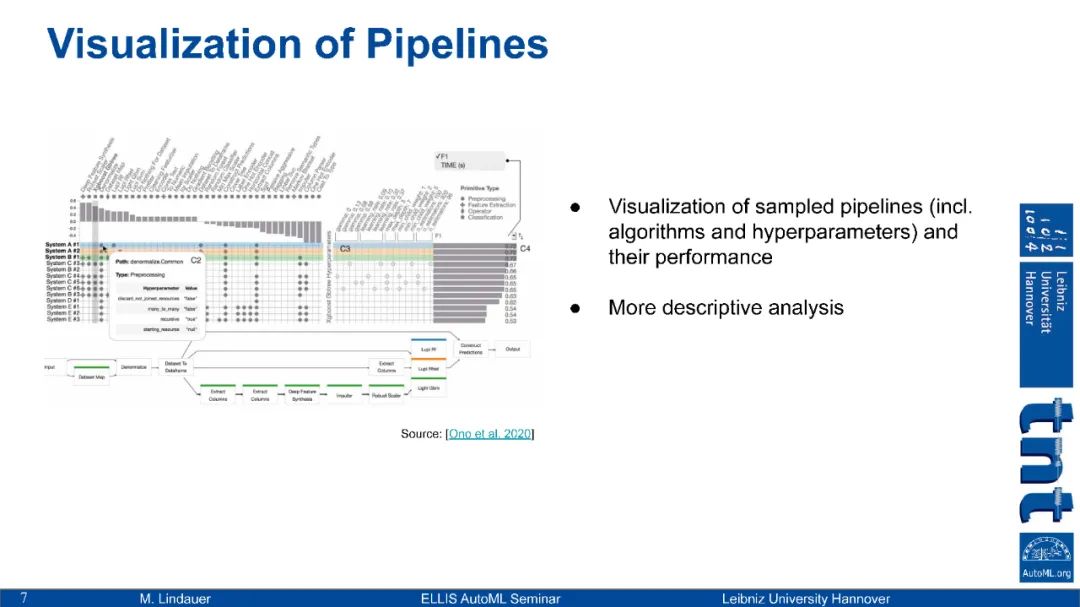

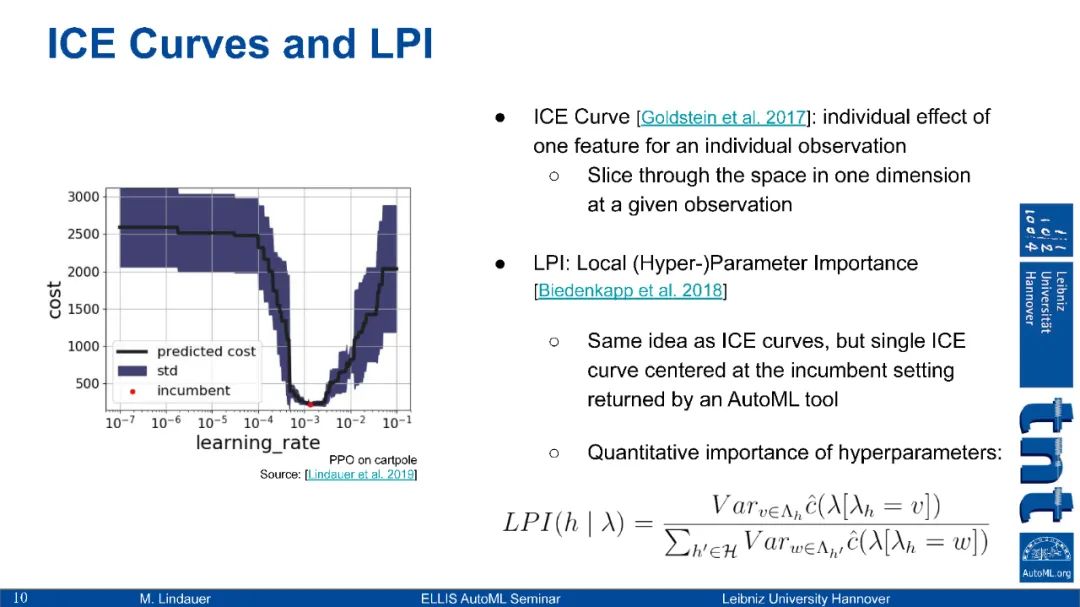

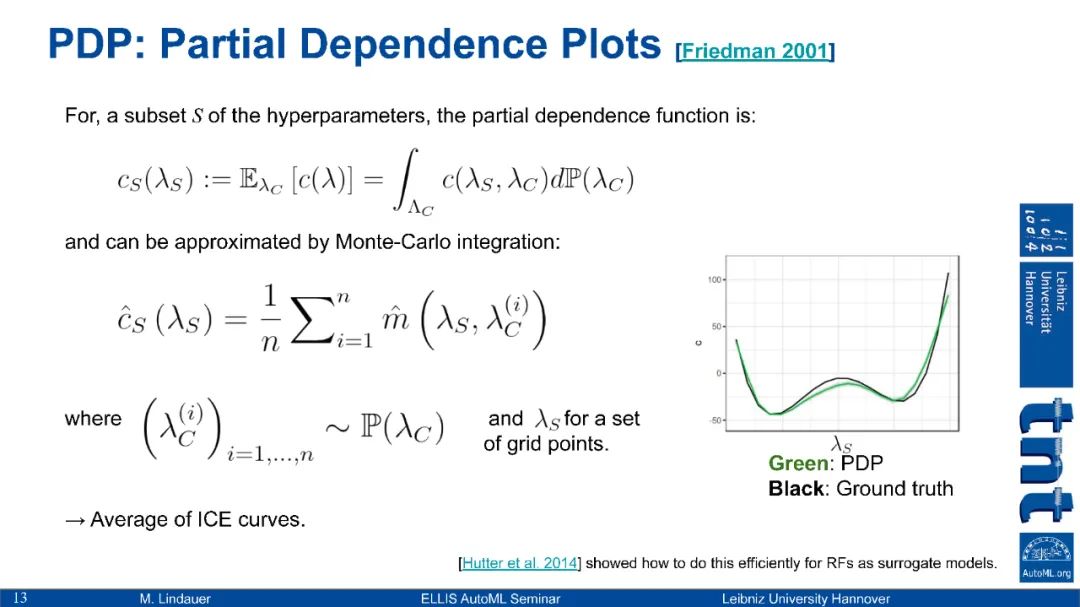

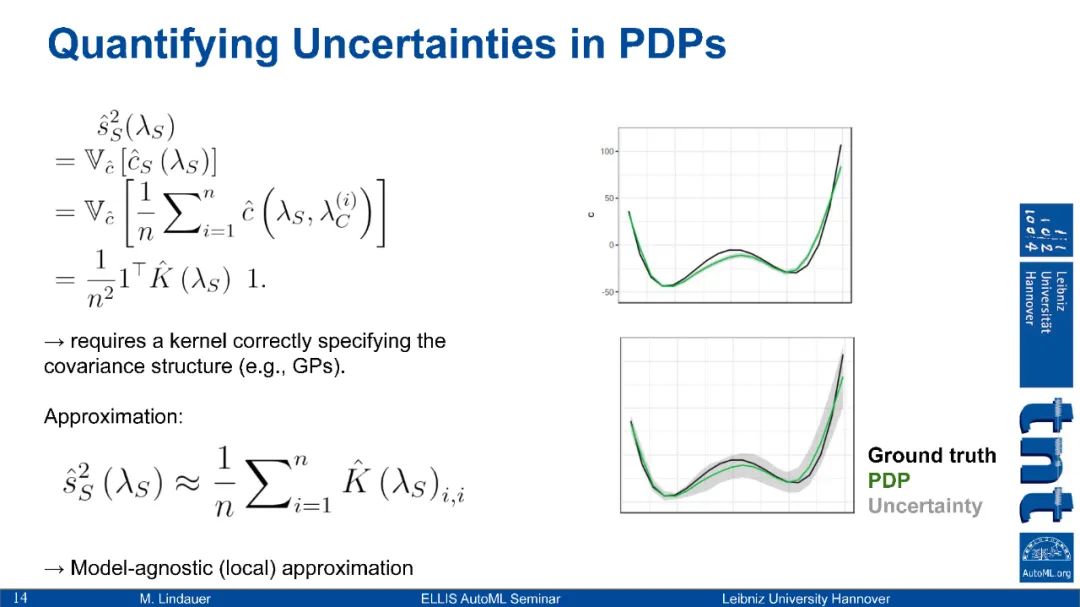

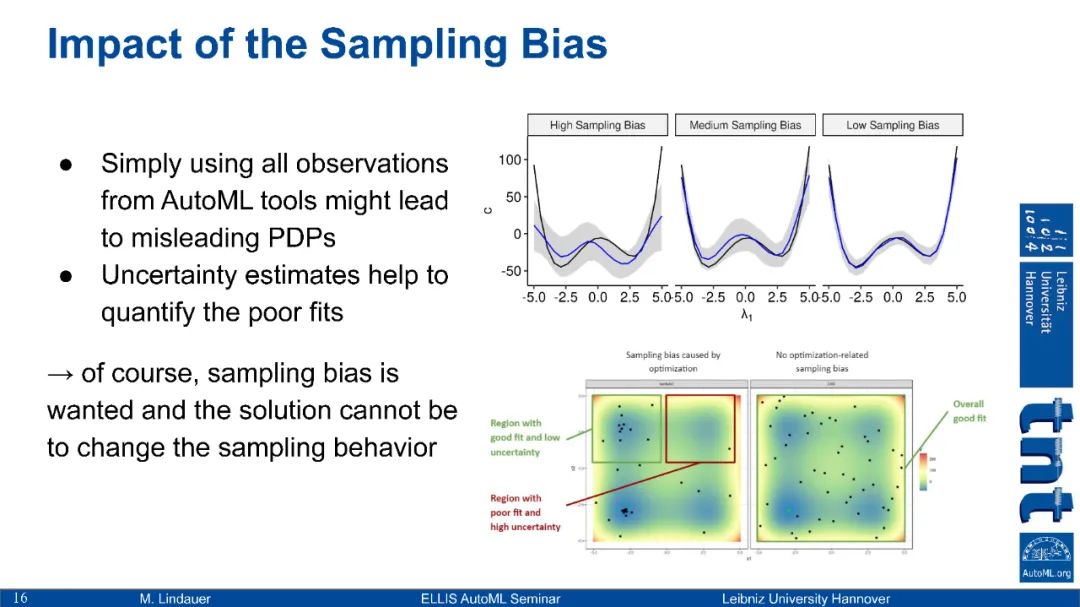

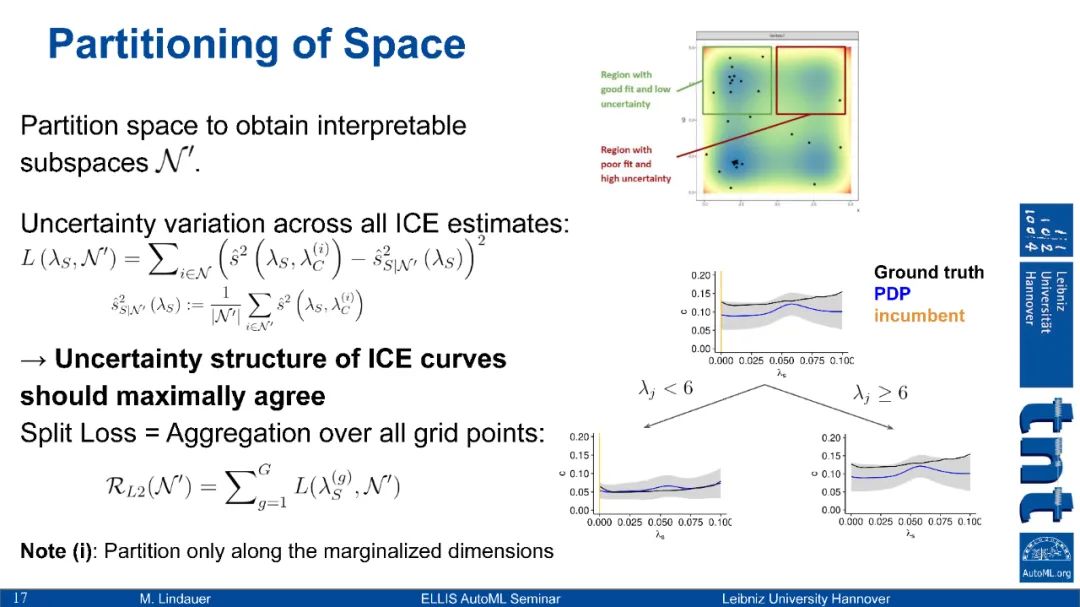

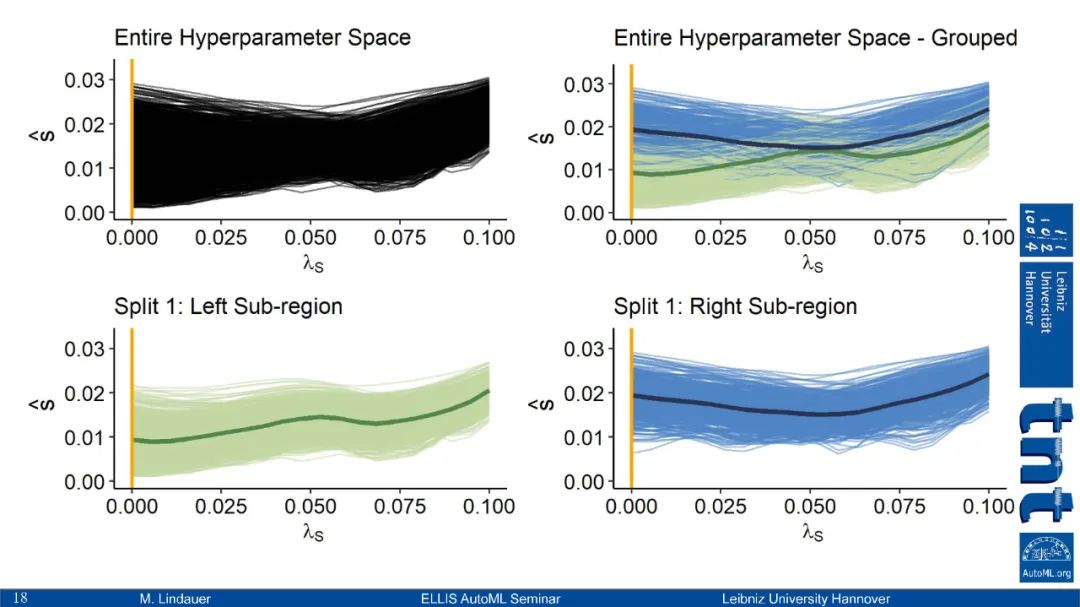

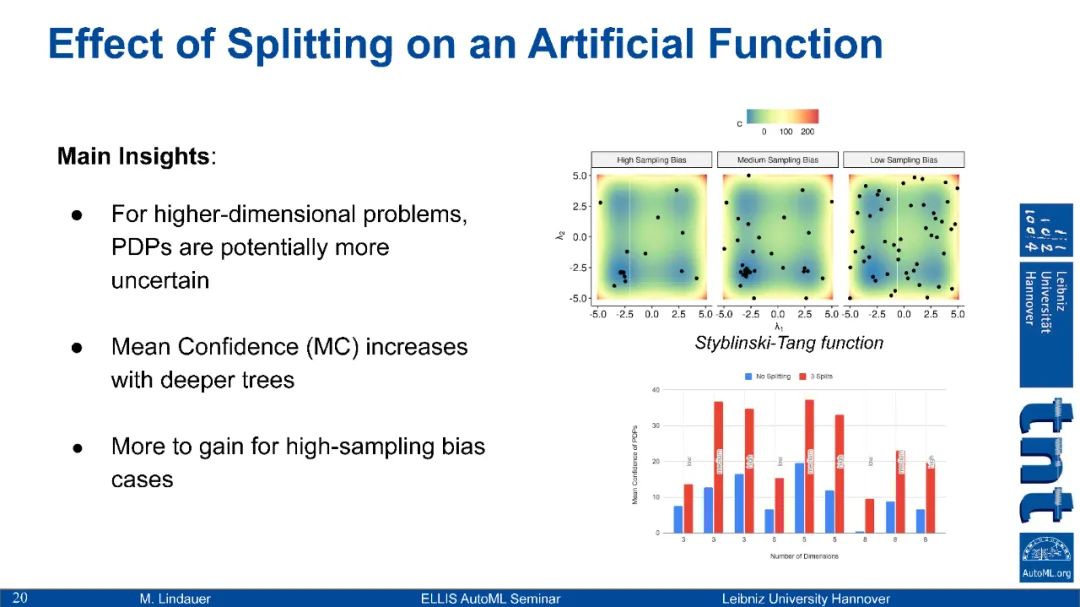

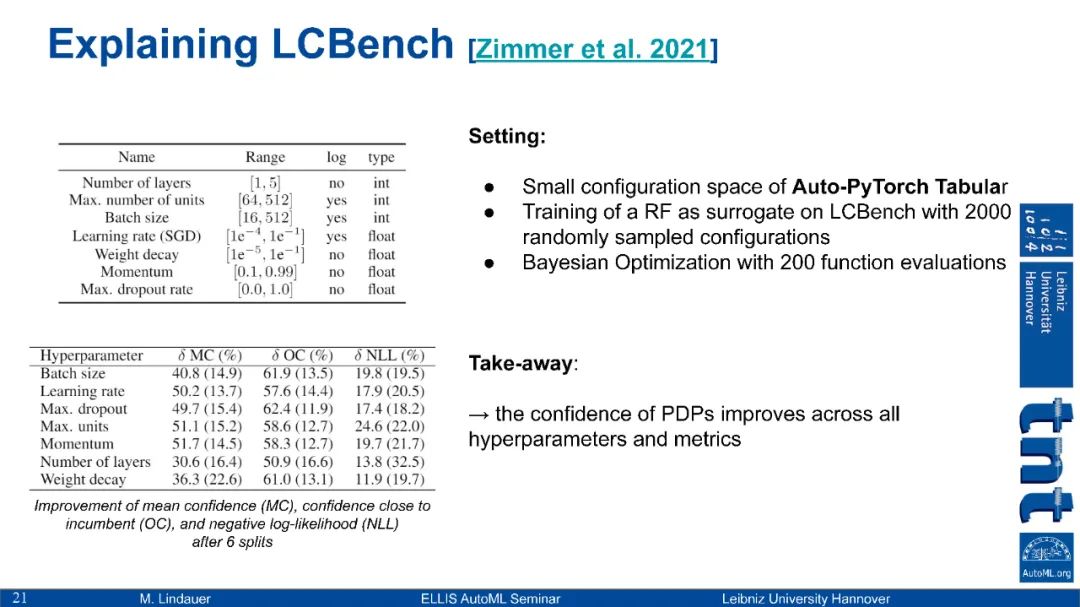

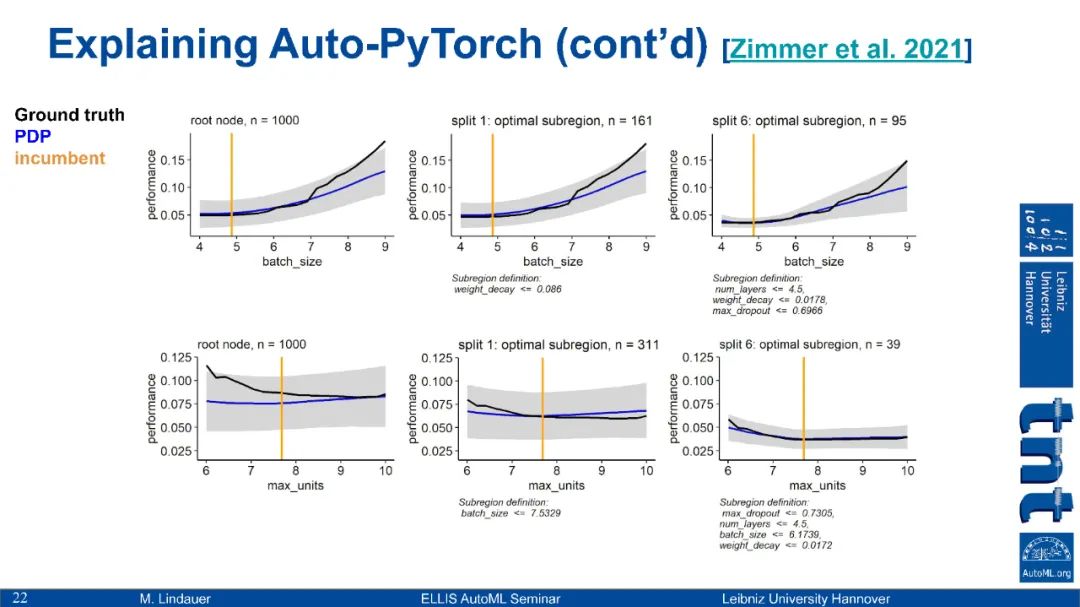

超参数效果的可视化: 我们如何可视化更改超参数设置的效果,无论是局部的还是全局的?[Hutter等人2014,Biedenkapp等人2018]

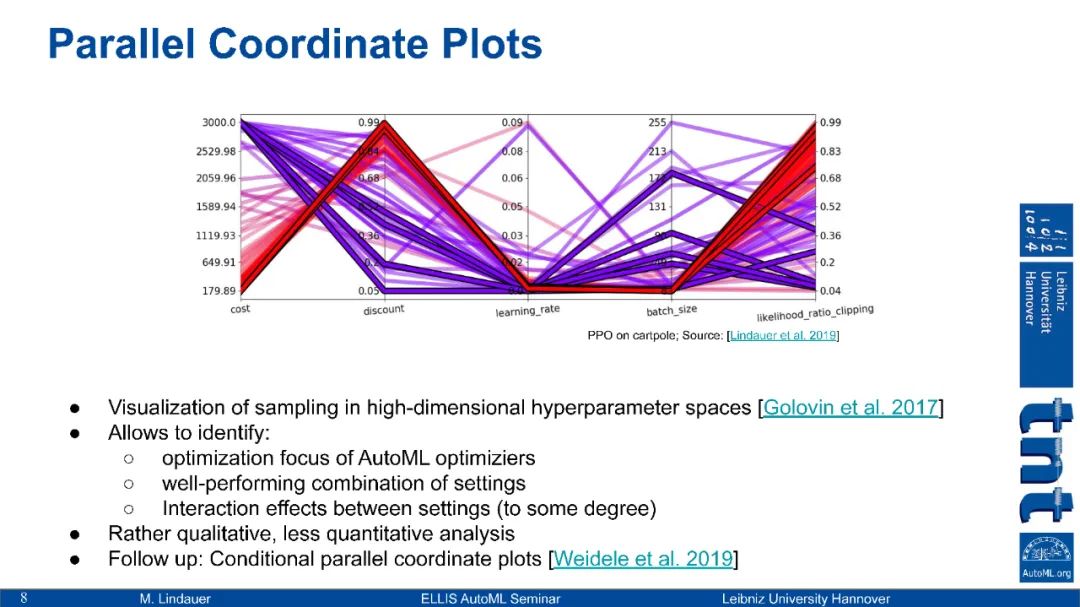

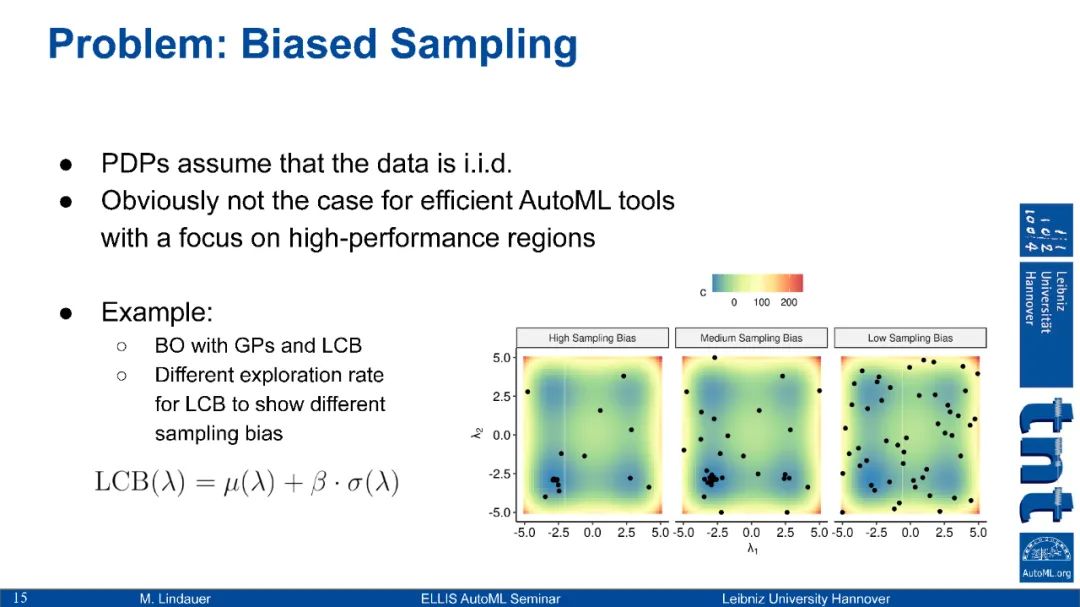

采样过程的可视化: 在配置空间的哪些区域有一个AutoML工具在什么时候采样,为什么采样?我们在那儿能看到哪场演出?[Biedenkapp等人2018]

https://www.automl.org/xautoml/

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“XAUTOML” 就可以获取《【XAUTOML】可解释自动机器学习,27页ppt》专知下载链接

登录查看更多

相关内容

Arxiv

0+阅读 · 2021年6月18日