吴恩达发布了大型X光数据集,斯坦福AI诊断部分超越人类 | AAAI 2019

数栗子 发自 凹非寺

量子位 报道 | 公众号 QbitAI

最近,吴恩达的斯坦福团队发布了一个叫做CheXpert的大型数据集,论文中选了AAAI 2019。

它包含了224,316张标注好的胸部X光片,以及放射科医师为每张胸片写的病理报告。

虽然,像从前NIH发布的ChestX-ray14数据集那样,CheXpert也是根据医师的报告,自动标注肺水肿、心脏肥大等各种病症的;

但团队说,新的数据集更适合做Benchmark,因为测试集上的标签,是经过 (持证上岗的) 放射科医师验证的标签。

团队便是用这个数据集做Benchmark,举行了一场5种疾病的识别比赛。

数据集是怎样炼成的

这22万张胸片,都是2002年10月到2017年7月之间,斯坦福医院做过的X光检查,来自65,240个就诊的人类。

有哪些标签

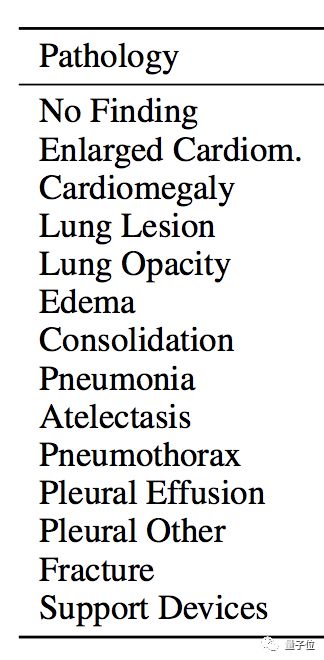

每张胸片有14个标签要贴,其中12个,是表明患者是否存在心脏肥大 (Cardiomegaly) 、肺部病变 (Lung Lesion) 等12种疾病特征。

另外两个标签,一个是无发现 (No Finding) ,另一个是辅助器具 (Support Devices) 。

14个标签,都分为阴 (Negative) 、阳 (Positive) 以及不确定 (Uncertain) 这三种选项。

因为,并不是所有问题,都能从胸片上得到确定的答案。如果不能做出明确的判断,就不可以贸然输出阴或阳。

自动标注工具

有了14个标签要贴,吴恩达团队开发了一种自动贴标签的算法:从医师每张胸片做的报告文本里,找到和每个标签相对应的信息。

算法分三步:

一是提取文中提及的信息 (Mention Extraction) ,得出一个列表;

二是为提及的信息做分类 (Mention Classification) ,分成阴、阳、不确定这三类;

三是把提及的信息聚合起来 (Mention Aggregation) ,得出最终结论,标注完成。

团队已经把标注工具开源了:

https://github.com/stanfordmlgroup/chexpert-labeler

人类医师验证一下

数据集要成为合格的Benchmark,测试集给的标准答案就要有说服力。

团队找到8位持证的放射科医师,让他们独立去标注500张胸片的测试集。然后,把5位医师给出的主流答案作为Ground Truth;至于,另外3位医师的答案,后面有其他用途。

这样一来,各路诊断模型都可以在一个相对有效的标准之下接受评估。

对比一下,从前的ChestX-Ray14数据集里,测试集是自动标注,并没有经过人类医师的鉴定。团队认为,CheXpert更加适合做Benchmark。

你也来比赛吧

既然提供了新的Benchmark,就可以拿来比赛。

吴恩达老师发推宣布,一场疾病识别比赛已经开始了,欢迎大家带着自己的模型去参加。

比赛内容涉及5种疾病的识别:

· 肺不张 (Atelectasis)

· 心脏肥大 (Cardiomegaly)

· 肺实变 (Consolidation)

· 肺水肿 (Edema)

· 胸腔积液 (Pleural Effusion)

为了鼓励小伙伴们前去参与,团队祭出了自家模型里成绩最好的一只:

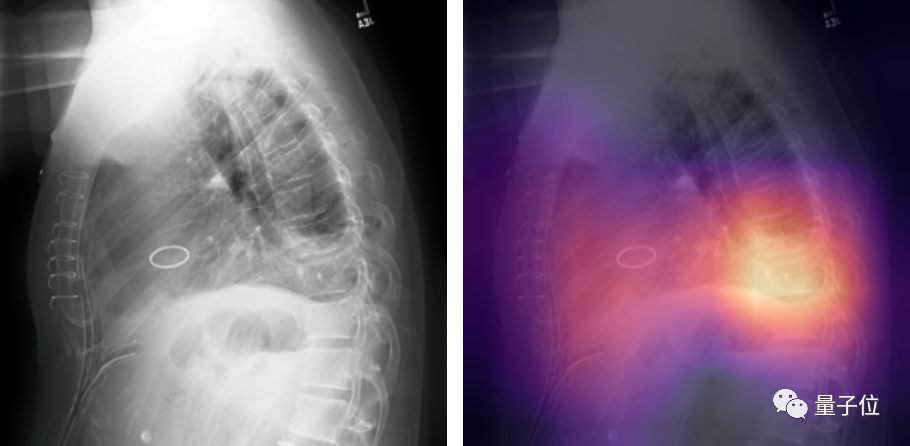

用500张胸片的测试集来比,这个模型在心脏肥大、肺水肿以及胸腔积液这三项上,超越了前面提到的“另外3位人类医师”。

若以粗暴的五局三胜为规则,AI已经赢了。

有兴趣的同学,可以去试试看自己的模型能不能超越斯坦福的AI。数据集和参赛方法都在这里啦:

CheXpert数据集传送门:

https://stanfordmlgroup.github.io/competitions/chexpert/

(注册一下,就会收到下载链接)

CheXpert论文 (AAAI 2019) 传送门:

https://arxiv.org/pdf/1901.07031.pdf

比赛参加方法传送门:

https://worksheets.codalab.org/worksheets/0x693b0063ee504702b21f94ffb2d99c6d/

作者系网易新闻·网易号“各有态度”签约作者

— 完 —

2018中国人工智能领航企业

加入社群

量子位AI社群开始招募啦,欢迎对AI感兴趣的同学,在量子位公众号(QbitAI)对话界面回复关键字“交流群”,获取入群方式;

此外,量子位专业细分群(自动驾驶、CV、NLP、机器学习等)正在招募,面向正在从事相关领域的工程师及研究人员。

进专业群请在量子位公众号(QbitAI)对话界面回复关键字“专业群”,获取入群方式。(专业群审核较严,敬请谅解)

诚挚招聘

量子位正在招募编辑/记者,工作地点在北京中关村。期待有才气、有热情的同学加入我们!相关细节,请在量子位公众号(QbitAI)对话界面,回复“招聘”两个字。

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态

喜欢就点「好看」吧 !