贝塔分布背后的直觉:概率的概率分布

编者按:贝塔分布的定义很简单,具有两个参数α、β(α,β > 0)的一组定义在(0, 1)区间的连续概率分布。但是,它背后的直觉却不是那么明显。Stack Overflow数据科学家David Robinson在Cross Validated解释了贝塔分布背后的直觉。

简而言之,贝塔分布代表probabilities(概率的复数形式)的分布,也就是说,它代表当我们不知道概率是什么时,概率的所有可能值。

所有看棒球的人都熟悉打击率这个概念,也就是安打数除以打数(因此,打击率是0到1之间的百分数)。.266是一个平均水平的打击率,而.300是一个优秀的打击率。

假设我们想预测某个棒球手在整个赛季的打击率。你可能会说,使用已有的打击率数据不就行了?但是在赛季刚开始的时候,这会是一个非常差的衡量指标,如果棒球手的打数只有几次,可能预测出棒球手的打击率为1.000或0.000这样的数字。

我们为什么知道上面的预测很糟糕?如果我们观察到棒球手在赛季一开始出现了一个三振,为什么没人会预测这个棒球手在整个赛季都拿不到一个安打?因为我们有先验知识,我们知道,在历史上,绝大多数棒球手的赛季平均打击率在.215到.360之间,有一些极端罕见的例外低于或高于这个范围。我们知道,如果一个棒球手刚开始出现了几个三振,那可能意味着他最终的打击率会比平均值低一点,但我们知道他大概不会偏离上面提到的范围。

我们的打击率问题可以表示为二项分布(一系列成功和失败),表示这些先验预期(在统计学上我们直接称为先验)的最好方式是贝塔分布——也就是说,在我们观测到棒球手的打击数据前,我们大致期望他的打击率会是这样的。贝塔分布的定义域为(0, 1),和概率一样,因此我们知道我们的路线是正确的——但是贝塔分布与当前任务的相关性远不止这些。

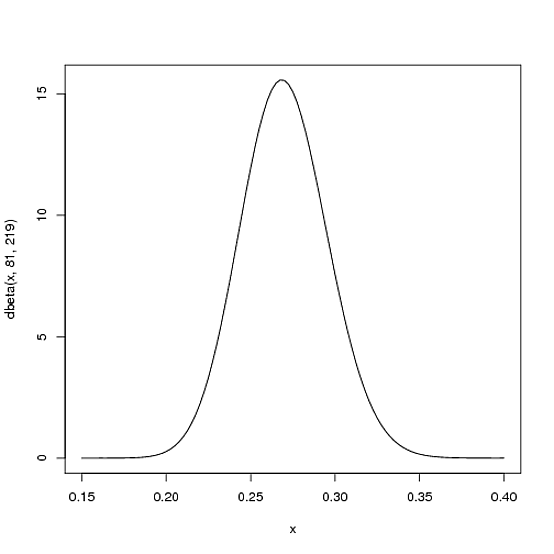

我们期望,棒球手整个赛季的打击率最有可能在.27附近,但.21到.35也很合理。这可以用参数α=81、β=219的贝塔分布表示:

curve(dbeta(x, 81, 219))

注意,分布的均值为α/(α+β) = 81/(81+219) = .270。

整个分布基本上完全位于(.2, .35)之间,对打击率而言,这个范围很合理。

在我们的例子中,贝塔分布的x轴代表打击率。因此,不仅y轴代表概率(更准确地说,概率密度),x轴也代表概率(打击率是安打的概率)!贝塔分布是概率的概率分布。

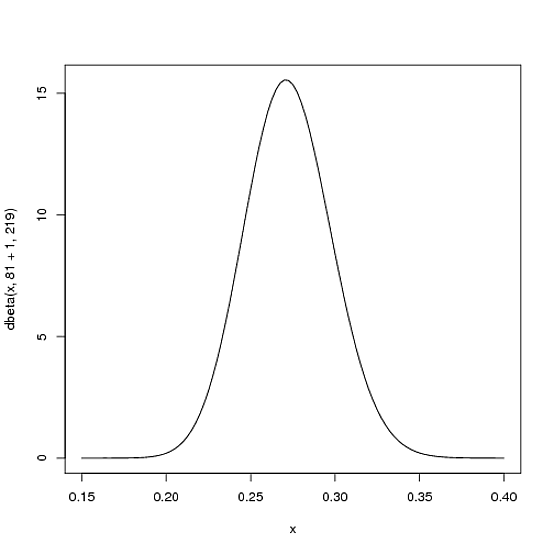

接着我们讨论为什么贝塔分布非常合适我们的问题。假设棒球手完成了一个安打。当前赛季的记录为安打 1;打数 1。我们需要更新概率——我们希望略微移动整个曲线以反映我们新获得的信息。尽管相应的数学证明有点复杂(证明见此),结果非常简单。新的贝塔分布将是:

Beta(α0+hits,β0+misses)

其中,α0和β0是刚开始的参数81和219。因此,在这一情形下,α增加了1(1次安打),而β完全没有增加(目前还没有落空)。这意味着我们的新分布是Beta(81+1,219):

curve(dbeta(x, 82, 219))

注意上面的图像基本上没有变动——肉眼观察不到改变!(这是因为一个安打其实说明不了什么。)

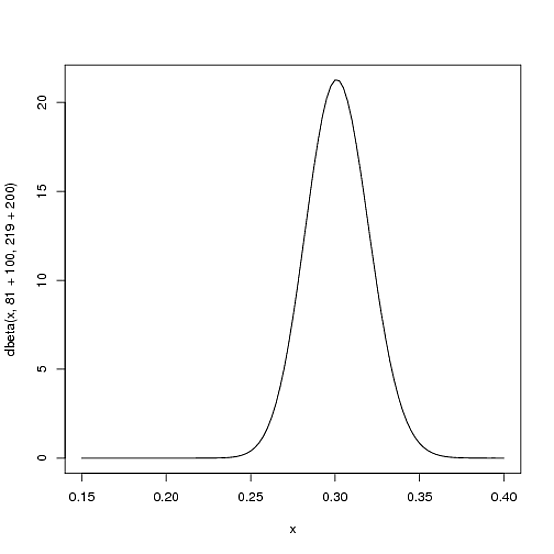

然而,随着赛季的进行,棒球手的安打数越多,曲线为了适应新证据所作的移动也会越多,而且,由于我们有更多的证据,它会收拢。比如,到赛季的一半,球手的打数达到了300,其中有100个安打。新的分布会是Beta(81+100,219+200):

curve(dbeta(x, 81+100, 219+200))

注意,和原来相比,现在曲线变得更狭长了,同时向右侧(更高的击打率)移动了。我们对球手的打击率更有概念了。

基本上,所得贝塔分布的期望值,就是我们新的估计。回顾一下,贝塔分布的期望值为α/(α+β)。因此,在真实打数为300,安打数为100的情况下,新贝塔分布的期望值为(81+100)/(81+100+219+200) = .303。注意它比朴素的估计值100/(100+200) = .333要低,但比赛季开始前的估计值81/(81+219) = .270要高。你可能会注意到,这一等式等价于球手加上“提前开始”的安打数和落空数——也就是说“在赛季开始时,球手已经有81安打、219落空的记录”。

因此,贝塔函数最适宜用来表示概率的概率分布——当你并不预先知道概率是多少,但具备一些合理的猜测的时候。