《生命3.0》作者泰格马克:人类和AI,谁是终极操纵者?

新智元 AI World 2018 世界人工智能峰会

全程回顾

新智元于9月20日在北京国家会议中心举办AI WORLD 2018世界人工智能峰会,邀请机器学习教父、CMU教授 Tom Mitchell,迈克思·泰格马克,周志华,陶大程,陈怡然等AI领袖一起关注机器智能与人类命运。

爱奇艺

上午:https://www.iqiyi.com/v_19rr54cusk.html

下午:https://www.iqiyi.com/v_19rr54hels.html

新浪:http://video.sina.com.cn/l/p/1724373.html

新智元AI WORLD 2018

演讲:Max Tegmark

整理:肖琴

新智元 AI World 2018 世界人工智能峰会

全程回顾

新智元于9月20日在北京国家会议中心举办AI WORLD 2018世界人工智能峰会,邀请机器学习教父、CMU教授 Tom Mitchell,迈克思·泰格马克,周志华,陶大程,陈怡然等AI领袖一起关注机器智能与人类命运。

爱奇艺

上午:https://www.iqiyi.com/v_19rr54cusk.html

下午:https://www.iqiyi.com/v_19rr54hels.html

新浪:http://video.sina.com.cn/l/p/1724373.html

新智元AI WORLD 2018

演讲:Max Tegmark

整理:肖琴

【新智元导读】在新智元AI World 2018世界人工智能峰会上,MIT物理系终身教授、未来生命研究所创始人、《生命3.0》的作者Max Tegmark作了《人类如何通过人工智能“赋能”,而不是被其“操纵”》的研究,Tegmark认为,我们应该认真思考未来,思考如何引领技术发展的方向,让AI会增强人类,而非操纵人类。

震撼!AI WORLD 2018世界人工智能峰会开场视频

9月20日,在新智元AI World 2018世界人工智能峰会上,MIT物理系终身教授、未来生命研究所创始人、《生命3.0》的作者Max Tegmark分享了他对“更远的未来”的想法。

Tegmark在他的畅销书《生命3.0》中设想了一个具有发展阶段的生命历程。生命1.0就是最原始的生命形式,如细胞,生命只是在不停复制。

到了生命2.0阶段,这是人类所在的地方:人类能够学习,适应不断变化的环境,并能有意地改变这些环境。但我们还不能改变我们的身体自身,不能改变我们的生物遗传。Tegmark 将这种对比比喻成软件和硬件之间的对比。

第三个阶段,即生命 3.0 阶段。在这个阶段,我们把人工智能用于所有任务,也就是所谓的AGI(通用人工智能)。人类不仅可以重新设计自身的软件,还可以重新设计自身的硬件。

Tegmark说,我们现在技术发展和AI发展的现状非常复杂,但是有一点可以确定,就是大多数的研究员在某种程度上已经能够建立AGI,AI在很多任务上已经能做得比人类更好。当然,这也是非常有争议的部分,可能会带来技术的爆炸。

Tegmark表示,如果考虑未来可能面临的挑战,这会是人类历史上犯下的一个巨大的错误。但是因为技术是如此的有力,我们在实现技术能力的道路上会犯下很多错误。我们应该如何引导技术的发展,为人类创造一个非常美好的未来,这是美国、中国以及所有国家都应该思考的问题。

以下是Max Tegmark在新智元AI World 2018世界人工智能峰会上的演讲实录,他的演讲主题是《人类如何通过人工智能“赋能”,而不是被其“操纵”》。

Max Tegmark:非常高兴能够来到这里,前面几位嘉宾已经谈了很多最近AI的惊人发展,以及在不久的未来我们期望看到的AI的进一步发展。接下来我就和大家谈一谈更远的未来。

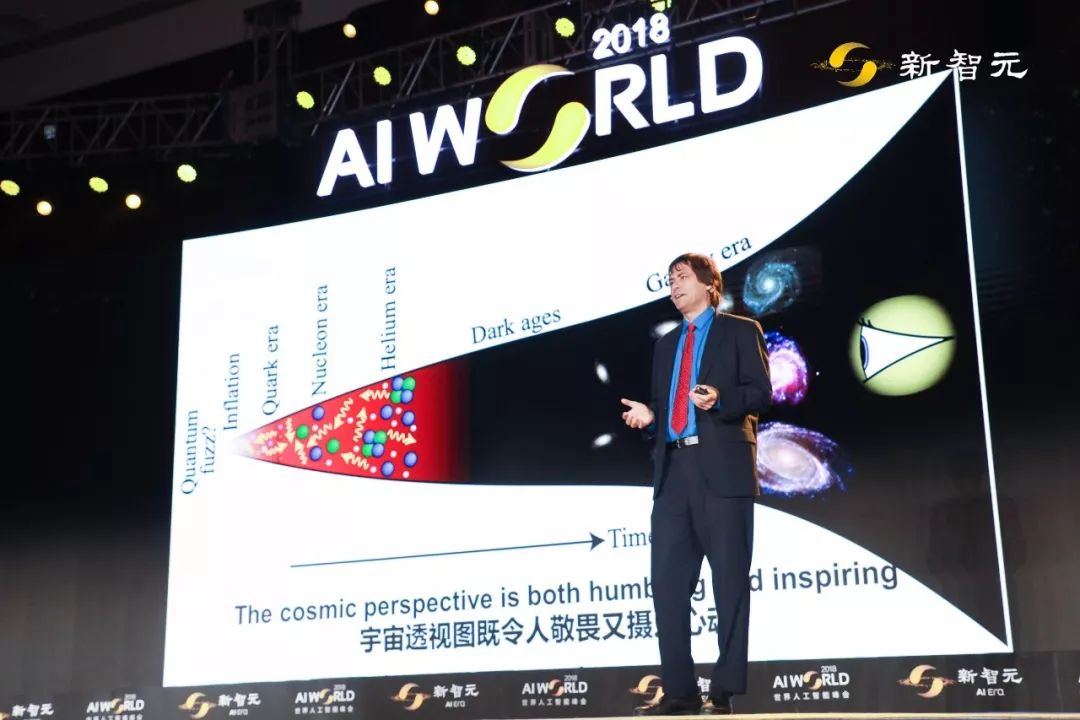

首先让我们回顾一下AI在宇宙透视图当中的位置,宇宙是从哪里来的呢?我们是怎么成为现在的自己呢?怎样从一个非常小的行星,形成了一个巨大的宇宙?我们用望远镜也可以看到,整个宇宙是非常巨大的,尽管是地球给了我们生命,但宇宙似乎仍旧不被我们所理解,宇宙实际上让我们敬畏。

我们正在研发的技术能够帮助我们去了解生命,不仅仅是几个世纪以前,甚至是几十亿年以前的生命。

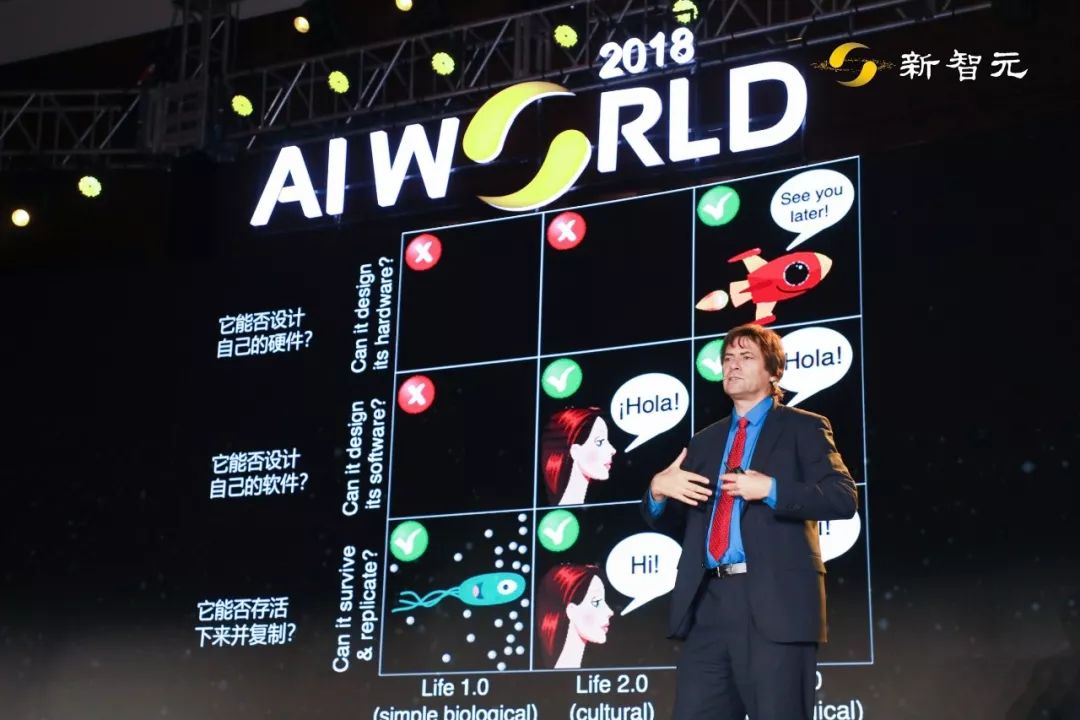

我把最早的生命称作生命1.0(Life 1.0),因为它是最原始的生命形式,例如细胞,这一阶段的生命无法学习。

我把人类生命称作生命2.0(Life 2.0),我们已经可以学习了,而且可以 在我们的大脑中安装新的软件,比如语言、工作技能。所有这些使人类成为成为世界上最强大的物种。

在生命3.0(Life 3.0),我们不仅能够开发软件,而且能够开发硬件。当然,Life 3.0现在还不存在。不过或许技术已经发展到Life 2.1的阶段,创造出人工义肢、心脏起搏器等等增强我们身体的硬件。

那么,让我们看一下我们与技术的关系。

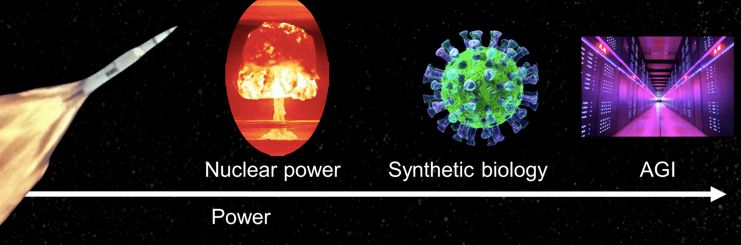

我们的世界是非常神奇的,我们知道如何明智地使用技术去实现我们的梦想。例如发射火箭,我们知道如何给火箭的方向定位,如何达到那个目标,所以我们就需要动力、方向和目标。

但还有一段更鼓舞人心的旅程,它的动力比火箭的发动机更强大,它的乘客不仅是宇航员,而是整个人类。

我们要谈论的是人类整体去往AI的未来的旅程。对于发射火箭来说,光有动力还不行,我们要知道它的方向和目标。对于AI也是如此,接下来我们将谈论AI的动力、方向和目标。

什么是智能?智能就是去完成复杂目标的能力,目标越复杂我们就需要越多的智能。智能分为两种:生物智能和人工智能。

智能就是关于所有信息处理的能力,不管是用大脑细胞的碳原子来处理,还是用GPU的硅原子还处理,或者其它我们创造出来的技术。

AI的发展如此迅速,让人振奋。不久前我们还没造出会走路的机器人,现在机器人已经会做后空翻了;不久前我们还没有做出无人驾驶汽车,现在已经有自主的火箭了,它能够自己着陆。不久前还不能用AI进行人脸识别,现在AI不久能很好地实现人脸识别,还能模拟和创造假的人脸。

不久前AI还不能在围棋中胜过人类,但现在,正如你们知道的,AlphaGo已经打败了世界上最厉害的围棋手,那还是使用很多人类经验、经过很长时间训练的。后来的AlphaZero甚至完全不使用人类经验,仅仅自我训练了24小时,最终诞生出世界上最好的围棋AI。

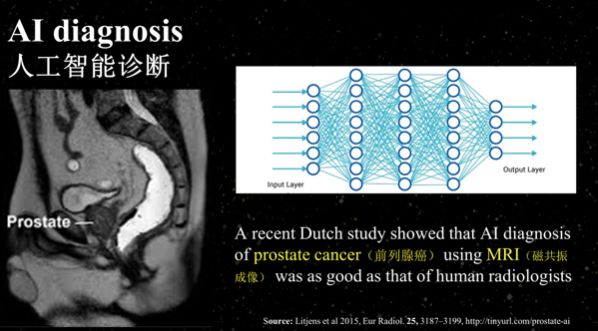

所有的这些进步实际上会带来一些商业化的应用,比如关于医疗,利用AI去诊断前列腺癌、肺癌和眼部疾病方面,甚至做外科手术,AI可以帮助我们实现目的。

我们说了很多AI方面取得的进展,这就提出一个基本的问题:AI能够帮助我们做什么?AI会给中国带来哪些好处?当然,肯定是能够让中国的商业更加发达,也帮助中国的企业更加富有,比如如何通过AI改善教育、养老、医疗保健等等,可以让我们过得更加幸福。

但在更远的未来呢?这些技术能够持续到多远的未来?未来会发生什么?

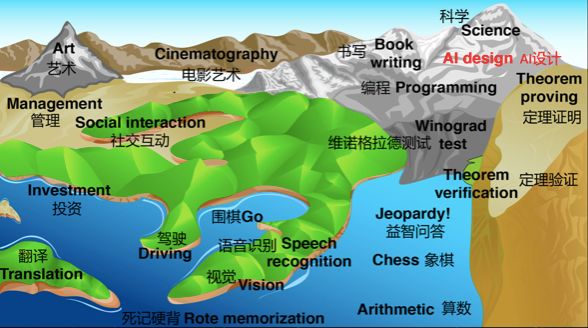

对于“人工智能取代人类”的担忧,从来都不是没有来由的。我现在用人类能力地形图来说明这个问题。

图中的海拔高度代表了AI在执行这些任务时达到人类水平的难度,海平面则表示了当下AI所能达到的水平。海平面会随着AI的进步上升,所以在这张地形图上,会发现类似“全球变暖”的变化。我们显然要避免那些近海区的工作,这些工作迟早会被人工智能取代。

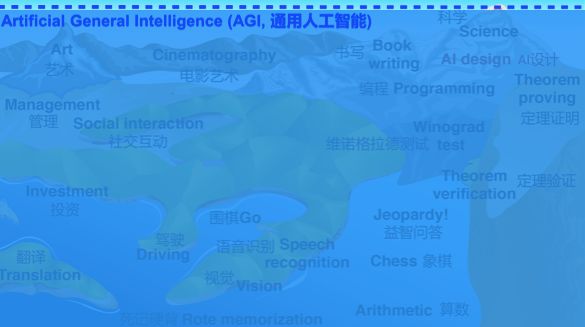

那么一个问题是:AI最终将上升到多高的地方?海面最终会将所有的陆地覆盖吗?像下面这张图这样,AI在几乎所有任务中都达到了人类水平?

这就是通用人工智能(AGI)的定义。可能有人会说:“还有很多事情是人类做得比机器好的!我们永远不会到达AGI!”

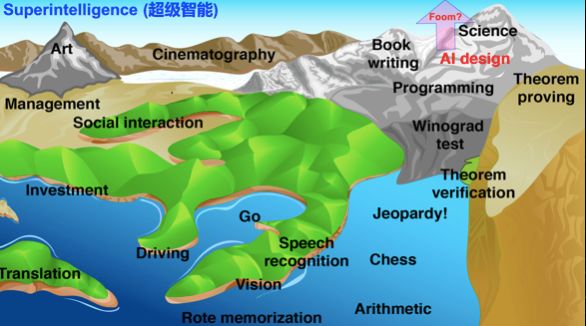

如果你认为AGI只是科幻故事,还有一种更疯狂的观点我们需要谈一下,就是超级智能(super intelligence)。因为如果我们成功制造了AGI,那么从定义上来说,AI在所有工作上都比人类做得更好,包括在AI设计的工作上。

当然,这也是一个非常有争议的部分,可能会带来技术的爆炸,因为我们一直去让AI提升,最终可能AI会比人类做得好很多。

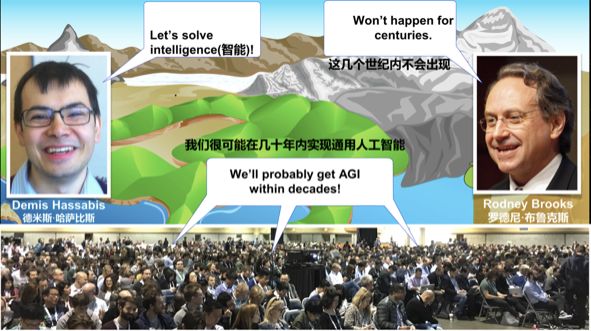

AI领域专家对此有不同的观点。例如Rodney Brooks,他认为再过几个世纪也不会出现AGI。但Demis Hassabis的观点就更积极,认为AGI会实现,而且要更努力研究使其实现。

此外,最近的一项调查显示,大部分AI研究人员和Demis Hassabis的观点是一致的,认为AGI能实现,可能是在50年后。

虽然没有确定的答案,但思考这个问题是很重要的。如果机器能够做任何事情,那还要人干什么?这对人类意味着什么?所以我们面临着一种选择:要么就是非常满足于此,我们构建这些机器让它们来代替人类做所有事情,不用考虑后果如何。

但我认为我们应该更有野心一些。在令人鼓舞的高科技未来面前,我们应该试着掌舵它的方向。

现在让我们来到火箭发射的“Steering”(方向)部分。我们已经让技术越来越强大,你们该如何引导技术,让技术帮助人类进步?

我和其他科学家一起成立了未来生命研究所。我们的目标很简单,就是让未来的生活更加激励人心、鼓舞人心。

我喜欢技术,我认为今天的世界比明朝的时候好,正是因为我们拥有技术。我很乐观地相信我们将建成一个非常高科技的未来,只要我们最终赢得这场竞赛。什么竞赛呢?就是越来越强大的科技和人类掌控这些技术的越来越强大的智慧之间的竞赛。

要赢得这场竞赛,人类需要改变策略。过去我们一直是从错误中学习。比如刚开始我们发明了火,经历了无数火灾之后,我们发明了灭火器。我们发明了汽车,出了几次车祸事故之后,我们又发明了红绿灯、安全气囊、安全带等等,以及一系列交通法规。

从错误中学习是好的,这让科技朝着造福人类社会的方向发展。

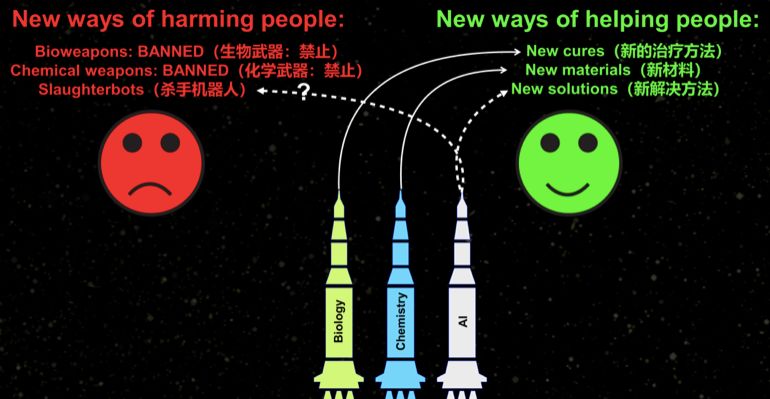

但随着技术变得越来越强大,最终会达到一个点,这是你不能再从错误中学习了。比如核武器,没有人会希望俄罗斯和美国爆发一场核战争,然后说让我们从这场错误中学习,以后要更加小心,云云。更好是主动前瞻,在一开始就做正确的事情。

在开发更强大的AI时,我们也应该有这种前瞻意识。这看起来是理所当然的想法,但有趣的是,有时候会有人跟我说:“马克,你不要说那样的话了,你那是在散布恐慌。”

这不是制造恐慌,在MIT,我们把这叫做“安全工程”(safety engineering)。

比如,在美国航天局部署阿波罗11号任务之前,在中国发射自己载人卫星之前,他们都会仔细地设 想所有可能出错的状况,毕竟是要把人类放进易燃易爆的太空舱里,再将他们发射上一个无人能助的境遇。这是在制造恐慌吗?不,那正是在做安全工程,以确保任务顺利进行,这正是处理通用人工智能或其他强有力的科技时应该采取的策略。

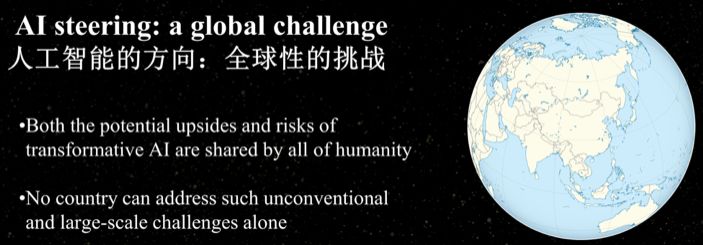

人工智能的方向其实是一个全球性的挑战,就像气候变化一样,这些问题让单个国家解决可能是非常难。我认为中国实际上以一个非常独特的地位在引领AI的发展,不仅是让AI更加强大,也让AI带来好处。为什么这样说呢?因为中国是全球AI技术的引领者,中国在这个领域的研究不仅关注让AI更加强大,而且保证AI是安全和有益于人类的。

此外,我认为中国的文化也有利于AI。因为中国是人类最古老的文明,有着非常强大的长期思考和长 期规划的能力。我是西方人,大多数西方国家的人在别人谈论到长远计划或者未来的事情都会大笑,认为要真正到了那个时候才应该计划下一步的事情。但我们是要去考虑未来的,我们需要有中国人的智慧,把很多事情放到全球的议事日程上来,知道未来我们发展的方向。

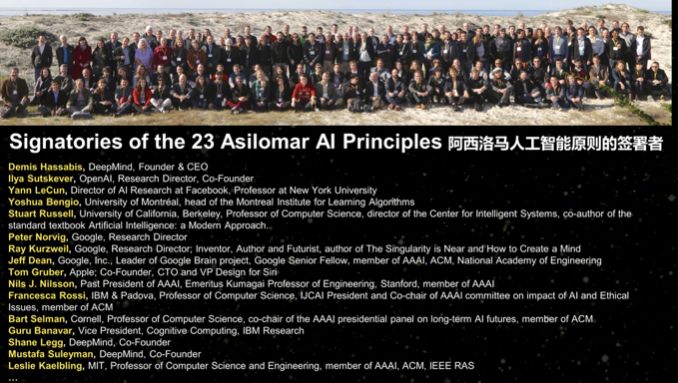

我们组织了阿西洛马人工智能原则会议。

其中的一个原则就是我们应该避免致命自主武器的出现和军备竞赛,应该帮助人类而不是危害人类,比如开发新的药品和材料,而不是去伤害人们。我们也应该保证AI能够给我们带来新的解决方案,而不是给人类带来灾难。

我们在西方做了一次调查,问他们要什么样的未来。很多人的回答是希望实现超级智能,但有些人会有些担心,有的人有一点保留。有的人担心最终机器会控制这个世界。

我认为“AI最终会变得邪恶”、“AI会拥有意识”,这些是不必要的担心,实际应该担心的是日益强大的AI与我们的目标不一致。我想说的最后一个原则就是,如果我们要构建超级智能,它只能是为了全人类的好处而构建,而不是为了某个国家、某个公司或某个组织的益处。

那么我们的目标是什么?我们究竟要走向何方?

总的来说,我们与技术和未来AI的关系是非常复杂的,但大方向上很简单,就是大部分研究人员希望在某种程度上已经建立AGI,或者在50年后能够实现AGI。如果考虑未来可能面临的挑战,这会是人类历史上犯下的一个巨大的错误,但让我们面对它。因为AI技术是如此的强大,我们在实现它的道路上肯定会犯下很多错误。

另一方面,如果我们好好思考我们想要达到的目标是什么,找到如何引导技术方向的方法,我们就将创造出一个非常美好的未来。

这就是我们面临的选择。我们可以满足于现状,也可以更有雄心一些,思考如何引领技术发展的方向,思考我们要去往怎样的未来,创造一个真正让人兴奋的未来。我认为未来我们不是被AI控制,而是AI会增强我们。

新智元AI WORLD 2018

世界人工智能峰会全程回顾

新智元于9月20日在北京国家会议中心举办AI WORLD 2018世界人工智能峰会,邀请机器学习教父、CMU教授 Tom Mitchell,迈克思·泰格马克,周志华,陶大程,陈怡然等AI领袖一起关注机器智能与人类命运。

全程回顾新智元 AI World 2018 世界人工智能峰会盛况:

爱奇艺

上午:https://www.iqiyi.com/v_19rr54cusk.html

下午:https://www.iqiyi.com/v_19rr54hels.html

新浪:http://video.sina.com.cn/l/p/1724373.html