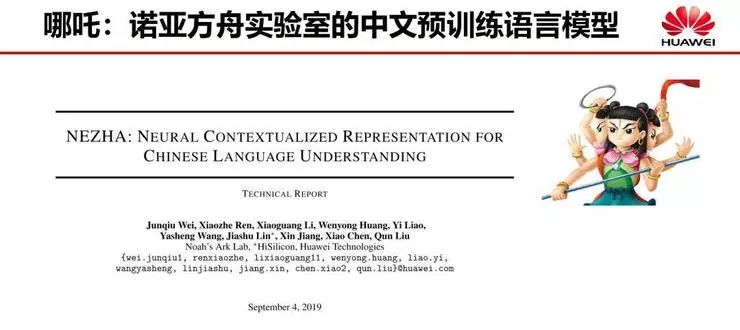

华为开源预训练语言模型「哪吒」:编码、掩码升级,提升多项中文 NLP 任务性能!

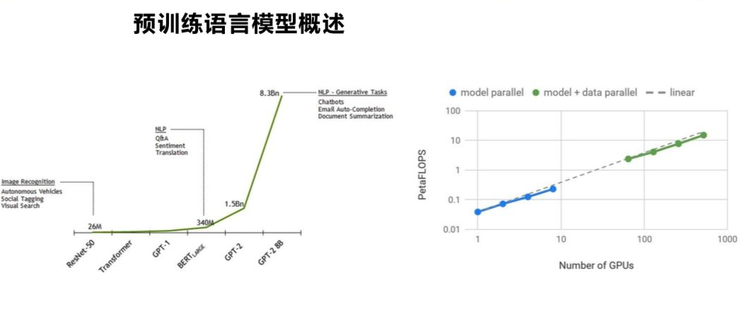

NEZHA 开发背景

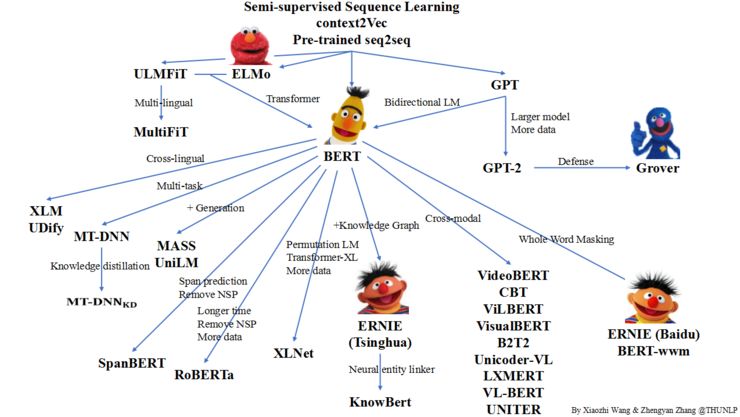

更多详细内容,可参见 PLM 论文整理 Github 项目地址: https://github.com/thunlp/PLMpapers

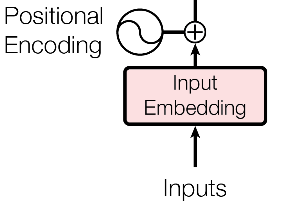

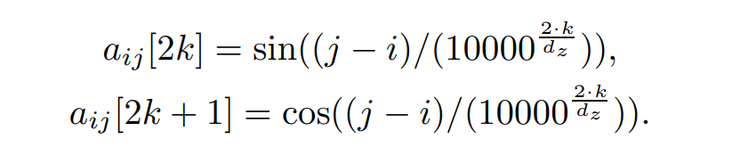

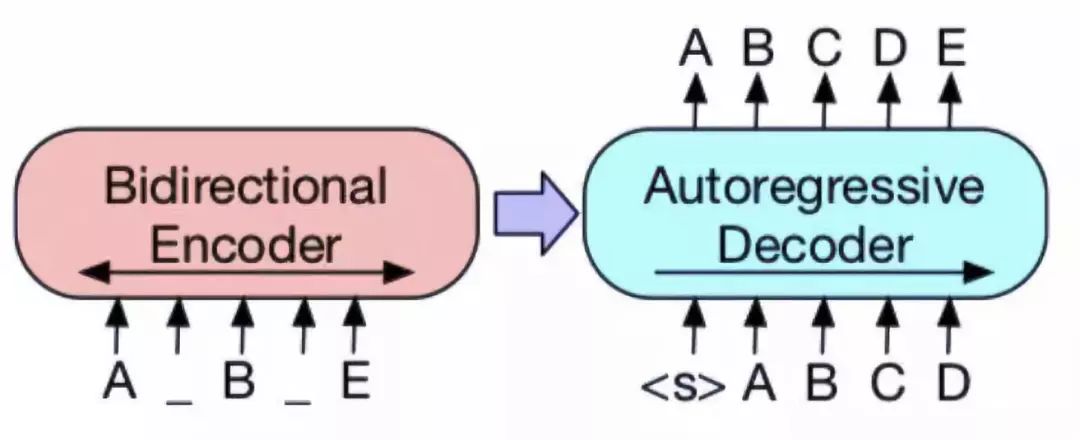

三头六臂 NEZHA(哪吒)

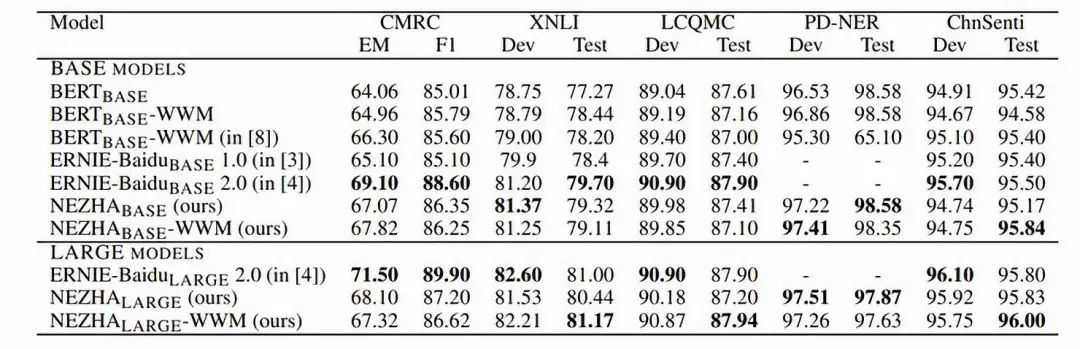

NEZHA 实验结果

更多详情,可参见 NEZHA 论文地址: https://arxiv.org/pdf/1909.00204.pdf 关于知识蒸馏模型 TinyBERT 详细解读,可参考往期内容: https://mp.weixin.qq.com/s/f2vxlhaGW1wnu8UYrvh-tA Github 开源地址(包含 NEZHA 与 TinyBERT ): https://github.com/huawei-noah/Pretrained-Language-Model

点击“阅读原文” 查看 NLP的游戏规则从此改写?

从word2vec, ELMo到BERT

点击“阅读原文” 查看 NLP的游戏规则从此改写?

从word2vec, ELMo到BERT

登录查看更多

相关内容

专知会员服务

21+阅读 · 2019年12月12日

UniViLM: A Unified Video and Language Pre-Training Model for Multimodal Understanding and Generation

Arxiv

19+阅读 · 2020年2月15日

Arxiv

15+阅读 · 2018年10月11日