Node2Vec:万物皆可Embedding

《Node2vec: Scalable Feature Learning for Networks》 KDD 2016,图神经网络经典必读第一篇,平衡同质性和结构性 。

2021年年初,图神经网络一举成为热门研究主题。AAAI2021年,录用了165篇论文。

那我为什么推荐Node2vec,而不是这165篇论文?

因为Node2vec作为图神经网络的经典必读篇目,应用也非常广泛,很多比赛分享中都有它的影子。

同时Node2vec是GNN图游走类算法中非常重要的一种,也是图神经网络算法工程师面试必备的知识点。

虽然网上有很多解读Nde2vec的文章和视频,及复现讲解。但自己复现总是会碰到很多的问题,如果跟随资深的GNN算法工程师,手把手教你一起复现,可以事半功倍。

这里推荐深度之眼 的《 Node2vec 复现班 》:

↓ 扫描上方二维码加班主任 ↓

↓回复:GNN 免费参加 ↓

深度之眼好评度超高的赵导师 结合自己工作及学习经验,并配合深度之眼教研团的打磨,总结出一条GNN基石论文 的 学习路径:

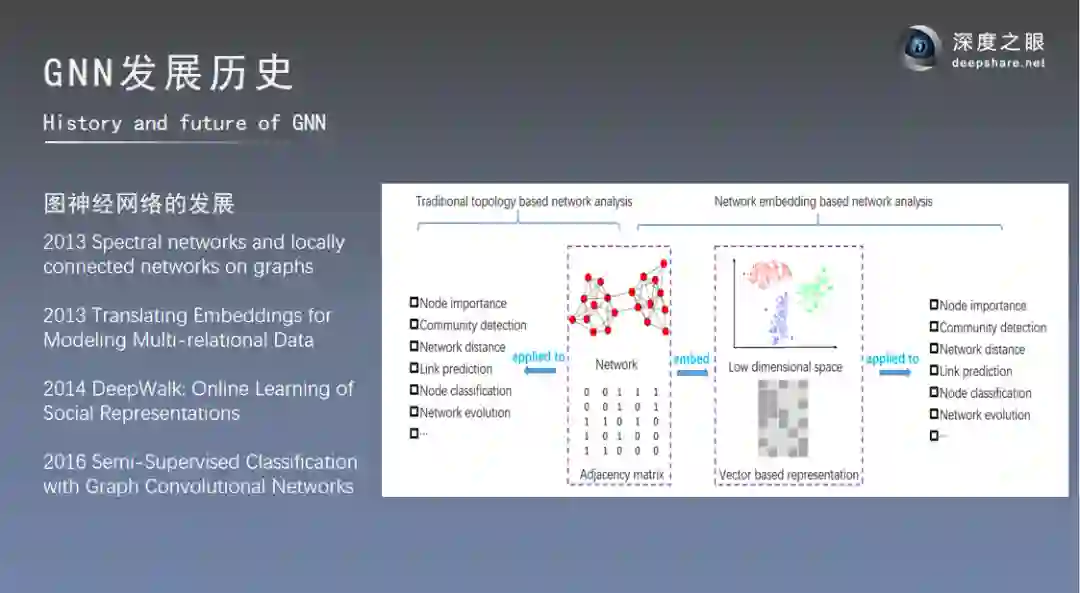

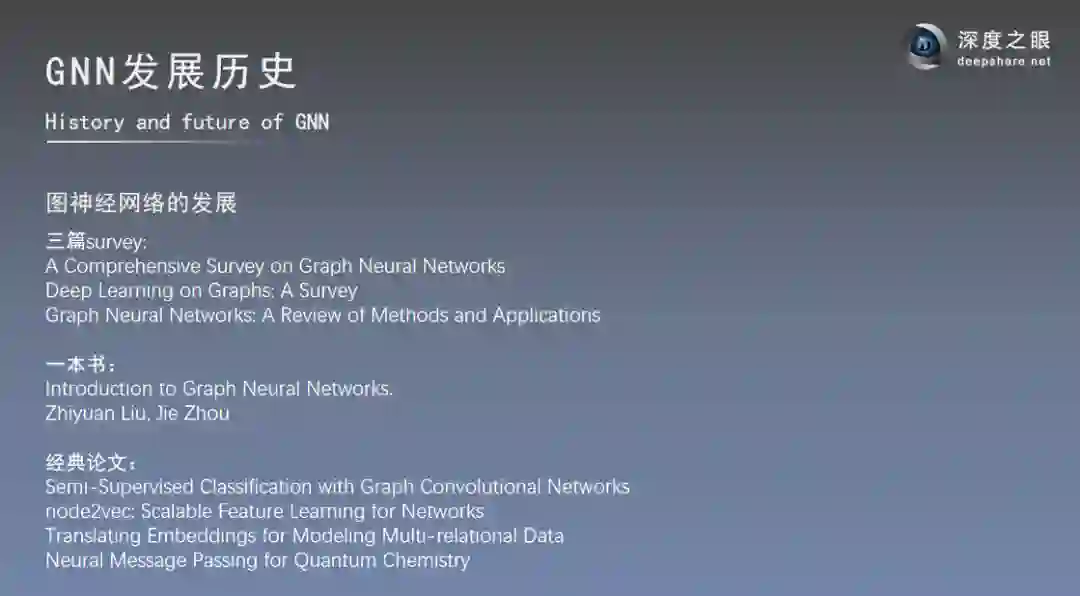

Step1:系统了解图神经网络技术演化路径及发展历史

Step2:精讲GNN开山之作 —Node2vec

Node2vec作为图神经网络最著名的模型之一,你可以掌握:

1. Node2vec模型实现,掌握图神经网络最基本的节点分类问题。

2. 一种非常高效的alias sampling采样方法。

3. 掌握random walk生成训练语料的方法以及基于pytorch的Node2vec实现。

1套系统的方法论:2步走教你啃透Node2vec

Step1:深挖研究背景

提纲挚领,从4大维度介绍论文,深入讲解论文发表的研究背景、成果及意义,介绍论文中取得的核心成果,对比解决同一问题,已有解决方法和论文中提出的新的解决方法的优缺点,熟悉论文的整体思路和框架,建立对本篇论文的一个概貌性认识。

Step2:死磕算法模型

老师会重点讲解论文中的模型原理,深入拆解模型结构,对关键公式逐步推导,让你了解算法每一个因子是如何对结果产生影响的,掌握实验手段及结果,老师会帮你拎出论文中的关键点、创新点和启发点,节约你自己摸索的时间。

· 3天高质量社群服务,导师全程陪伴

· 实时直播+录播,带你学习正确论文精读方法论

· 100+学员同群交流,学习经验up up⬆⬆⬆

· 助教24小时答疑,再也不怕debug

· 专属班主任私信督学,治疗学习拖延症

重点是,如果你不知道怎么学习,购买课程后,班主任1v1给你制定学习计划!

为了激励大家完成学习,我们还准备了价值298元的算法工程师面试锦囊。只要完成全部课程的学习,你就能私信班主任获取!

这一次,我为粉丝们申请了20个免费福利名额:

3天带你复现Node2vec

购买即赠《效率提升3倍的Paper阅读方法》

↓ 扫描上方二维码加班主任 ↓

↓回复:GNN 免费参与 ↓

如果你不知道怎么读论文、不知道如何正确复现论文,一定要跟着这门课程学习一次,因为正确的方法可以节约你10倍的阅读时间。