团队新作 | 自动化所ICPR2020“最佳学术论文”获奖成果介绍

【导读】日前,国际模式识别大会(ICPR 2020)以线上形式召开,各奖项评选结果在大会中正式发布,自动化所共斩获大会五项最佳学术论文奖( Best Scientific Paper Award)中的两项。同时,大会也为入选IAPR Fellow的自动化所蒋田仔研究员、赫然研究员正式颁发证书。下面,将与各位分享此次获得ICPR最佳学术论文奖的两篇文章。

01.基于相互指导双任务网络的场景文本检测

Mutually Guided Dual-Task Network for Scene Text Detection

从场景图像中检测文本由于图像背景复杂、文本方向和形状变化、光照和视觉变化等而具有较高的难度。目前的检测算法一般只能检测单词或者文本行,检测器在训练阶段也只能使用词级别或行级别标注的数据进行训练。这种将词检测和行检测区别对待的做法,忽视了两个任务之间的互惠性。实际上,我们可以利用其互惠性实现两个任务的相互指导、共同提高。

词检测和行检测是息息相关的。行检测器就像一个过滤器,可以将图片中的非文本区域过滤掉,在此基础上,词检测器只需要找到词语之间的间隙即可得到词检测结果。此外,词检测器可以为行检测器提供词语位置先验,在词检测器的帮助下,行检测器只需要将词语聚合成行即可得到行检测结果。

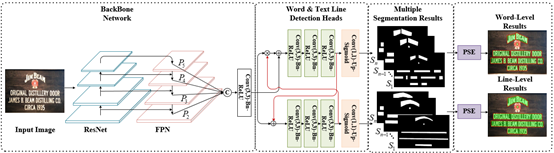

图1. 算法整体架构

两个任务对于词语间的像素的定义是不同的,因此使用一个网络对这两个任务进行联合训练会造成网络学习困惑。为了实现两个任务的联合训练,模式分析与学习团队提出了一种双任务网络(如图1所示),该网络具有两个检测分支,分别进行词级别和行级别的文本检测。此外,为了利用两个任务的互惠性提升彼此性能,团队提出了文本行过滤模块和词特征增强模块,从而实现了两个任务的相互指导(如图1中红线所示)。

团队在行级别和词级别标注的数据集上进行了实验,实验结果验证了双任务网络和相互指导策略的有效性。该方法只需要一次测试就可获得两种格式的检测结果,并得到更高的检测精度。检测效果的例子如图2所示

图2. 检测结果示例

Mengbiao Zhao, Wei Feng, Fei Yin, Xu-Yao Zhang, Cheng-Lin Liu. Mutually Guided Dual-Task Network for Scene Text Detection. In Proceedings of the 25th International Conference on Pattern Recognition (ICPR 2020).

02.基于对比关系网络的图像补全

Image Inpainting with Contrastive Relation Network

图像补全,是指对图像中缺失的区域进行内容补全,要求补全后的图像看起来自然逼真,在图像恢复、物体移除等领域具有广泛应用。传统图像补全算法使用残缺图片背景区域中的像素或图像块对缺失区域进行补全,而当图片残缺区域较大或待补全内容具有较复杂的语义结构时,这类传统算法的补全结果往往有明显瑕疵。近年来,研究人员利用卷积神经网络和生成对抗网络强大的表征学习和图像重建能力,提出了若干基于生成对抗网络的图像补全算法。然而,如何同时生成结构合理且纹理逼真自然的补全结果,仍是图像补全任务面临的一大挑战。

为了解决上述问题,智能感知中心团队提出了基于对比关系网络的图像补全算法。

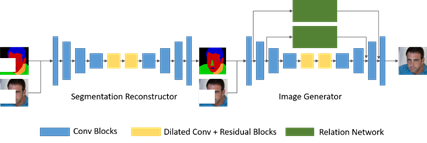

图1. 方法整体框架图

该研究利用补全网络的两个阶段分别解决前述要求:

1)首先利用分割重建网络预测残缺图像的完整语义分割图;

2)在第二阶段通过图像生成器恢复细粒度的图像细节。

第一阶段中补全的完整语义分割图对第二阶段的图像细节生成提供指导。

在第二阶段的图像生成器中,团队提出了一种基于图的关系网络,对残缺图像中存在的关系进行建模。在关系网络中,既考虑了同一语义区域内像素之间的内部关系,也考虑了不同语义部分之间的相互关系,以此来提高图像纹理的一致性和协调性。此外,为了促使关系网络中的图网络部分学习到更好的节点特征表示,团队提出了对比损失函数。对比损失函数通过扩大负样本对之间的特征差异,同时提高正样本对的特征相似度,来对图网络中的节点特征表示进行优化。

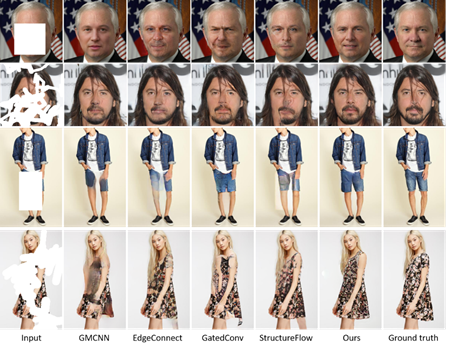

与最新相关算法相比,提出的方法不仅在定量实验中取得了更好的性能,同时在定性分析实验中实现了对残缺图像更逼真、自然的补全结果。

图2. 测试结果对比

Xiaoqiang Zhou, Junjie Li, Zilei Wang, Ran He, Tieniu Tan. Image Inpainting with Contrastive Relation Network. In Proceedings of the 25th International Conference on Pattern Recognition (ICPR 2020).

欢迎后台留言、推荐您感兴趣的话题、内容或资讯!

如需转载或投稿,请后台私信。