来自之江实验室和浙江大学的研究者提出了一种再注意机制,旨在更有效地捕捉目标级别的语义信息,抑制背景干扰,实现更准确的目标定位能力。

弱监督定位任务(Weakly supervised object localization, WSOL)仅利用图像级别的类别标签,就能实现目标级别的定位功能,因为其细粒度注释的最小化需求大大压缩了人工成本,于近年获得大量关注。

由于缺乏目标级别标签的约束,仅利用图像标签进行分类训练,弱监督定位方法往往倾向于只定位图像中最具判别性的局部区域,难以涵盖整个物体区域。弱监督定位方法的局部聚焦缺陷是否和卷积神经网络局部特征关联性相关?Transformer 类网络结构的长程依赖特性对弱监督定位有何影响?作者通过可视化分析 CAM 方法、纯 transformer 网络的长程特征依赖关系,发现 transformer 网络中的长程依赖有利于克服局部聚焦缺陷,却容易受到背景干扰。

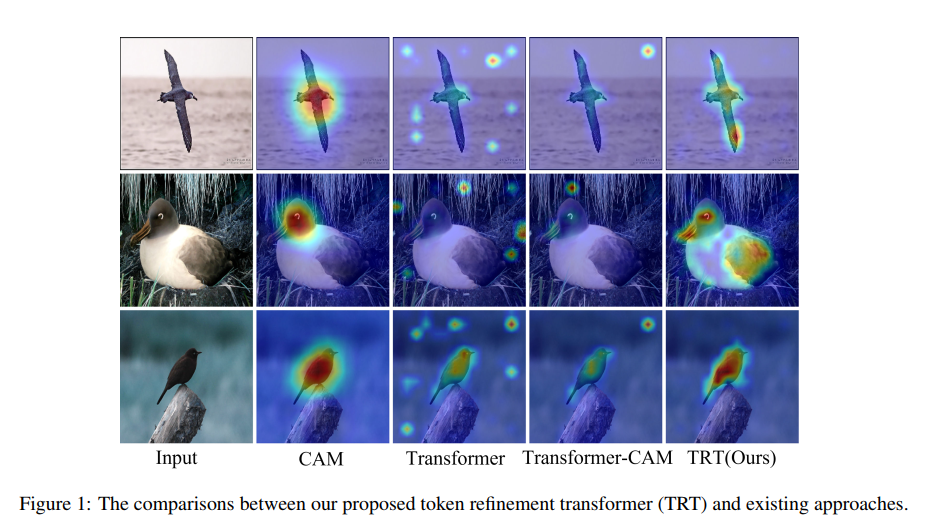

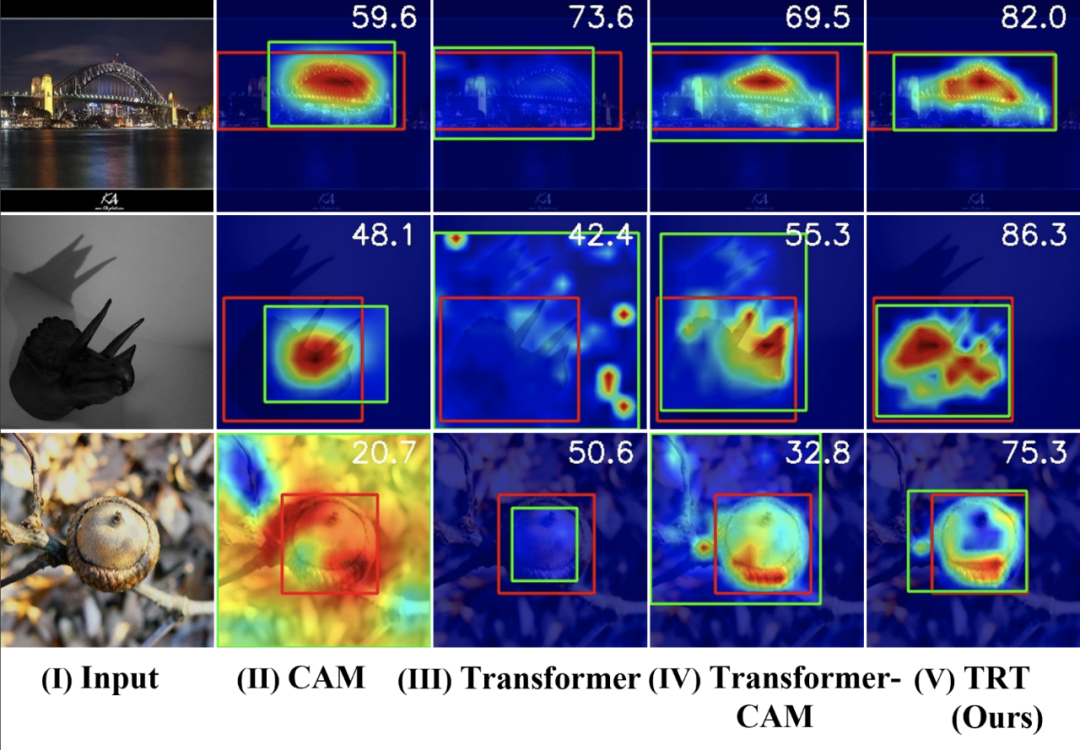

下图 1 展示了不同方法的可视化定位结果,可以看出 CAM 方法存在明显局部聚焦的问题;Transformer 的长程依赖容易产生背景误定位的现象;融合 Transformer 长程依赖和 CAM(参照 TS-CAM 论文方法)的方法虽然一定程度上缓解了局部聚焦和背景干扰的问题,但是问题依旧存在。

![]()

基于此,来自之江实验室和浙江大学的研究者提出一种再注意机制,即 TRT (token refinement transformer),旨在更有效地捕捉目标级别的语义信息,抑制背景干扰,实现更准确的目标定位能力。

![]()

![]()

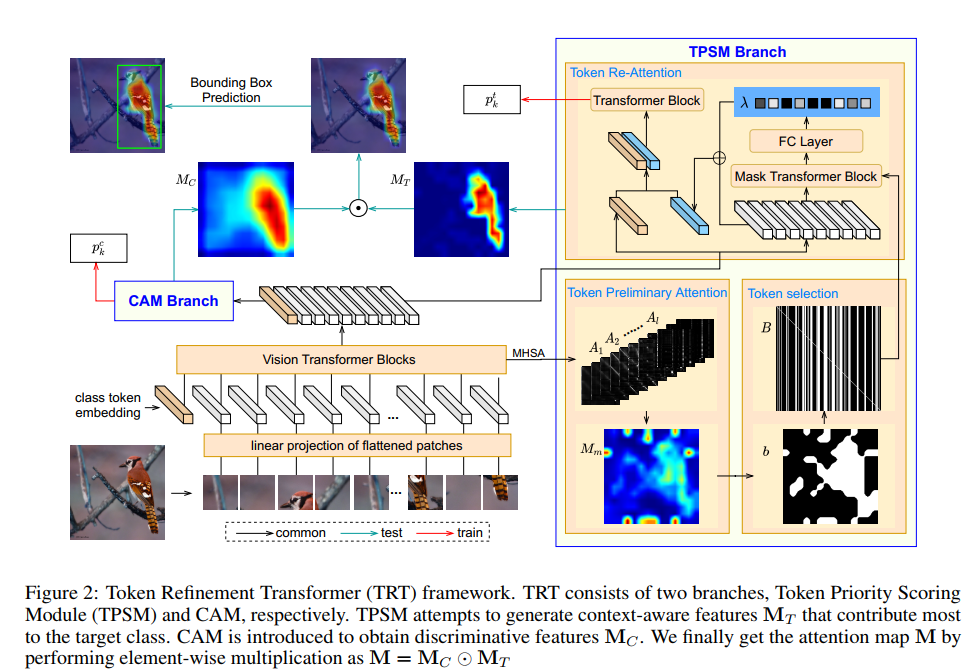

上图 2 展示了 TRT 方法的整体框架图,TRT 由 TPSM(Token Priority Scoring Module)和 CAM ( Class Activation Map ) 两个分支构成。其中 TPSM 分支主要由 Token Preliminary Attention、Token Selection 和 Token Re-Attention 三部分组成。Token Preliminary Attention 表示利用 transformer 网络不同层的 class token 和 patch token 之间的长程依赖关系构建初步注意力图;Token Selection 指构建自适应阈值策略,筛选出初步注意力图中与 class token 关联性更高的 patch token;Token Re-Attention 指对筛选的 patch token 执行再注意操作。

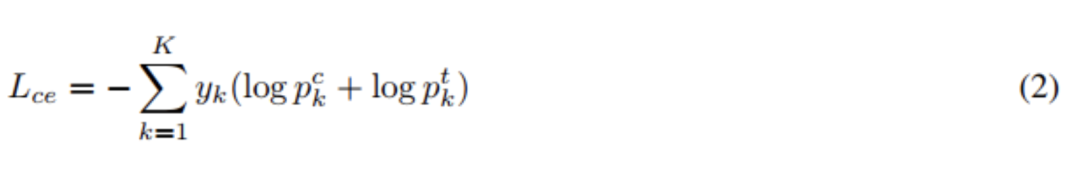

训练阶段,针对 CAM 分支和 TPSM 分支输出的分类概率

![]() 和

和

![]() ,与类别标签构建交叉熵损失函数,实现分类训练,如下公式(2)所示。

,与类别标签构建交叉熵损失函数,实现分类训练,如下公式(2)所示。

![]()

测试阶段,将 CAM 分支输出的特征

![]() 与 TPSM 分支输出的特征

与 TPSM 分支输出的特征

![]() 点乘,生成最终的注意力图M。

点乘,生成最终的注意力图M。

![]()

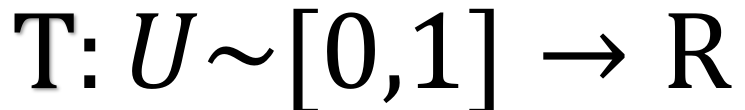

第 l 个 transformer 层的自注意矩阵公式如下式(4)所示,其中

![]() 的第一行为 class token 的注意力向量,展示了 class token 和所有 patch token 之间的关联关系。将所有层 transformer 层 class token 的注意力向量进行均值融合,得到初步注意力结果 m。

的第一行为 class token 的注意力向量,展示了 class token 和所有 patch token 之间的关联关系。将所有层 transformer 层 class token 的注意力向量进行均值融合,得到初步注意力结果 m。

![]()

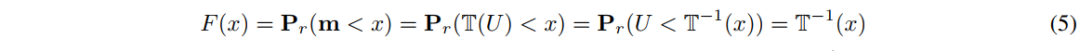

利用累积分布采样方法构建自适应阈值,具体操作为:对初步注意力结果 m 进行排序并构建积分图,针对积分图结果确定固定阈值,则针对 m 生成了自适应阈值。

操作原理如下式(5)所示,其中 F 为 m 的累积分布函数,严格单调转换![]() 为其逆函数。

为其逆函数。

![]()

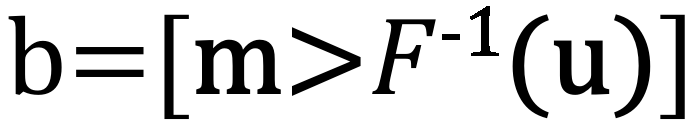

基于阈值生成二值图

![]() ,b 中值为 1 的位置表示被筛选的 patch token 的位置。

,b 中值为 1 的位置表示被筛选的 patch token 的位置。

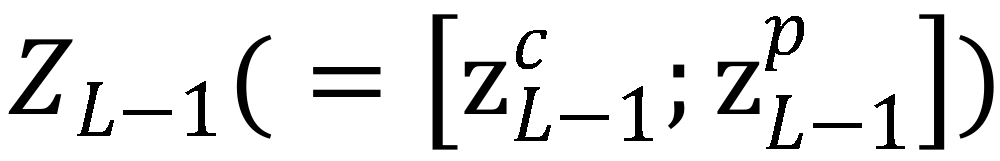

利用二值图 b 构建挑选矩阵 B,并基于矩阵 B 构建掩码自注意力操作。对图 2 中 visual transformer blocks 输出的特征

![]() 中 patch token 部分

中 patch token 部分

![]() 执行掩码自注意力操作,对操作结果进行全连接和掩码 softmax 操作,生成重要性权重 λ。

执行掩码自注意力操作,对操作结果进行全连接和掩码 softmax 操作,生成重要性权重 λ。

在训练阶段,利用重要性权重λ对

![]() 进行加权融合,将

进行加权融合,将

![]() 与融合结果送入最后一个 transformer 层。利用最后一个 transformer 层输出的 class token 生成分类概率

与融合结果送入最后一个 transformer 层。利用最后一个 transformer 层输出的 class token 生成分类概率

![]() 。

。

在测试阶段,从初步注意力结果 m 中获取未被筛选的 patch token 权重信息,从重要性权重 λ 中获取被筛选的 patch token 权重信息,由此生成

![]() ,如式(10)所示,m' 为

,如式(10)所示,m' 为![]() 的向量形式。

的向量形式。

![]()

![]()

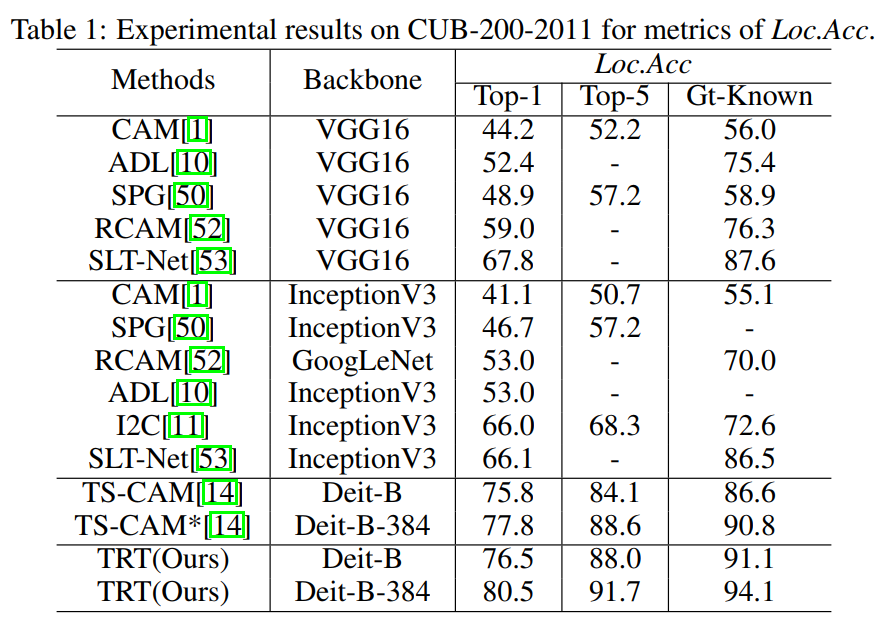

表 1:在 CUB-200-2011 数据集上的定位准确率比较

![]()

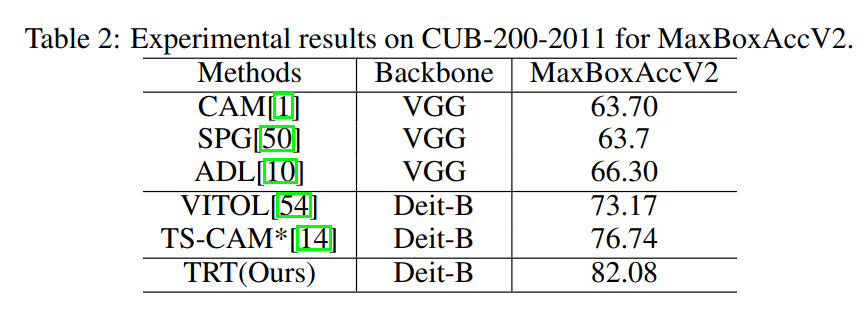

表 2:在 CUB-200-2011 数据集上的 MaxBoxAccV2 结果比较

![]()

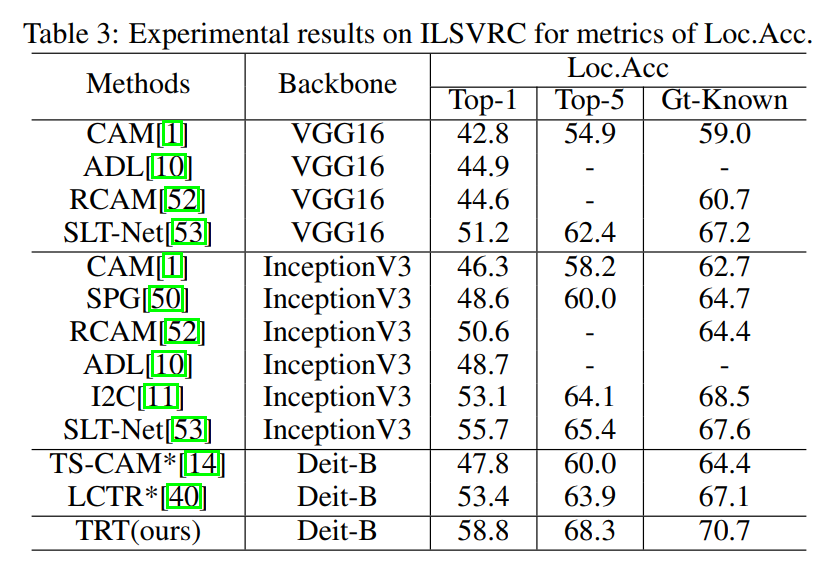

表 3:在 ILSVRC 数据集上的定位准确率比较

![]()

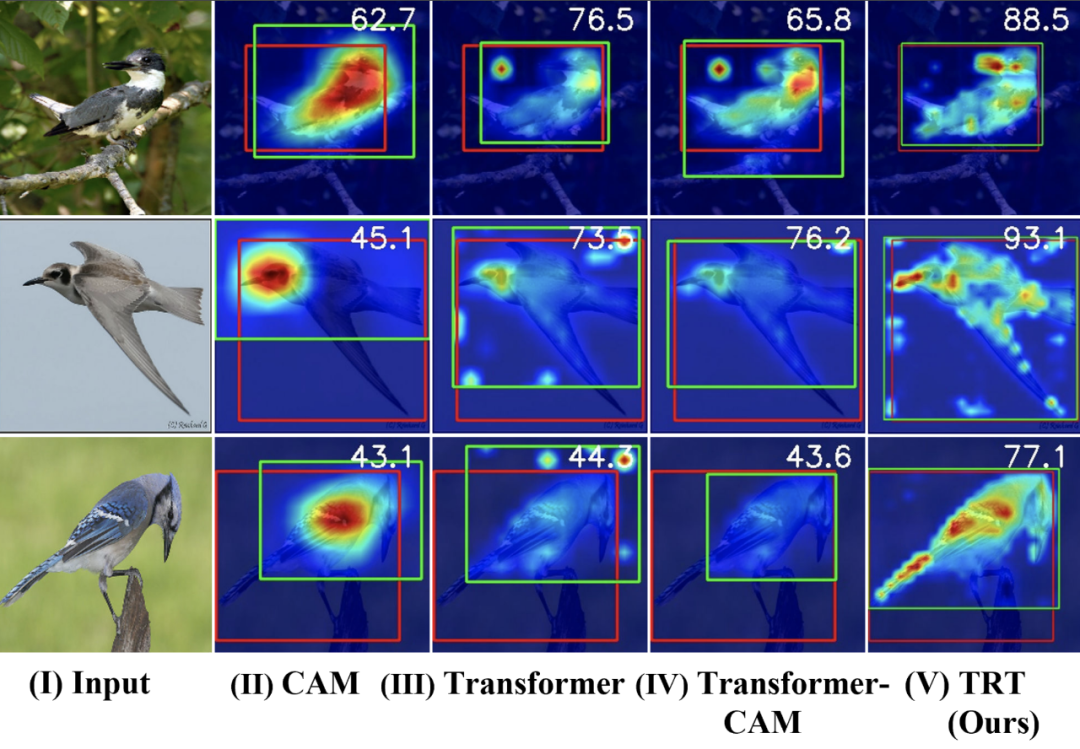

图 3: ILSVRC 上目标显著性区域以及定位对比

![]()

图 4: 在 CUB-200-2011 数据集上的目标显著性区域以及定位结果

掌握「声纹识别技术」:前20小时交给我,后9980小时……

《声纹识别:从理论到编程实战》中文课上线,由谷歌声纹团队负责人王泉博士主讲。

课程视频内容共 12 小时,着重介绍基于深度学习的声纹识别系统,包括大量学术界与产业界的最新研究成果。

同时课程配有 32 次课后测验、10 次编程练习、10 次大作业,确保课程结束时可以亲自上手从零搭建一个完整的声纹识别系统。

课程目前还在

首周优惠中

,欢迎对声纹领域感兴趣的同学一起学习。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com

和

和

,与类别标签构建交叉熵损失函数,实现分类训练,如下公式(2)所示。

,与类别标签构建交叉熵损失函数,实现分类训练,如下公式(2)所示。

与 TPSM 分支输出的特征

与 TPSM 分支输出的特征

点乘,生成最终的注意力图M。

点乘,生成最终的注意力图M。

的第一行为 class token 的注意力向量,展示了 class token 和所有 patch token 之间的关联关系。将所有层 transformer 层 class token 的注意力向量进行均值融合,得到初步注意力结果 m。

的第一行为 class token 的注意力向量,展示了 class token 和所有 patch token 之间的关联关系。将所有层 transformer 层 class token 的注意力向量进行均值融合,得到初步注意力结果 m。

,b 中值为 1 的位置表示被筛选的 patch token 的位置。

,b 中值为 1 的位置表示被筛选的 patch token 的位置。

中 patch token 部分

中 patch token 部分

执行掩码自注意力操作,对操作结果进行全连接和掩码 softmax 操作,生成重要性权重 λ。

执行掩码自注意力操作,对操作结果进行全连接和掩码 softmax 操作,生成重要性权重 λ。

进行加权融合,将

进行加权融合,将

与融合结果送入最后一个 transformer 层。利用最后一个 transformer 层输出的 class token 生成分类概率

与融合结果送入最后一个 transformer 层。利用最后一个 transformer 层输出的 class token 生成分类概率

。

。

,如式(10)所示,m' 为

,如式(10)所示,m' 为 的向量形式。

的向量形式。