任务导向型对话系统——对话管理模型研究最新进展

作者丨戴音培、虞晖华、蒋溢轩、唐呈光、李永彬、孙健

单位丨阿里巴巴-达摩院-小蜜Conversational AI团队,康奈尔大学

对话管理模型背景

-

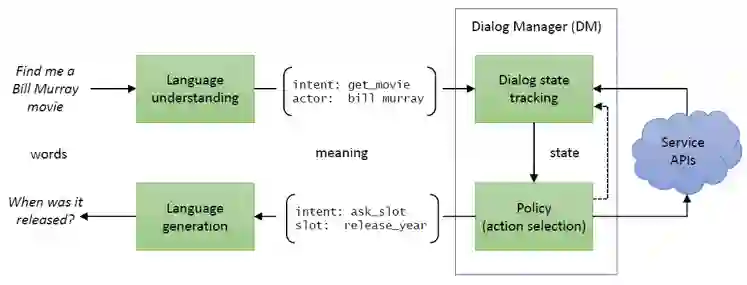

自然语言理解(Natural Language Understanding, NLU):对用户的文本输入进行识别解析,得到槽值和意图等计算机可理解的语义标签。 -

对话状态跟踪(Dialog State Tracking, DST):根据对话历史,维护当前对话状态,对话状态是对整个对话历史的累积语义表示,一般就是槽值对(slot-value pairs)。 -

对话策略(Dialogue Policy):根据当前对话状态输出下一步系统动作。一般对话状态跟踪模块和对话策略模块统称为对话管理模块(Dialogue manager, DM)。 -

自然语言生成(Natural Language Generation, NLG):将系统动作转换成自然语言输出。

可拓展性差

标注数据少

训练效率低

对话管理模型研究前沿介绍

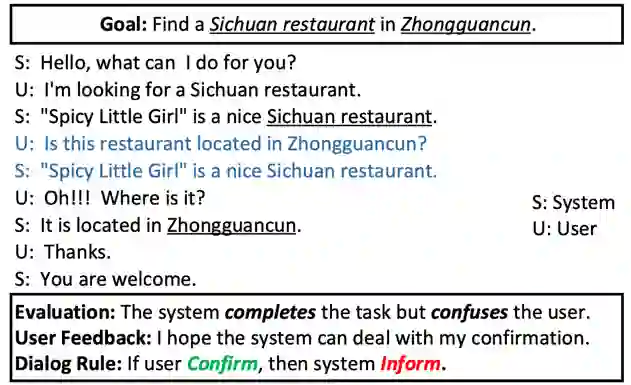

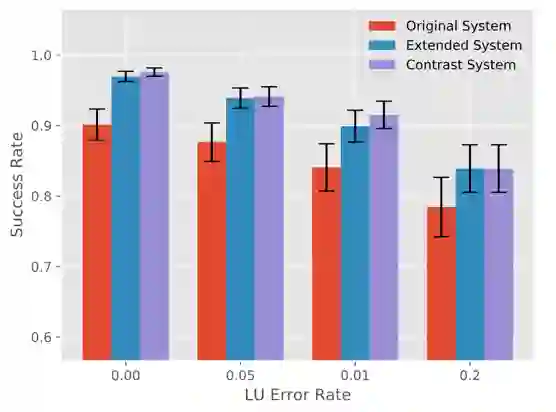

然而传统的对话管理模型在可拓展性方面仍需改进,具体在三个方面:1)如何处理变化的用户意图,2)如何变化的槽位和槽值,3)如何处理变化的系统动作。

变化的用户意图

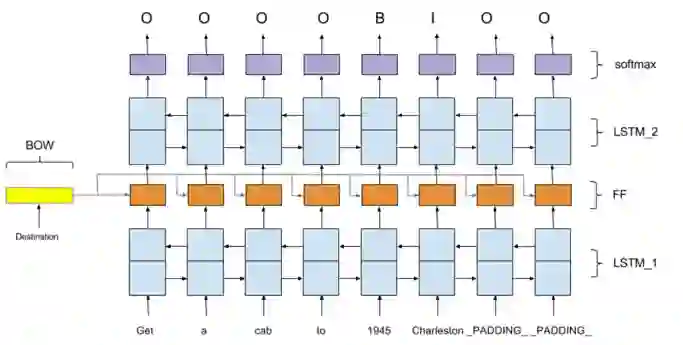

在实际应用场景中,时常会出现由于用户意图未被考虑到,使得对话系统给出不合理回答的情况。如图 3 所示的例子,用户的“confirm”意图未被考虑,这时就需要加入新的话术来帮助系统处理这样的情况。

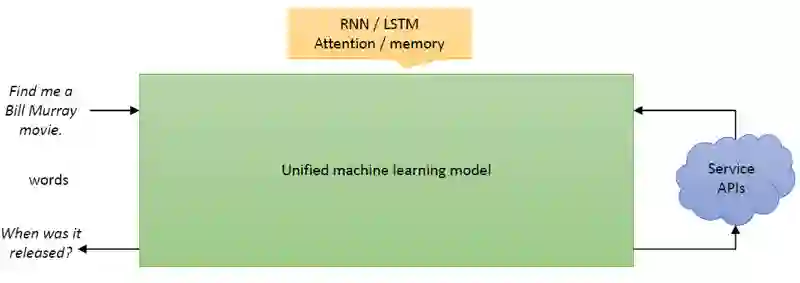

随着近几年序列到序列技术的发展,直接利用端到端神经网络模型将 DST 的结果作为一个序列生成出来也是一个很热门的方向,常见的技巧如注意力机制(attention mechanism)、拷贝机制(copy mechanism)均可以用来提高生成效果。

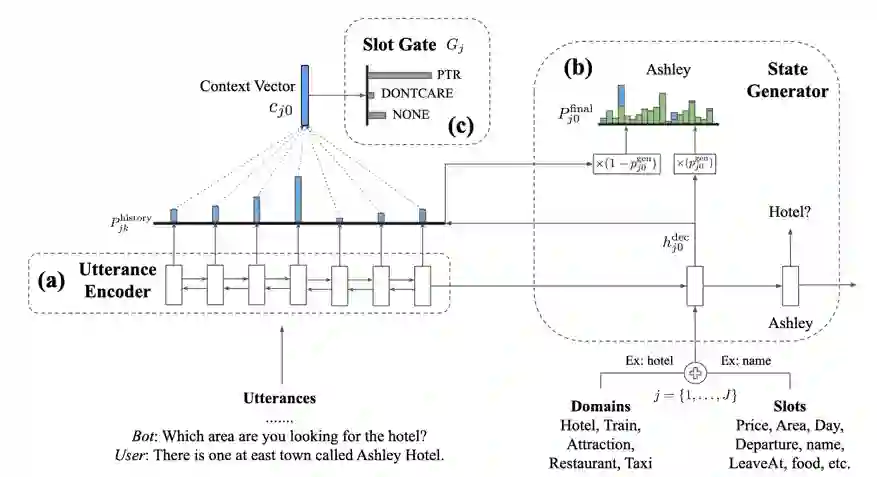

在著名的多领域对话 MultiWOZ 数据集上,来自港科大的 Pascale Fung 教授团队利用了拷贝网络,显著提高了不可枚举槽的识别精度 [20]。他们提出的 TRADE 模型如图 6 所示,每次检测槽值时,模型会将领域和槽位的不同结合进行语义编码作为 RNN 解码器的初始位置输入,解码器通过拷贝网络,直接将对应的槽值生成出来。

▲ 图6. TRADE模型框架

通过生成的方式,无论是不可枚举的槽值,还是变化的槽位的槽值,都能使用同一个模型完成,这可以做到领域间槽值信息的共享,也大大地提高了模型的泛化能力。

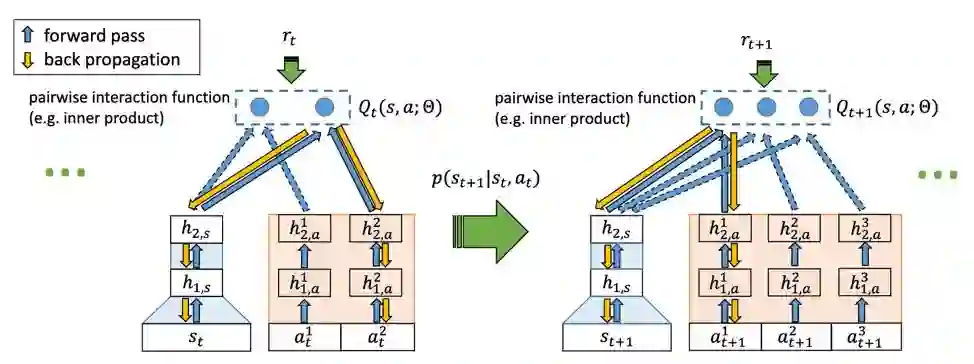

对此,我们需要考虑的是,如何设计更好的对话策略网络,使得系统能够快速的扩展新的动作。首先的尝试来自微软 [21],他们试图通过改变经典的 DQN 结构来实现系统在不受限动作空间上的增强学习。

论文的对话任务是一个文字游戏闯关任务,每轮的动作是一句话,动作数目不定,选择不同的动作故事情节就会有不同的发展。作者提出了新的模型 Deep Reinforcement Relevance Network (DRRN),通过语义相似性匹配的方式将当前的对话状态和各个可选的系统动作一一匹配得到 Q 函数。

具体来看:某轮对话时,每个长度不定的动作文本会经过神经网络编码得到固定长度的系统动作向量,故事背景文本经过另一个神经网络也得到固定长度的的对话状态向量,两个向量通过交互函数(如点积)生成最后的 Q 值。图 8 是论文设计模型结构。实验表明,在“Saving John”和“Machine of Death”两个文字游戏上 DRRN 比传统 DQN(使用 padding 技巧)的表现更加优异。

对话管理模型痛点二:标注数据少

随着对话系统应用领域的多样化,对数据的需求也更加多样化,若想训好一个任务型对话系统,通常都需要尽可能多的该领域的数据,但一般来说,想要获取高质量的有标注数据的成本很高。为此学者们进行了各种研究尝试,主要可分为三种思路:1)用机器自动标注数据,降低数据标注的成本;2)对话结构挖掘,尽可能高效利用无标注数据;3)加强数据采集策略,高效获取优质的数据。

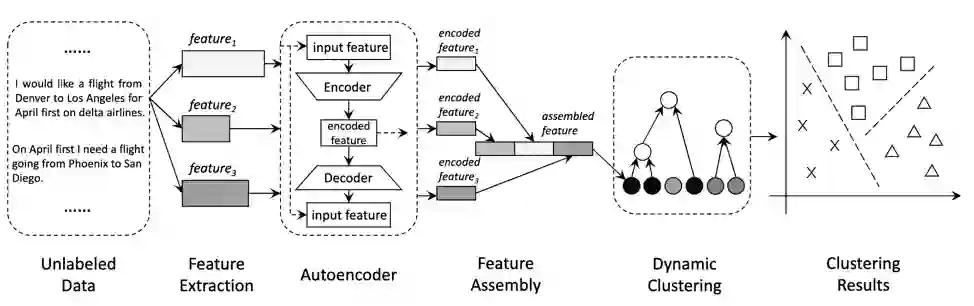

机器自动标注

由于人工标注数据的代价大、效率低,学者们希望通过机器辅助人工来标注数据,方法大致可分为两大类:有监督方法和无监督方法。论文 [23] 提出一种架构 auto-dialabel,用层次聚类的无监督学习方法将对话数据中的意图和槽位自动分组,从而实现对话数据的自动标注(类别的具体标签需要人工来定)。

该方法是基于一个假设:相同意图的表达可能会共享相似的背景特征。模型提取的初始特征包括词向量、POS 标注、名词词簇和 LDA 四种特征。各个特征经由自编码器转成相同维度的向量后进行拼接,再采用 RBF(radial bias function)函数计算类间距离进行动态的层次聚类。距离最近的类将会自动合并,直到类间距离大于预设的阈值停止。模型框架如图 10 所示。

▲ 图10. Auto-dialabel模型

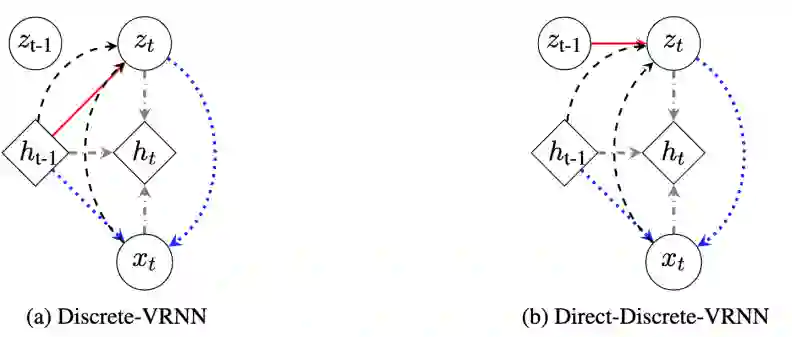

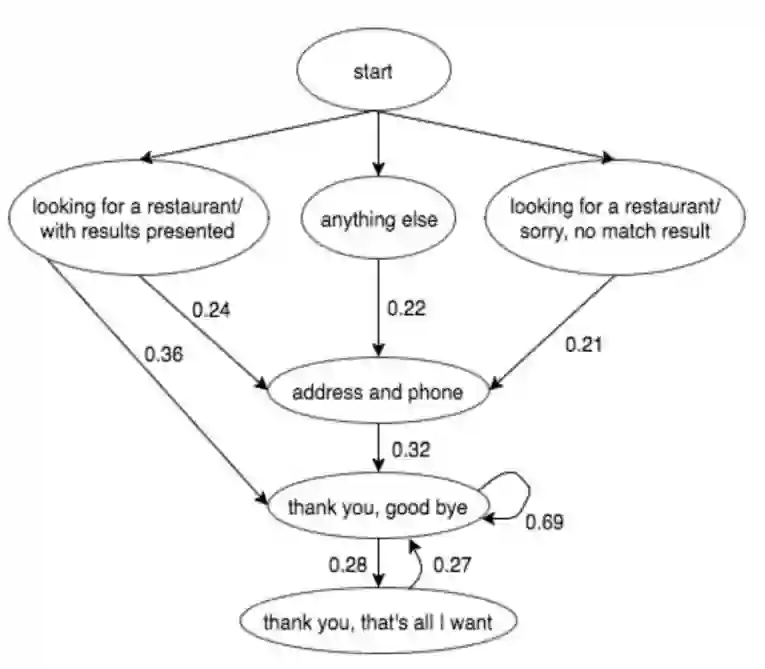

论文实验表明 VRNN 要优于传统的 HMM 的方法,同时将对话结构的信息加入到奖励函数中,也有助于增强学习模型更快地收敛。图 12 是经过 D-VRNN 挖掘出的餐馆领域的隐变量转移概率的可视化图。

CMU 学者 [26] 也尝试利用 VAE 的方法,将系统动作作为隐变量推断出来直接用于对话策略的选择,这样就能减轻预定义系统动作不够全面带来的问题。

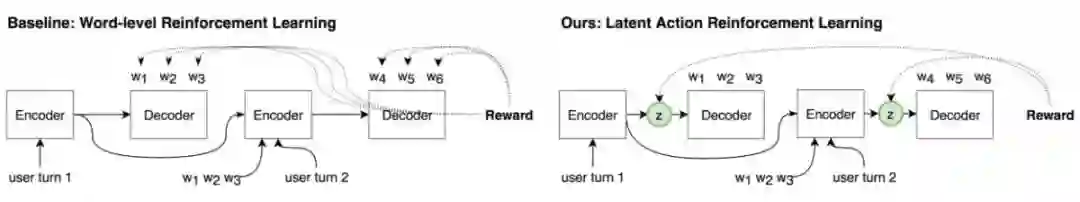

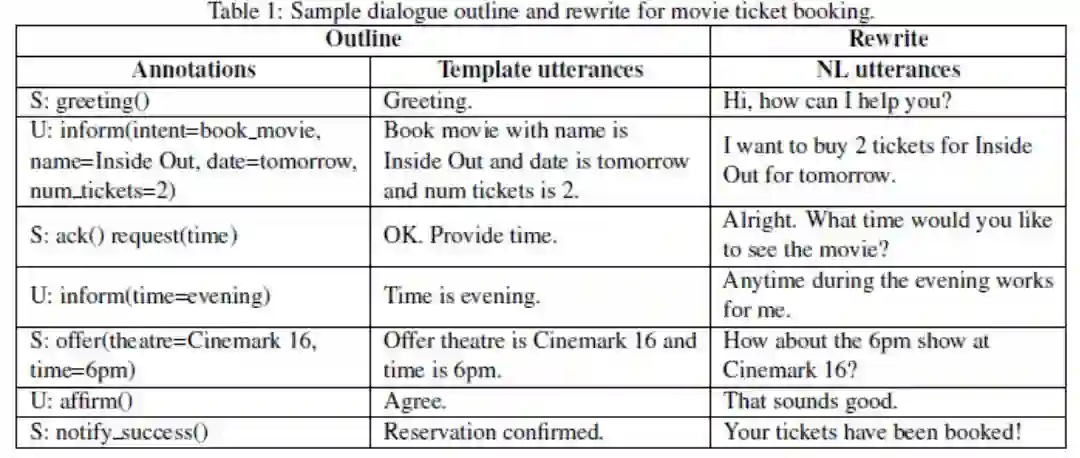

如图 13 所示,为了简便起见,论文采用端到端的对话系统框架,基线模型是字级别的增强学习模型(即对话动作是词表中的词),通过 encoder 将对话历史编码,再利用 decoder 解码生成对话回复,奖励函数直接通过比对生成的对话回复语句和真实对话回复语句得到。

作者提出的隐动作模型和基线模型的区别是 encoder 到 decoder 之间多了离散隐变量的后验推理,对话动作由离散隐变量表示,没有任何人为的干预定义。最终实验证明,基于隐动作的端到端增强学习模型在语句生成的多样性和任务完成率上均超过了基线模型。

数据采集策略

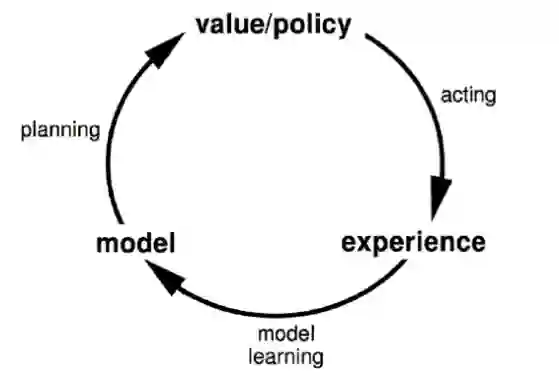

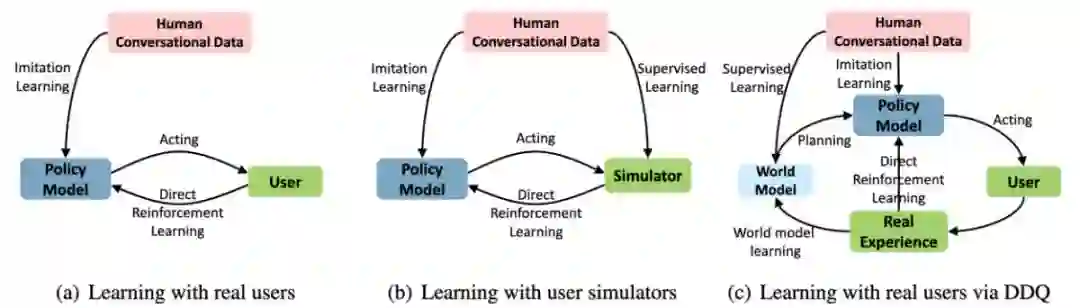

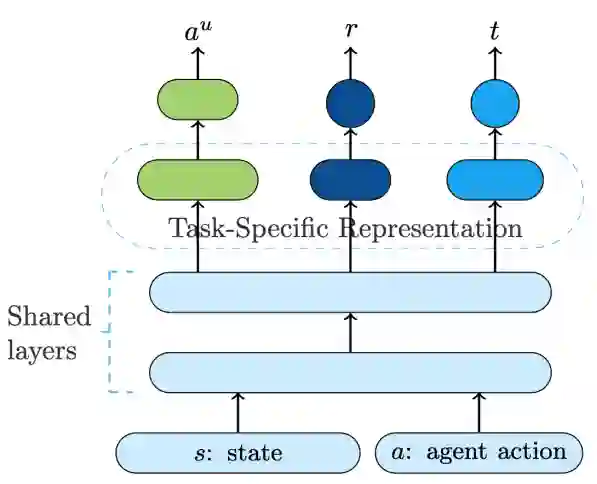

Model-based 增强学习

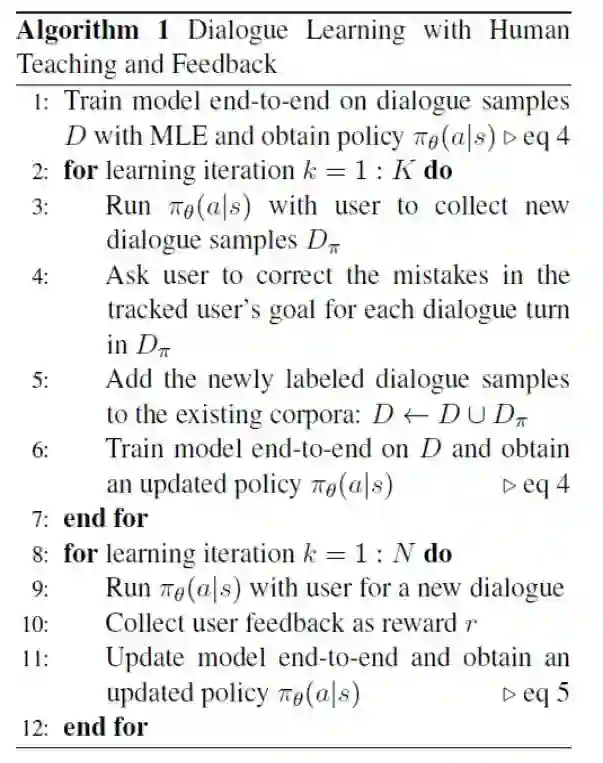

▲ 图21. 监督式预训练、模仿学习和在线增强学习结合的复合式学习

▲ 图22. 老师纠正学生的回复(左侧开关)或者对学生的回复做出评价(右侧开关)

小蜜Conversational AI团队的对话管理框架

▲

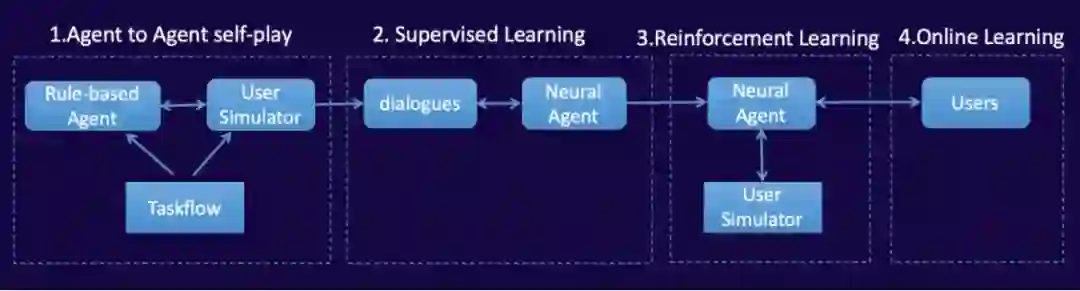

图23. 对话管理模型化四步走路线

▲

图23. 对话管理模型化四步走路线

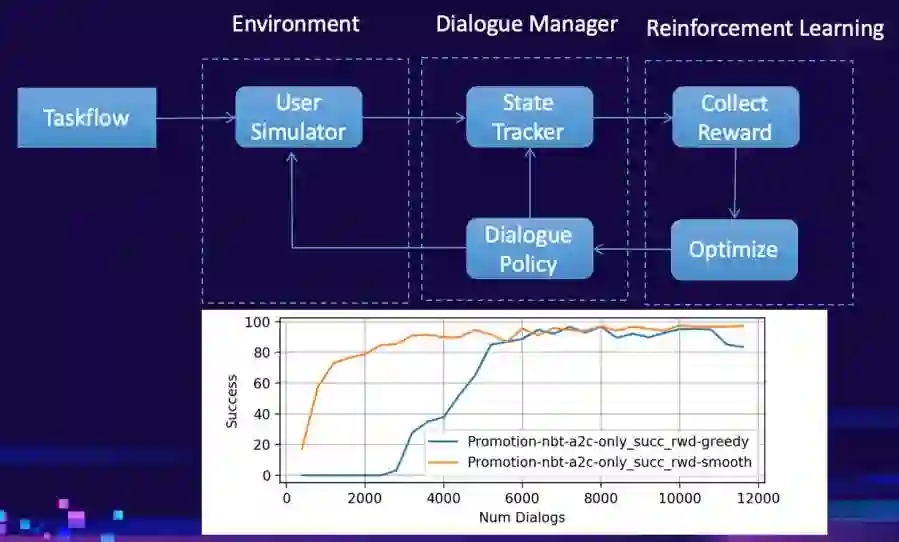

▲ 图24. 小蜜Conversational AI团队的对话管理模型框架和评价指标

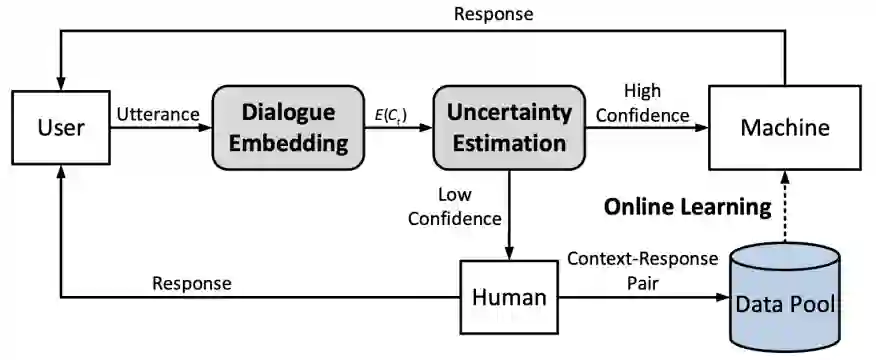

总结

本综述围绕对话管理(Dialog Management, DM)模型的最新前沿研究做了一个详细的介绍,针对传统对话管理的痛点划分了三个大的方向:1)可拓展性差;2)标注数据少;3)训练效率低。

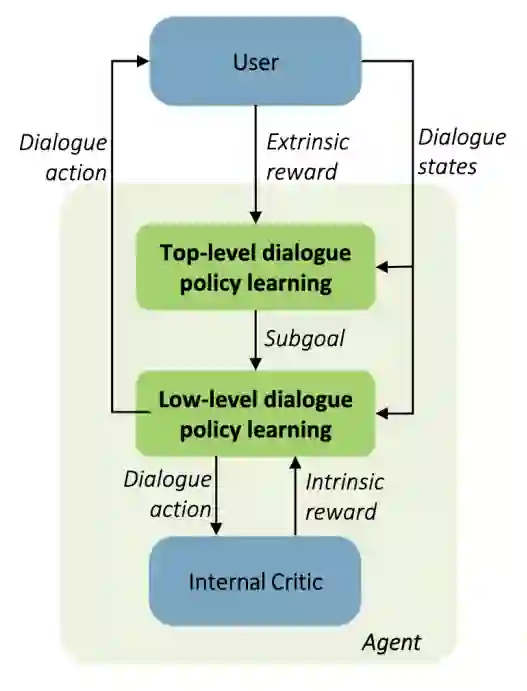

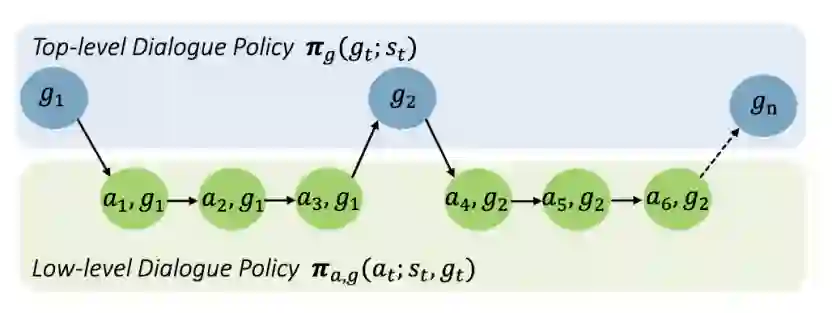

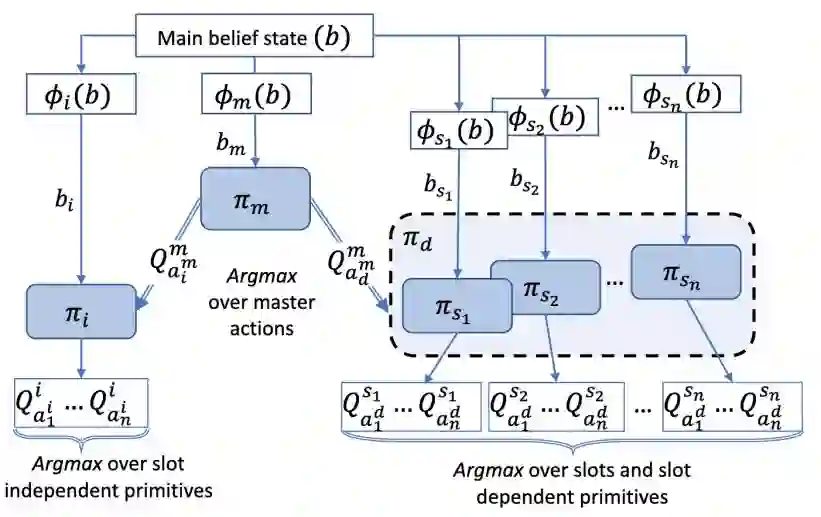

在可拓展性方面,我们介绍了处理变化的用户意图、对话本体、系统动作空间的常用方法,主要有语义相似匹配方法、知识蒸馏方法和序列生成方法;对于标注数据稀缺问题,我们介绍了机器自动标注、对话结构有效挖掘和数据高效收集策略三部分内容;而针对传统 DM 中 RL 模型训练效率低下的问题,学界有尝试引入 HRL、FRL 等方法对动作空间进行层次划分,也有利用 model-based RL 对环境进行建模提高训练效率,将 human-in-the-loop 引入对话系统训练框架亦是当下十分活跃的研究方向。

最后我们对阿里巴巴-达摩院-小蜜 Conversational AI 团队目前在 DM 模型化的进展做了一个比较详细的汇报介绍,希望本综述能为大家的对话管理研究提供一些启发和思考。

参考文献

[1]. TURING A M. I.—COMPUTING MACHINERY AND INTELLIGENCE[J]. Mind, 1950, 59(236): 433-460.

[2]. Weizenbaum J. ELIZA---a computer program for the study of natural language communication between man and machine[J]. Communications of the ACM, 1966, 9(1): 36-45.

[3]. Young S, Gašić M, Thomson B, et al. Pomdp-based statistical spoken dialog systems: A review[J]. Proceedings of the IEEE, 2013, 101(5): 1160-1179.

[4]. Bordes A, Boureau Y L, Weston J. Learning end-to-end goal-oriented dialog[J]. arXiv preprint arXiv:1605.07683, 2016.

[5]. Wen T H, Vandyke D, Mrksic N, et al. A network-based end-to-end trainable task-oriented dialogue system[J]. arXiv preprint arXiv:1604.04562, 2016.

[6]. Su P H, Budzianowski P, Ultes S, et al. Sample-efficient actor-critic reinforcement learning with supervised data for dialogue management[J]. arXiv preprint arXiv:1707.00130, 2017.

[7]. Serban I V, Sordoni A, Lowe R, et al. A hierarchical latent variable encoder-decoder model for generating dialogues[C]//Thirty-First AAAI Conference on Artificial Intelligence. 2017.

[8]. Berant J, Chou A, Frostig R, et al. Semantic parsing on freebase from question-answer pairs[C]//Proceedings of the 2013 Conference on Empirical Methods in Natural Language Processing. 2013: 1533-1544.

[9]. Dhingra B, Li L, Li X, et al. Towards end-to-end reinforcement learning of dialogue agents for information access[J]. arXiv preprint arXiv:1609.00777, 2016.

[10]. Lei W, Jin X, Kan M Y, et al. Sequicity: Simplifying task-oriented dialogue systems with single sequence-to-sequence architectures[C]//Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). 2018: 1437-1447.

[11]. Madotto A, Wu C S, Fung P. Mem2seq: Effectively incorporating knowledge bases into end-to-end task-oriented dialog systems[J]. arXiv preprint arXiv:1804.08217, 2018.

[12]. Mrkšić N, Séaghdha D O, Wen T H, et al. Neural belief tracker: Data-driven dialogue state tracking[J]. arXiv preprint arXiv:1606.03777, 2016.

[13]. Ramadan O, Budzianowski P, Gašić M. Large-scale multi-domain belief tracking with knowledge sharing[J]. arXiv preprint arXiv:1807.06517, 2018.

[14]. Weisz G, Budzianowski P, Su P H, et al. Sample efficient deep reinforcement learning for dialogue systems with large action spaces[J]. IEEE/ACM Transactions on Audio, Speech and Language Processing (TASLP), 2018, 26(11): 2083-2097.

[15]. Wang W, Zhang J, Zhang H, et al. A Teacher-Student Framework for Maintainable Dialog Manager[C]//Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing. 2018: 3803-3812.

[16]. Yun-Nung Chen, Dilek Hakkani-Tur, and Xiaodong He, "Zero-Shot Learning of Intent Embeddings for Expansion by Convolutional Deep Structured Semantic Models," in Proceedings of The 41st IEEE International Conference on Acoustics, Speech, and Signal Processing (ICASSP 2016), Shanghai, China, March 20-25, 2016. IEEE.

[17]. Rastogi A, Hakkani-Tür D, Heck L. Scalable multi-domain dialogue state tracking[C]//2017 IEEE Automatic Speech Recognition and Understanding Workshop (ASRU). IEEE, 2017: 561-568.

[18]. Mesnil G, He X, Deng L, et al. Investigation of recurrent-neural-network architectures and learning methods for spoken language understanding[C]//Interspeech. 2013: 3771-3775.

[19]. Bapna A, Tur G, Hakkani-Tur D, et al. Towards zero-shot frame semantic parsing for domain scaling[J]. arXiv preprint arXiv:1707.02363, 2017.

[20]. Wu C S, Madotto A, Hosseini-Asl E, et al. Transferable Multi-Domain State Generator for Task-Oriented Dialogue Systems[J]. arXiv preprint arXiv:1905.08743, 2019.

[21]. He J, Chen J, He X, et al. Deep reinforcement learning with a natural language action space[J]. arXiv preprint arXiv:1511.04636, 2015.

[22]. Wang W, Zhang J, Li Q, et al. Incremental Learning from Scratch for Task-Oriented Dialogue Systems[J]. arXiv preprint arXiv:1906.04991, 2019.

[23]. Shi C, Chen Q, Sha L, et al. Auto-Dialabel: Labeling Dialogue Data with Unsupervised Learning[C]//Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing. 2018: 684-689.

[24]. Haponchyk I, Uva A, Yu S, et al. Supervised clustering of questions into intents for dialog system applications[C]//Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing. 2018: 2310-2321.

[25]. Shi W, Zhao T, Yu Z. Unsupervised Dialog Structure Learning[J]. arXiv preprint arXiv:1904.03736, 2019.

[26]. Zhao T, Xie K, Eskenazi M. Rethinking action spaces for reinforcement learning in end-to-end dialog agents with latent variable models[J]. arXiv preprint arXiv:1902.08858, 2019.

[27]. Shah P, Hakkani-Tur D, Liu B, et al. Bootstrapping a neural conversational agent with dialogue self-play, crowdsourcing and on-line reinforcement learning[C]//Proceedings of the 2018 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 3 (Industry Papers). 2018: 41-51.

[28]. Budzianowski P, Wen T H, Tseng B H, et al. Multiwoz-a large-scale multi-domain wizard-of-oz dataset for task-oriented dialogue modelling[J]. arXiv preprint arXiv:1810.00278, 2018.

[29]. Peng B, Li X, Li L, et al. Composite task-completion dialogue policy learning via hierarchical deep reinforcement learning[J]. arXiv preprint arXiv:1704.03084, 2017.

[30]. Kristianto G Y, Zhang H, Tong B, et al. Autonomous Sub-domain Modeling for Dialogue Policy with Hierarchical Deep Reinforcement Learning[C]//Proceedings of the 2018 EMNLP Workshop SCAI: The 2nd International Workshop on Search-Oriented Conversational AI. 2018: 9-16.

[31]. Tang D, Li X, Gao J, et al. Subgoal discovery for hierarchical dialogue policy learning[J]. arXiv preprint arXiv:1804.07855, 2018.

[32]. Casanueva I, Budzianowski P, Su P H, et al. Feudal reinforcement learning for dialogue management in large domains[J]. arXiv preprint arXiv:1803.03232, 2018.

[33]. Peng B, Li X, Gao J, et al. Deep dyna-q: Integrating planning for task-completion dialogue policy learning[J]. ACL 2018.

[34]. Su S Y, Li X, Gao J, et al. Discriminative deep dyna-q: Robust planning for dialogue policy learning.EMNLP, 2018.

[35]. Wu Y, Li X, Liu J, et al. Switch-based active deep dyna-q: Efficient adaptive planning for task-completion dialogue policy learning.AAAI, 2019.

[36]. Zhang Z, Li X, Gao J, et al. Budgeted Policy Learning for Task-Oriented Dialogue Systems. ACL, 2019.

[37]. Abel D, Salvatier J, Stuhlmüller A, et al. Agent-agnostic human-in-the-loop reinforcement learning[J]. arXiv preprint arXiv:1701.04079, 2017.

[38]. Liu B, Tur G, Hakkani-Tur D, et al. Dialogue learning with human teaching and feedback in end-to-end trainable task-oriented dialogue systems[J]. arXiv preprint arXiv:1804.06512, 2018.

[39]. Lu Y, Srivastava M, Kramer J, et al. Goal-Oriented End-to-End Conversational Models with Profile Features in a Real-World Setting[C]//Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 2 (Industry Papers). 2019: 48-55.

[40]. Chen L, Zhou X, Chang C, et al. Agent-aware dropout dqn for safe and efficient on-line dialogue policy learning[C]//Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing. 2017: 2454-2464.

[41]. Gao J, Galley M, Li L. Neural approaches to conversational AI[J]. Foundations and Trends® in Information Retrieval, 2019, 13(2-3): 127-298.

[42]. Ross S, Gordon G, Bagnell D. A reduction of imitation learning and structured prediction to no-regret online learning[C]//Proceedings of the fourteenth international conference on artificial intelligence and statistics. 2011: 627-635.

[43]. Rajendran J, Ganhotra J, Polymenakos L C. Learning End-to-End Goal-Oriented Dialog with Maximal User Task Success and Minimal Human Agent Use[J]. Transactions of the Association for Computational Linguistics, 2019, 7: 375-386.

[44]. Mrkšić N, Vulić I. Fully Statistical Neural Belief Tracking[C]//Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics (Volume 2: Short Papers). 2018: 108-113.

[45]. Zhou L, Small K. Multi-domain Dialogue State Tracking as Dynamic Knowledge Graph Enhanced Question Answering[J]. arXiv preprint arXiv:1911.06192, 2019.

[46]. Rajpurkar P, Jia R, Liang P. Know What You Don't Know: Unanswerable Questions for SQuAD[J]. arXiv preprint arXiv:1806.03822, 2018.

[47]. Zhang J G, Hashimoto K, Wu C S, et al. Find or Classify? Dual Strategy for Slot-Value Predictions on Multi-Domain Dialog State Tracking[J]. arXiv preprint arXiv:1910.03544, 2019.

2018 年,累计发表 13 篇顶会论文,提交 30 个专利,并成功入选了《麻省理工科技评论》2019“全球十大突破性技术”。

2018 年,双十一阿里巴巴智能服务占比达到 98%,帮助阿里巴巴和商家完成了相当于 700,000 人工客服的工作量。

专注于自然语言处理和智能人机交互的创新研究和大规模应用,在自然语言理解、多轮对话管理、用户模拟器、小样本学习、强化学习、知识图谱问答、非结构化知识问答等多个方向上取得良好进展,打造了小蜜家族的任务型对话开发平台和知识图谱问答平台。

工作内容:

复杂句子的深层语义分析;

基于对话上下文的语言理解;

自然语言理解的的鲁棒性问题研究。

招聘岗位:算法专家—人机对话

对话管理模型的研究及开发;

对话模拟器的研究和开发;

智能人机对话系统的研究和开发。

招聘岗位:算法专家—知识图谱和智能问答

知识挖掘和知识图谱建设;

语义知识表示、智能问答系统的研究和开发;

机器阅读理解系统的研究和开发。

岗位要求

自然语言处理、机器学习、人工智能、图像处理等相关专业的硕士/博士;

具有较强的编程能力,熟练使用 Python/Java/C/C++之一;

很强的使命感和自我驱动力,对技术饱有热情;

有 ACL、EMNLP、AAAI、IJCAI 等相关顶会论文者优先;

有对话系统研发经验者优先。

招聘岗位:技术专家

JAVA 基础扎实,对 JVM 原理有一定的了解,能够独立排查和解决问题;

掌握多线程及高性能的设计与编码及性能调优,有高并发应用开发经验;

熟悉分布式系统的设计和应用,熟悉分布式、缓存、消息、spring、ibatis 等常见开源框架;

熟悉 linux 常用命令,熟悉 python/shell/javascript 脚本语言,有 sql 优化经验;

具有创新思维,学习能力强,有一定的抗压能力,善于沟通和团队协作,乐于分享;

对智能技术的发展有浓厚兴趣。

简历内推绿色通道:shuide.lyb@alibaba-inc.com

邮件标题备注:PaperWeekly + 内推

点击以下标题查看更多往期内容:

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

▽ 点击 | 阅读原文 | 获取最新论文推荐