PaperWeekly 第31期 | 远程监督在关系抽取中的应用

石戈

北京理工大学博士一年级

主要研究方向为实体链接、关系抽取等

邮箱shige@bit.edu.cn

微信Garym713

引言

本期主要介绍下关系抽取任务中目前比较常用的一类方法 — Distant Supervision。该方法由 M Mintz 于 ACL2009 上首次提出,与传统预先定义关系类别不同,Distant Supervision 通过将知识库与非结构化文本对齐来自动构建大量训练数据,减少模型对人工标注数据的依赖,增强模型跨领域适应能力。

本期挑选近期 Distant Supervision 相关的以神经网络模型为基础的几篇文献进行介绍,希望对大家有所帮助。本期涉及的论文有:

1. Distant Supervision for Relation Extraction via Piecewise Convolutional Neural Networks (EMNLP2015)

2. Neural Relation Extraction with Selective Attention over Instances (ACL2016)

3. Distant Supervision for Relation Extraction with Sentence-level Attention and EntityDescriptions (AAAI 2017)

在展开之前,先回顾下 Distant Supervision 的具体定义。Distant Supervision 的提出主要基于以下假设:两个实体如果在知识库中存在某种关系,则包含该两个实体的非结构化句子均能表示出这种关系。例如,"Steve Jobs", "Apple"在 Freebase 中存在 founder 的关系,则包含这两个实体的非结构文本“Steve Jobs was the co-founder and CEO of Apple and formerly Pixar.”可以作为一个训练正例来训练模型。这类数据构造方法的具体实现步骤是:

1. 从知识库中抽取存在关系的实体对

2. 从非结构化文本中抽取含有实体对的句子作为训练样例

Distant Supervision 的方法虽然从一定程度上减少了模型对人工标注数据的依赖,但该类方法也存在明显的缺点:

1. 假设过于肯定,难免引入大量的噪声数据。如 "Steven Jobs passed away the daybefore Apple unveiled iPhone 4s in late 2011."这句话中并没有表示出 Steven Jobs 与 Apple 之间存在 founder 的关系。

2. 数据构造过程依赖于 NER 等 NLP 工具,中间过程出错会造成错误传播问题。针对这些问题,目前主要有四类方法:(1)在构造数据集过程中引入先验知识作为限制;(2)利用指称与指称间关系用图模型对数据样例打分,滤除置信度较低的句子;(3)利用多示例学习方法对测试包打标签;(4)采用 attention 机制对不同置信度的句子赋予不同的权值。

本期介绍的三篇文章主要采用方法 3、4 来缓解标注错误问题。

— 01 —

Distant Supervision for Relation Extraction via Piecewise Convolutional Neural Networks

EMNLP2015 论文链接:

http://anthology.aclweb.org/D/D15/D15-1203.pdf

这篇论文主要针对数据标注错误问题和传统统计模型特征抽取过程中出现的错误提出解决方法。针对数据标注错误问题,作者提出采用多示例学习的方式从训练集中抽取取置信度高的训练样例训练模型。针对第二个问题,作者提出 piece-wise 的卷积神经网络(PCNN)。

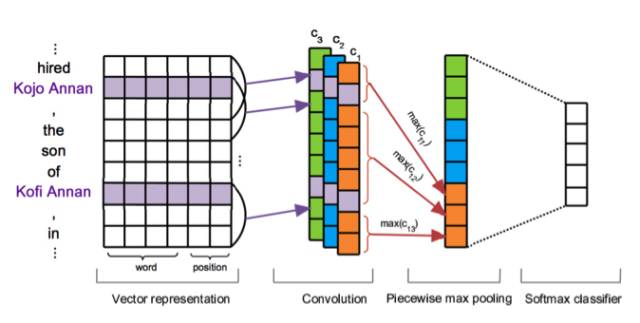

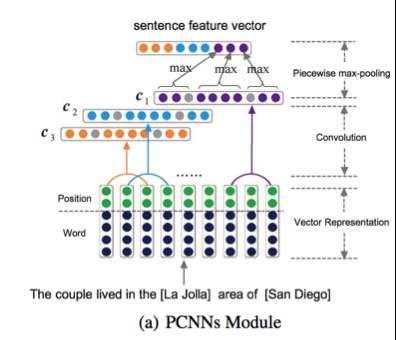

首先,看下文章的模型。该模型比较简单,与传统卷积神经网络的区别主要在于池化层的改变。通过 word2vec 的 Skip-gram 模型将词表示成向量形式,与位置向量(各词语与两个实体的相对位置)进行拼接作为输入,之后通过卷积层得到 feature map。在池化层通过两个实体位置将 feature map 分为三段进行池化,其目的是为了更好的捕获两个实体间的结构化信息。最后,通过 softmax 层进行分类。

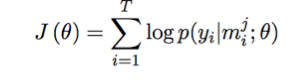

在训练阶段,其目标函数是:

yi 表示的是关系类别,mij 表示的是第 i 个包中的第 j 个样例,qi 是每个包中包含的样例个数。其核心思想是通过多示例学习的方法选取每个包中置信度最高的样例作为正样例进行训练(在此就不对多示例学习进行具体的描述,感兴趣的同学可以自己查找相关文献阅读)。最后通过实验验证,作者提出的方法 Top N 平均值比基于多示例学习的机器学习方法高了 5 个百分点。

— 02 —

Neural Relation Extraction with Selective Attention over Instances

ACL2016 论文链接:

http://anthology.aclweb.org/P/P16/P16-1200.pdf

实验代码链接:

https://github.com/thunlp/NRE

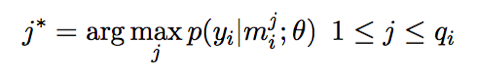

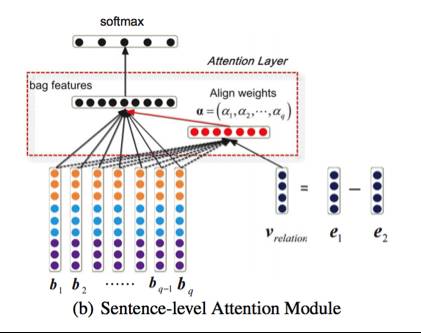

这篇论文同样是针对 Distant Supervision 中噪声数据较多的问题,提出基于 attention 机制的卷积神经网络模型。这篇论文采用了第一篇论文中的方法作为基准系统,论文作者认为多示例学习的方法虽然缓解了噪声数据较多的问题,但是由于只采用每个包中置信度最高的样例作为训练数据,在滤除噪声的同时也损失了很多有用信息。其模型框架如下图所示:

图中,m1, m2, m3,…,mc 表示的是两个实体对应的训练句子集合,ri 表示的是句子 mi 经过 CNN 编码池化后的向量,ai 表示的是训练句子样例的权重。该框架首先通过 CNN 编码后得到句子向量 ri,再通过计算 ri 与关系 r 向量的相似度来赋予 ri 在整个句子集合中的权重,其计算公式如下:

xi 表示的是句子的向量化表示,A 是匹配的参数,k 表示的是关系数目。最后在各句子加权取和后通过 softmax 分类器得到分类结果。该框架采用的编码器是第一篇文章中提出的 PCNN 网络。

— 03 —

Distant Supervision for Relation Extraction with Sentence-level Attention and Entity Descriptions

AAAI2017 论文链接:

http://www.aaai.org/ocs/index.php/AAAI/AAAI17/paper/view/14491

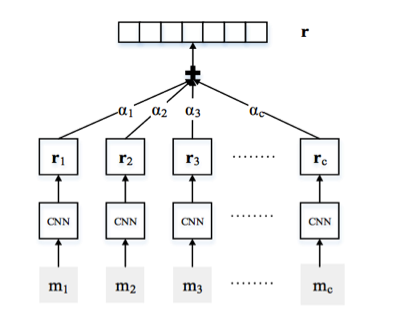

这篇文章同样针对数据噪声问题提出基于注意力机制的卷积神经网络模型,与第二篇文章的主要不同点在于 attention 权值的计算方法。该文章利用“实体-实体=关系”的方法表示实体间关系,同时利用卷积神经网络捕获实体描述页面特征,丰富实体表示,最后通过计算实体间关系与句子间的相似度赋予句子不同的权重。其模型图如下所示:

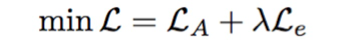

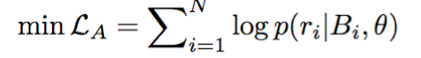

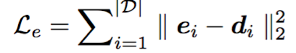

图a是模型的信息编码部分,与前两篇文章基本一致。图 b 中 bi 表示的是经过图 A PCNN 网络编码后得到的句子向量。在 attention 权值计算部分,利用一个简单的卷积神经网络对实体描述页面编码抽取特征进行向量化表示,其目标输出是该实体的词向量表示(该部分网络结构未没有在图中表示出来)。最后通过目标函数 min L 将实体描述页面信息作为限制条件与多示例学习方法结合来训练关系抽取模型。

ri 表示的是实体间关系,Bi 表示的是第 i 个训练包。ei 表示的是实体的词向量,di 表示的是实体描述页面通过卷积网络编码后得到的实体描述向量。