【EMNLP2020】低资源域适应的多阶段预训练

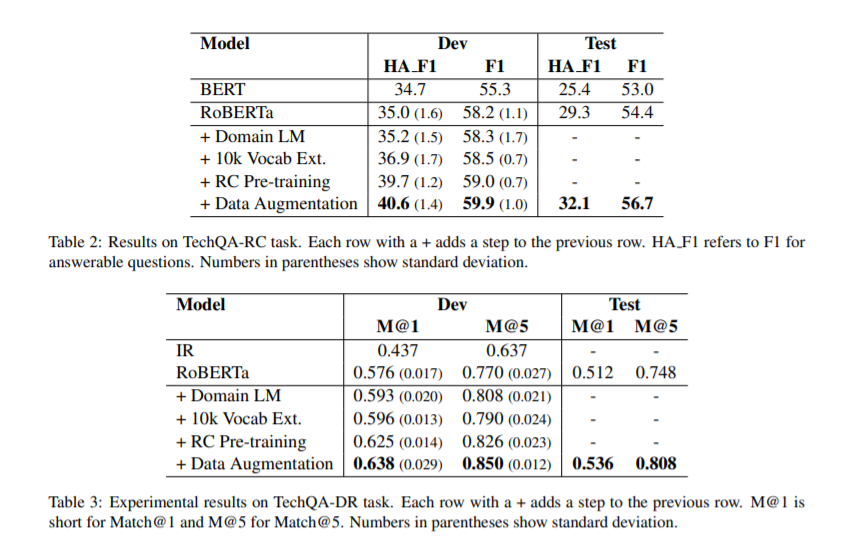

迁移学习技术在难以获得大量高质量注释数据的NLP任务中特别有用。目前的方法在对下游任务进行微调之前,直接对域内文本采用预先训练好的语言模型(LM)。我们展示了使用特定于领域的术语扩展LM的词汇表会带来进一步的收获。在更大的效果上,我们利用未标记数据中的结构创建辅助合成任务,这有助于LM向下游任务转移。在事先训练好的Roberta-large LM系统上逐步应用这些方法,并在IT领域的三个任务上显示出可观的性能提升:阅读理解、文档排序和重复问题检测。

https://arxiv.org/abs/2010.05904

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“LRDA” 可以获取《【EMNLP2020】低资源域适应的多阶段预训练》专知下载链接索引

登录查看更多

相关内容

Arxiv

8+阅读 · 2019年3月4日