除了实时光线追踪,英伟达图灵架构还有这些AI图像处理能力

▲点击上方 雷锋网 关注

文 | 李诗

来自雷锋网(leiphone-sz)的报道

前些天,英伟达发布全新GPU架构——Turing(图灵),被黄仁勋视为十二年来英伟达GPU的最大飞跃,无疑是计算机图形领域的游戏改变者。

图灵架构最大核心亮点在于即时光线追踪(Real Time Ray Tracing),能够计算光线反射、折射、散射等路线,渲染出逼真的画面,可为游戏开发者提供电影级画质的实时渲染,也就是让游戏看起来更像电影。据悉,这些新GPU依靠自身的一个特殊部分来快速呈现高分辨率图形,完成图像的大部分成像工作后,使用人工智能技术来猜测未完成的像素。

雷锋网了解到,除了即时光线追踪外,英伟达的GPU还支持多种AI图像处理能力,可谓是开了挂。

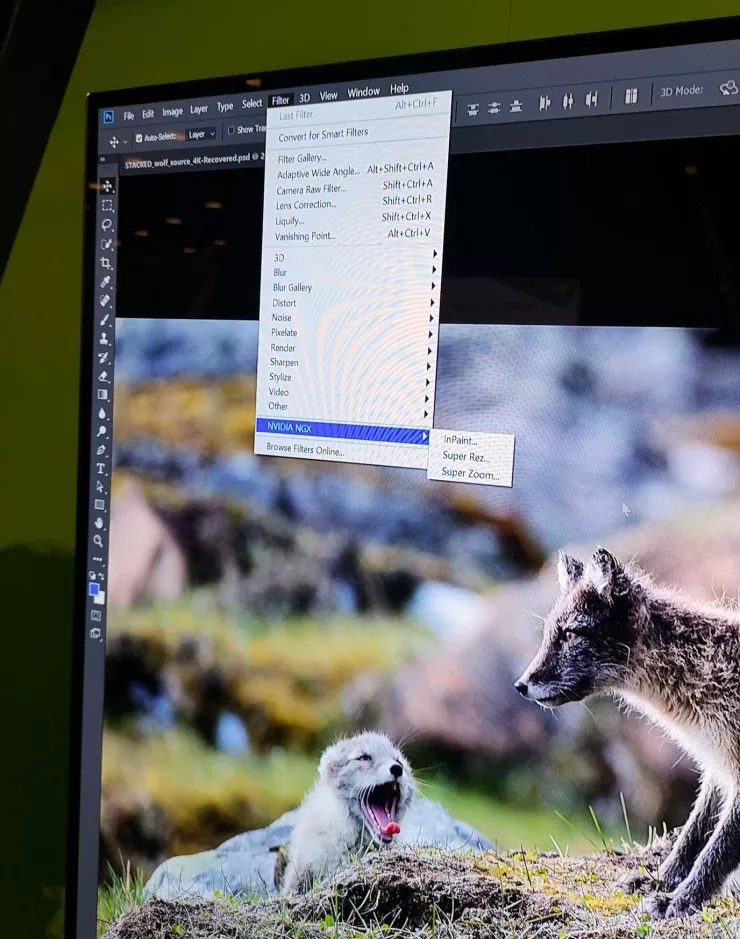

Adobe上的AI图像处理插件

在上周举办的计算机图形学年度会议SIGGRAPH 2018上,英伟达发布了全新的图灵架构,随后展示了一系列用于Photoshop和Premiere的插件。这些插件都利用了其最新的图灵GPU架构和Quadro RTX系列显卡支持的机器学习功能,能够使Photoshop和Premiere上的一些常用功能运行更顺畅,更少手动调整。

早在2017年,Adobe在AI图像处理上就有很多的案例。通过机器学习技术训练计算机识别和操纵数据,能够使得图像处理工具对图像内容有更准确的理解和猜测,实现很多P图高手都难以完成的效果。

雷锋网曾报道,2018年3月,在Adobe Summit 2018上,Adobe和英伟达宣布双方将基于 Nvidia GPU 对 Adobe Sensei 人工智能系统和机器学习框架进行优化。简单地说,就是将 Adobe Sensei 建立在 Nvidia GPU 的硬件基础之上。

实际上,双方的合作已经持续了十多年,不过此前的合作都是在创意和数字体验方面, Adobe 的图片、视频等依赖于 GPU 来运作图形相关应用;不过这次合作的核心是 Adobe 在 2016 年 9 月发布的 Sensei 人工智能系统。

合作确立半年之后,英伟达发布全新图灵架构之际,也展示了双方合作的成果。

雷锋网编辑在英伟达于SIGGRAPH大会的展台上也看到了这些插件的演示。

第一个插件是Super Rez。

Super Rez的主要功能是为图像添加更逼真的细节。如图所示,狼群站立在山腰上,其毛发细节逼真,树叶纹理清楚,放大后也很清晰,分辨率能达到4K至8K。这个功能对于大幅高清图像很适用,例如大幅面海报。从现场演示来看,这项功能大概需要10分钟。

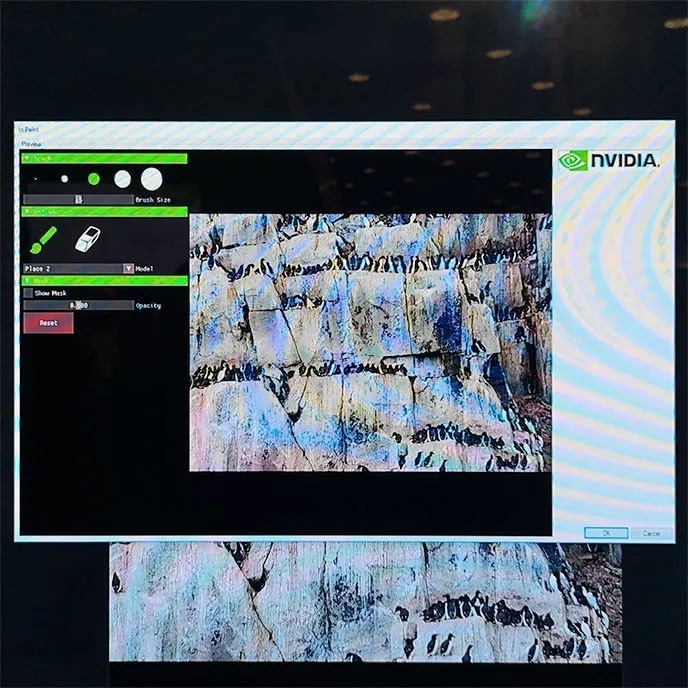

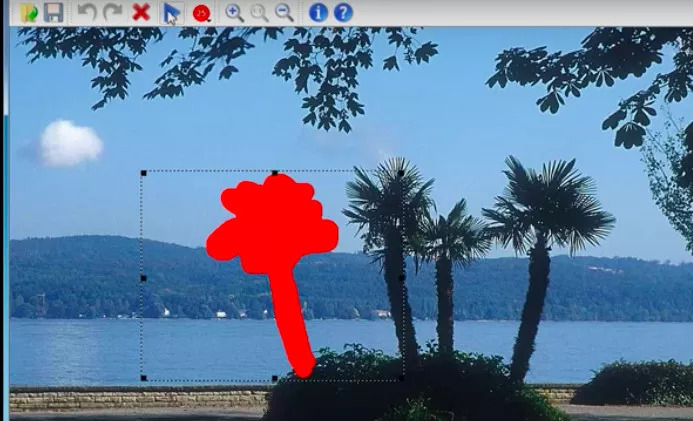

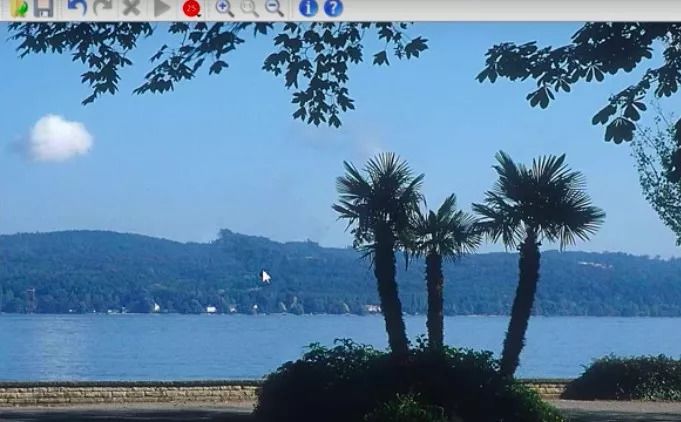

第二个插件是Inpaint。

这个插件用AI增强了Photoshop的内容感知填充。英伟达演示的案例是,在陡峭的悬崖上绘制成群结队的企鹅,企鹅脚下的岩石看起来如真的岩石一样粗糙,看起来并不像用传统的画笔从附近区域复制过来的。

据雷锋网了解,Inpaint这个技术由英伟达Guilin Liu领导的团队开发,运用了最先进的深度学习方法,可以编辑重建损坏的图像,同时也可以通过移除部分图像并重新填充来编辑图像。

“我们的模型可以稳健地处理任何形状、大小、位置距离的图像破洞。以前的深度学习方法主要关注位于图像中心周围的矩形区域,并且通常依赖昂贵的后期处理”。

(使用Inpaint去除多余的一棵树)

为了准备用于训练的神经网络,该团队首先生成了55,116个随机条纹和任意形状和大小的图像破洞用于训练。该团队使用NVIDIA Tesla V100 GPU和cuDNN加速的PyTorch深度学习框架,该团队通过将生成的图像破洞的蒙版应用于ImageNet,Places2和CelebA-HQ数据集中的图像来训练他们的神经网络。在训练阶段,将破洞或缺失部分引入上述数据集的完整训练图像中,以使网络能够学习重建丢失的像素。

目前,英伟达演示的Inpaint运行于6300美元的Quadro RTX 6000显卡上,但是其效果实现所花费的时间依然不短。或许因为如此,英伟达表示它没有计划发布这些插件,只是展示新显卡和Nvidia的NGX SDK的可能性。

相比于价格高昂的Quadro系列,英伟达于8月21日发布的几款针对游戏玩家的Geforce RTX显卡价格则要亲民很多。

草图视频生成真实视频

英伟达与Adobe合作的这几款插件看起来都很日常,而英伟达与MIT合作的一项视频生成技术看起来则尤为炫酷。

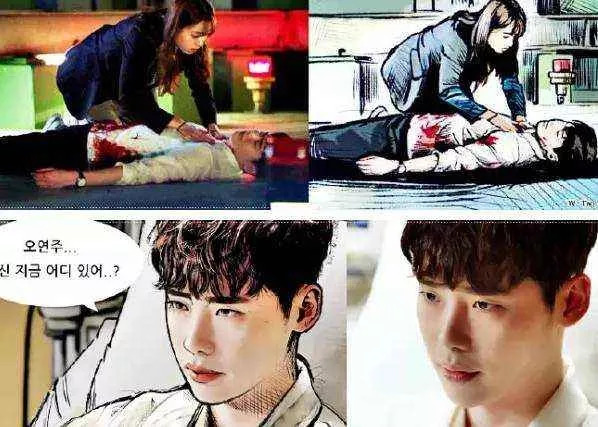

不知道是否有人看过韩剧《W两个世界》,在这部大火的浪漫韩剧中,男主人公是从一本漫画里走出来的,女主人公也能在二次元和三次元之间随意穿梭。

英伟达新的技术向我们展示了“脑洞大开”的韩剧也是有实现的可能,用线条画一个帅哥,然后一键转换,他的真实的眉眼就出来了,就这么神奇。

效果如下:给出一个由简单线条组成的素描草图就能生成细节丰富的人脸,脸型、鼻子眼睛嘴巴等五官、发型等都和草图的轮廓一致,最厉害的是生成的人物还能流畅地动起来。

目前,我们能看到的图像处理技术能做到的主要是背景分割、人脸区域分割,用来对头发发型、发色、面部五官进行调整。而像这样根据草图直接生成一个崭新的人脸,不免让人讶异。

除了人物,英伟达和MIT的这项技术也可以用于实景。可以合成长达30秒的2K分辨率街景视频。

右边是一幅动态语义地图,左边则是和真实世界一样的视频。可以看到,两边的场景的布局完全一样,所以这并不是找了一个相似的视频出来,而是依葫芦画瓢全新生成的。

由于是计算机生成的,你可以对视频中的元素进行修改,例如,将道路两侧全部变成树木,或者全部变成建筑。

据雷锋网了解,此项目由英伟达和MIT组成的团队开发,包括英伟达的Ting-Chun Wang、刘明宇(Ming-Yu Liu),以及来自MIT的朱俊彦(Jun-Yan Zhu)等。

以上几位研究员合著了一篇名为“Video-to-Video Synthesis”的论文,论文摘要现实,该论文研究视频到视频的合成问题,目标是学习从输入源视频(例如,一系列的语义分割掩码)到输出照片级视频的映射眼熟,输出视频能精确地描绘原视频内容。论文提出了一种新型的生成对抗网络框架下的视频到视频合成方法。通过精心设计生成器和判别器架构,结合空间-时间对抗目标函数,在多种输入视频格式下生成了高分辨率、时间连贯的照片级视频,其中多种形式的输入包括分割掩码、草图和姿态图。

视频合成的demo很炫酷,可以想象,以后影视制作中的一些部分完全可以不用实景拍摄,画个简笔画然后合成真实视频就可以了。但是,很显然,这个视频到视频的合成的技术比前面介绍的Adobe里用到的AI图像处理技术还要难实现,目前还停留在实验室阶段。

GPU与AI图像处理

图灵架构的实时光线追踪无疑是最让人惊叹的,其能计算光线反射、折射、散射,渲染出逼真的画面,对游戏、影视的画面效果会带来很大的提升。

此外,图灵架构还有更多的特性:

Tensor Core可加速深度神经网络训练和推理;

图灵流式多处理器(Turing Streaming Multiprocessor)架构拥有4608个CUDA core,可提供高达16 teraflops的计算性能,并行运算每秒16万亿次整数运算,以加速模拟真实世界的物理模拟;

先进的可编程着色技术可提高复杂视效和图形密集型工作体验;

首次采用超快速的三星16Gb GDDR6内存,支持更复杂的设计、海量建筑数据集、8K电影内容等;

NVIDIA NVLink可通过高速链路联通两个GPU,将内存容量扩展至96 GB,并可通过高达100GB / s的数据传输提供更高性能;

增强型技术可提高VR应用性能,包括可变速率着色(Variable Rate Shading)、多视角渲染(Multi-View Rendering)和VRWorks Audio。

计算机图形领域一直追逐更清晰的图像显示、更逼真的渲染、更快的处理速度是,GPU的性能提升在不断实现这些目标。如今,AI与图像处理的结合给我们带来更多的可能性,这也是不少公司都在布局的方向。

在今年的WWDC上,苹果重点介绍了其Metal和ML两大技术。2014年苹果推出Metal,能利用GPU获得更高的图形计算能力,使得一些操作游戏如《堡垒之夜》在iPhone上运行。通过对eGPU的支持,Metal使得苹果的设备能够获得更逼真的3D渲染效果,还能帮助Unity实现实时的光线渲染效果。

此外,Metal的另一大特色在于,其能支持机器学习,加速训练神经网络这样的计算密集型任务。因此基于Metal开发的机器学习工具Core ML也能利用GPU,在效率上得到很大提升。

GPU和AI技术的提升,无疑也将对VR的发展起到推动的作用,雷锋网编辑期待着更多炫酷的AI图像处理技术的诞生。

关注雷锋网(leiphone-sz)回复 2 加读者群交个朋友