SFFAI分享 | 连政:端到端语音合成【附PPT与视频资料】

关注文章公众号

回复"SFFAI31"获取PPT资料

视频资料可点击下方阅读原文在线观看

作者介绍

连政,中国科学院自动化研究所模式识别国家重点实验室16级硕博生。目前研究兴趣为多模态情感识别、语音合成和语音转换。

导读

如何使人机交互中机器的声音更具情感和表现力一直是一个重要的研究热点。不同于传统pipeline式的语音合成系统,端到端的语音合成方法凭借简练的模型结构,突出的性能获得了越来越多的关注,其中以wavnet, tacotron, tacotron2等最为著名。

正文

通常的语音合成系统包含文本分析、声学模型和声码器等模块。而构建这些模块需要大量专业相关的知识以及特征工程,这将花费大量的时间和精力,而且各个模块之间组合在一起也会产生很多新的问题。近期,王雨轩等人提出TACOTRON框架,将文本分析和声学模型统一为一个模块,合成语音在自然度和清晰度方面,超越了传统的基于参数合成和拼接合成的语音合成系统。在声码器方面,传统声码器重构语音存在频谱细节丢失,语音相位依赖最小相位假设和人工设计等问题,导致重构语音自然度和音质下降,DeepMind研究者提出的WaveNet结构,可以直接学习到采样值序列的映射,因此具有很好的合成效果。目前主流的语音合成框架就是TACOTRON + WaveNet的结构。

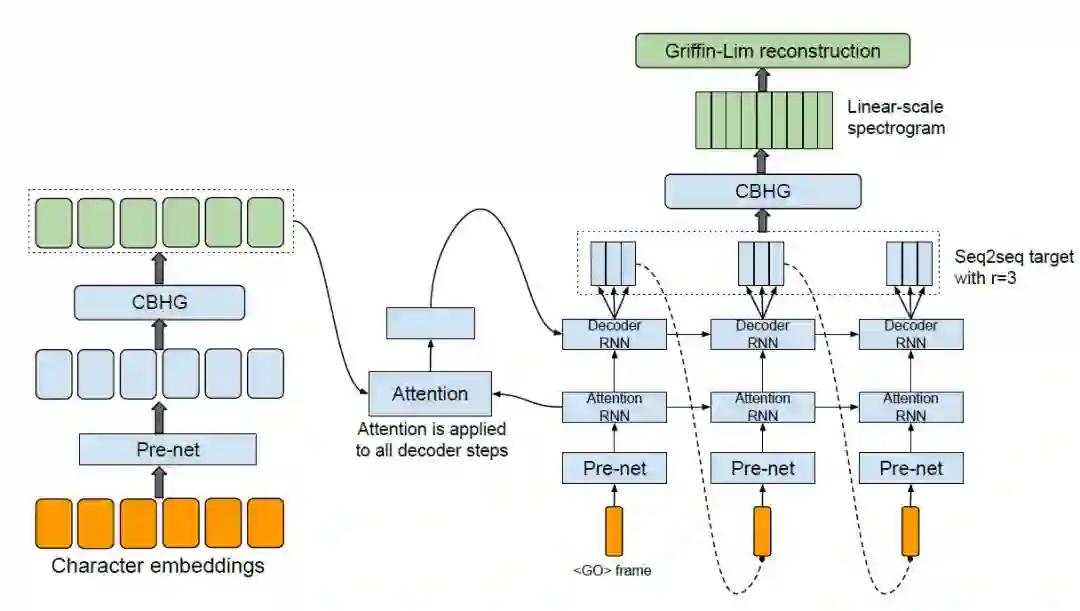

TACOTRON的核心模块是基于注意力机制的编码器-解码器模型。模型结构如下图。它包含一个编码器,一个基于注意力机制的解码器和一个后处理网络。从高层面上说,模型把字符作为输入,产生的谱参数随后被转换成波形。其中,编码器的目的,是提取文本的鲁棒序列表达。使用高效的编码器实现可以提取出更具表达力的高级别表示,从而有助于模型泛化。编码器的输入是字符序列或者音素序列(对于汉语,输入可以为带调的声韵母序列);解码器采用基于内容的注意力解码器,在这个解码器中,一个有状态的循环层在每个时间步骤上都产生一次注意点查询。再把上下文向量和Attention RNN单元的输出拼接在一起,作为解码器RNN的输入;后处理网络的任务是,把seq2seq的输出转化成可以被合成为波形的目标表达。在原始端到端模型被提出来时,使用Griffin-Lim做合成器,因此后处理网络要学习的是如何预测在线性频率刻度上采样的频谱幅度(线性谱)。

图1 TACOTRON网络结构示意图

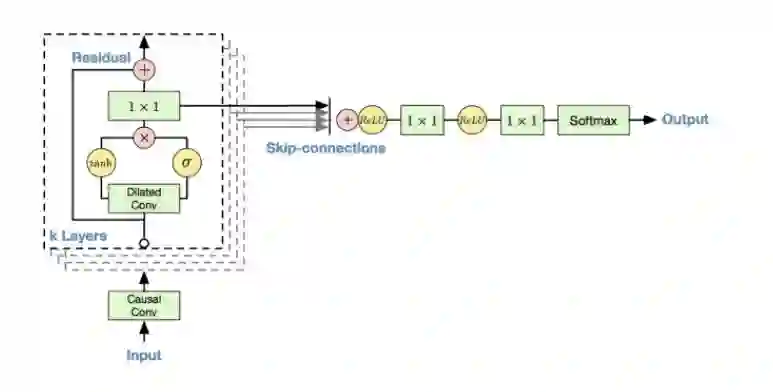

WaveNet结构,是一种序列生成模型,可以用于语音生成建模。在语音合成的声学模型建模中,WaveNet可以直接学习到采样值序列的映射,因此具有很好的合成效果。目前Wavenet在语音合成声学模型建模,声码器方面都有应用,特别是在声码器建模方面,能够与前端端到端Tacotron进行结合,生成媲美人类录音水平的效果。网络结构如图2所示。WaveNet是一种自回归(autoregression)的深度生成模型,可以根据一个序列的前n-1个点预测第n个点的结果,因此可以用来预测语音中的采样点数值。WaveNet采用因果卷积神经网络来对条件概率建模,每个卷积层都对前一层进行卷积,卷积核越大,层数越多,时域上的感知能力越强,感知范围(receptive field)越大。在生成过程中,每生成一个点,把该点放到输入层最后一个点继续迭代生成即可。由于语音波语音的采样率高,时域上对感知范围要求大,WaveNet使用了扩张因果卷积网络结构(Dilated Casual Convolutions)来获得足够大的接受野。此外,WaveNet采用了类似PixelCNN的加门控激活函数。于此同时,WaveNet还采用残差网络结构以及参数化的跳跃链接(skip connection)来构建深层次的网络,同时这种网络结构也有助于加快模型收敛。

图2 WaveNet网络结构示意图

SFFAI招募召集人!

现代科学技术高度社会化,在科学理论与技术方法上更加趋向综合与统一,为了满足人工智能不同领域研究者相互交流、彼此启发的需求,我们发起了SFFAI这个公益活动。SFFAI每周举行一期线下活动,邀请一线科研人员分享、讨论人工智能各个领域的前沿思想和最新成果,使专注于各个细分领域的研究者开拓视野、触类旁通。

SFFAI自2018年9月16日举办第一期线下交流,每周一期,风雨无阻,截至目前已举办33期线下交流活动,共有64位讲者分享了他们的真知灼见,来自100多家单位的同学参与了现场交流,通过线上推文、网络直播等形式,50000+人次参与了SFFAI的活动。SFFAI已经成为人工智能学生交流的第一品牌,有一群志同道合的研究生Core-Member伙伴,有一批乐于分享的SPEAKER伙伴,还有许多认可活动价值、多次报名参加现场交流的观众。

我们邀请你一起来组织SFFAI主题论坛,加入SFFAI召集人团队。每个召集人负责1-2期SFFAI主题论坛的组织筹划,我们有一个SFFAI-CORE团队来支持你。一个人付出力所能及,创造一个一己之力不可及的自由丰盛。你带着你的思想,带着你的个性,来组织你感兴趣的SFFAI主题论坛。

当召集人有什么好处?

谁可以当召集人?

怎样才能成为召集人?

为什么要当召集人?

了解我们,加入我们,请点击下方海报!

历史文章推荐:

SFFAI分享 | 黄健:语音情感识别【附PPT与视频资料】

SFFAI分享 | 刘永成:Geometric Relation Learning in 3D Point Cloud Analysis

SFFAI分享 | 马聪:NLP中的生成式预训练模型【附PPT与视频资料】

SFFAI分享 | 罗玲:From Word Representation to BERT【附PPT,视频】

SFFAI分享 | 古纾旸:Generative model is more than just GANs【附PPT与视频资料】

SFFAI分享 | 李祥泰:Context modeling in semantic segmentation【附PPT,视频】

SFFAI分享 | 考月英:科研与工作经历分享【附PPT】

SFFAI分享 | 王少楠:博士生活杂谈【附PPT与视频资料】

SFFAI分享 | 张士峰:经验分享之我的科研历程【附PPT与视频资料】

语音关键词检测方法综述【附PPT与视频资料】

脉冲神经网络与小样本学习【附PPT】

若您觉得此篇推文不错,麻烦点点在看↓↓