对比自监督学习浪潮迅猛来袭,你准备好了吗?

回顾自监督学习

回顾对比学习

提出一种比较近期各种对比学习方法的框架

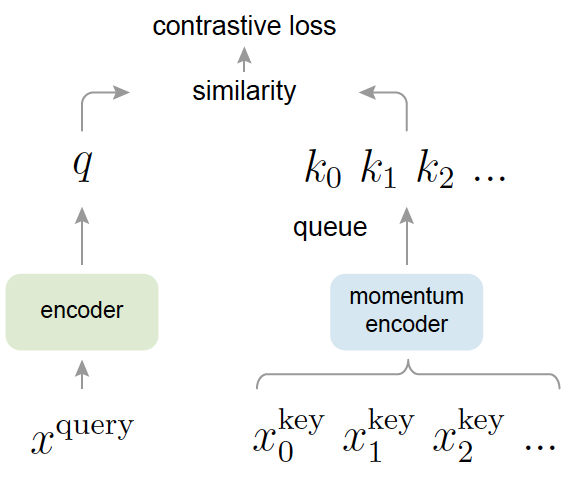

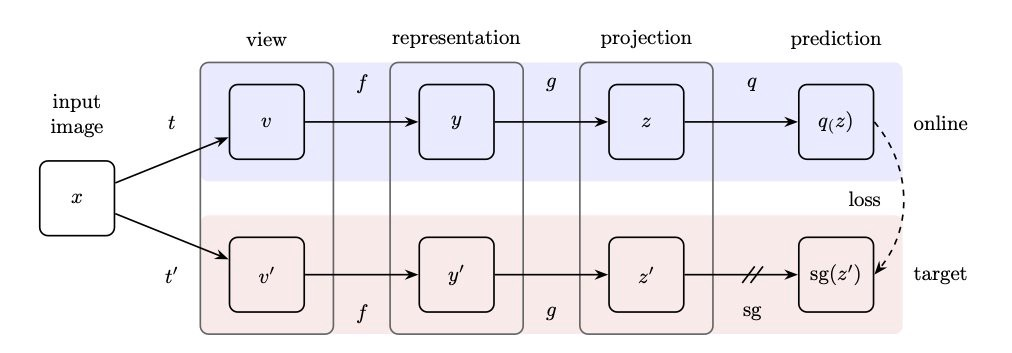

使用我们的框架比较CPC、AMDIM、MOCO、SimCLR、BYOL

使用我们的框架形式化定义了一种新的方法「YADIM」

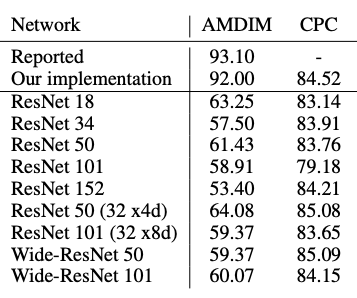

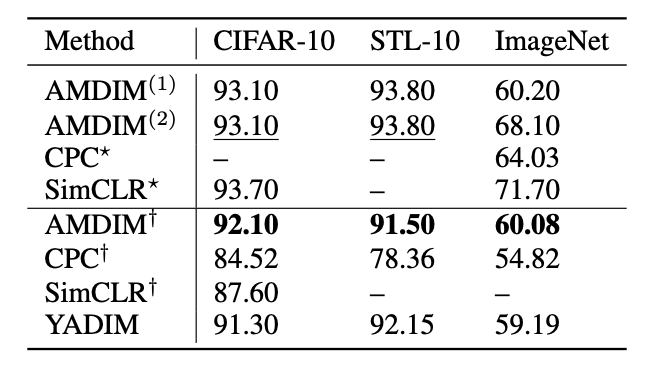

描述了一些我们的实验结果

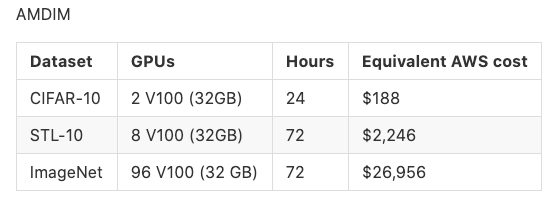

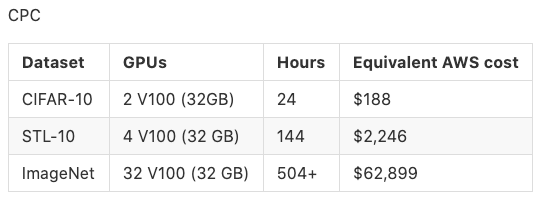

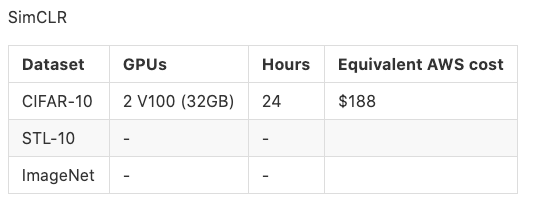

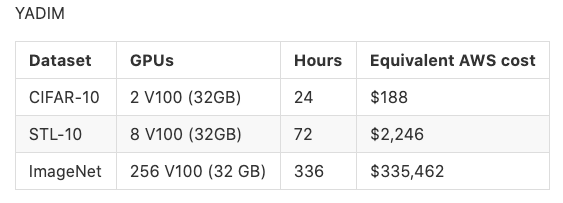

描述了取得这些实验结果的计算要求

实现

AMDIM:https://pytorch-lightning-bolts.readthedocs.io/en/latest/self_supervised_models.html#amdim

BYOL:https://pytorch-lightning-bolts.readthedocs.io/en/latest/self_supervised_models.html#byol

CPC V2:https://pytorch-lightning-bolts.readthedocs.io/en/latest/self_supervised_models.html#cpc-v2

Moco V2:https://pytorch-lightning-bolts.readthedocs.io/en/latest/self_supervised_models.html#moco-v2

SimCLR:https://pytorch-lightning-bolts.readthedocs.io/en/latest/self_supervised_models.html#simclr

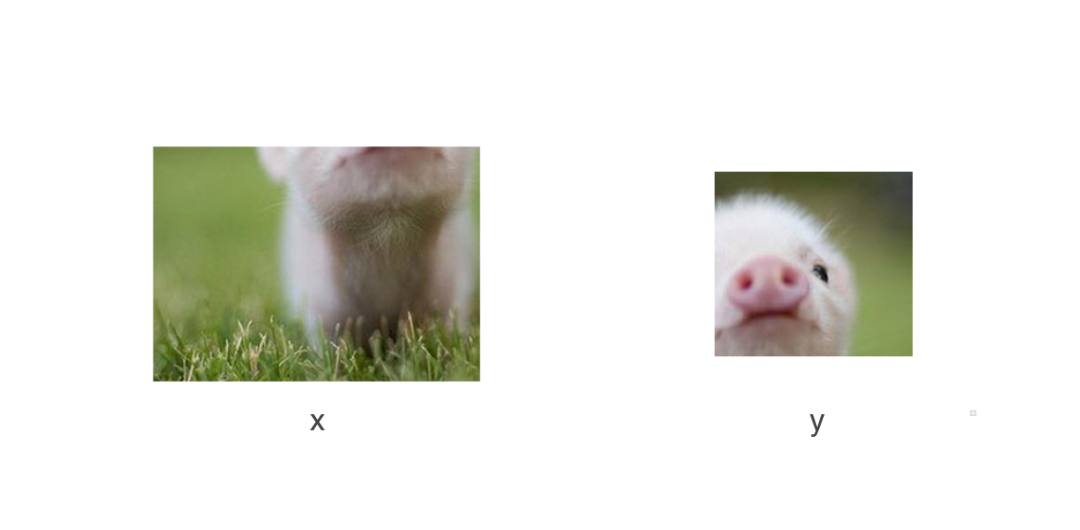

自监督学习

-

预测两个图块之间的相对位置(https://arxiv.org/abs/1505.05192) -

解决一个拼图问题(https://arxiv.org/abs/1603.09246) -

对某张图像进行着色(https://richzhang.github.io/colorization/)

对比学习

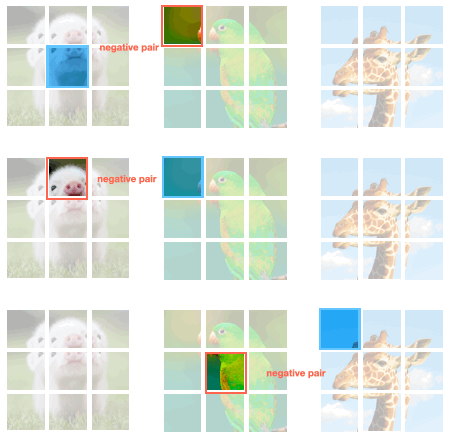

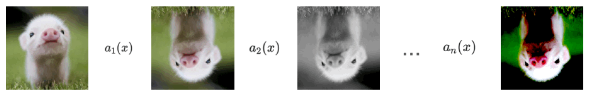

特性1:数据增强过程

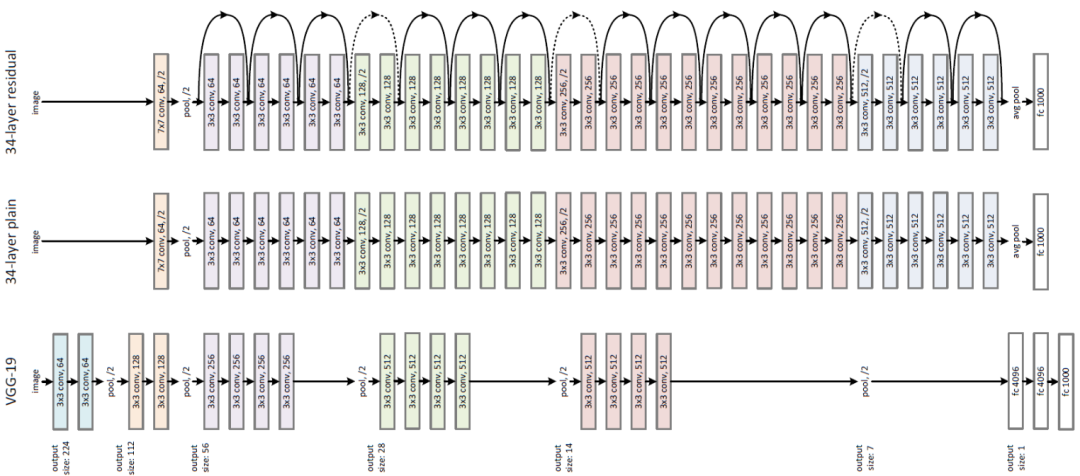

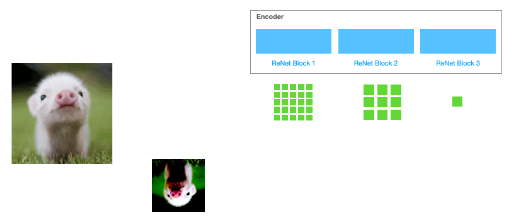

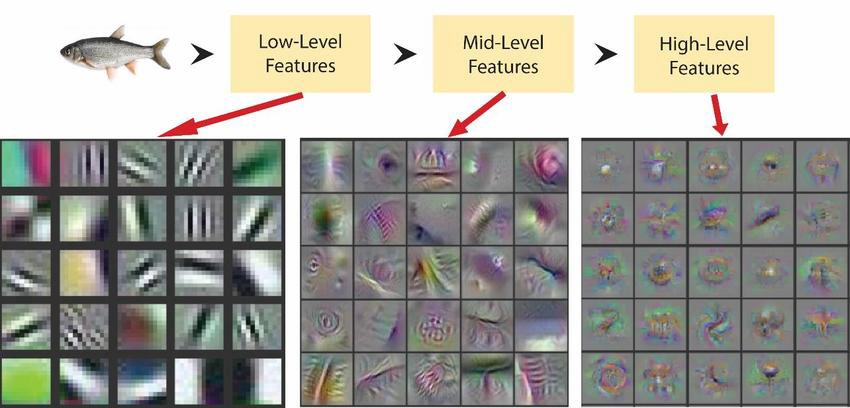

特性2:编码器

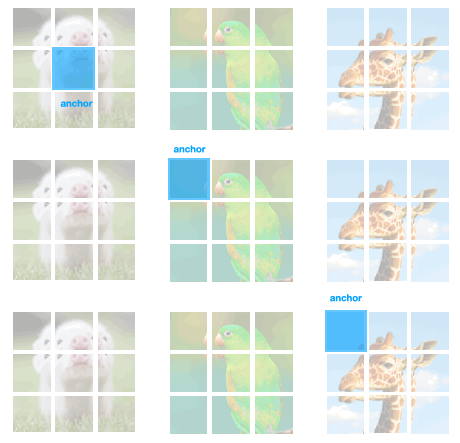

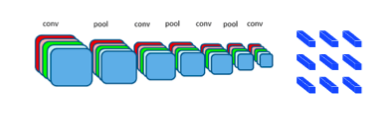

特性3:表征提取

关于特性3的思考

特性4:相似度度量

特性5:损失函数

另一种DIM(YADIM)

要点回顾

为了比较各种对比学习方法并且更容易地对其进行设计,我们引入了一种概念框架。

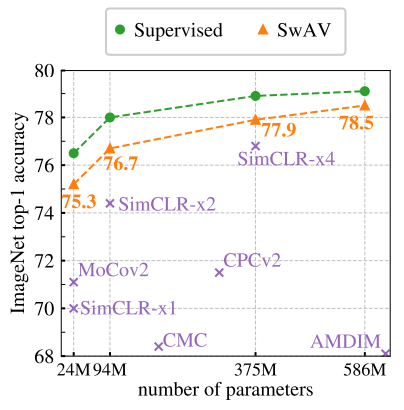

AMDIM、CPC、SimCLR、Moco、BYOL 以及 Swav 之间的差异非常微小。主要的不同之处在于它们提取表征的方式。

AMDIM 和 CPC 提出了被其它方法采用的关键思想。SimCLR、Moco、BYOL 以及 Swav 可以看做 AMDIM 的变体。

只要编码器够宽,对于编码器的选择并没有影响。

只要数据增强过程生成良好的正负样本输入,表征提取策略并没有太大的影响。

通过使用我们的框架,我们可以形式化定义一种新的对比自监督学习方法「YADIM」,它与其它的竞争方法性能相当。

训练这类方法的巨大计算开销意味着:在世界上,只有有限的研究组可以在该领域持续取得进展。尽管如此,我们以一种标准化的方式表述了所有这些算法,这至少可以减轻实现这些算法并对实现进行验证的困难。

由于大多数实验结果都是由更宽的网络和特定的数据增强过程驱动的,我们猜想当前的研究方向的提升空间可能较为有限。