人工智能,无处不在的AI风险在何处?|网络法律评论

一、引言:图灵测试与AlphaGo

六十多年前,计算机科学之父阿兰·图灵 (Alan Turing) 曾提出著名的图灵测试 (Turing Test),判断机器是否能够思考,或更准确地说,判断机器是否能够表现出与人类相同或者至少无法区分的智能 (intelligence)。

关于机器是否能够思考的问题可追溯到数百年前勒内·笛卡尔 (René Descartes) 所提出的关于机器与人类的见解。在1637年出版的《谈谈方法》(中译名)一书中,笛卡尔提到人类可以创造出可以说话的机器,甚至可以与人类进行简单的互动。笛卡尔判断机器是无法像人类一样合理且多样地安排自己的语言与人类无障碍交流,却没有预料到未来科技的发展有效的解决了机器语言的难题。

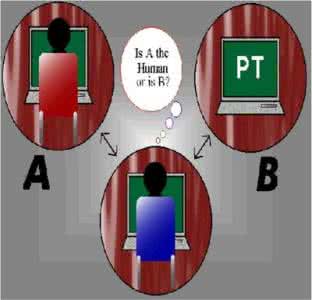

1950年,图灵发表的一篇里程碑式的论文《计算机器与智能》 开创了人工智能的先河。在这篇文章中,图灵提出了判断机器智能的测试,即著名的“图灵测试” (Turing test):如果一台机器能够与人类正常开展对话而不被识别出来(并不是人类在交流而是机器),那么这一台机器就具有智能。图灵测试的操作方法非常简单,由一名测试者像两个无法看见的测试对象提出一系列的问题。测试对象中一个是正常人 (A),而另一个是机器 (B)。经过一系列询问和回答之后,如果测试者无法区分A与B的不同,那么这台机器就通过了图灵测试。

2014年6月8日,英国雷丁大学 (University of Reading) 宣布由俄罗斯人弗拉基米尔·维西罗夫 (Vladimir Veselov) 创造的人工智能“尤金·古斯特曼” (Eugene Goostman) 通过了图灵测试,成为人工智能乃至计算机史上的里程碑事件。 在这场为纪念图灵去世60周年举办的图灵测试竞赛中,尤金让测试者相信所对话的是一名13岁的男孩。 然而,这一结论也在计算机界中受到了诸多质疑。

2016年,人工智能领域最为热门的事件无疑是谷歌 “阿尔法狗” (AlphaGo) 大战人类智能代表、围棋世界冠军李世石。阿尔法狗最终以4:1的总比分在人机大战中获胜,被认为是人工智能的崛起的标志性事件。阿尔法狗是谷歌旗下DeepMind公司开发的一款围棋人工智能程序,以深度神经网络 (deep neural networks) 和 “树搜索” (search tree) 为主要特征。 赛后,在世界职业围棋排名中,阿尔法狗落后人类排名第一的棋手柯洁屈居第二。

对比来看,阿尔法狗并没有实现图灵测试所要求的通用智能,而仅是在围棋这一特殊应用领域的突破。为什么阿尔法狗的成功能够代表着人工智能的崛起?到底什么是人工智能?我们又应该在什么层面上讨论人工智能的法律问题?

二、什么是人工智能?

人工智能 (Artificial Intelligence, AI) 的概念在20世纪50年代的达特茅斯会议 (Dartmouth Summer Research Project on Artificial Intelligence) 中被提出,会议发起人包括约翰·麦卡锡 (John McCarthy)、马文·闵斯基 (Marvin L. Minsky)、纳撒尼尔·罗切斯特 (Nathaniel Rochester)以及克劳德·香农 (Claude E. Shannon)。不过在此会议之前,英国科学家已经开展了十几年的人工智能相关研究。

目前尚且没有普遍公认的人工智能概念。有人提出了相对宽泛的定义,认为“人工智能是展现出智能行为,也即需要智能才能够实现的行为的计算系统”。也有人提出了相对明确的智能发展目标,认为“无论在什么样的真实环境中,人工智能能够理性地解决复杂难题,或者能够采取适当的行动,以实现设定目标的系统。” 达特茅斯会议发起人之一的麦卡锡认为,对人工智能的理解尚且需要依赖人类智能 (human intelligence) 的概念。 很大程度上人工智能的最终目标是让计算程序能够具备人类那样处理难题的能力。

根据Russel以及Norvig提出的现代进路,人工智能可分为四类,详见以下表格。

类别 |

应用 |

像人类一样思考的系统(system that think like human) |

认知结构和神经网络 |

像人类一样行为的系统(system that act like human) |

通过自然语言处理通过图灵测试;知识表达、自动推理和学习 |

理性思考的系统 (system that think rationally) |

逻辑解算器 (logical solvers)、推理和最优化 |

理性行为的系统 (system that act rationally) |

能够通过认知、计划、推理、学习、交流、决策、行动来实现目标的智能软件和具身化 (embodied) 的机器人 |

表格2.1人工智能的分类

回答导言中提出的问题,图灵测试和阿尔法狗实际上代表了不同层面的人工智能。21世纪前后成为社会热点的人工智能,诸如IBM的深蓝 (Deep Blue) 以及Google的阿尔法狗,都是人工智能的局部设计,被称之为“狭义的人工智能” (Narrow AI)。这类智能能够在某一特殊领域——比如围棋、无人驾驶、图像识别——发挥人类无法实现的效用,但是与图灵测试所要求的更为一般性的人工智能还相差甚远。后者更加理想,也更难以实现。这类更为强大且全面的智能被称之为 “通用智能” (Artificial General Intelligence, AGI),也即AI系统能够实现至少和人类一样的高级智能行为。这一方向也代表着人工智能科研的未来。近年来通过将狭义的人工智能扩张从而实现通用智能的进路收效甚微;科学家普遍认为至少在未来数十年间通用智能尚无法实现。

三、人工智能发展趋势与热点应用

为展现人工智能在2016年的发展趋势及成果,并为下文法律问题分析提供事实支撑,本节从法律的视角出发,选择无人驾驶、智能律师以及判决预测这三大人工智能的应用领域展开案例分析。需要指出的是,本节的梳理只关注法律和人工智能的交叉领域,不包括2016年人工智能在技术层面的突破或者法律之外领域的应用(比如会计、新闻等)。

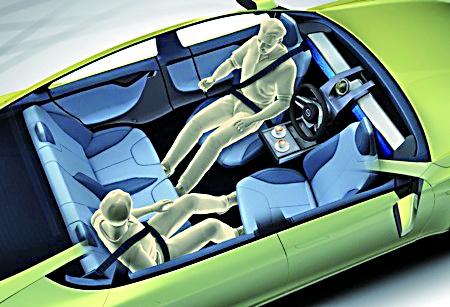

(一)法律治理AI:无人驾驶

随着自动驾驶技术的日臻成熟,这一科技领域的相关法律问题已经开始得到广泛关注。多国政府都在近年间出台了相关的政策、指引文件甚至法律,在2016年尤甚。

美国无论是在自动驾驶技术,还是相关规范的创新上都走在世界前列。奥巴马政府非常注重无人驾驶技术的发展,并提供了很大的政策支持。

早在2013年5月,美国国家公共交通安全管理局 (The National Highway Traffic Safety Administration, NHTSA) 就制定了《自动驾驶政策的初步声明》。2016年初,美国交通部部长安东尼•福克斯 (Anthony Foxx) 在底特律汽车展上公布了正式版本的《自动驾驶政策声明》。

福克斯还介绍了美国总统《2017财年预算提案》 ,称美国将划拨40亿美元成立长达十年的自动驾驶扶持计划,加速相关技术的研发和商业使用。2016年2月4日,NHTSA对《联邦机动车安全标准》可能适用于谷歌的无人驾驶车的若干条款进行了解释。美国交通部也于当年3月发布了对这一系列标准的审议报告,并于同年9月份发布了联邦无人驾驶政策。

目前美国联邦层面适用于无人驾驶的法律仅有一部,即《完善美国地面交通法案》(Fixing America’s Surface Transportation Act, FAST),已于2015年正式生效。另一部法律草案《自动驾驶车辆隐私保护法案 (2015)》(Autonomous Vehicle Privacy Protection Act of 2015) 尚待美国两院审议。 在州法层面,美国目前已经有5个州(加利福尼亚州、密歇根州、内华达、田纳西州以及佛罗里达州)以及华盛顿特区通过了关于无人驾驶监管的法律。

英国交通部也于2016年7月发布了关于扶持司机辅助系统 (Advanced Driver Assistance System, ADAS) 以及自动驾驶技术的提案。与美国不同的是,英国将政策重心放在了无人驾驶卡车 (driverless lorries) 上,原因在于英国高速路网中高速路出入口远远多于其他欧盟国家;一旦大型货车堵在路口,将很可能造成交通拥堵。英国交通部希望能够在重型运输车辆 (HGV) 的使用上处于世界领先地位,从而提升物流速度,减轻道路拥堵状况。 英国无人驾驶卡车车队将很快开始测试。

除了英国之外,其他欧盟国家也在推进无人驾驶技术的发展。比如,德国总理默克尔就曾在2016年4月宣称德政府将开始扶持无人驾驶车的发展,会尽快开始对自动驾驶车辆进行路测,同时扫清相关的法律障碍。 按照默克尔的建议,德国汽车行业将首先草拟一份关于无人驾驶行业发展的“愿望清单” (wish list) 以及时间表。在此基础上,德国政府将与行业共同磋商自动驾驶行业的发展。此外,德国内阁会着力解决无人驾驶的相关法律问题,为接下来进行的测试提供法律基础。

(二)AI学习法律:智能律师

法律在塑造AI发展方向上发挥着重要的作用,然而AI也在快速渗透法律业,有望带来法律实践的颠覆性变革。2016年最为著名的律师莫过于ROSS Intelligence——世界上首位人工智能律师。在ROSS Intelligence公司发布的白皮书中,CEO 安德鲁·阿鲁达 (Andrew Arruda) 称其为“协助展开法律研究的人工智能律师”。ROSS的研发可以追溯到2014年多伦多大学学生团队的一项研究。在一年之后得到了创业加速器 Y Combinator 的支持下,ROSS被转移到美国加州进行了10个月的破产法学习,随后就在2016年得到了第一份工作,在纽约Baker & Hostetler律师事务所,负责公司破产业务。从开始研发到上市AI ROSS进入法律界只用了11个月的时间。

这一智能系统所采用的方法包括机器学习 (machine learning) 和自然语言处理 (natural language processing)。ROSS Intelligence实际上是IBM人工智能技术在法律领域的第一次应用。这一系统建立在IBM的超级认知计算机Watson之上。作为一台久负盛名的超级计算机,Watson曾在2011年一档智力竞赛节目Jeopardy中经过连续三夜的马拉松大战最终战胜人类获得竞赛的冠军。

ROSS的强大指出在于能够理解自然语言。对应的概念为人造语言 (artificial language),如世界语。律师可以通过“自然语言”(比如英语或者中文)向ROSS发问:“What is China’s new cybersecurity Act?” (中国最新的网络安全法是什么?)随即该AI系统将在阅读整个法律体系的条文之后提供答案,并且附带最新的相关文献,包括立法、判例法以及二级文献。

此外,ROSS还能够帮助简化很多日常的法律实践,帮助律师、法官以及公司法务人员等更加高效的工作。通过自然语言处理和机器学习,它可以帮助律师起草和审核合同。利用成像技术 (imaging) 这一智能系统还能够分析法律文件,辨别不同元素间的异同。未来的语音系统 (speech system) 还能够实现由AI代表任一一方当事人展开庭审论辩。ROSS还可以随时追踪最新的法律动态,例如在法院做出新的判决之后第一时间通知其律师同事。最后,通过持续性向用户学习,ROSS还可以不断发展完善,并越来越智能。

(三)AI预测法律:判决预测

AI不仅能够实现更为高效的法律工作,甚至能够预测判决的最终结果。例如,一项由多个全球顶尖大学——UCL、谢菲尔德大学以及宾夕法尼亚大学——合作完成的研究发现,如果让一个人工智能系统学习欧盟人权法院近年来做出的所有相关判决,然后进行预测究竟哪一方能够胜诉,最终结果显示,AI预测准确率高达79%。一旦智能系统在判决预测这一特殊领域成熟起来,还可以扩展应用到证人证词以及律师辩护稿。研究人员届时会使用更多的数据展开测试。虽然AI能够实现很高的预测率,有批评者指出它无法理解法律案件的微妙差别。如果仅仅依赖于训练数据,而不对案件的背景有足够的了解,AI的预测很可能会失准,并对最终判决带来不利影响。

四、人工智能的热点法律问题

(一)隐私和数据安全

由于自动驾驶等人工智能的应用大量依赖于智能系统内数据的流动或传输,相关数据又涉及个人私人事务,隐私和数据安全是人工智能相关的两大重要法律问题。 以无人驾驶为例,自动驾驶车辆网络的有效运转势必依赖大量位置数据及其他个人数据。这种大规模的数据实践可能带来诸多层面的隐私问题。无人驾驶技术的发展因此势必需要在车辆网络的有效运转、数据的商业使用以及厂商利益,以及用户个人的私人利益之间达成有效的平衡。

另一方面,无人驾驶可预见的风险在于安全性。一旦人类将车辆的控制权交给了人工智能,后者又不能独立确保车辆网络运转保持正常,可能出现的安全事故导致的后果是不可预估的,这也是对人工智能治理讨论的核心之一。安全风险的来源可能有两种,其一是车辆系统自身出现错误导致系统故障或崩溃,还有一种可能是网络恶意袭击和恐怖主义事件。可见,数据安全层面的人工智能治理也可以和反恐措施有密切联系。

(二)版权

人工智能的自主思考能力还能够应用在艺术创作上面。在2016年诞生了很多由人工智能创作的作品。

影视方面,9月份IBM公布了超级计算机Watson创作的电影预告片Morgan。 IBM的研究者向Watson提供了100部恐怖片的预告视频并将其分割成分离的瞬间和场景。Watson通过一系列的影像、声音和创作分析来学习预告片的样态。 此外,2016年6月还有一部名为“Sunspring”的科幻片在Ars发布,宣称完全由AI创作。

音乐方面,索尼公司的 AI在2016年创作了第一部流行歌曲,取名为《爸爸的车》(“Daddy’s car”)。 这首歌曲由索尼的Flow Machines软件通过分析13000首来自全世界不同类型的音乐创作而成。谷歌也发布了一首AI创作的钢琴曲,时常90秒。曲子基本上由经过训练的神经网络创作,不过最开始的4个音符由人类提供。这是谷歌的Magenta项目完成的第一部作品,该项目旨在利用谷歌的机器学习系统创作艺术和音乐作品。

文学作品方面,谷歌的研究人员在2016年发表了一篇关于训练AI进行科幻小说创作的文章。 为了让AI能够更加自然流畅的与人交流,研究者让AI在毫无联系的两个句子之间建立语句关联。所使用的训练数据为12000本科幻类的电子书,此外还包括很多浪漫小说。

一旦人工智能可以像人类一样创作,相关作品是否具有版权,以及与人类作品有何异同就成为了人工智能在版权领域治理的关键。2016年已经有部分国家开始就人工智能创作的问题开始对版权法的适用范围展开讨论。例如,日本政府的知识产权战略本部在2016年展开讨论如何制定法律保护AI创作的音乐、小说等作品的相关权利。 根据日本《著作权法》,只有人类创作的作品享有著作权,而不包括AI的作品。由于该法将作品定义为 “思想和感情的创作型表现”,如果没有人类加入创作,AI的作品很难成为受保护的对象。

就AI作品的版权问题,Annemarie Bridy认为,考虑到智能软件愈发复杂,并且所有的创造性都来自于代码,实际上AI作品并不像我们一开始认为地那样成分混杂。从规范的角度上,Birdy认为AI的作者身份问题可以适用雇佣理论 (Hire Doctrine) 而纳入到目前的版权保护框架当中。也即,AI作品的版权可以赋予并非实际创作 (author-in-fact) 但主导创作过程的法人。因此,虽然不是人类创造性的产物,但AI作品却应归因于人类的创造力。通过这一进路,代码的创作性就能够得到现代版权法的认可。

(三)就业、劳动与社会保障

早期的人工智能系统已经成功地强化了人类劳动 (human labour),并且很大程度上颠覆了不同劳动部门的组织结构。 然而,一旦人工智能(尤其是通用智能)大规模应用于社会的多个层面,将可能导致大规模的失业。其中低技能工种 (low-skill jobs) 最有可能被人共智能和自动化取代。

2014年皮尤研究中心做了一项关于AI与就业的调查研究;围绕着一个前瞻性的核心问题——在2025年,人工智能应用以及机器人所取代的工作会比其创造的多吗?皮尤的研究者邀请了1896名专家学者回答这一问题并提出自己关于人工智能和劳动市场的见解。结果显示,在人工智能和机器人对劳动市场的影响这一问题上存在着普遍的分歧。

有近一半的专家 (48%) 认为未来人工智能会取代大量的工作,甚至多于未来创造的新工种。他们认为自动化的普及已经很大程度上影响到了蓝领的就业,而以人工智能为首的下一轮科技创新很可能会颠覆白领的劳动市场。在未来新的就业环境中,部分高精尖人才可能会取得极大成功,但大部分人将会永久失业,或者沦为低工种劳动力。如果大量劳动力因为AI的普及导致过剩,很多人担心会引发全球人力资源分配以及社会保障等诸多问题,涉及雇佣关系、权利分配、收入不平等、社会紊乱,甚至工作在每个人生活中扮演的角色。这一阵营的专家还评估了目前的教育系统,认为存在极大的不足,无法帮助下一代掌握必要的技能以从事未来的工种。

还有一半的专家 (52%) 主张科技所取代的工作不会比创造的多。虽然未来很多由人类完成的工作将会在2025年前后交由人工智能完成,但是他们相信人类有智慧创造新的工作、产业以及生活方式,就像在工业革命初期那样。或许人工智能所带来的变革正是一个反思的契机,可以帮助我们解决资本主义劳动市场带来的诸多弊端以及对于个人生活的影响,比如工薪阶层的大量时间投入于工作当中,无法顾及家庭以及自己的爱好等。

五、治理人工智能

仅在某一特殊领域中讨论人工智能的治理可能是片面且不充分的。人工智能在不同领域产生的法律问题可能具有相通性,而且其本身相关的一些基本性问题也需要得到解决。究竟什么是人工智能以及我们在什么层面上讨论治理?当人工智能出现事故时究竟由谁来负责?我们能够在多大程度上将某些关乎个人以及社会重大利益的事务交由机器处理?如何避免或减小AI可能带来的风险和伤害?

目前人工智能还处于规范真空的环境当中。虽然有一些国家或地区已经制定了关于无人驾驶或无人机技术的规范,目前几乎没有法律专门应对AI可能带来的挑战,也几乎没有判决发展出相关的标准来解决“谁应对AI造成的伤害负责”的问题。 传统的监管措施,例如产品许可 (product licensing)、开发监管 (research and development oversight) 以及侵权责任 (tort liability) 无疑存在适用性低的问题。考虑到人工智能的颠覆性,一方面事前治理会非常困难,因为AI的科研和发展是 “不显眼的、不连续的、分散的以及不透明的”,而另一方面AI又具有 “不可预测和不可控的特性”,导致事后监管失灵,尤其是当AI系统崩溃可能导致灾难性后果的情形。

在2016年发表的一篇关于治理人工智能的文章中,Matthew U. Scherer从“机构权能” (institutional competence) 的视角分析了立法、行政以及司法机构在治理人工智能问题上应该扮演的角色。究竟哪一个公权力机构最有能力处理AI崛起所带来的法律挑战?

在Scherer看来,首先,立法机构最适合发布有关AI监管的指引性规则,考虑到其民主正当性以及“授权自由” (freedom to delegate)。

其次,行政机构则更适合决定规范的具体内容,因为它们具有相对的独立性,而且有能力和资源驾驭一些技术问题。在人工智能在社会中扮演重要角色之前,有必要在行政体制内建立一个专门负责AI治理的机构。

最后法院的角色是当AI系统造成伤害之后如何分配责任。

考虑到不同机构的权能和特点,Scherer提出了一个基于“差别侵权责任” 的人工智能治理框架。所谓“差别侵权责任” (differential tort liability) 是指对于风险等级不同的AI系统施以不同程度的责任,而这一框架的核心在于建立一个AI认证系统 (AI certification system)。详言之,经过认证的AI系统若造成伤害将承担相对有限的侵权责任,而未经认证的系统会面临严格的侵权责任。

本文节选自腾讯研究院新近出品的国际互联网法律政策报告《未知的破晓,解构互联网法律前沿》。识别下方二维码可购买☟

相关阅读: