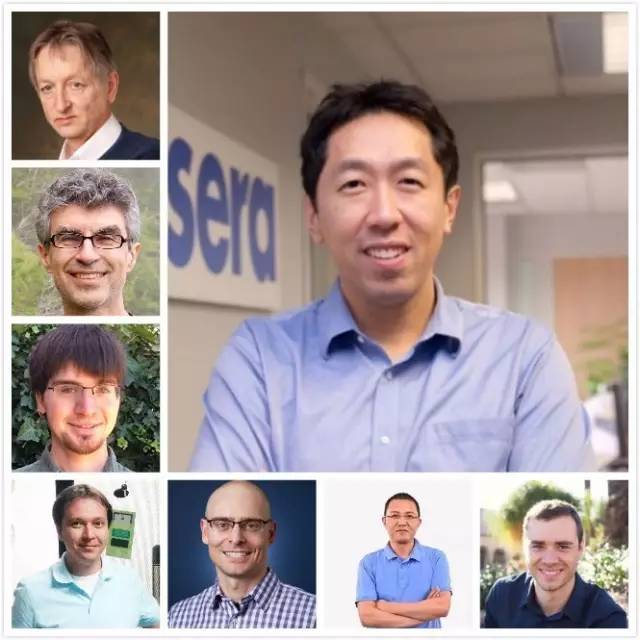

【斯坦福 CS231n 趣事】吴恩达访 Karpathy、林元庆和苹果 AI 负责人

点击上方“公众号”可以订阅哦!

1新智元报道

作者:文强

【导读】吴恩达在他的新计划深度学习系列课程 Deeplearning.ai 里,采访了 7 位深度学习领袖,结合之前整理的 Geoffrey Hinton、Yoshua Bengio、Ian Goodfellow,新智元这次为你献上 Andrej Karpathy、林元庆和苹果 AI 负责人 CMU 教授 Ruslan Salakhutdinov 的访谈。他们关于深度学习和 AI 有什么思考?更多干货,不容错过。

Andrej Karpathy:单独开发各个部分再组装是错误的,开发 AGI 应该从开始就做一个综合的系统

作为斯坦福 CS231N 的形象代言人之一,李飞飞高徒、现在特斯拉 AI 和视觉负责人,Andrj Karpathy 无疑是当前深度学习领域的另一个年轻“网红”。Karpathy 在采访中讲述了他是如何进入深度学习领域,让他感到兴奋和意外的事实,以及对学习深度学习的建议——要学好数学。

Karpathy 本科读多伦多大学,听了 Hintion 的课,知道神经网络能够像人类一样学习,觉得很神奇,那是他第一次接触深度学习。后来,他在英属哥伦比亚大学读硕士的时候了解到机器学习(ML),认为 ML 是对 AI 更技术的描述——可以说与 Ian Goodfellow 的感受十分类似——于是决定从事这个方向的 AI。

Karpathy 认为机器学习是一种新的计算范式,也是对“编程”概念的颠覆:以往是人类写代码编程,而机器学习是人类写优化算法,机器负责编程,其结果有时候还优于人类写的程序。

除了在一开始说的头衔,Karpathy 也是计算机视觉界的“世界杯”,ImageNet 竞赛中,人类基准的代言人。我们都说神经网络超越了人的水平,但这个人的水平是怎么来的呢?——Karpathy 自己做的!

最初,他是在 CIFAR 10 数据集上做视觉识别和分类。那时候只有 10 个类别,因此做起来还相对容易,他把正确率做到了 94% 左右。(根据当时任务的难度,他预估能把神经网络的错误率做到大约 10%。结果,现在这个数字已经降低到 2% 到 3% 的样子。)

Karpathy 认为把人类基准做出来很重要,实际上这在一定程度上也受了吴恩达的影响。Kaparthy 认为,需要有人类表现的具体数字,才能有去和算法作比较,衡量机器做得有多好。

ImageNet 竞赛里,一方面是做好人类基准,另一方面是将算法识别和分类的精度提高,一直以来,不同的人对于这两者的重要性都有不同的看法。

在做人类基准时,Karpathy 的方法是,写了一个 UI 的 JavaScript 脚本,列出 1000 个类别,每个类别都带有一些例子,然后看图,将这 1000 个类别从上拉到下,看这张图属于哪个类别。他会放下手头所有的事情来做这个识别,花上一两周的时间,最终得到一个数字。

后来,他觉得一个人做不够,于是在实验室里找人一起来做,但发现大多数人都不愿意——你想,两周的时间里,每天就坐在计算机前面看哪种狗是哪个类别。不过,他们最终还是设法得出了一个近似数字,能够体现人类平均水平。

Karpathy 用“fun”来形容这项工作,他说自己最初就是想知道一个数字,但 ImageNet 竞赛后来发展成为计算机视觉界的重大赛事,带来了深刻的影响,于是自己也成了 ImageNet 中“人类水平”的代名词,这实在是很搞笑(hilarious)的结果。

当神经网络的表现最终超越人,也就是超越 Karpathy 的表现时,他表示自己感到很惊讶。由于很多时候图像十分模糊,他在识别的时候会在大约 20 个种类里面猜,但神经网络一下子就知道了。神经网络是如何做到这一点的,他不得而知。

另一方面,神经网络在细微的统计数字、纹理、质地等方面十分优秀,因此从这个意义上讲,Karpathy 对于神经网络在识别和分类上面超越他并不感到意外。

说到斯坦福 CS231N 课程,Karpathy 认为计算机视觉是一项很强大的工具,他感觉自己通过教书把这项强大的工具提供给了很多人。此外,CS231N 不同的地方在于,课程内容是时刻更新的,有时候甚至会在课上讨论上周乃至昨天发表的论文。Karpathy 认为贴近最新技术这一点,也是这门课如此受欢迎的原因之一。

不过,讲课备课也会占去了他很多的时间,在上课期间,他基本没有做研究,因此从这个意义上说,他并不推荐博士生去上课。但是,讲课这件事本身绝对是他博士经历的亮点。

作为一个也算见证了深度学习比较长时间发展的人,Karpathy 认为令他感到意外的两件事情,一是以前认为神经网络不可能在如此大规模的图像识别中成功——这个已经被证明是错误的,另一个,或许也是更重要的一个,就是在 ImageNet 数据集上预训练的模型,经过微调后能够用于完成其他任务。

由此,他得出的一个结论是,或许人们应该一开始就开发一种综合的系统,而不是单独开发各种不同功能的系统,再将其组合起来。

Karpathy 认为未来 AI 将向两个大方向发展,一个是应用 AI,不断完善算法提升性能,另一个则是 AGI。而关于 AGI,他认为一开始分别做不同系统然后再组合的方式是错误的,人类可以做推理、计划、使用语言……这些不同的事情,或许开发神经网络也应该有个更高层的统一,是动态过程,能够与智能体全局互动。

做到这一点,Karpathy 举出了几种方法,像 Amazon Mechanical Turk 那样,使用监督学习训练,然后再扩展,或者类似 AI 演化(evolution)。实际上,Karpathy 对此已经有了比较明确的想法而且认为自己是正确的,可惜他表示不愿意在视频中透露——那我们就期待他未来的成果吧。

苹果 AI 负责人、CMU 教授 Rus Salakhutdinov:博士第一年合作完成受限玻尔兹曼机论文,认为无监督学习、半监督学习接下来会有突破

Ruslan Salakhutdinov 是 CMU 教授,也是苹果 AI 负责人。他进入深度学习也是因为 Hinton。当时不知道自己博士该学什么的 Salakhutdinov 在走廊偶遇 Hinton,后者说我有一些很不错的想法啊,来我们谈一下,于是就讲了玻尔兹曼机在内的很多点子,有挺多 Salakhutdinov 当时都不太理解,不过被 Hinton 的想法震撼了。3 个月以后他就到 Hinton 那里读博士了。可以说,那一天改变了他接下来的人生。

作为受限玻尔兹曼机论文的合著者之一,Ruslan Salakhutdinov 实际上是在博士第一年把论文写出来的。他们需要预训练策略来训练多层神经网络,后来聚焦到自编码器。最初是做数字,然后做人脸特征,再后来做文件压缩,处理了不同类型的数据。最终,他们能够训练很深、很多层的自编码器,发表论文,经历了很激动人心的一年。

Salakhutdinov 说,受限玻尔兹曼机、深度玻尔兹曼机都属于生成模型,早期训练很多层的玻尔兹曼机,是因为只有这样初始化权重,才能够有效地学习,训练多层神经网络。但是,到 2009、2010 年的时候,计算力跟上来,人们发现不用这么麻烦,直接使用 BP 就能得到很好的效果。

现在看学习算法,比如 MCMC,VAE,都不能像 BP 那样有效扩展;吴恩达也做过用概率 Max pooling 构建生成模型,但是很难训练。VA 方法也可以视为一种受限玻尔兹曼机,卷积很难整合到里面去。Salakhutdinov 认为我们必须找到方法解决难扩展和难训练的问题。

现在,通过一些策略,能够在统计领域使用 BP,这方面颇有起色,值得注意。

Salakhutdinov 认为无监督学习和半监督学习是十分重要的议题,早期将无监督学习视为无监督预训练,因为当时人们不知道如何训练多层的系统。即使在今天,当拥有很多无标签数据和小部分带标签样本时,使用无监督预训练模型构建生成模型,也能有所帮助。

Salakhutdinov 建议有志从事深度学习的人选择无监督学习和半监督学习,认为这一块接下来会有突破。

此外,他认为很值得关注的还有深度强化学习,智能体与环境交互,与其他智能体交互,都是非常有趣的研究。对话系统和 NLP 也是。从这两点,似乎可以窥见苹果 AI 研究的一点点方向。

Salakhutdinov 既是 CMU 教授,又在苹果做部门主管,拥有学界和产业界双重身份和经历的他建议,不管是做应用还是做研究,放手大胆去做是最重要的。当时他研究神经网络时,神经网络是高度非凸的系统,难以优化,很多人都不看好。但是,他们没有管这么多,想着要实现怎样的结果就去做了。

再来,作为教师,他的上课时一直强调要了解代码,真正理解底层信息。他会要求学生从头实现 BP。这个过程很难,但一旦做过一次,对系统有了真正的理解,对今后帮助无穷。

最后,至于选择学术道路还是产业道路,Salakhutdinov 表示两者皆有好处,主要看个人兴趣所在。常见的看法,学界更自由,可以研究长期的,比较基础的问题,而产业界基础资源好,比如硬件设施还有大数据,而且一旦产品做成,能够影响许许多多的人。总之,无论是学术界还是产业界,你来做深度学习就行了。

林元庆:AI 技术发展是一个循环的过程,找到爆发点很重要

作为现任 IDL 负责人,林元庆是中国深度学习的一位领军人。吴恩达还在百度期间,两人就很好地合作。这次接收吴恩达采访,林元庆分享了他进入深度学习领域的经历,结合百度正在做的事情谈了深度学习。

实际上林元庆读博之前学的是光学,更接近做物理。后来去了美国,听了机器学习相关的讲座,觉得很有趣很令人激动,于是转学机器学习,很多事情都是从头学习,最初连 PCA 算法都不知道,但他认为那段时间每天都有新东西学,很充实很有趣。

林元庆后来去了 NEC 实验室,开始做计算机视觉,他在那里做的第一件大事就是参加第一届 ImageNet 竞赛,带领团队拿下了第一名,还在 workshop 做报告。这也是让他从事大规模机器视觉研究的原因。再后来 AlexNet 等网络的出现,让他意识到深度学习真的很厉害,于是也开始做很多深度学习方面的研究。

林元庆接下来介绍了深度学习国家级实验室。这个国家级实验室的目标是建立超大规模的深度学习平台,中国乃至世界第一,为研究者和开发人员提供深度学习框架(比如 PaddlePaddle)、计算力资源和大规模数据。你可以在上面开发,做项目,重复别人的项目,还可以与百度的产品对接,类似于一整个生态系统。这个平台的优势在于代码、数据及实验设置都是弄好的,研究人员和开发者在复用时输一行指令就行了,几秒钟时间就能运行其他人论文描述的结果,因此能够大大加速深度学习的研究进程。

林元庆表示,中国政府为此投入了很多资金,但更重要的是,建立深度学习国家级重点实验室这件事本身就是一个标志,会吸引更多的人参与到深度学习研究中来。

林元庆认为,找到很强的商业模式,形成正循环,对促使技术告诉发展十分重要,这也是百度内部在选择项目时候的关键。过去几年中,深度学习驱动的产品在爆发式增长,从搜索引擎、语音识别到安防、电子商务,有非常多也非常好的应用。这样的环境对 AI 技术的研究也有很大意义:从初始数据写算法,有了初始产品,推向市场让用户使用,获得更多数据,然后优化算法,进而完善产品……这就是一个正循环,也是 AI 技术特有的现象。相比之下,传统的技术的发展路线就比较线性。林元庆介绍,百度在研发和开发过程中很看重这样的过程,他们会研究形成正循环规律,以使自己更快地达到飞速增长的点,从而更快地达到一个高的技术水平。

对于想要进入深度学习和 AI 领域的人,林元庆建议从开源社区入手,TensorFlow,Caffe、Caffe2,还有 PaddlePaddle。大多数框架都能找到许多线上课程,公开的基准测试也有很多,向厉害的、有经验的研究者学习。

不过,林元庆个人的实际经历却正好相反,他是先接触 PCA、LDA 等方法,然后才做的深度学习。他认为这种方向也不错,对数学基础有掌握,也能很好地了解深度学习。数学和机器学习基础知识本来就与深度学习密切相关。

注:投稿请电邮至124239956@qq.com ,合作 或 加入未来产业促进会请加:www13923462501 微信号或者扫描下面二维码:

文章版权归原作者所有。如涉及作品版权问题,请与我们联系,我们将删除内容或协商版权问题!联系QQ:124239956